面積42225 平方毫米,擁有1.2 萬億個晶體管,400000 個核心,片上內(nèi)存18 Gigabytes,內(nèi)存帶寬19 PByte/s,fabric帶寬100 Pbit/s。這就是有史以來最大的芯片——Cerebras Wafer Scale Engine!

這顆巨型芯片由Cerebras Systems公司推出,芯片發(fā)布后,三位中國芯片領(lǐng)域?qū)<以谂笥讶α⒓醋龀鲈u價:

芯片專家唐杉:“膜拜一下Cerebras的巨型芯片,每邊大約9英寸,22cm。我記得我之前寫文章還畫過一個類似的對比圖。[機智]Wired的文章,看來Cerebras要走到前臺了。”

深鑒科技聯(lián)合創(chuàng)始人姚頌:“Cerebras的Wafer-scale chip確實壯觀,有一種獨特的美感,就好像看到大炮巨艦的那種壯麗之情。希望Andrew Feldman一切順利。”

獵戶星空首席戰(zhàn)略官王兵:“一萬兩千億晶體管的巨大芯片,300mm wafer能做出的最大芯片,挑戰(zhàn)芯片行業(yè)極限之作。如果能成功必然會顛覆整個AI芯片行業(yè)。不過即便是用了多種錯誤冗余技術(shù),量產(chǎn)良品率還將會是個巨大的挑戰(zhàn)。”

Cerebras Wafer Scale Engine擁有1.2萬億個晶體管。1971年英特爾首款4004處理器的晶體管數(shù)量為2,300個,最近的AMD處理器擁有320億個晶體管。

大多數(shù)芯片實際上是在12英寸硅晶片上創(chuàng)建的芯片集合,并在芯片工廠中批量生產(chǎn)。但Cerebras Systems芯片是在單個晶圓上互連的單芯片。這些互連設(shè)計使這些芯片全部保持高速運行狀態(tài),萬億個晶體管可以全部一起工作。

通過這種方式,Cerebras Wafer Scale Engine成為有史以來最大的處理器,它專門設(shè)計用于處理AI應(yīng)用問題。該公司在本周在斯坦福大學(xué)舉行的Hot Chips會議上討論這款“世界最大”的芯片的設(shè)計。

此前,三星實際上已制造出了一個閃存芯片eUFS,擁有2萬億個晶體管。但Cerebras芯片專為流程加工而設(shè)計,擁有400,000個核心,芯片面積42,225平方毫米。它比最大的Nvidia GPU大56.7倍,后者尺寸為815平方毫米,含211億個晶體管。

史上最大芯片跟棒球的對比

WSE還包含3,000倍的高速片上存儲器,并且具有10,000倍的存儲器帶寬。

該芯片來自Andrew Feldman領(lǐng)導(dǎo)的團隊,后者曾創(chuàng)建微型服務(wù)器公司SeaMicro,并以3.34億美元的價格賣給了AMD。Cerebras Systems的聯(lián)合創(chuàng)始人兼首席硬件架構(gòu)師Sean Lie將將在Hot Chips大會上展示Cerebras Wafer Scale Engine。這家位于加州Los Altos的公司擁有194名員工。

Cerebras CEOFieldman與SeaMicro box最初版本合影

芯片尺寸在AI任務(wù)中非常重要,因為大尺寸芯片可以更快地處理信息,在更短的時間內(nèi)給出答案。這能夠減少“訓(xùn)練時間”,使研究人員能夠測試更多想法,使用更多數(shù)據(jù)并解決新問題。谷歌、Facebook、OpenAI、騰訊、百度和許多企業(yè)都認為,今天制約AI發(fā)展的基本限制是訓(xùn)練模型需要的時間太長。因此,縮短訓(xùn)練時間有望消除整個行業(yè)取得進步的主要瓶頸。

當然,芯片制造商通常不會制造這么大的芯片。在單個晶片的制造過程中通常會出現(xiàn)一些雜質(zhì)。如果一種雜質(zhì)會導(dǎo)致一塊芯片發(fā)生故障,那么晶圓上的多種雜質(zhì)就會導(dǎo)致多塊芯片出問題。實際制造出的芯片產(chǎn)量僅占實際工作芯片的一小部分。如果晶圓上只有一個芯片,它有雜質(zhì)的幾率是100%,雜質(zhì)會使芯片失效。但Cerebras設(shè)計的芯片留有冗余,一種雜質(zhì)不會導(dǎo)致整個芯片都不能用。

單晶圓提供超級計算機級的計算能力

“Cerebras WSE”專為人工智能設(shè)計而設(shè)計,其中包含了不少基礎(chǔ)創(chuàng)新,解決了限制芯片尺寸的長達數(shù)十年的技術(shù)挑戰(zhàn) - 如良品率,功率傳送、封裝等,推動了最先進技術(shù)的發(fā)展。和包裝,每個架構(gòu)決策都是為了優(yōu)化AI工作的性能。結(jié)果是,Cerebras WSE根據(jù)工作量提供了數(shù)百或數(shù)千倍的現(xiàn)有解決方案的性能,只需很小的功耗和空間。”Cerebras Systems首席執(zhí)行官的Fieldman說。

通過加速神經(jīng)網(wǎng)絡(luò)訓(xùn)練的所有元素來實現(xiàn)這些性能提升。神經(jīng)網(wǎng)絡(luò)是一種多級計算反饋回路。輸入在循環(huán)中移動速度越快,循環(huán)學(xué)習(xí)的速度越快,即訓(xùn)練時間越短。可以通過加速循環(huán)內(nèi)的計算和通信來加速輸入的循環(huán)速度。

Cerebras WSE芯片面積比目前最大的GPU大56.7倍, 并提供更多核心進行計算,有更多核心靠近內(nèi)存,因此內(nèi)核可以高效運行。由于這些大量的內(nèi)核和內(nèi)存位于單個芯片上,因此所有通信都在芯片上進行,通信帶寬高、延遲低,因此核心組可以以最高效率進行協(xié)作。

Cerebras WSE中的46,225平方毫米的芯片面積上包含40萬個AI優(yōu)化核心,無緩存、無開銷的計算內(nèi)核,以及和18千兆字節(jié)的本地化分布式超高速SRAM內(nèi)存。內(nèi)存帶寬為每秒9 PB。這些核心通過細粒度、全硬件、片上網(wǎng)狀連接通信網(wǎng)絡(luò)連接在一起,可提供每秒100 petabits的總帶寬。更多核心、更多本地內(nèi)存和低延遲高帶寬結(jié)構(gòu),共同構(gòu)成了面向AI加速任務(wù)的最佳架構(gòu)。

“雖然AI在一般意義上被使用,但沒有兩個數(shù)據(jù)集或兩個AI任務(wù)是相同的。新的AI工作負載不斷涌現(xiàn),數(shù)據(jù)集也在不斷變大,”Tirias Research首席分析師兼創(chuàng)始人Jim McGregor在一份聲明中表示。

“隨著AI的發(fā)展,芯片和平臺解決方案也在不斷發(fā)展。Cerebras WSE是半導(dǎo)體和平臺設(shè)計方面的一項驚人的工程成就,它在單個晶圓級的解決方案中提供了超級計算機級的計算能力、高性能內(nèi)存和帶寬。”

Cerebras 表示,如果沒有多年來與臺積電(TSMC)的密切合作,他們不可能取得這個創(chuàng)紀錄的成就。臺積電是全球最大的半導(dǎo)體代工廠,在先進工藝技術(shù)方面處于領(lǐng)先地位。WSE芯片由臺積電采用先進的16nm制程技術(shù)制造。

400000個AI優(yōu)化的內(nèi)核

WSE包含40萬個AI優(yōu)化的計算內(nèi)核(compute cores)。這種計算內(nèi)核被稱為稀疏線性代數(shù)核(Sparse Linear Algebra Cores, SLAC),具有靈活性、可編程性,并針對支持所有神經(jīng)網(wǎng)絡(luò)計算的稀疏線性代數(shù)進行了優(yōu)化。SLAC的可編程性保證了內(nèi)核能夠在不斷變化的機器學(xué)習(xí)領(lǐng)域運行所有的神經(jīng)網(wǎng)絡(luò)算法。

由于稀疏線性代數(shù)內(nèi)核是為神經(jīng)網(wǎng)絡(luò)計算進行優(yōu)化的,因此它們可實現(xiàn)業(yè)界最佳利用率——通常是GPU的3倍或4倍。此外,WSE核心還包括Cerebras發(fā)明的稀疏捕獲技術(shù),以加速在稀疏工作負載(包含0的工作負載)上的計算性能,比如深度學(xué)習(xí)。

零在深度學(xué)習(xí)計算中很普遍。通常,要相乘的向量和矩陣中的大多數(shù)元素都是0。然而,乘以0是浪費硅,功率和時間的行為,因為沒有新的信息。

因為GPU和TPU是密集的執(zhí)行引擎——引擎的設(shè)計永遠不會遇到0——所以它們即使在0時也會乘以每一個元素。當50-98%的數(shù)據(jù)為零時,如深度學(xué)習(xí)中經(jīng)常出現(xiàn)的情況一樣,大多數(shù)乘法都被浪費了。由于Cerebras的稀疏線性代數(shù)核心永遠不會乘以零,所有的零數(shù)據(jù)都被過濾掉,可以在硬件中跳過,從而可以在其位置上完成有用的工作。

比GPU大3000倍的片上內(nèi)存

內(nèi)存是每一種計算機體系結(jié)構(gòu)的關(guān)鍵組成部分。靠近計算的內(nèi)存意味著更快的計算、更低的延遲和更好的數(shù)據(jù)移動效率。高性能的深度學(xué)習(xí)需要大量的計算和頻繁的數(shù)據(jù)訪問。這就要求計算核心和內(nèi)存之間要非常接近,而在GPU中卻不是這樣,GPU中絕大多數(shù)內(nèi)存都很慢,而且離計算核心很遠。

Cerebras Wafer Scale Engine包含了比迄今為止任何芯片都要多的內(nèi)核和本地內(nèi)存,并且在一個時鐘周期內(nèi)擁有18 GB的片上內(nèi)存。WSE上的核心本地內(nèi)存的集合提供了每秒9 PB的內(nèi)存帶寬——比最好的GPU大3000倍的片上內(nèi)存和10000倍的內(nèi)存帶寬。

低延遲、高帶寬的獨特通信結(jié)構(gòu)

Swarm通信結(jié)構(gòu)是WSE上使用的處理器間通信結(jié)構(gòu),它以傳統(tǒng)通信技術(shù)功耗的一小部分實現(xiàn)了帶寬的突破和低延遲。Swarm提供了一個低延遲、高帶寬的2D網(wǎng)格,它將WSE上的所有400,000個核連接起來,每秒的帶寬總計達100 petabits。

路由、可靠的消息傳遞和同步都在硬件中處理。消息會自動激活每個到達消息的應(yīng)用程序處理程序。Swarm為每個神經(jīng)網(wǎng)絡(luò)提供了一個獨特的、優(yōu)化的通信路徑。軟件根據(jù)正在運行的特定用戶定義的神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu),配置通過400,000個核心的最優(yōu)通信路徑,以連接處理器。

典型的消息遍歷一個具有納秒延遲的硬件鏈接。一個Cerebras WSE的總帶寬是每秒100 PB。不需要TCP/IP和MPI等通信軟件,因此可以避免性能損失。這種結(jié)構(gòu)的通信能量成本遠低于遠低于每比特 1 焦耳,比GPU低了近兩個數(shù)量級。結(jié)合了巨大的帶寬和極低的延遲,Swarm通信結(jié)構(gòu)使 Cerebras WSE比任何當前可用的解決方案學(xué)習(xí)得更快。

-

芯片

+關(guān)注

關(guān)注

460文章

52520瀏覽量

441093 -

AI

+關(guān)注

關(guān)注

88文章

35164瀏覽量

280067

原文標題:史上最大芯片誕生!1.2萬億晶體管超級巨無霸,專為AI設(shè)計

文章出處:【微信號:AI_shequ,微信公眾號:人工智能愛好者社區(qū)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

iPhone XS創(chuàng)八項紀錄發(fā)布!最貴、最大、最強AI芯片,雙卡特供中國

2007年10大芯片廠商排名全新出爐

Github發(fā)布史上最大更新

AI發(fā)展對芯片技術(shù)有什么影響?

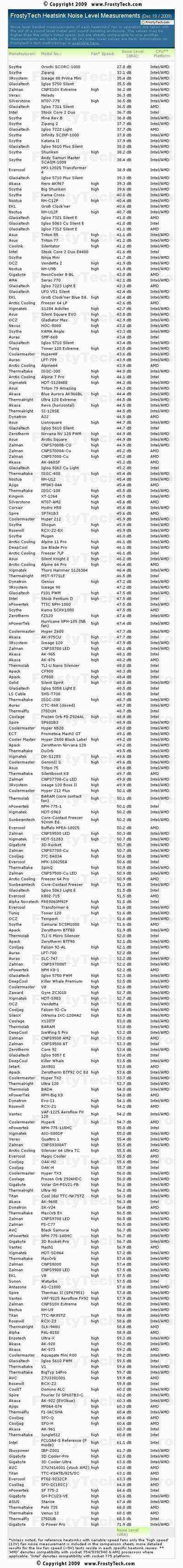

史上規(guī)模最大 252款CPU散熱器排排坐

WAPI終端芯片模塊出爐與WiFi兼容

賽靈思發(fā)布史上最大容量FPGA芯片VU19P

史上最大芯片將用于這兩個項目

WWDC亮點:史上最大MacBook Air 游戲制作人小島秀夫亮相蘋果春晚

史上最大芯片出爐,專為AI設(shè)計

史上最大芯片出爐,專為AI設(shè)計

評論