在過去的幾年中,人工智能領域已進入高速增長階段,這在很大程度上受諸如深度學習(DL)和強化學習(RL)之類的機器學習方法的推動。這些技術的組合展示了在解決各種問題方面的空前性能,這些問題從以超人的角度玩Go到像專家一樣診斷癌癥。

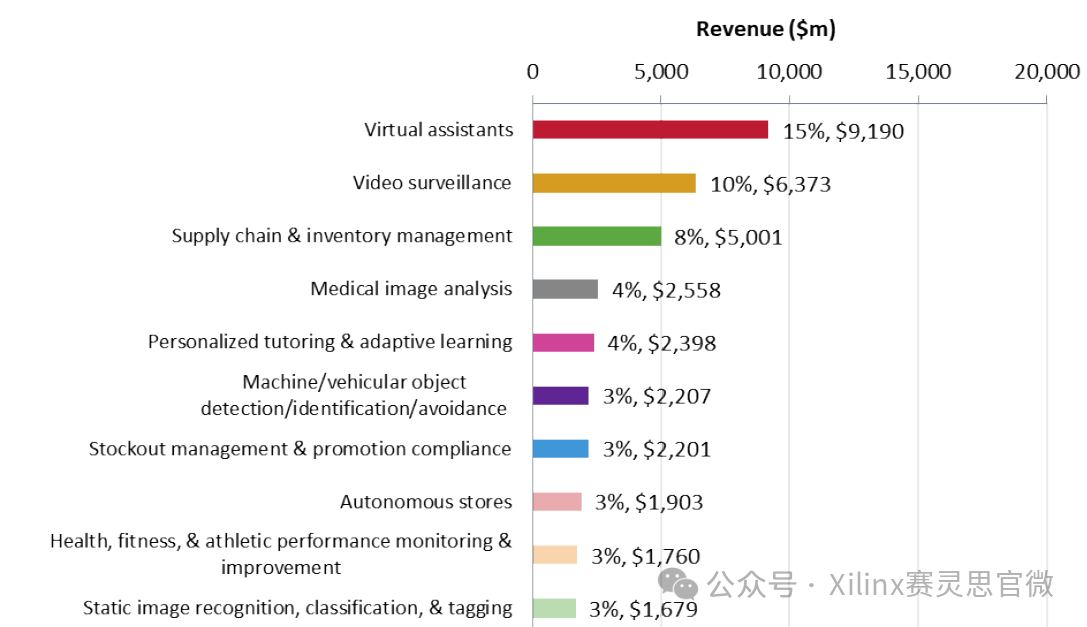

在我們以前的博客中,智能物聯網和霧計算趨勢以及物聯網中無處不在的計算機視覺的興起,我們談到了物聯網中DL的一些有趣用例。應用將是廣泛而深入的。它們將在未來幾十年內刺激對新型處理器的需求。

深度學習工作流程概述

DL / RL創新正以驚人的速度發生(每年在眾多與AI相關的會議上發表數千篇有關新算法的論文)。盡管預測最終的解決方案為時尚早,但硬件公司正在爭相構建處理器、工具和框架。他們試圖利用多年研究人員的經驗來確定DL工作流程中的痛點和瓶頸。

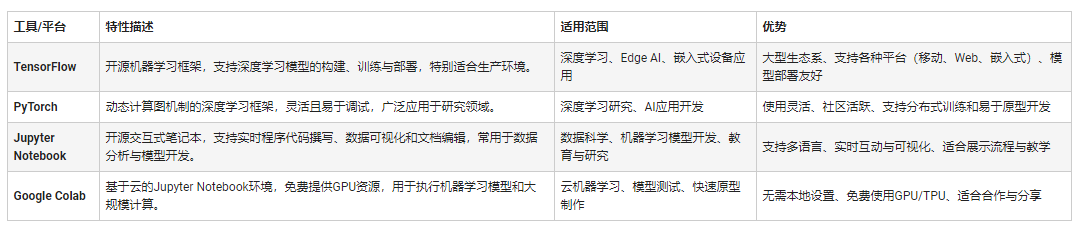

訓練DL模型的平臺

讓我們從培訓平臺開始。基于圖形處理單元(GPU)的系統通常是訓練高級DL模型的選擇。Nvidia早已意識到將GPU用于通用高性能計算的優勢。

GPU有數百個計算核心,它們支持大量的硬件線程和高吞吐量的浮點計算。 Nvidia開發了Compute Unified Device Architecture(CUDA)編程框架,使GPU友好地供科學家和機器學習專家使用。

CUDA工具鏈改善了耗時問題,為研究人員提供了一種靈活而友好的方式來實現高度復雜的算法。幾年前,Nvidia恰當地發現了DL的機會,并為大多數DL運營不斷開發CUDA支持。 Caffe、Torch和Tensorflow等標準框架均支持CUDA。

在AWS之類的云服務中,開發人員可以選擇使用CPU還是GPU(更具體地說是Nvidia GPU)。平臺的選擇取決于神經網絡的復雜性、預算和時間。基于GPU的系統通常可以比CPU減少訓練時間幾倍,但價格更高。

GPU / CPU的替代品

替代品來了。 Khronos在2009年提出了OpenCL,這是一種用于在各種硬件(例如CPU、GPU、DSP或FPGA)上進行并行計算的開放標準。它將使其他處理器(如AMD GPU)進入DL培訓市場,為開發人員提供更多選擇。

但是,它在DL庫支持方面仍落后于CUDA。希望這種情況在未來幾年內會有所改善。英特爾還通過收購Nervana開發了針對DL培訓定制的處理器。

DL推理的競爭格局

DL推理是一個競爭激烈的市場。通常可以根據用例的要求在多個級別上部署應用:

云/企業:圖像分類、網絡安全、文本分析、NLP等。

智能網關:生物識別、語音識別、智能代理等。

邊緣端點:移動設備、智能相機等。

云推理

在Google、Facebook、百度或阿里巴巴等互聯網巨頭的大力推動下,云推理市場將實現巨大的增長。例如,Google Cloud和Microsoft Azure提供了非常強大的圖像分類、自然語言處理和面部識別API,開發人員可以輕松地將其集成到他們的云應用中。

云推理平臺將需要可靠地支持數百萬并發用戶。擴展吞吐量的能力至關重要。此外,降低能耗是控制服務運營成本的另一個重中之重。

在云推理空間上,除GPU外,數據中心還使用FPGA或定制處理器來使云推理應用更具成本效益和功效。例如,Microsoft Project Brainwave使用英特爾FPGA來證明在運行諸如CNN、LSTM等的DL算法時的強大性能和靈活性。

FPGA具有優勢。硬件邏輯、計算內核和內存配置可針對特定類型的神經網絡進行定制,從而使其更有效地處理預訓練模型。但是,一個缺點是與CPU或CUDA相比編程困難。如上一節所述,OpenCL將有助于使FPGA對軟件開發人員更加友好。

除了FPGA之外,Google還制造了定制的處理器,稱為TPU。它是一種專注于高效矩陣計算的ASIC。但是,僅Google自己的服務支持該功能。

用于智能邊緣計算的嵌入式DL推理

在邊緣,DL推理解決方案需要解決針對不同用例和市場的多種需求。

自動駕駛平臺

自動駕駛平臺目前是最熱門的市場,最新的DL和RL方法正在應用中,以實現最高水平的自動駕駛。 Nvidia一直領導著從Tegra到Xavier的幾類DL SoC市場。 例如,Xavier SoC內置于Nvidia的Drive PX平臺中,該平臺可實現多達320個TFLOP。 它的目標是5級自動駕駛。

移動處理器

另一個快速增長的領域是移動應用處理器。 DL啟用了智能手機上以前無法實現的新功能。 一個例子是蘋果將神經引擎集成到A11 Bionic芯片中,從而使其能夠在iPhone X上添加高精度面部鎖定。

中國芯片制造商海思半導體還發布了麒麟970處理器,該處理器具有神經處理單元(NPU)。 華為的一些最新智能手機(圖4)已經使用新的DL處理器進行了設計。 例如,使用NPU,智能手機相機會“知道”正在查看的內容,并會根據場景的主體(例如人、植物、風景等)自動調整相機設置。

新架構

值得一提的是,有一類新的處理器,稱為神經形態處理器,它緊密模仿人類大腦神經元和突觸的機制。他們可以實現一種稱為“脈沖神經網絡(SNN)”的神經網絡,它可以在空間和時間域中學習。

原則上,與現有的DL架構相比,它們具有更高的能源效率,并且在解決在線機器學習問題方面具有優勢。

IBM的TrueNorth和英特爾的Loihi基于神經形態架構。研究人員正在探索這些芯片的功能,顯示出一些潛力。目前尚不清楚何時將新型處理器準備用于廣泛的商業用途。諸如Applied Brain Research和Brainchip之類的許多初創公司也專注于這一領域,開發工具和IP。

這是一個有趣的時代

在短短的幾年內,AI / DL / RL / ML已成為許多行業的重要工具。從IP、處理器、系統設計到工具鏈和軟件方法論的底層生態系統已經進入了快速的創新周期。新的處理器將支持許多以前無法實現的新物聯網應用。

但是,物聯網和機器學習應用仍在不斷發展。芯片設計人員和開發人員將需要幾代處理器才能提出正確的架構組合,從而滿足各種市場的需求。在以后的文章中,我們將更深入地研究各種垂直領域的計算平臺。

責任編輯:tzh

-

處理器

+關注

關注

68文章

19833瀏覽量

233891 -

物聯網

+關注

關注

2927文章

46015瀏覽量

389321 -

機器學習

+關注

關注

66文章

8496瀏覽量

134218 -

深度學習

+關注

關注

73文章

5557瀏覽量

122572

發布評論請先 登錄

聚徽智控——從嵌入式到邊緣計算:平板工控電腦的技術進化論

嵌入式開發入門指南:從零開始學習嵌入式

新生態 智未來「飛凌嵌入式2025嵌入式及邊緣AI技術論壇」開啟報名!

電子發燒友榮獲飛凌嵌入式“2024年度最具價值媒體”獎

嵌入式學習建議

ARMxy ARM嵌入式計算機搭載 1 TOPS NPU支持深度學習

用于智能邊緣計算的嵌入式深度學習推理解決方案

用于智能邊緣計算的嵌入式深度學習推理解決方案

評論