微軟和谷歌一直在積極研究用于訓練深度神經網絡的新框架,并且在最近將各自的成果開源——微軟的 PipeDream 和谷歌的 GPipe。

原則上看,他們都遵循了類似的原則來訓練深度學習模型。這兩個項目已在各自的研究論文(PipeDream,GPipe)中進行了詳細介紹,這篇文章將對此進行總結。

先放上 GitHub 開源地址:

微軟:

https://github.com/msr-fiddle/pipedream

谷歌:

https://github.com/tensorflow/lingvo/blob/master/lingvo/core/gpipe.py

眾所周知,在實驗過程中,雖然訓練基本模型比較瑣碎,但復雜度卻隨模型的質量和大小線性增加。例如,2014 年 ImageNet 視覺識別挑戰賽的冠軍是 GoogleNet,它通過 400 萬個參數獲得了 74.8% 的 top1 準確性,而僅僅三年之后,2017 年 ImageNet 挑戰賽的冠軍就使用 1.458 億個參數(多了 36 倍)的最新神經網絡實現了 top1 準確率——82.7%。但是,在同一時期,GPU 內存僅增加了約 3 倍。

隨著模型縮放以達到更高的準確性,對這些模型的訓練變得越來越具有挑戰性。前面的樣本也顯示了,依靠 GPU 基礎結構的改進來實現更好的訓練是不可持續的。我們需要分布式計算方法,這些方法可以并行化跨不同節點的訓練工作量,以擴展訓練規模。分布式訓練的概念聽起來很瑣碎,但實際上卻極其復雜。

谷歌的 GPipe GPipe

專注于擴展深度學習計劃的訓練工作量。從基礎架構的角度來看,訓練過程的復雜性是深度學習模型經常被忽視的一個方面。訓練數據集越來越大,越來越復雜。例如,在醫療保健領域,需要使用數百萬個高分辨率圖像進行訓練的模型并不罕見。結果,訓練過程通常要花費很長時間才能完成,并且內存和 CPU 消耗非常大。

思考深度學習模型的分布式的有效方法是將其劃分為數據分布式和模型分布式。數據分布式方法采用大型機器集群,將輸入數據拆分到它們之間。模型分布式嘗試將模型移至具有特定硬件的加速器,例如 GPU 或 TPU,以加速模型訓練。

概念上看,幾乎所有訓練數據集都可以按照一定的邏輯進行分布式訓練,但是關于模型的說法卻不盡相同。例如,一些深度學習模型由可以獨立訓練的并行分支組成。在那種情況下,經典策略是將計算劃分為多個分區,并將不同的分區分配給不同的分支。但是,這種策略在按順序堆疊各層的深度學習模型中是不足的。

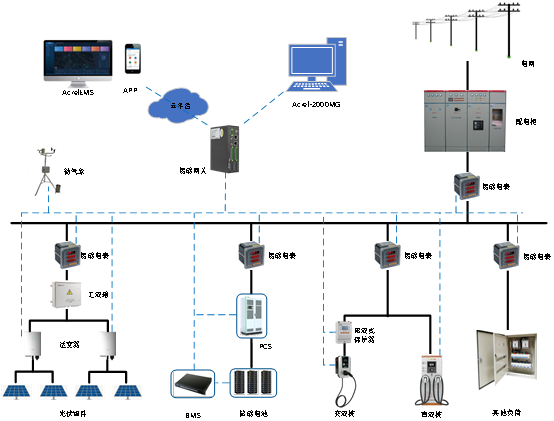

GPipe 通過利用一種稱為流水線的技術將數據和模型分布式結合在一起。從概念上講,GPipe 是一個分布式機器學習庫,它使用同步隨機梯度下降和流水線分布式進行訓練,適用于由多個連續層組成的任何 DNN。

GPipe 在不同的加速器之間劃分模型,并自動將一小批訓練樣本拆分為較小的微批。該模型允許 GPipe 的加速器并行運行,從而最大限度地提高了訓練過程的可擴展性。

下圖說明了具有連續層的神經網絡的 GPipe 模型在四個加速器之間分配。Fk 是第 k 個分區的復合正向計算函數。Bk 是相應的反向傳播函數。Bk 取決于上層的 Bk + 1 和 Fk 的中間激活。在頂級模型中,我們可以看到網絡的順序性質如何導致資源利用不足。下圖顯示了 GPipe 方法,其中將輸入的迷你批處理分為較小的宏批處理,這些宏批處理可由加速器同時處理。

圖片來源:

https://arxiv.org/pdf/1811.06965.pdf

微軟的 PipeDream

幾個月前,微軟研究院宣布創建 Project Fiddle,這是一系列旨在簡化分布式深度學習的研究項目。PipeDreams 是 Fiddle 項目首次發布的版本之一,專注于深度學習模型訓練的并行化。

PipeDream 采用與其他方法不同的方法來利用稱為管道分布式的技術來擴展深度學習模型的訓練。這種方法試圖解決數據和模型并行技術的一些挑戰,例如 GPipe 中使用的技術。

通常,在云基礎架構上進行訓練時,數據并行方法在規模上會承受較高的通信成本,并且隨著時間的推移會提高 GPU 計算速度。類似地,模型分布式技術通常在利用硬件資源上更加效率低下,程序員需要決定如何在給定硬件部署的情況下拆分其特定模型,給他們帶來了不必要的負擔。

圖片來源:

http://www.microsoft.com/zh-cn/research/uploads/prod/2019/08/fiddle_pipedream_sosp19.pdf

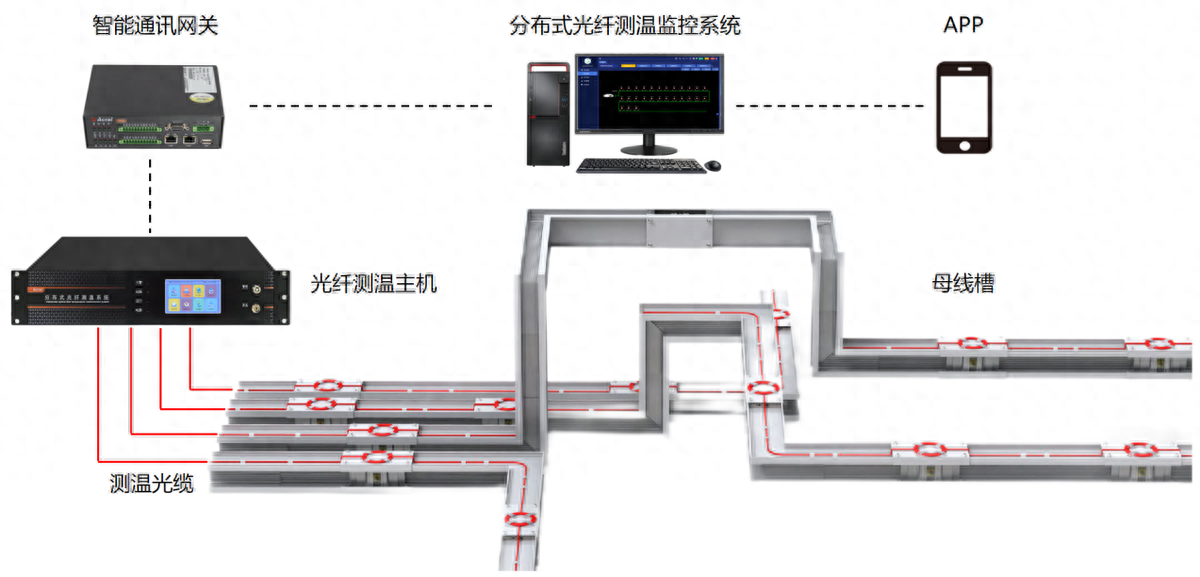

PipeDream 嘗試通過使用稱為管道分布式的技術來克服數據模型分布式方法的一些挑戰。

從概念上講,管道分布計算涉及將 DNN 模型的各層劃分為多個階段,其中每個階段均由模型中的一組連續層組成。每個階段都映射到一個單獨的 GPU,該 GPU 對該階段中的所有層執行正向傳遞(和反向傳遞)。

給定一個特定的深度神經網絡,PipeDream 會基于在單個 GPU 上執行的簡短概要分析,自動確定如何對 DNN 的運算符進行分區,在不同階段之間平衡計算負載,同時最大程度地減少與目標平臺的通信。即使存在模型多樣性(計算和通信)和平臺多樣性(互連拓撲和分層帶寬),PipeDream 也會有效地實現負載平衡。PipeDream 訓練分布式的方法的原理比數據模型分布式方法具有多個優點。

對于初學者而言,PipeDream 需要在工作程序節點之間進行較少的通信,因為管道執行中的每個工作程序僅需要將漸變的子集和輸出激活信息傳達給單個其他工作程序。

圖片來源:

https://www.microsoft.com/zh-cn/research/uploads/prod/2019/08/fiddle_pipedream_sosp19.pdf

訓練分布式是構建更大、更準確的深度學習模型的關鍵挑戰之一。分布式訓練方法是深度學習社區中一個活躍的研究領域,需要將有效的并發編程技術與深度學習模型的本質相結合。盡管仍處于早期階段,但 Google 的 GPipe 和 Microsoft 的 PipeDream 本身已經是很優秀的產品,它是深度學習開發人員可用的兩種最具創造性的分布式訓練方法。

責任編輯:PSY

-

微軟

+關注

關注

4文章

6676瀏覽量

105464 -

谷歌

+關注

關注

27文章

6228瀏覽量

107740 -

神經網絡

+關注

關注

42文章

4811瀏覽量

103042

發布評論請先 登錄

潤和軟件StackRUNS異構分布式推理框架的應用案例

潤和軟件發布StackRUNS異構分布式推理框架

使用VirtualLab Fusion中分布式計算的AR波導測試圖像模擬

分布式云化數據庫有哪些類型

基于ptp的分布式系統設計

HarmonyOS Next 應用元服務開發-分布式數據對象遷移數據權限與基礎數據

分布式通信的原理和實現高效分布式通信背后的技術NVLink的演進

淺談屋頂分布式光伏發電技術的設計與應用

分布式光纖測溫是什么?應用領域是?

分布式輸電線路故障定位中的分布式是指什么

微軟和谷歌分別開源分布式深度學習框架對比

微軟和谷歌分別開源分布式深度學習框架對比

評論