隨著 NLP 的不斷發展,對 BERT/Transformer 相關知識的研究應用,也越來越細節,下面嘗試用 QA 的形式深入不淺出 BERT/Transformer 的細節知識點。

不考慮多頭的原因,self-attention 中詞向量不乘 QKV 參數矩陣,會有什么問題?

為什么 BERT 選擇 mask 掉 15% 這個比例的詞,可以是其他的比例嗎?

使用 BERT 預訓練模型為什么最多只能輸入 512 個詞,最多只能兩個句子合成?

為什么 BERT 在第一句前會加一個 [CLS] 標志?

Self-Attention 的時間復雜度是怎么計算的?

Transformer 在哪里做了權重共享,為什么可以做權重共享?

BERT 非線性的來源在哪里?

BERT 的三個 Embedding 直接相加會對語義有影響嗎?

Transformer 的點積模型做縮放的原因是什么?

在 BERT 應用中,如何解決長文本問題?

1.不考慮多頭的原因,self-attention 中詞向量不乘 QKV 參數矩陣,會有什么問題?

self-attention 的核心是「用文本中的其它詞來增強目標詞的語義表示」,從而更好的利用上下文的信息。

self-attention 中,sequence 中的每個詞都會和 sequence 中的每個詞做點積去計算相似度,也包括這個詞本身。

如果不乘 QKV 參數矩陣,那這個詞對應的 q,k,v 就是完全一樣的。

在相同量級的情況下, 與 點積的值會是最大的(可以從 “兩數和相同的情況下,兩數相等對應的積最大” 類比過來)。

那在 softmax 后的加權平均中,該詞本身所占的比重將會是最大的,使得其他詞的比重很少,無法有效利用上下文信息來增強當前詞的語義表示。

而乘以 QKV 參數矩陣,會使得每個詞的 q,k,v 都不一樣,能很大程度上減輕上述的影響。

當然,QKV 參數矩陣也使得多頭,類似于 CNN 中的多核,去捕捉更豐富的特征 / 信息成為可能。

2.為什么 BERT 選擇 mask 掉 15% 這個比例的詞,可以是其他的比例嗎?

BERT 采用的 Masked LM,會選取語料中所有詞的 15% 進行隨機 mask,論文中表示是受到完形填空任務的啟發,但其實「與 CBOW 也有異曲同工之妙」。

從 CBOW 的角度,這里 有一個比較好的解釋是:在一個大小為 的窗口中隨機選一個詞,類似 CBOW 中滑動窗口的中心詞,區別是這里的滑動窗口是非重疊的。

那從 CBOW 的滑動窗口角度,10%~20% 都是還 ok 的比例。

上述非官方解釋,是來自我的一位朋友提供的一個理解切入的角度,供參考。

3.使用 BERT 預訓練模型為什么最多只能輸入 512 個詞,最多只能兩個句子合成一句?

這是 Google BERT 預訓練模型初始設置的原因,前者對應 Position Embeddings,后者對應 Segment Embeddings

在 BERT 中,Token,Position,Segment Embeddings「都是通過學習來得到的」,pytorch 代碼中它們是這樣的

self.word_embeddings=Embedding(config.vocab_size,config.hidden_size) self.position_embeddings=Embedding(config.max_position_embeddings,config.hidden_size) self.token_type_embeddings=Embedding(config.type_vocab_size,config.hidden_size)

上述 BERT pytorch 代碼來自//github.com/xieyufei1993/Bert-Pytorch-Chinese-TextClassification,結構層次非常清晰。

而在 BERT config 中

"max_position_embeddings":512 "type_vocab_size":2

因此,在直接使用 Google 的 BERT 預訓練模型時,輸入最多 512 個詞(還要除掉 [CLS] 和 [SEP]),最多兩個句子合成一句。這之外的詞和句子會沒有對應的 embedding。

當然,如果有足夠的硬件資源自己重新訓練 BERT,可以更改 BERT config,設置更大 max_position_embeddings 和 type_vocab_size 值去滿足自己的需求。

?

總結下博主的話:就是 Google 規定的,想換大的可以自行嘗試!

但這樣的解釋感覺有些欠妥,可能是 Google 嘗試增大 Transorfmer 的最大長度時發現不太適合處理超長句子,所以才有了后面的 Transformer-XL。

?

4.為什么 BERT 在第一句前會加一個 [CLS] 標志?

BERT 在第一句前會加一個 [CLS] 標志,最后一層該位對應向量可以作為整句話的語義表示,從而用于下游的分類任務等。

為什么選它呢,因為與文本中已有的其它詞相比,這個無明顯語義信息的符號會「更 “公平” 地融合文本中各個詞的語義信息」,從而更好的表示整句話的語義。

這里補充一下 bert 的輸出,有兩種:

一種是 get_pooled_out (),就是上述 [CLS] 的表示,輸出 shape 是 [batch size,hidden size]。

一種是 get_sequence_out (),獲取的是整個句子每一個 token 的向量表示,輸出 shape 是 [batch_size, seq_length, hidden_size],這里也包括 [CLS],因此在做 token 級別的任務時要注意它。

self-attention 是用文本中的其它詞來增強目標詞的語義表示,但是目標詞本身的語義還是會占主導的,因此,經過BERT的12層,每次詞的embedding融合了所有詞的信息去更好的表示自己。而[CLS]位本身沒有語義,經過12層,得到的是所有詞的加權平均,相比其他正常詞,可以更好的表征句子語義。當然,也可以通過對最后一層所有詞的embedding做pooling去表征句子語義。另外,[CLS]也指示了句子的開始,[SEP]則指示了句子的分割/結尾,BERT應該可以學到這個信息

?

總結:就是 CLS 是整個句子語義的載體,如果不用 CLS,而是放在第一位進行輸出可能會影響到第一個 token 本身的詞意表達。如果用全連接層進行分類等,會增加參數。

?

5.Self-Attention 的時間復雜度是怎么計算的?

Self-Attention 時間復雜度: ,這里 n 是序列的長度,d 是 embedding 的維度。

Self-Attention 包括 **三個步驟:相似度計算,softmax 和加權平均 **,它們分別的時間復雜度是:

相似度計算可以看作大小為 (n,d) 和 (d,n) 的兩個矩陣相乘: ,得到一個 (n,n) 的矩陣

softmax 就是直接計算了,時間復雜度為

加權平均可以看作大小為 (n,n) 和 (n,d) 的兩個矩陣相乘: ,得到一個 (n,d) 的矩陣

因此,Self-Attention 的時間復雜度是 。

這里再分析一下 Multi-Head Attention,它的作用類似于 CNN 中的多核。

多頭的實現不是循環的計算每個頭,而是通過 transposes and reshapes,用矩陣乘法來完成的。

?

In practice, the multi-headed attention are done with transposes and reshapes rather than actual separate tensors. —— 來自 google BERT 源碼

?

Transformer/BERT 中把 d,也就是 hidden_size/embedding_size 這個維度做了 reshape 拆分,可以去看 Google 的 TF 源碼 或者上面的 pytorch 源碼:

?

hidden_size (d) = num_attention_heads (m) * attention_head_size (a),也即 d=m*a

?

并將 num_attention_heads 維度 transpose 到前面,使得 Q 和 K 的維度都是 (m,n,a),這里不考慮 batch 維度。

這樣點積可以看作大小為 (m,n,a) 和 (m,a,n) 的兩個張量相乘,得到一個 (m,n,n) 的矩陣,其實就相當于 m 個頭,時間復雜度是 。

張量乘法時間復雜度分析參見:矩陣、張量乘法的時間復雜度分析

因此 Multi-Head Attention 時間復雜度就是 ,而實際上,張量乘法可以加速,因此實際復雜度會更低一些。

不過,對于做 transposes and reshapes 的邏輯,個人沒有理的很明白,希望大佬看到能留言解答一下,感謝。

6.Transformer 在哪里做了權重共享,為什么可以做權重共享?

Transformer 在兩個地方進行了權重共享:

(1)Encoder 和 Decoder 間的 Embedding 層權重共享;

(2)Decoder 中 Embedding 層和 FC 層權重共享。

「對于(1」《Attention is all you need》中 Transformer 被應用在機器翻譯任務中,源語言和目標語言是不一樣的,但它們可以共用一張大詞表,對于兩種語言中共同出現的詞(比如:數字,標點等等)可以得到更好的表示,而且對于 Encoder 和 Decoder,「嵌入時都只有對應語言的 embedding 會被激活」,因此是可以共用一張詞表做權重共享的。

論文中,Transformer 詞表用了 bpe(Byte Pair Encoding) 來處理,所以最小的單元是 subword。英語和德語同屬日耳曼語族,有很多相同的 subword,可以共享類似的語義。而像中英這樣相差較大的語系,語義共享作用可能不會很大。

但是,共用詞表會使得詞表數量增大,增加 softmax 的計算時間,因此實際使用中是否共享可能要根據情況權衡。

該點參考:https://www.zhihu.com/question/333419099/answer/743341017

「對于(2」,Embedding 層可以說是通過 onehot 去取到對應的 embedding 向量,FC 層可以說是相反的,通過向量(定義為 x)去得到它可能是某個詞的 softmax 概率,取概率最大(貪婪情況下)的作為預測值。

那哪一個會是概率最大的呢?在 FC 層的每一行量級相同的前提下,理論上和 x 相同的那一行對應的點積和 softmax 概率會是最大的(可類比本文問題 1)。

因此,Embedding 層和 FC 層權重共享,Embedding 層中和向量 x 最接近的那一行對應的詞,會獲得更大的預測概率。實際上,Decoder 中的「Embedding 層和 FC 層有點像互為逆過程」。

通過這樣的權重共享可以減少參數的數量,加快收斂。

但開始我有一個困惑是:Embedding 層參數維度是:(v,d),FC 層參數維度是:(d,v),可以直接共享嘛,還是要轉置?其中 v 是詞表大小,d 是 embedding 維度。

查看 pytorch 源碼發現真的可以直接共享:

fc=nn.Linear(d,v,bias=False)#DecoderFC層定義 weight=Parameter(torch.Tensor(out_features,in_features))#Linear層權重定義

Linear 層的權重定義中,是按照 (out_features, in_features) 順序來的,實際計算會先將 weight 轉置在乘以輸入矩陣。所以 FC 層 對應的 Linear 權重維度也是 (v,d),可以直接共享。

7.BERT 非線性的來源在哪里?

前饋層的 Gelu 激活函數和 self-attention,self-attention 是非線性的。

8.BERT 的三個 Embedding 為什么可以直接相加會對語義有影響嗎?

引用蘇劍林老師的回答:

那只能說明你還不了解 Embedding 的意義。

Embedding 的數學本質,就是以 one hot 為輸入的單層全連接。請參考: https://kexue.fm/archives/4122

也就是說,世界上本沒什么 Embedding,有的只是 one hot。

現在我們將 token,position,segment 三者都用 one hot 表示,然后 concat 起來,然后才去過一個單層全連接,等價的效果就是三個 Embedding 相加。

引用博主的回答:

這是一個很有意思的問題,蘇劍林老師給出的回答,真的很妙:

?

「Embedding 的數學本質,就是以 one hot 為輸入的單層全連接。也就是說,世界上本沒什么 Embedding,有的只是 one hot。」

?

「在這里想用一個簡單的例子再嘗試理解一下」:假設 token Embedding 矩陣維度是 [4,768];position Embedding 矩陣維度是 [3,768];segment Embedding 矩陣維度是 [2,768]。

對于一個字,假設它的 token one-hot 是[1,0,0,0];它的 position one-hot 是[1,0,0];它的segment one-hot 是[1,0]。那這個字最后的 word Embedding,就是上面三種 Embedding 的加和。

如此得到的 word Embedding,和concat后的特征:[1,0,0,0,1,0,0,1,0],再過維度為[4+3+2,768] = [9, 768] 的全連接層,得到的向量其實就是一樣的。

「再換一個角度理解」:

直接將三個one-hot 特征 concat 起來得到的 [1,0,0,0,1,0,0,1,0] 不再是one-hot了,但可以把它映射到三個one-hot 組成的特征空間,空間維度是 4*3*2=24 ,那在新的特征空間,這個字的one-hot就是[1,0,0,0,0...] (23個0)。

此時,Embedding 矩陣維度就是 [24,768],最后得到的 word Embedding 依然是和上面的等效,「但是三個小 Embedding 矩陣的大小會遠小于新特征空間對應的 Embedding 矩陣大小」。

當然,在相同初始化方法前提下,兩種方式得到的 word Embedding 可能方差會有差別,但是,BERT還有Layer Norm,會把 Embedding 結果統一到相同的分布。

BERT的三個Embedding相加,本質可以看作一個「特征的融合」,強大如 BERT 應該可以學到融合后特征的語義信息的。

引用邱錫鵬老師的回答:

這是個好問題。雖然在深度神經網絡里變得非常復雜,本質上神經網絡中每個神經元收到的信號也是“權重”相加得來。具體細節的分析這里就不提了,有興趣的同學可以自己推一推。

這里想說一下寬泛一點的分析(瞎扯)。

在實際場景中,疊加是一個更為常態的操作。比如聲音、圖像等信號。一個時序的波可以用多個不同頻率的正弦波疊加來表示。只要疊加的波的頻率不同,我們就可以通過傅里葉變換進行逆向轉換。

一串文本也可以看作是一些時序信號,也可以有很多信號進行疊加,只要頻率不同,都可以在后面的復雜神經網絡中得到解耦(但也不一定真的要得到解耦)。在 BERT 這個設定中,token,segment,position 明顯可以對應三種非常不同的頻率。

由此可以再深入想一想,在一串文本中,如果每個詞的特征都可以用疊加波來表示,整個序列又可以進一步疊加。哪些是低頻信號(比如詞性?),哪些是高頻信號(比如語義?),這些都隱藏在 Embedding 中,也可能已經解耦在不同維度中了。說不定可以是一種新的表示理論:)

參考:https://www.zhihu.com/question/374835153

9.Transformer 的點積模型做縮放的原因是什么?

論文中解釋是:向量的點積結果會很大,將 softmax 函數 push 到梯度很小的區域,scaled 會緩解這種現象。怎么理解將 sotfmax 函數 push 到梯度很小區域?還有為什么 scaled 是維度的根號,不是其他的數?

LinT 的回答

為什么比較大的輸入會使得softmax的梯度變得很小?

對于一個輸入向量 ,softmax函數將其映射/歸一化到一個分布 。在這個過程中,softmax先用一個自然底數 將輸入中的「元素間差距先“拉大”」,然后歸一化為一個分布。假設某個輸入 中最大的的元素下標是 k,「如果輸入的數量級變大(每個元素都很大),那么 會非常接近1」。

我們可以用一個小例子來看看 的數量級對輸入最大元素對應的預測概率 的影響。假定輸入 ,我們來看不同量級的 a 產生的 有什么區別。

a = 1 時,;

a = 10 時,;

a = 100 時, (計算機精度限制)。

我們不妨把 a 在不同取值下,對應的的 全部繪制出來。代碼如下:

frommathimportexp frommatplotlibimportpyplotasplt importnumpyasnp f=lambdax:exp(x*2)/(exp(x)+exp(x)+exp(x*2)) x=np.linspace(0,100,100) y_3=[f(x_i)forx_iinx] plt.plot(x,y_3) plt.show()

得到的圖如下所示:

可以看到,數量級對 softmax 得到的分布影響非常大。「在數量級較大時,softmax 將幾乎全部的概率分布都分配給了最大值對應的標簽」。

然后我們來看 softmax 的梯度。不妨簡記 softmax 函數為 , softmax 得到的分布向量 對輸入 梯度為:

把這個矩陣展開:

根據前面的討論,當輸入 的元素均較大時,softmax會把大部分概率分布分配給最大的元素,假設我們的輸入數量級很大,最大的元素是 ,那么就將產生一個接近one-hot的向量 , 此時上面的矩陣變為如下形式:

也就是說,在輸入的數量級很大時,「梯度消失為0,造成參數更新困難」。

維度與點積大小的關系是怎么樣的,為什么使用維度的根號來放縮?

針對為什么維度會影響點積的大小,在論文的腳注中其實給出了一點解釋:

假設向量 q 和 k 的各個分量是互相獨立的隨機變量,均值是0,方差是1,那么點積 的均值是 0,方差是 。這里我給出一點更詳細的推導:

對 , 和 都是隨機變量,為了方便書寫,不妨記 。這樣有。

則:

這樣 , 和 的均值是 0,方差為 1,又由期望和方差的性質, 對相互獨立的分量 ,有 以及 。

所以有 的均值 ,方差 。「方差越大也就說明,點積的數量級越大(以越大的概率取大值)」。那么一個自然的做法就是把方差穩定到1,做法是將點積除以 ,這樣有:

「將方差控制為1,也就有效地控制了前面提到的梯度消失的問題」。

可以參考一下。水平有限,如果有誤請指出。

參考:https://www.zhihu.com/question/339723385

10.在 BERT 應用中,如何解決長文本問題?

舉例:在閱讀理解問題中,article 常常長達 1000+, 而 Bert 對于這個量級的表示并不支持。

用 Sliding Window(劃窗),主要見于諸閱讀理解任務(如 Stanford 的 SQuAD)。Sliding Window 即把文檔分成有重疊的若干段,然后每一段都當作獨立的文檔送入BERT進行處理。最后再對于這些獨立文檔得到的結果進行整合。(Transformer-XL)

還可以分段來執行,各段可以求平均、求 max、或者加個 attention 融合。

斤木的回答:

可以看下 Amazon 今年 EMNLP 的這篇文章:Multi-passage BERT

主要思路是 global norm + passage rank + sliding window

實驗做的很扎實,從 ablation study 看這幾個 trick 都很有用。

如果不想切 passages 就上 XLNet 吧。

責任編輯:lq

-

模型

+關注

關注

1文章

3372瀏覽量

49297 -

nlp

+關注

關注

1文章

489瀏覽量

22125

原文標題:【Pre-Training】超細節的 BERT/Transformer 知識點

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

華邦電子安全閃存關鍵知識點

Docker-鏡像的分層-busybox鏡像制作

Aigtek功率放大器應用:電感線圈的知識點分享

后悔沒有早點看到:天線設計中的知識點!

硬件工程師面試基礎知識點

Transformer能代替圖神經網絡嗎

Transformer架構在自然語言處理中的應用

使用PyTorch搭建Transformer模型

【大語言模型:原理與工程實踐】大語言模型的基礎技術

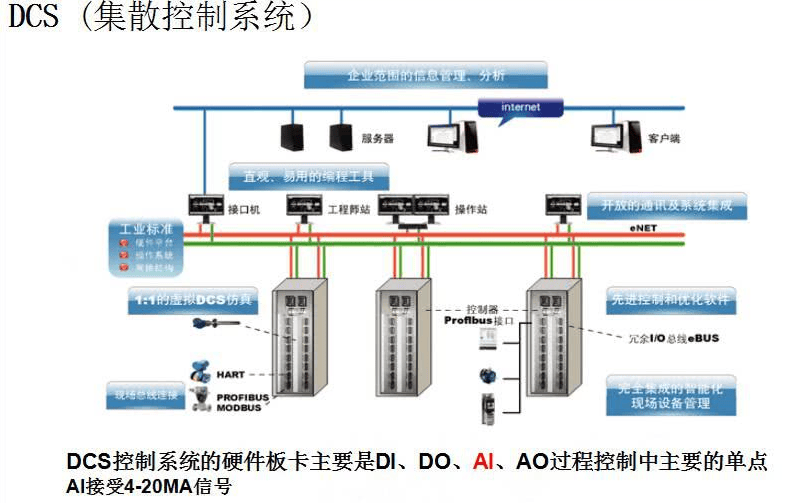

一篇搞定DCS系統相關知識點

嘗試用QA的形式深入不淺出BERT/Transformer的細節知識點

嘗試用QA的形式深入不淺出BERT/Transformer的細節知識點

評論