英特爾AVX-512VNNI技術解析

高級矢量擴展指令集(AdvancedVector ExtensionsAVX)是x86架構微處理器中的SIMD指令集。英特爾AVX-512顧名思義寄存器位寬是512b,可以支持16路32b單精度浮點數或64路8b整型數。

英特爾至強可擴展處理器通過英特爾深度學習加速(英特爾DLBoost)進一步提升了AI計算性能。英特爾深度學習加速包含英特爾AVX-512VNNI(VectorNeural Network Instructions),是對標準英特爾AVX-512指令集的擴展。

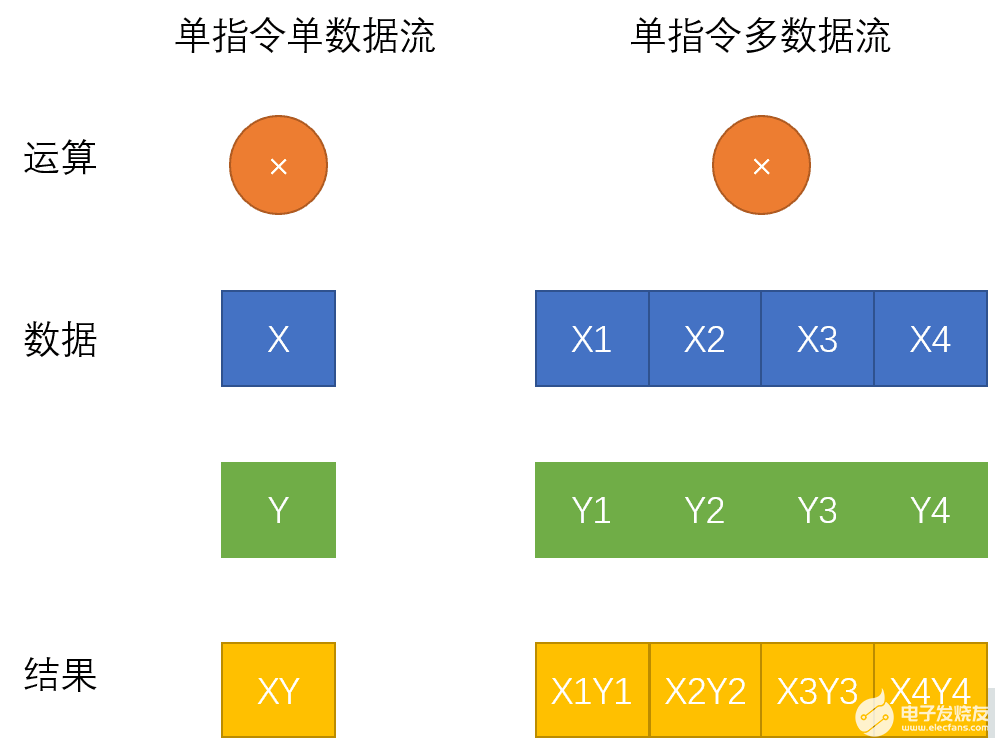

如何理解英特爾AVX-512技術,還要從SIMD指令集說起。SIMD是單指令流多數據流操作(SingleInstruction Stream, Multiple Data Stream)的縮寫,相對應的是SISD單指令流單數據流(SingleInstruction Stream, Single Data Stream)。相較于傳統的單指令單數據指令,SIMD指令使得一條指令可以完成多組數據的操作。單指令單數據流和單指令多數據流區別如下圖所示:

英特爾AVX指令集的前世今生

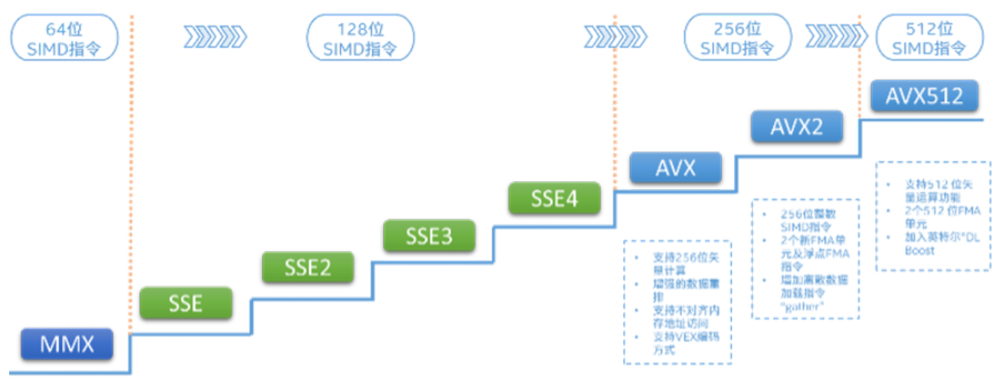

英特爾最早發布的SIMD指令集是MMX指令集:

1996年,英特爾發布了基于新版P55C架構的PentiumMMX系列處理器,其中引入了新的MMX指令集,開始支持SIMD。PentiumMMX系列處理器上新引入的MMX指令集開創了x86處理器支持SIMD操作的先河,該指令集定義了8個64-bit寬度的寄存器,每個寄存器的64-bit容量中可以放入八個8-bit長度的整數或四個16-bit長度整數或兩個32-bit整數,CPU在識別到MMX指令集的新指令時會自動將寄存器中的數據進行分割計算,這樣一來,單個指令就成功操作了多個數據,實現了SIMD。

英特爾AVX-512指令集實際上分成不同的擴展,用來實現不同的操作。具體的擴展如下:

AVX-512 Foundation

AVX-512 Conflict Detection Instructions (CD)

AVX-512 Exponential and Reciprocal Instructions (ER)

AVX-512 Prefetch Instructions (PF)

AVX-512 Vector Length Extensions (VL)

AVX-512 Byte and Word Instructions (BW)

AVX-512 Doubleword and Quadword Instructions (DQ)

AVX-512 Integer Fused Multiply Add (IFMA)

AVX-512 Vector Byte Manipulation Instructions (VBMI)

AVX-512 Vector Neural Network Instructions Word variable precision (4VNNIW)

AVX-512 Fused Multiply Accumulation Packed Single precision (4FMAPS)

VPOPCNTDQ

VPCLMULQDQ

AVX-512 Vector Neural Network Instructions (VNNI)

AVX-512 Galois Field New Instructions (GFNI)

AVX-512 Vector AES instructions (VAES)

AVX-512 Vector Byte Manipulation Instructions 2 (VBMI2)

AVX-512 Bit Algorithms (BITALG)

AVX-512 Bfloat16 Floating-Point Instructions (BF16)

AVX-512 Half-Precision Floating-Point Instructions (FP16)

通過以上這些指令集擴展,讓英特爾至強可擴展處理器家族在音視頻處理、游戲、科學計算、數據加密壓縮以及深度學習等場景中擁有了出色的表現。

英特爾AVX-512VNNI(VectorNeural Network Instructions)

英特爾AVX-512VNNI(VectorNeural NetworkInstructions)是英特爾深度學習加速一項重要的內容,也是對標準英特爾AVX-512指令集的擴展。可以將三條指令合并成一條指令執行,更進一步的發揮新一代英特爾至強可擴展處理器的計算潛能,提升INT8模型的推理性能。目前第2代和第3代英特爾至強可擴展處理器均支持英特爾VNNI。

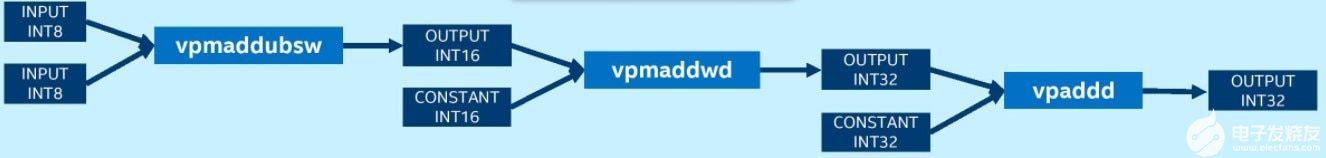

未使用VNNI的平臺需要vpmaddubsw、vpmaddwd和vpaddd指令才能完成INT8卷積運算中的乘累加:

而擁有VNNI的平臺上則可以使用一條指令vpdpbusd完成INT8卷積操作:

英特爾深度學習加速VNNI加速推薦系統中的矢量召回

下面介紹一個具體的使用場景:英特爾深度學習加速VNNI加速推薦系統中的矢量召回。

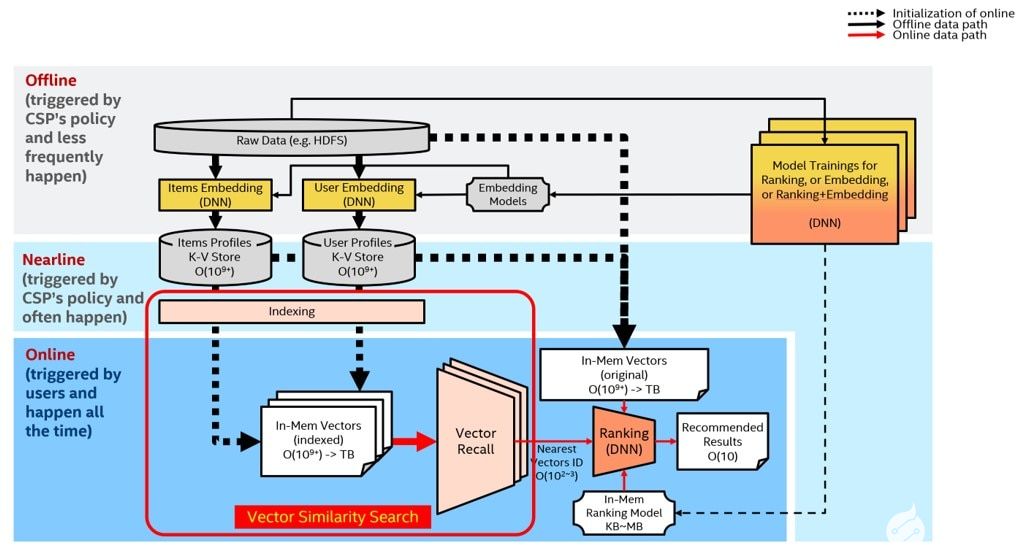

眾所周知,推薦系統需要解決的問題是:如何為既定用戶生成一個長度為K的推薦列表,并使該推薦列表盡量(高準確性)、盡快(低延遲)地滿足用戶的興趣和需求?常規的推薦系統包含兩部分:矢量召回(vectorrecall)和重排(ranking)。前者從龐大的推薦池里粗篩出當前用戶最可能感興趣的幾百或幾千條內容,并將結果交由后者的排序模塊進一步排序,得到最終推薦結果。

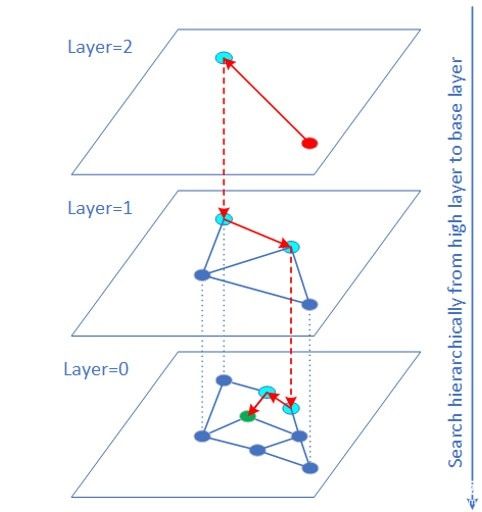

矢量召回可以轉換成高緯度的矢量相似性搜索問題。HNSW(HierarchicalNavigable Small World)算法是基于圖結構的ANN(ApproximateNearest Neighbor)矢量相似度搜索算法之一,也是速度最快精度最高的算法之一。

矢量原始數據的數據類型常常是FP32。對于很多業務(如圖片檢索),矢量數據是可以用INT8/INT16表示而且量化誤差對最終搜集結果影響有限。這時可以使用VNNI intrinsic 指令實現矢量INT8/INT16 的內積計算。大量實驗表明QPS性能有較大的提升,而且召回率幾乎不變。QPS提升的原因一方面是 INT8/INT16訪問帶寬比 FP32少很多,另一方面距離計算部分由于使用 VNNI指令得以加速。

當數據集比較大時(如1億到10億數據量級范圍),傳統的做法是將數據集切片,變成幾個較小的數據集,每個數據集單獨獲取topK,最后再合并。由于增加了多個機器之間的通信,增加延遲的同時降低了QPS。在大數據集上使用HNSW方案的最佳實踐是:盡量不切片,在完整的數據集上建立索引和執行搜索,可獲得最佳性能。當數據集過大,內存空間不夠時,可以考慮使用英特爾傲騰持久內存解決。

Super-FusedBERT技術解析

BERT介紹

BERT(BidirectionalEncoder Representations fromTransformers,基于變換器的雙向編碼器表示技術)是2018年谷歌公司提出的NLP(Naturallanguageprocessing,自然語言處理)學科的新技術。谷歌正在利用BERT來更好地理解用戶搜索語句的語義。2020年的一項文獻調查得出結論:“在一年多一點的時間里,BERT已經成為NLP實驗中無處不在的基線”,算上分析和改進模型的研究出版物超過150篇。

BERT的創新點在于它將雙向Transformer用于語言模型,之前的模型是從左向右輸入一個文本序列,或者將left-to-right和right-to-left的訓練結合起來。實驗的結果表明,雙向訓練的語言模型對語境的理解會比單向的語言模型更深刻,BERT使用了一種新技術叫做MaskedLM(MLM),在這個技術出現之前是無法進行雙向語言模型訓練的。

英特爾AVX-512技術加速新浪廣告業務

通過使用英特爾AVX-512實現Super-FusedBert優化方案

一、利用Intel MKL高性能數學庫

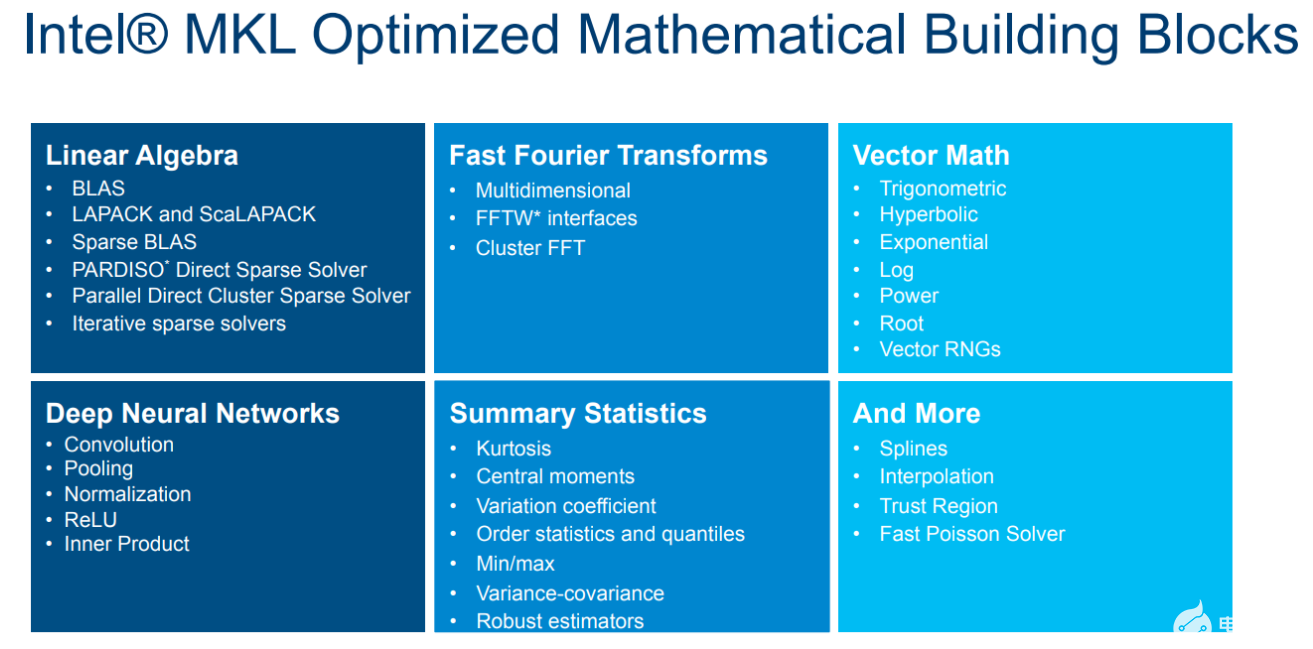

MKL是Intel發布的高性能數學庫,適用于科學計算,工程和金融領域。經過多年的打磨,MKL已經是x86平臺上性能最好的數學庫之一。借助MKL可以最大限度的發揮出Xeon處理器的硬件性能,幫助加速Bert模型的推理。

圖 MKL高性能數學庫

深度學習模型中存在大量矩陣乘法(GEMM)這種計算密集操作,可以直接使用MKL的cblas_sgemm接口。

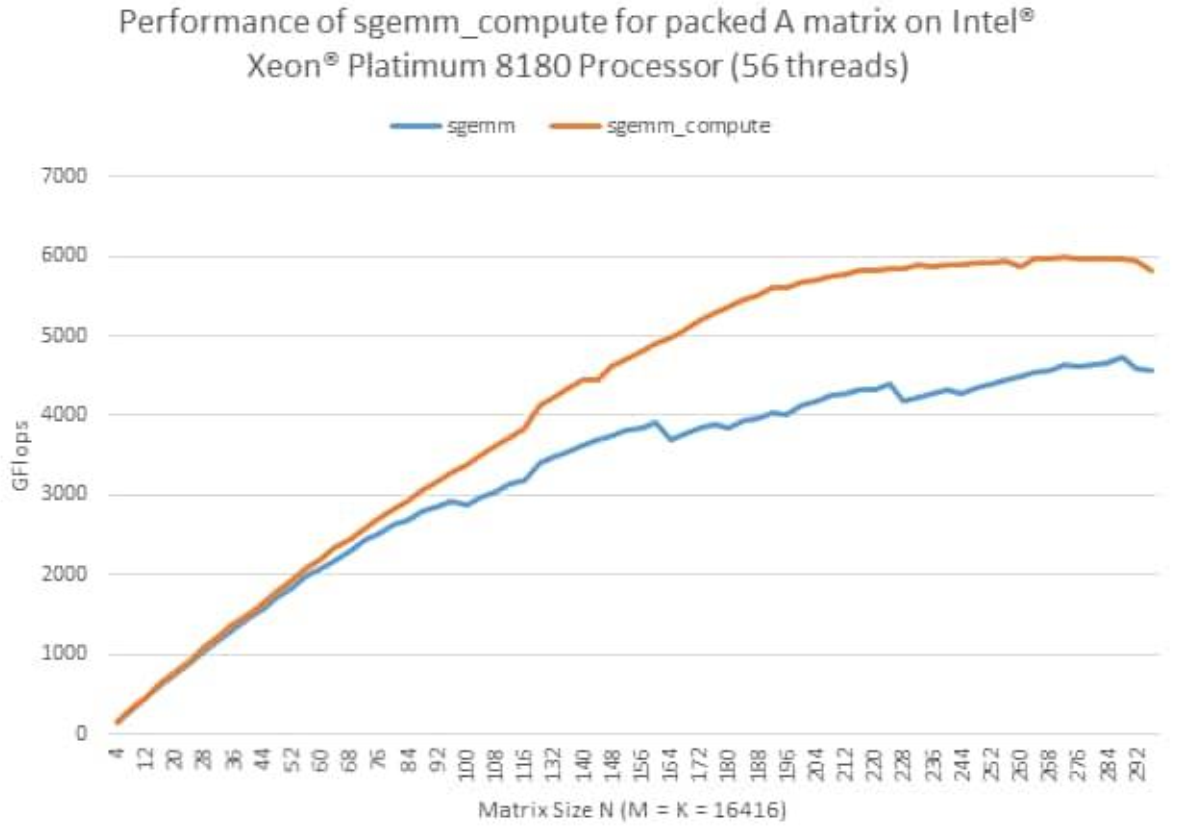

此外,MKL還提供了一種新的GEMM接口,叫PackedAPI。這種API可以對輸入的矩陣進行預處理(Pack),進一步提高GEMM的效率。

圖 MKLPacked API性能曲線

對于Bert模型,在其推理時權重是固定的,因此可以對權重進行重排,使用MKL的PackedAPI進行模型推理加速。

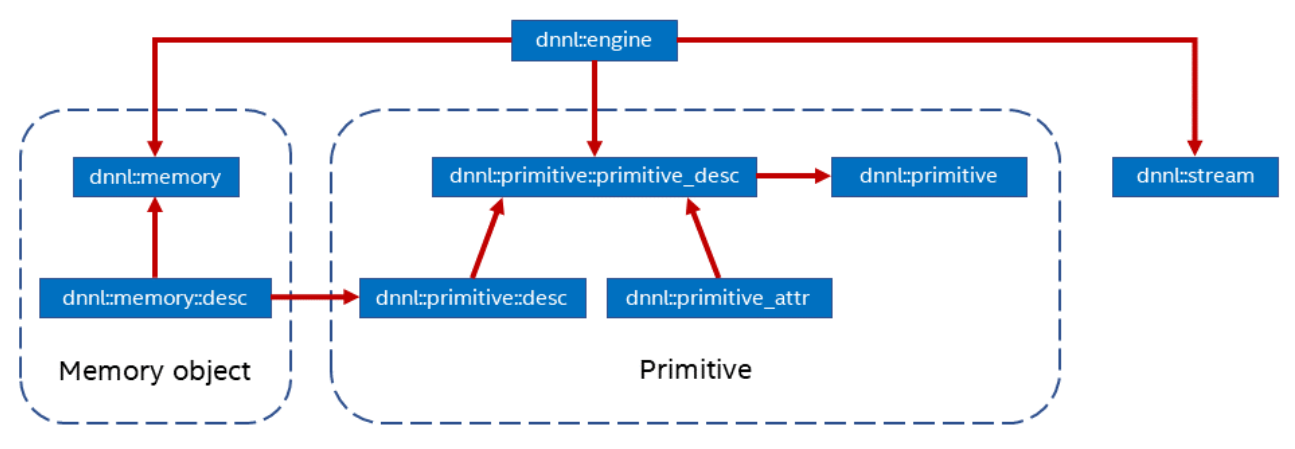

二、利用Intel oneDNN開源深度學習加速庫

oneDNN是Intel開源的深度學習加速庫,同樣可以支持不同的計算設備,如CPU,GPU等。oneDNN抽象了以下幾個概念:

Primitive:一種DNN算子的底層原語,支持matmul,convolution等。

Memory:對Primitive使用的內存的抽象,存在多種布局,不同的內存布局也會影響

Primitive:的執行效率。

Engine:底層計算設備抽象,可支持 CPU, GPU。

Stream:Engine中Primitive的隊列。

圖 oneDNN結構

oneDNN中支持了大量常用的深度學習算子。Bert中使用的softmax,layernorm,gelu也都在oneDNN的Primitive中找到相應的實現。

三、使用AVX-512技術進行算子融合

在深度學習框架中,一個模型由多個算子組成,這些算子執行都服從深度學習中調度器的調度。冗余的算子會增加調度開銷,進而影響執行效率。并且算子實現中可能還有很多不必要的訪存和內存分配。因此在針對推理的優化中,減少算子數量非常必要。

圖 算子融合示意圖

除此之外,深度學習模型中,計算密集的算子(matmul,conv)后面會跟一個element-wise的操作(激活函數relu)。這些element-wise的操作可以在計算密集算子計算的過程中完成,而不必等到計算密集算子完全計算完后再進行。這種優化也叫算子融合。

在Bert模型中,matmul,biasadd,gelu的組合可以使用oneDNN的matmulprimitive算子結合追加post_op來完成。

oneDNN的matmulprimitive可以進行多維tensor的乘法操作,并附加融合bias加法。

四、訪存優化

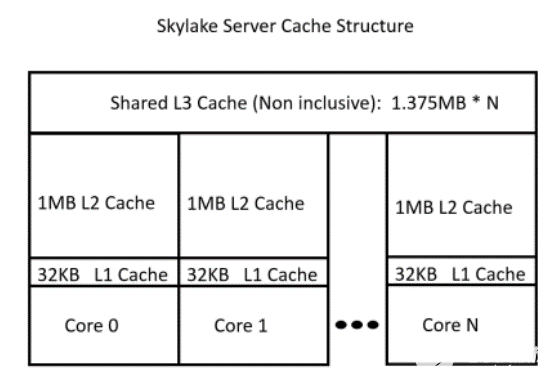

由于CPU架構的特點,越靠近CPU的存儲越快,體積越小。因此高效利用緩存對程序性能非常重要。

圖 CPUcache結構示意圖

這就要求算子在實現的過程中能夠盡可能減少內存占用,進而減少cache的換出,提高cache利用率。

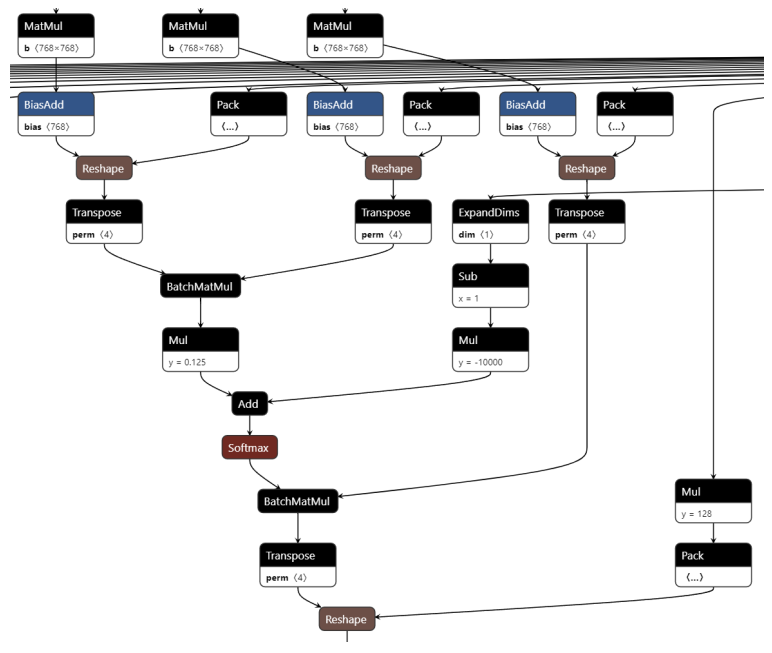

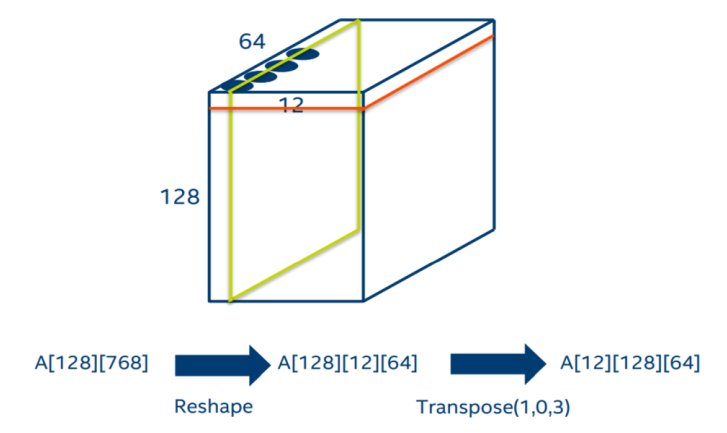

在Bert的self-attention中,對于q、k、v的計算中存在轉置操作。通過下圖可以清楚的看到,每一個q、k、v在經過一個線性層后,都會按照head進行split并轉置。在self-attention最后和v進行點積后,還需要一個轉置來擺放數據。

圖self-attention圖結構

其實通過分析圖結構的計算流程,我們可以將上面的轉置消除。如下圖,原來的數據是按紅色方框的方式存放,但是BatchMatmul需要用到的數據位于綠色方塊中。因此我們可以使用MKL的batch_sgemm接口,將參數stride指定為64*12。這樣就可以避免轉置帶來的內存占用和訪存開銷。

圖消除self-attention轉置

性能優化數據

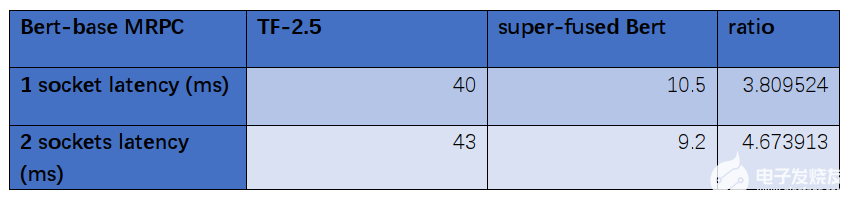

在Intel第三代Xeon處理器IceLake8358P上,我們對Super-FusedBert進行了性能測試:

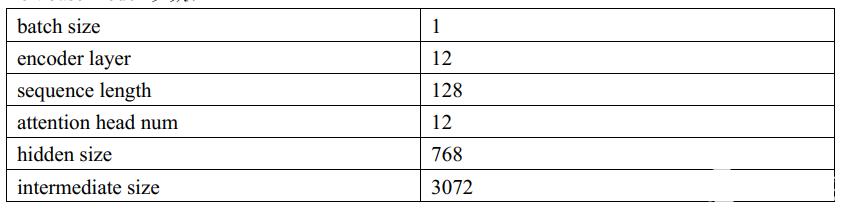

Bertbase model 參數:

數據對比:

通過數據對比分析,經過優化后的Bert-base模型在第三代Xeon處理器IceLake8358P比優化前節省了大約四分之三的時長,分別從40ms優化到10.5ms、43ms優化到9.2ms。

這種優化對于滿足實時在線服務推理的延遲要求有著十分顯著的作用,有利于業務部門搭建基于Bert模型的業務,提高了集群中CPU利用率。

*實際性能受使用情況、配置和其他因素的差異影響。更多信息請見www.Intel.com/PerformanceIndex性能測試結果基于配置信息中顯示的日期進行測試,且可能并未反映所有公開可用的更新。

詳情請參閱配置信息披露。沒有任何產品或組件是絕對安全的。

英特爾技術可能需要啟用硬件、軟件或激活服務。

具體成本和結果可能不同。

審核編輯:湯梓紅

-

英特爾

+關注

關注

61文章

10182瀏覽量

174134 -

微處理器

+關注

關注

11文章

2373瀏覽量

83931 -

指令集

+關注

關注

0文章

228瀏覽量

23740

發布評論請先 登錄

世紀大并購!傳高通有意整體收購英特爾,英特爾最新回應

請問OpenVINO?工具套件英特爾?Distribution是否與Windows? 10物聯網企業版兼容?

英特爾與Stellantis Motorsports攜手推進自適應控制技術

英特爾推出全新英特爾銳炫B系列顯卡

英特爾CEO Gelsinger宣布退休

英特爾考慮出售Altera股權

剛剛!英特爾最新回應

英特爾至強品牌新戰略發布

英特爾股票分析:英特爾的困境能否結束?

面對高通收購,Apollo 50億美元投資,你該買入英特爾股票嗎?

英特爾AVX-512VNNI技術解析

英特爾AVX-512VNNI技術解析

評論