本文是基于NNoM神經(jīng)網(wǎng)絡(luò)框架實現(xiàn)的。NNoM是一個為單片機定制的神經(jīng)網(wǎng)絡(luò)框架,可以實現(xiàn)TensorFlow 模型的量化和部署到單片機上,可以在Cortex M4/7/33等ARM內(nèi)核的單片機上實現(xiàn)加速(STM32,LPC,Nordic nRF 等等)。

NNoM和本文代碼可以在后臺回復(fù):“麥克風(fēng)降噪”領(lǐng)取。

效果演示視頻:

STM32實現(xiàn)單麥克風(fēng)實時神經(jīng)網(wǎng)絡(luò)(RNN)降噪演示

硬聲創(chuàng)作者:麻博士在科研

這個例子是根據(jù)著名的 RNNoise (https://jmvalin.ca/demo/rnnoise/) 的降噪方法進行設(shè)計的。整體進行了一些簡化和定點化的一些修改。

本例與RNNoise主要的區(qū)別如下:

此例子并非從RNNoise的模型直接轉(zhuǎn)換而來,而是從新基于Keras訓(xùn)練一個新模型,并轉(zhuǎn)化成NNoM模型。

RNN 網(wǎng)絡(luò)定點化時,根據(jù)定點模型的一些特點進行了部分神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)修改。

訓(xùn)練數(shù)據(jù)集選擇上使用了微軟的可定制語音數(shù)據(jù)庫而不是RNNoise收集的數(shù)據(jù)庫。

此例子用到的三方庫如下,大部分為寬松許可,但請大家在使用時遵循他們的開源協(xié)議。

RNNoise (https://jmvalin.ca/demo/rnnoise/)

Microsoft Scalable Noisy Speech Dataset (https://github.com/microsoft/MS-SNSD)

python speech features (https://github.com/jameslyons/python_speech_features)

arduino_fft (https://github.com/lloydroc/arduino_fft)

CMSIS (https://github.com/ARM-software/CMSIS_5)

NNoM本身許可為 Apache-2.0,詳細(xì)信息請看NNoM 開源主倉庫下的許可信息 (https://github.com/majianjia/nnom).

一些背景知識

如何用神經(jīng)網(wǎng)絡(luò)進行語音降噪?

神經(jīng)網(wǎng)絡(luò)降噪通常有兩種方式:

語音信號直入神經(jīng)網(wǎng)絡(luò)模型,神經(jīng)網(wǎng)絡(luò)全權(quán)進行識別處理并輸出降噪后的語音信號。

神經(jīng)網(wǎng)絡(luò)識別語音和噪音的特征,動態(tài)輸出增益,使用傳統(tǒng)信號處理方法進行濾波。

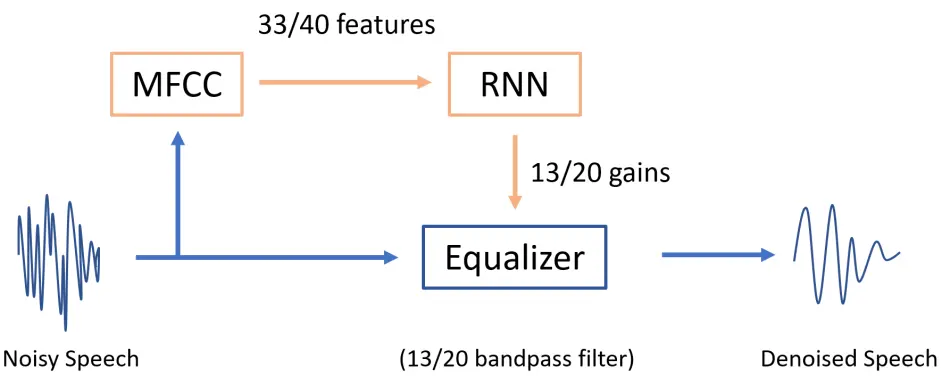

RNNoise 使用的是第二種方法。

實際進行語音降噪(濾波)的部分,是一個均衡器,也就是大家播放器內(nèi)調(diào)節(jié)低音高音的那個玩意兒。而均衡器(Equalizer)的本質(zhì)是很多個平行的帶通濾波器(Bandpass Filter). 我們神經(jīng)網(wǎng)絡(luò)的輸出,就是均衡器內(nèi)各個filter band的增益。

那輸入是什么?跟之前的 KeyWord Spotting例子(https://github.com/majianjia/nnom/tree/master/examples/keyword_spotting) 一樣,我們這里使用了梅爾倒頻譜 (MFCC)。如果不熟悉的小伙伴,可以回去看看KWS的解釋或自行百度。

跟RNNoise有一些不一樣的是我們的例子使用MFCC和梅爾刻度 (Mel-scale) 而不是他們用的OPUS-Scale 或者響度刻度 (Bark-Scale)。單純從刻度的對比上,他們其實差別不是很大。感興趣的同學(xué)可以自己去查查他們的區(qū)別。

系統(tǒng)圖如下

運行步驟

如果想看詳細(xì)的解析,請?zhí)轿恼潞蟀氩糠帧_@里介紹在RTT和STM32L476板子上把這套算法跑起來的步驟。

1.下載語音數(shù)據(jù)集

這里我們使用的數(shù)據(jù)集是微軟的可定制語音數(shù)據(jù)集Microsoft Scalable Noisy Speech Dataset (MS-SNSD: https://github.com/microsoft/MS-SNSD)。我們可以定制時長,噪音類型,噪音混合信噪比等。你需要把整個倉庫下載在 MS-SNSD/文件夾內(nèi)。整個數(shù)據(jù)庫有2.x GB大佬們請自行進行g(shù)ithub加速。

下載完后,你就可以用它生成我們需要的干凈的語音和帶噪音的語音。同時我們還控制了語音混合的程度,也就是信噪比(SNR).

在MS-SNSD/目錄下修改 noisyspeech_synthesizer.cfg 就可以配置需要生成的語音文件,推薦配置如下:

sampling_rate: 16000audioformat: *.wavaudio_length: 60silence_length: 0.0total_hours: 15snr_lower: 0snr_upper: 20total_snrlevels: 3

如果打算快速測試一下,可以把 total_hour 減少為1或者2小時。

修改完后,運行 noisyspeech_synthesizer.py 就可以生成我們需要的音頻WAV文件了。我們需要一對一的干凈的語音和帶噪音的語音,它們分別在MS-SNSD/CleanSpeech_training 和 MS-SNSD/NoisySpeech_training 內(nèi)。

2. 生成訓(xùn)練數(shù)據(jù)集

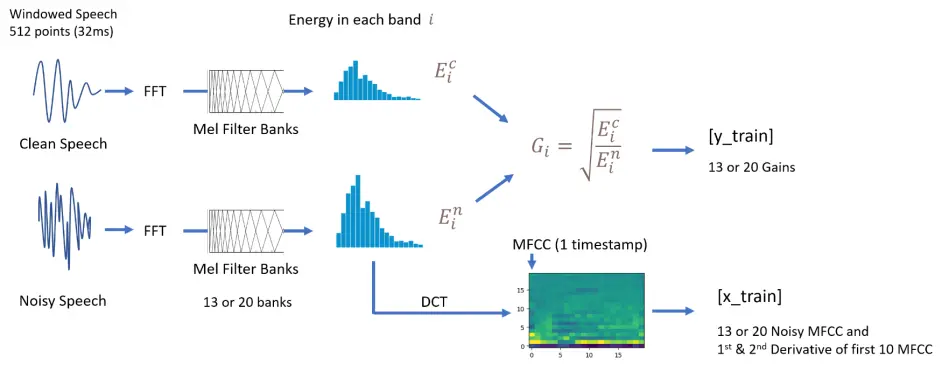

之前一步獲取到的是.wav文件,而我們訓(xùn)練神經(jīng)網(wǎng)絡(luò)使用的是 MFCC 和 gains。

現(xiàn)在我們可以運行例子提供的gen_dataset.py來計算MFCC和gains。它最終會生成一個dataset.npz文件。

在這個文件里面,你可以配置這些內(nèi)容

需要MFCC的特征數(shù)(同時也會修改均衡器Equalizer的Banpass Filter的數(shù)量)。修改 num_filter = 20即可。通常數(shù)字在10到26。

這個腳本也會生成一個c工程使用的濾波器參數(shù)文件equalizer_coeff.h (generate_filter_header(...))。在C語音的均衡器中會使用這個頭文件。

另外,這個腳本還會生成兩個Demo音頻。一個叫_noisy_sample.wav 另一個叫 _filtered_sample.wav。前者為從訓(xùn)練集里面選出的一個帶噪音的范例,后者為用gains和均衡器濾波后文件。基本上,這個文件代表了這個降噪方法的最好的水平。后文會有詳細(xì)的說明怎么生成這個gains。

3. 訓(xùn)練模型

當(dāng)dataset.npz生成后,我們就可以跑 main.py來訓(xùn)練Keras模型了。訓(xùn)練好的模型會保存在目錄下model.h5

因為我們的模型最終要放在單片機上跑,RNN 每次處理一個 timestamp,所以我們的模型設(shè)置為stateful=True 和 timestamps=1。這樣的設(shè)置對于訓(xùn)練并不是很理想,因為反向傳播(BP)沒有辦法很好的在很小的batch上工作。我們的Batch盡量設(shè)置得很大。這里設(shè)置batchsize >= 1024。

同時,這一步會把我們之前的噪音范例_noisy_sample.wav ,使用RNN生成的gains來濾波filtered_sig = voice_denoise(...)(可以對比我們真實gains降噪的結(jié)果)。濾波后的文件保存為_nn_filtered_sample.wav。

在最后,調(diào)用NNoM的API generate_model(...) 生成NNoM模型文件 weights.h。

4. RNN 在 NNoM 上部署

本例提供了SConstruct, 所以你可以直接在目錄下運行 scons 來編譯。默認(rèn)使用目錄下的main.c 編譯成PC可執(zhí)行程序。支持32/64bit windows。理論上也支持linux。

這個二進制文件可以直接對 .wav 文件降噪并生成一個新的 .wav文件,使用方法如下:

注意:僅僅支持16kHz 1CH的格式。(程序不解析WAV只復(fù)制文件頭)。

Win powershell: . nn-denoise [input_file] [output_file] 或者拖拽.wav 文件到編譯完成的*.exe上

Linux: 大家自己試試

比如,運行這個指令生成定點RNN濾波后的音頻:. nn-denoise _noisy_sample.wav _nn_fixedpoit_filtered_sample.wav

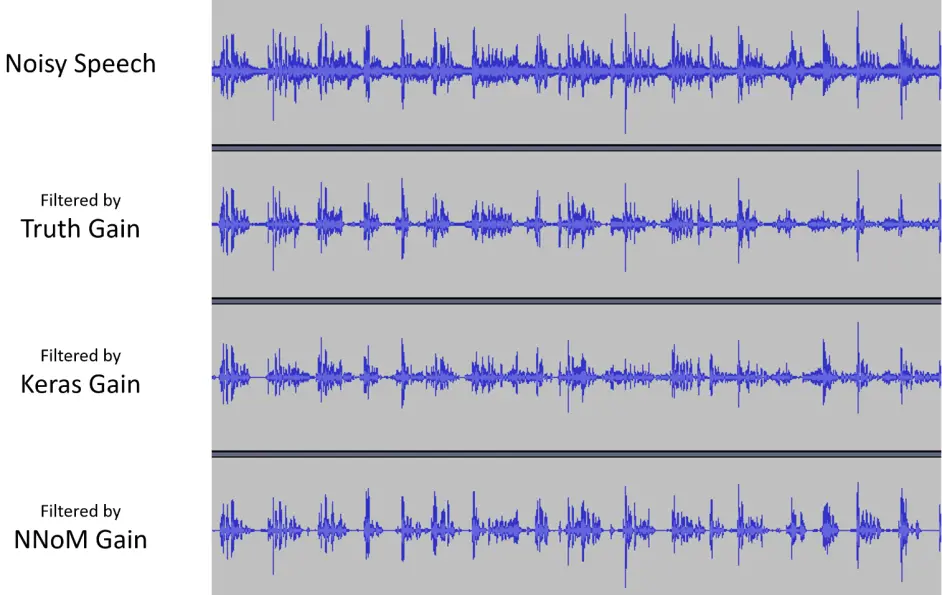

到此,目錄下一共有四個音頻,大家可以試聽一下。

_noisy_sample.wav --> 原始帶噪音文件_filtered_sample.wav --> 用真實gains降噪的文件(訓(xùn)練的gains)_nn_filtered_sample.wav --> Keras浮點模型gains 降噪_nn_fixedpoit_filtered_sample.wav --> NNoM定點模型gains降噪

關(guān)于演示可以看文章頂部的視頻。

不過,大家可以先看個圖視覺上感受一下。Filtered by NNoM是我們單片機上的效果,對比Keras是模型原始輸出的效果。而Truth Gain是模型訓(xùn)練輸入的參考,也就是最原始最好的效果。可以看到這個算法濾掉的不少的東西,具體是不是噪聲。。。再說。

以下是一大波細(xì)節(jié)講解

總的來說,我推薦大家看 gen_dataset.py 和 main.py里面的步驟,很多詳細(xì)的步驟都在注釋里面有相關(guān)的解釋。

關(guān)于訓(xùn)練數(shù)據(jù)

x_train 里面包含了13或者20個(默認(rèn))MFCC,除此之外,還有前10個MFCC特征的第一和第二導(dǎo)數(shù)(derivative)。這些為常用的語音識別特征。所以一共有 33 到 40 個特征。

訓(xùn)練數(shù)據(jù)的生成步驟

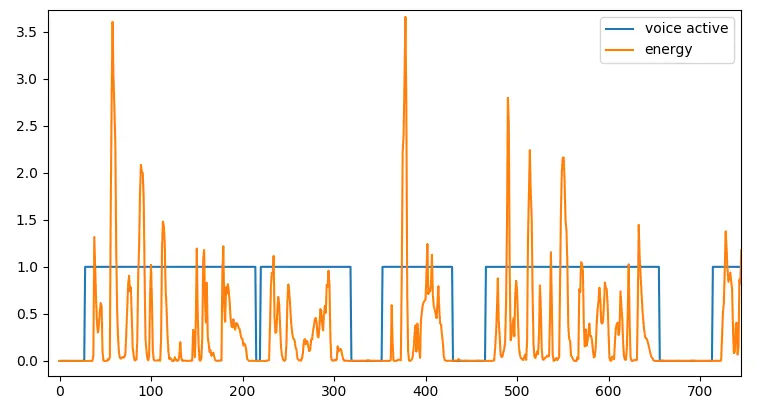

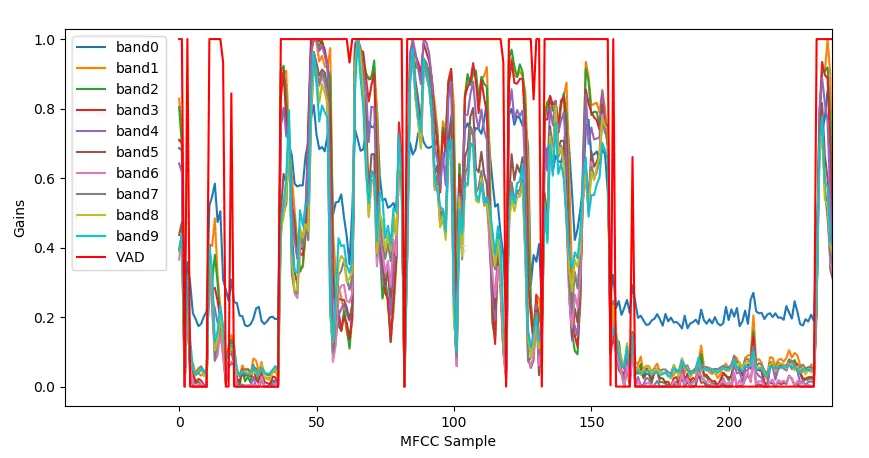

y_train 里面有兩組數(shù)據(jù),一組是gains,另一個叫 VAD

Gains 與RNNoise方法相同,為 clean speech/noisy speech 在每一個band上的能量的開平方。是一組0-1的值,組大小為均衡器的帶通濾波器個數(shù)。

VAD 全稱叫 Voice Active Detection。為一個0-1的值,指示是否有語音。計算方法為檢測一個窗口內(nèi)總能量的大小是否超過一個閾值。

語音能量和激活閾值

關(guān)于 Gains 和 VAD

在默認(rèn)的模型里面,有兩個輸出,其中一個便是VAD。在main_arm.c (單片機版本的Demo)里面,這個VAD值控制了板子上的一個LED。如果VAD > 0.5 LED 會被點亮。

下圖為使用Keras的模型識別 VAD時刻 和 gains 的計算結(jié)果。

在語音中各個頻段的增益

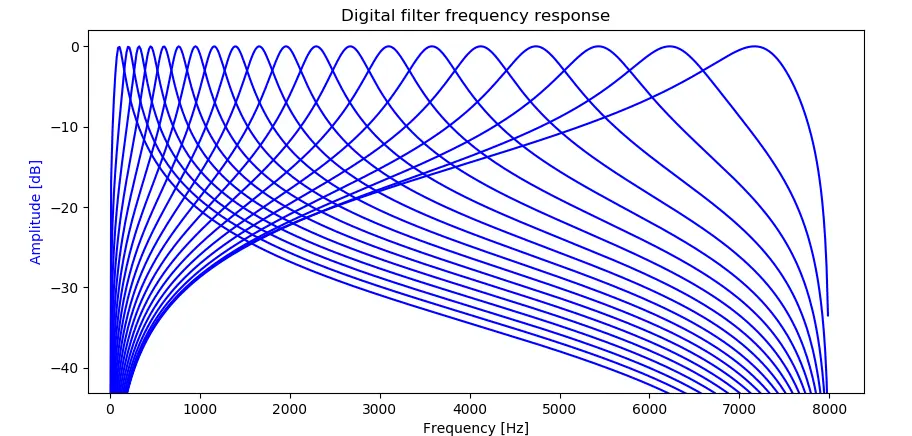

關(guān)于均衡器

這里使用了20(默認(rèn))或者13個帶通濾波器(Filter Band)來抑制噪音所在的頻率。實際上你可以設(shè)置成任何值。不過我推薦 大于10且小于30。每一個獨立的帶通濾波器的-3dB點都與它附近的帶通濾波器的-3dB點相交。響頻曲線如下:

濾波器響應(yīng)頻率范圍

音頻信號會平行地通過這些帶通濾波器,在最后把他們相加在一起。因為濾波器是交叉的,最終混合的信號幅度過大導(dǎo)致數(shù)值溢出,所以最終混合的信號會乘上一個0.6(并非數(shù)學(xué)上驗證的數(shù)值)再保存在int16 數(shù)組內(nèi)。

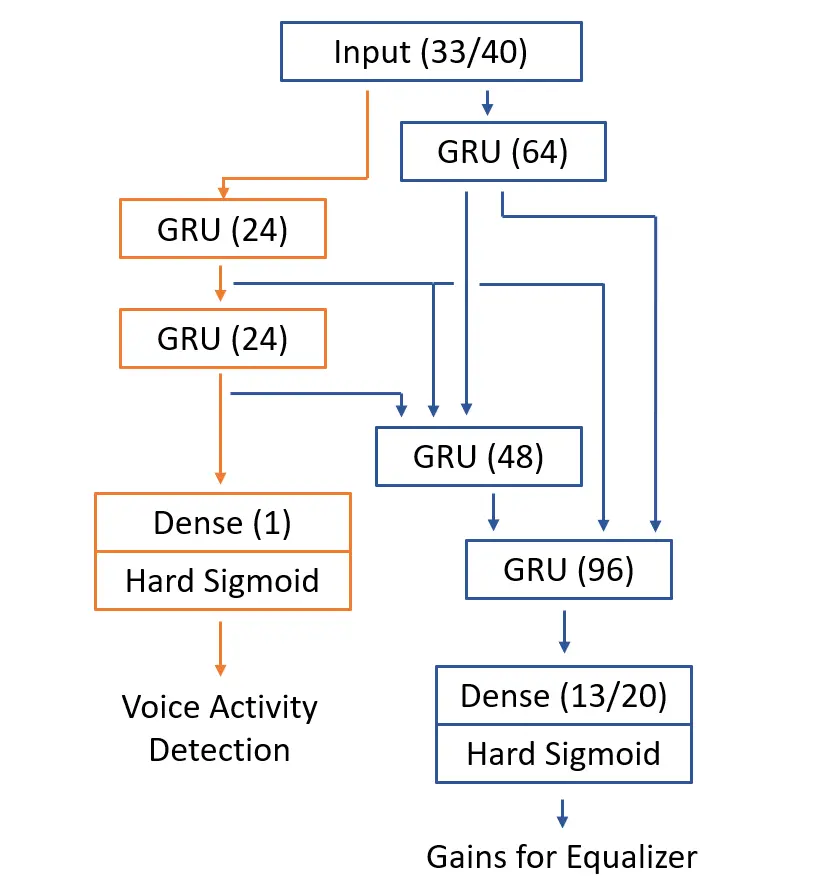

關(guān)于RNN模型的結(jié)構(gòu)

這里提供了兩個不同的RNN模型。一個是與RNNoise 類似的模型,各個RNN層之間包含很多的支線。這些支線會通過 concatenate 合并在一起。這個模型還會提供一個VAD輸出。整個模型一共約 120k的權(quán)重。比RNNoise稍高因為做了一些針對定點模型的改變。其實這個模型有點過于復(fù)雜了,我嘗試過減少模型參數(shù),仍然可以很好的進行降噪。大佬們可以大膽地調(diào)整參數(shù)。如圖下圖所示。

另一個模型是一個簡單的多層GRU模型,這個模型不提供VAD輸出。非常震驚的是這個模型也能提供不錯的效果。

如果想嘗試這個簡單的模型,在main.py里面修改 history = train(...) 成 train_simple(...)。

Keras的RNN需要把 stateful=True 打開,這樣NNoM在每計算一個timestamps的時候才不會重置state。

MCU 例子

這里提供了一個 MCU 的文件main_arm.c。這個文件針對 STM32L476-Discovery 的麥克風(fēng)做了移植,可以直接使用板載麥克風(fēng)進行語音降噪。

例子通過一個綠色 LED(PE8)輸出VAD檢測的結(jié)果,有人說話時就會亮。

除了單片機相關(guān)的代碼,功能上MCU代碼main_arm.c與PC代碼main.c完全一致, 本例雖然做了音頻降噪,但是并沒有針對音頻輸出寫驅(qū)動,所以降噪輸出是被直接拋棄了。大家可以自己寫保存或者回放的代碼。

如果你使用的是 ARM-Cortex M系列的MCU,做以下設(shè)置可以提升性能 (參考下面性能測試章節(jié))。

打開 NNoM 的 CMSIS-NN 后端,參考 Porting and Optimization Guide (https://github.com/majianjia/nnom/blob/master/docs/Porting_and_Optimisation_Guide.md)

在 mfcc.h里面,打開 PLATFORM_ARM 宏定義來使用ARM_FFT。

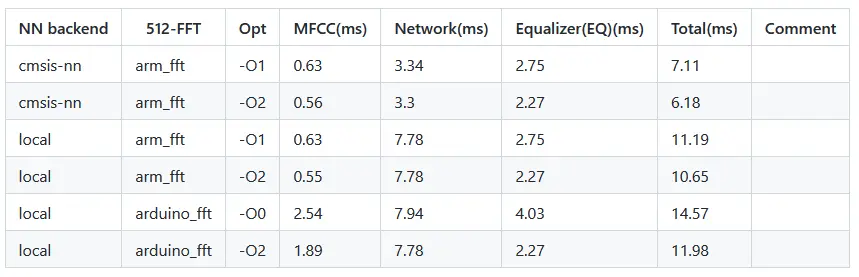

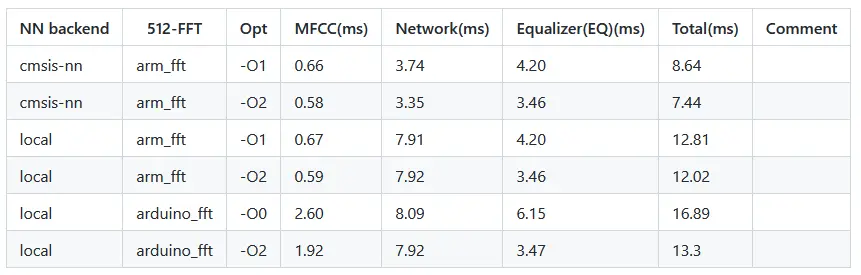

MCU 上的性能測試

傳統(tǒng)的 RNNoise 不止包含了浮點模型,還包括了其他計算(比如Pitch Filtering),導(dǎo)致總計算量在40MFLOPS左右。即是換成定點計算,一般的單片機也會很吃力。

本例中,浮點FFT,定點RNN模型,浮點均衡器(濾波器),并去掉了Pitch Filtering(額其實是因為我不知道怎么用)。我對這里使用的幾個運算量大的模塊進行了測試,分別是MFCC部分(包含F(xiàn)FT),神經(jīng)網(wǎng)絡(luò)部分,還有均衡器。

測試環(huán)境為

Board: STM32L476-Discovery

MCU: STM32L476, 超頻到 140MHz Cortex-M4F

音頻輸入: 板載PDM麥克風(fēng)

音頻輸出: 無

IDE: Keil MDK

測試條件:

神經(jīng)網(wǎng)絡(luò)后端: CMSIS-NN 或 Local C (本地后端)

FFT 庫(512點): arm_rfft_fast_f32 或 純FFT arduino_fft

優(yōu)化等級: -O0/-O1 或 -O2

均衡器濾波器數(shù)目: 13 band 或者 20 band

需要注意的是,這里使用的音頻格式為 16kHz 1CH,所以我們每次更新(FFT窗口:512,overlapping=50%)只有 256/16000 = 16ms 的時間來完成所有的計算。

13 Band Equalizer

可以看到,在完全優(yōu)化的情況下,最短用時僅僅6.18ms 相當(dāng)于38% 的CPU占用。在不適用ARM加速庫的情況下,也完全在16ms內(nèi)。因為所有的計算量是固定的,測試下來同一項目內(nèi)時間沒有太多的波動。

20 Band Equalizer

20個 band的情況下,在開啟優(yōu)化后也可以實現(xiàn)實時的語音降噪。

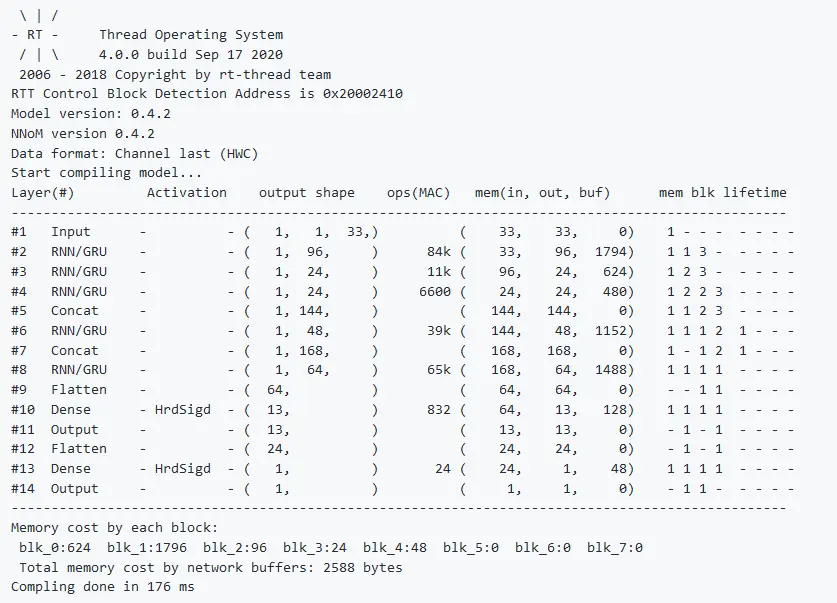

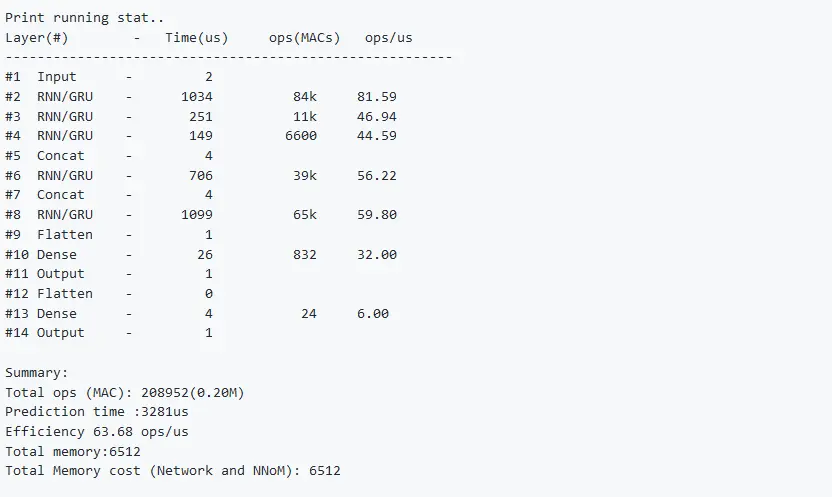

模型編譯log

單片機內(nèi)神經(jīng)網(wǎng)絡(luò)模型載入的log

單片機內(nèi)神經(jīng)網(wǎng)絡(luò)模型性能

原文標(biāo)題:【技術(shù)分享】STM32實現(xiàn)單麥克風(fēng)實時神經(jīng)網(wǎng)絡(luò)降噪

文章出處:【微信公眾號:電子發(fā)燒友論壇】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

審核編輯:湯梓紅

-

單片機

+關(guān)注

關(guān)注

6067文章

44960瀏覽量

648782 -

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4812瀏覽量

103198 -

降噪

+關(guān)注

關(guān)注

4文章

432瀏覽量

31750

原文標(biāo)題:【技術(shù)分享】STM32實現(xiàn)單麥克風(fēng)實時神經(jīng)網(wǎng)絡(luò)降噪

文章出處:【微信號:gh_9b9470648b3c,微信公眾號:電子發(fā)燒友論壇】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

助聽器降噪神經(jīng)網(wǎng)絡(luò)模型

粒子群優(yōu)化模糊神經(jīng)網(wǎng)絡(luò)在語音識別中的應(yīng)用

用matlab編程進行BP神經(jīng)網(wǎng)絡(luò)預(yù)測時如何確定最合適的,BP模型

關(guān)于BP神經(jīng)網(wǎng)絡(luò)預(yù)測模型的確定!!

卷積神經(jīng)網(wǎng)絡(luò)如何使用

【案例分享】ART神經(jīng)網(wǎng)絡(luò)與SOM神經(jīng)網(wǎng)絡(luò)

BP神經(jīng)網(wǎng)絡(luò)的數(shù)據(jù)分類——語音特征信號分類有哪些

如何用卷積神經(jīng)網(wǎng)絡(luò)方法去解決機器監(jiān)督學(xué)習(xí)下面的分類問題?

如何構(gòu)建神經(jīng)網(wǎng)絡(luò)?

如何使用stm32cube.ai部署神經(jīng)網(wǎng)絡(luò)?

神經(jīng)網(wǎng)絡(luò)移植到STM32的方法

卷積神經(jīng)網(wǎng)絡(luò)的介紹 什么是卷積神經(jīng)網(wǎng)絡(luò)算法

如何使用神經(jīng)網(wǎng)絡(luò)進行建模和預(yù)測

遞歸神經(jīng)網(wǎng)絡(luò)是循環(huán)神經(jīng)網(wǎng)絡(luò)嗎

AI神經(jīng)網(wǎng)絡(luò)降噪算法在語音通話產(chǎn)品中的應(yīng)用優(yōu)勢與前景分析

如何用神經(jīng)網(wǎng)絡(luò)進行語音降噪

如何用神經(jīng)網(wǎng)絡(luò)進行語音降噪

評論