在回答復(fù)雜的問(wèn)題時(shí),人類(lèi)可以理解不同模態(tài)的信息,并形成一個(gè)完整的思維鏈(Chain of Thought, CoT)。深度學(xué)習(xí)模型是否可以打開(kāi)「黑箱」,對(duì)其推理過(guò)程提供一個(gè)思維鏈呢?近日,UCLA 和艾倫人工智能研究院(AI2)提出了首個(gè)標(biāo)注詳細(xì)解釋的多模態(tài)科學(xué)問(wèn)答數(shù)據(jù)集 ScienceQA,用于測(cè)試模型的多模態(tài)推理能力。在 ScienceQA 任務(wù)中,作者提出 GPT-3 (CoT) 模型,即在 GPT-3 模型中引入基于思維鏈的提示學(xué)習(xí),從而使得模型能在生成答案的同時(shí),生成相應(yīng)的推理解釋。GPT-3 (CoT) 在 ScienceQA 上實(shí)現(xiàn)了 75.17% 的準(zhǔn)確率;并且人類(lèi)評(píng)估表明,其可以生成較高質(zhì)量的解釋。

像人類(lèi)一樣有效地學(xué)習(xí)并完成復(fù)雜的任務(wù)是人工智能追求的長(zhǎng)遠(yuǎn)目標(biāo)之一。人類(lèi)在決策過(guò)程中可以遵循一個(gè)完整的思維鏈(CoT)推理過(guò)程,從而對(duì)給出的答案做出合理的解釋。

然而,已有的機(jī)器學(xué)習(xí)模型大多依賴(lài)大量的輸入 - 輸出樣本訓(xùn)練來(lái)完成具體的任務(wù)。這些黑箱模型往往直接生成最終的答案,而沒(méi)有揭示具體的推理過(guò)程。

科學(xué)問(wèn)答任務(wù)(Science Question Answering)可以很好地診斷人工智能模型是否具有多步推理能力和可解釋性。為了回答科學(xué)問(wèn)題,一個(gè)模型不僅需要理解多模態(tài)內(nèi)容,還需要提取外部知識(shí)以得出正確答案。同時(shí),一個(gè)可靠的模型還應(yīng)該給出揭示其推理過(guò)程的解釋。然而,目前的科學(xué)問(wèn)答數(shù)據(jù)集大多缺乏對(duì)答案的詳細(xì)解釋?zhuān)蛘呔窒抻谖淖帜B(tài)。

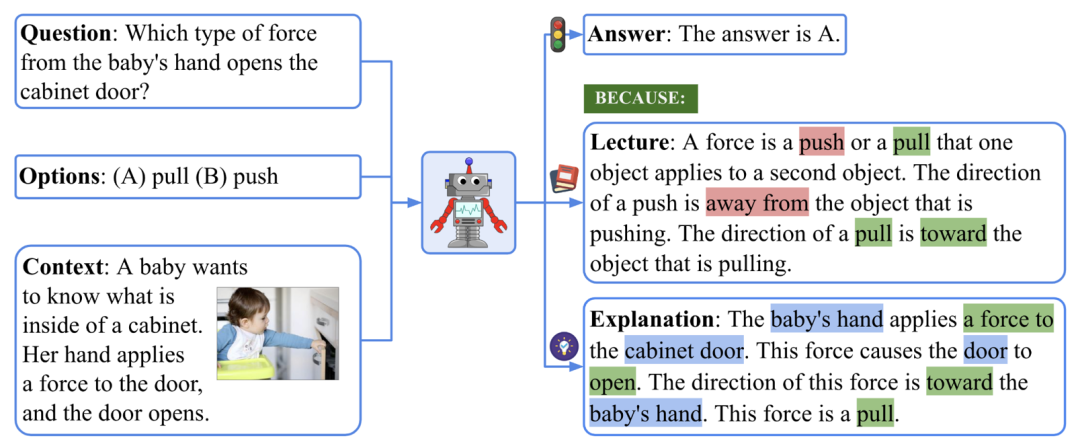

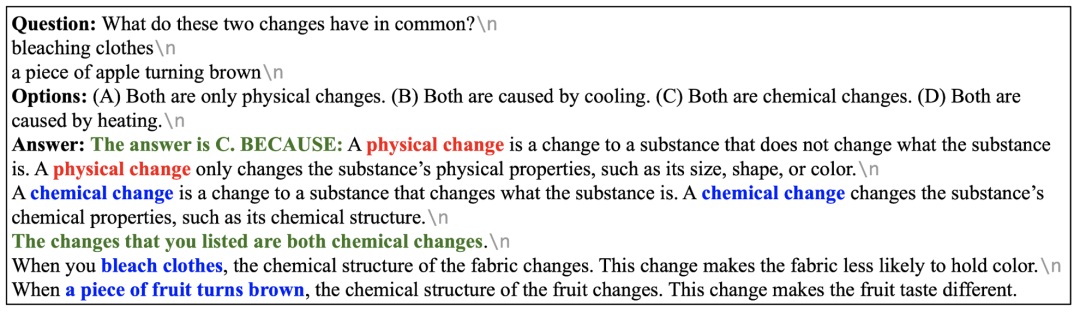

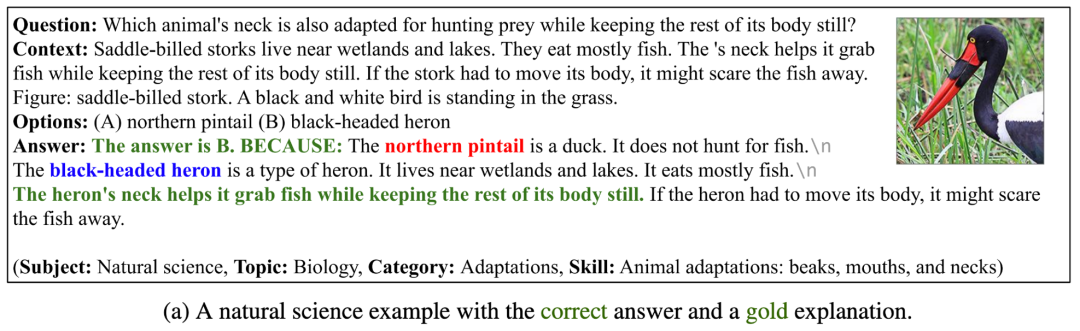

因此,作者收集了全新的科學(xué)問(wèn)答數(shù)據(jù)集 ScienceQA,它包含了 21,208 道來(lái)自中小學(xué)科學(xué)課程的問(wèn)答多選題。一道典型的問(wèn)題包含多模態(tài)的背景(context)、正確的選項(xiàng)、通用的背景知識(shí)(lecture)以及具體的解釋?zhuān)╡xplanation)。

ScienceQA 數(shù)據(jù)集的一個(gè)例子。

要回答上圖所示的例子,我們首先要回憶關(guān)于力的定義:「A force is a push or a pull that ... The direction of a push is ... The direction of a pull is ... 」,然后形成一個(gè)多步的推理過(guò)程:「The baby’s hand applies a force to the cabinet door. → This force causes the door to open. → The direction of this force is toward the baby’s hand. 」,最終得到正確答案:「This force is a pull. 」。

在 ScienceQA 任務(wù)中,模型需要在預(yù)測(cè)答案的同時(shí)輸出詳細(xì)地解釋。在本文中,作者利用大規(guī)模語(yǔ)言模型生成背景知識(shí)和解釋?zhuān)鳛橐环N思維鏈(CoT)來(lái)模仿人類(lèi)具有的多步推理能力。

實(shí)驗(yàn)表明,目前的多模態(tài)問(wèn)答方法在 ScienceQA 任務(wù)不能取得很好的表現(xiàn)。相反,通過(guò)基于思維鏈的提示學(xué)習(xí),GPT-3 模型能在 ScienceQA 數(shù)據(jù)集上取得 75.17% 的準(zhǔn)確率,同時(shí)可以生成質(zhì)量較高的解釋?zhuān)焊鶕?jù)人類(lèi)評(píng)估,其中 65.2% 的解釋相關(guān)、正確且完整。思維鏈也可以幫助 UnifiedQA 模型在 ScienceQA 數(shù)據(jù)集上取得 3.99% 的提升。

1、ScienceQA 數(shù)據(jù)集

數(shù)據(jù)集統(tǒng)計(jì)

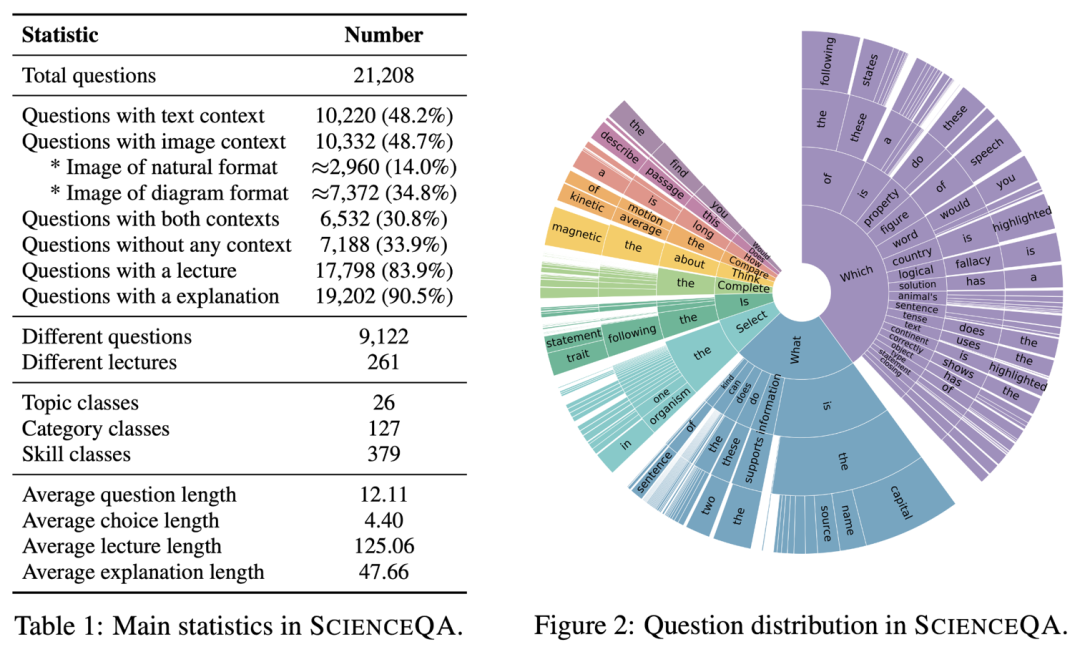

ScienceQA 的主要統(tǒng)計(jì)信息如下所示。

ScienceQA 數(shù)據(jù)集的主要信息

ScienceQA 包含21208個(gè)例子, 其中有9122個(gè)不同的問(wèn)題(question)。10332 道(48.7%)有視覺(jué)背景信息,10220 道(48.2%)有文本背景信息,6532 道(30.8%)有視覺(jué) + 文本的背景信息。絕大部分問(wèn)題標(biāo)注有詳細(xì)的解釋?zhuān)?3.9% 的問(wèn)題有背景知識(shí)標(biāo)注(lecture),而 90.5% 的問(wèn)題有詳細(xì)的解答(explanation)。

ScienceQA 數(shù)據(jù)集中問(wèn)題和背景分布。

數(shù)據(jù)集主題分布

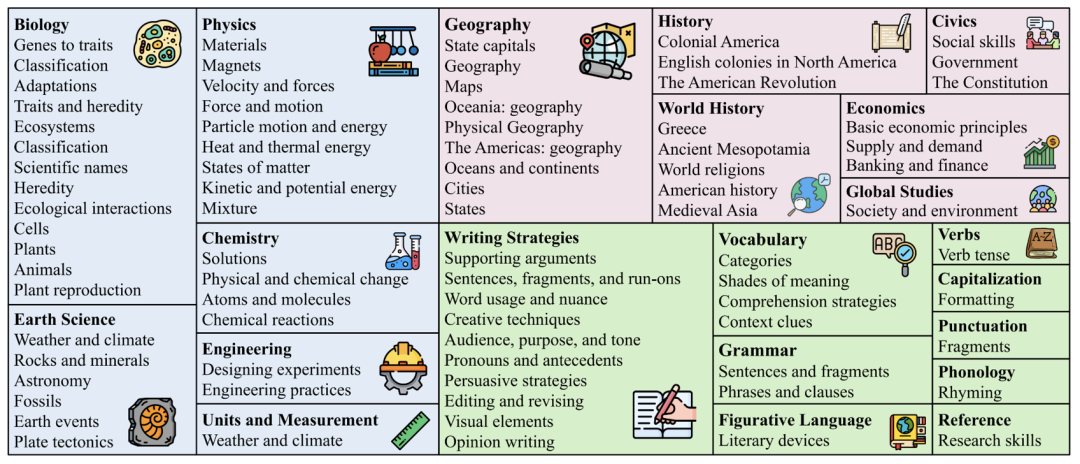

不同于已有的數(shù)據(jù)集,ScienceQA 涵蓋自然科學(xué)、社會(huì)科學(xué)和語(yǔ)言學(xué)三大學(xué)科分支,包含 26 個(gè)主題(topic)、127 個(gè)分類(lèi)(category)和 379 個(gè)知識(shí)技能(skill)。

ScienceQA 的主題分布。

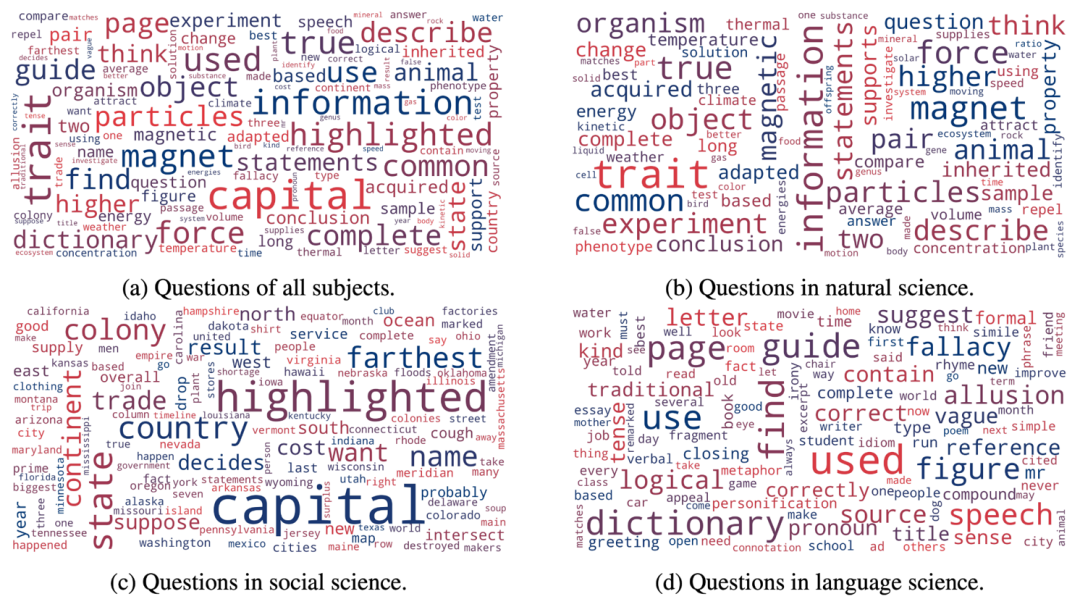

數(shù)據(jù)集詞云分布

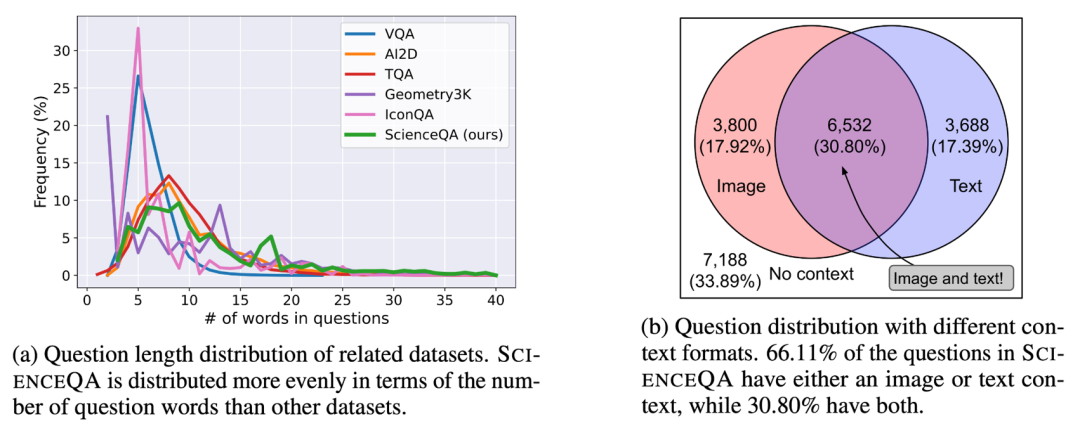

如下圖的詞云分布所示,ScienceQA 中的問(wèn)題具有豐富的語(yǔ)義多樣性。模型需要理解不同的問(wèn)題表達(dá)、場(chǎng)景和背景知識(shí)。

ScienceQA 的詞云分布。

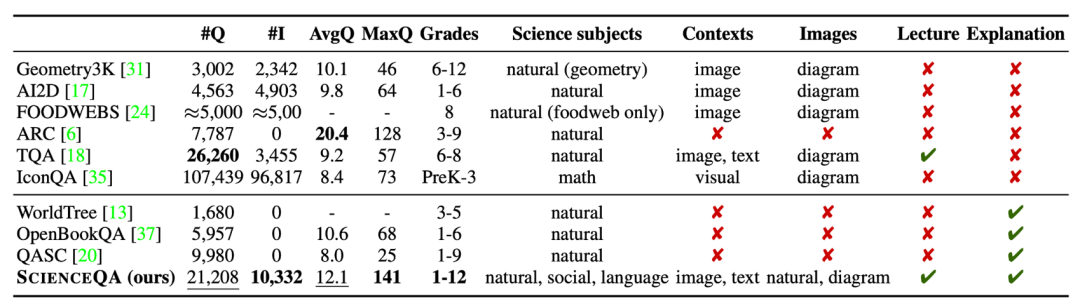

數(shù)據(jù)集比較

ScienceQA 是第一個(gè)標(biāo)注詳細(xì)解釋的多模態(tài)科學(xué)問(wèn)答數(shù)據(jù)集。相比于已有的數(shù)據(jù)集,ScienceQA 的數(shù)據(jù)規(guī)模、題型多樣性、主題多樣性等多個(gè)維度體現(xiàn)了優(yōu)勢(shì)。

ScienceQA 數(shù)據(jù)集與其它科學(xué)問(wèn)答數(shù)據(jù)集的比較。

2、模型和方法

Baselines

作者在 ScienceQA 數(shù)據(jù)集了評(píng)估不同的基準(zhǔn)方法,包括 VQA 模型如 Top-Down Attention、MCAN、BAN、DFAF、ViLT、Patch-TRM 和 VisualBERT,大規(guī)模語(yǔ)言模型如 UnifiedQA 和 GPT-3,以及 random chance 和 human performance。對(duì)于語(yǔ)言模型 UnifiedQA 和 GPT-3,背景圖片會(huì)被轉(zhuǎn)換成文本形式的注釋?zhuān)╟aption)。

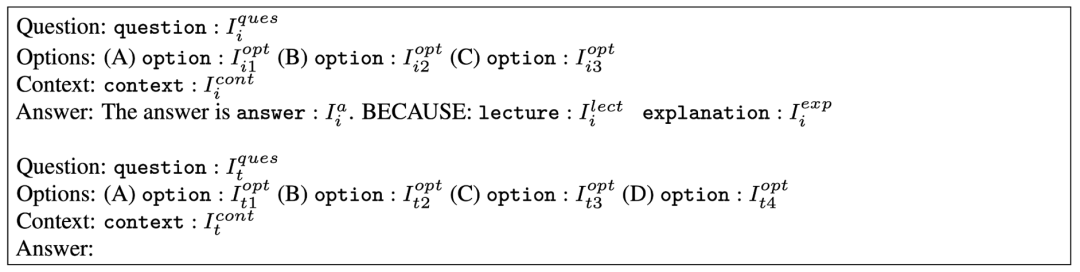

GPT-3 (CoT)

最近的研究工作表明,在給定合適的提示后,GPT-3 模型可以在不同的下游任務(wù)表現(xiàn)出卓越的性能。為此,作者提出 GPT-3 (CoT) 模型,在提示中加入思維鏈(CoT),使得模型在生成答案的同時(shí),可以生成對(duì)應(yīng)的背景知識(shí)和解釋。

具體的提示模板如下圖所示。其中 Ii 表示訓(xùn)練例子,It 表示測(cè)試?yán)印S?xùn)練例子包含問(wèn)題(Question)、選項(xiàng)(Options)、背景(Context)和答案(Answer)元素,其中答案由正確答案、背景知識(shí)(Lecture)和解釋?zhuān)‥xplanation)組成。GPT-3 (CoT) 會(huì)根據(jù)輸入的提示信息,補(bǔ)全測(cè)試?yán)拥念A(yù)測(cè)答案、背景知識(shí)和解釋。

GPT-3 (CoT) 采用的提示模板。

3、實(shí)驗(yàn)與分析

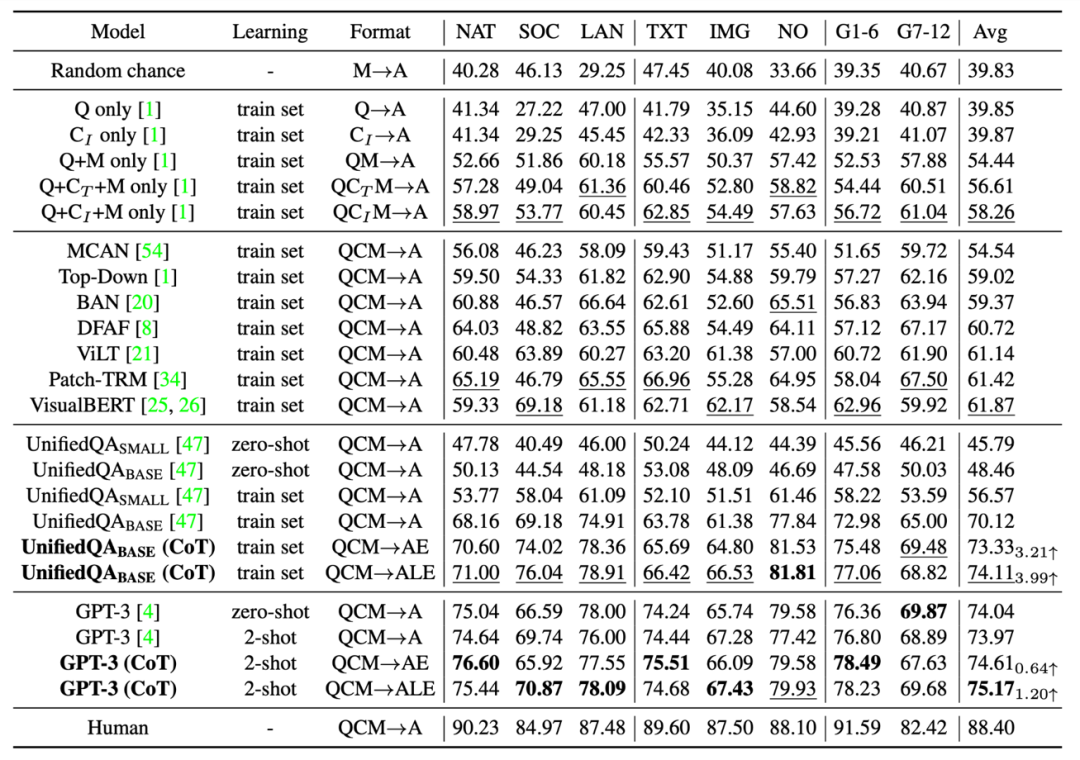

實(shí)驗(yàn)結(jié)果

不同的基準(zhǔn)和方法在 ScienceQA 測(cè)試集上的準(zhǔn)確率結(jié)果如下表所示。當(dāng)前最好的 VQA 模型之一的 VisualBERT 只能達(dá)到 61.87% 的準(zhǔn)確率。在訓(xùn)練的過(guò)程引入 CoT 數(shù)據(jù),UnifiedQA_BASE 模型可以實(shí)現(xiàn) 74.11% 的準(zhǔn)確率。而 GPT-3 (CoT) 在 2 個(gè)訓(xùn)練例子的提示下,實(shí)現(xiàn)了 75.17% 的準(zhǔn)確率,高于其它基準(zhǔn)模型。人類(lèi)在 ScienceQA 數(shù)據(jù)集上表現(xiàn)優(yōu)異,可以達(dá)到 88.40% 的總體準(zhǔn)確率,并且在不同類(lèi)別的問(wèn)題上表現(xiàn)穩(wěn)定。

不同的方法在 ScienceQA 測(cè)試集上的結(jié)果。

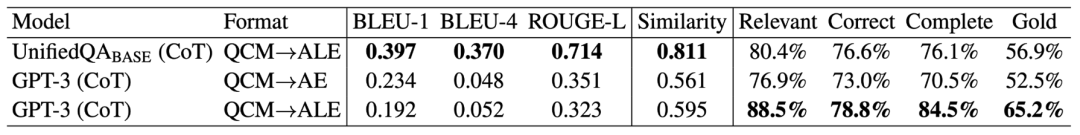

生成解釋的評(píng)估

作者用自動(dòng)評(píng)估指標(biāo)如 BLEU-1、BLEU-2、ROUGE-L 和 Sentence Similarity 評(píng)估了不同方法生成的解釋。由于自動(dòng)評(píng)估指標(biāo)只能衡量預(yù)測(cè)結(jié)果和標(biāo)注內(nèi)容的相似性,因此作者進(jìn)一步采用了人工評(píng)估的方法,來(lái)評(píng)估生成解釋的相關(guān)性、正確性和完整性。可以看到,GPT-3 (CoT) 生成的解釋中 65.2% 符合了 Gold 標(biāo)準(zhǔn)。

不同評(píng)估方法對(duì)生成解釋的結(jié)果。

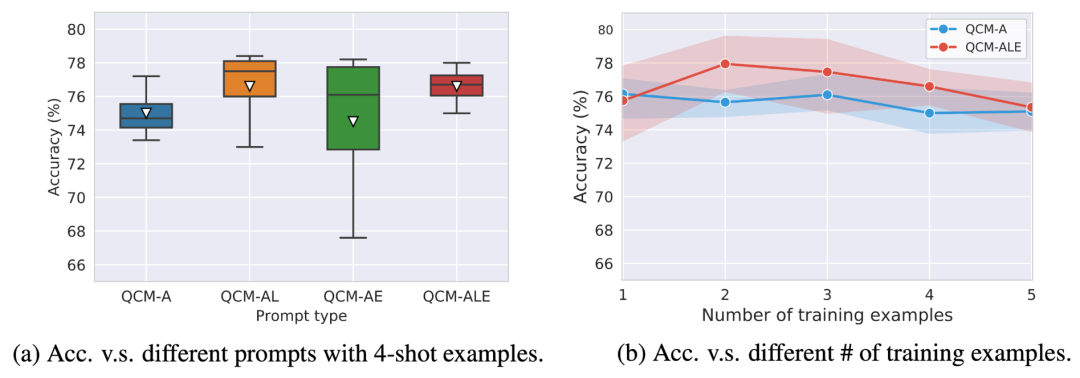

不同的提示模板

作者比較了不同的提示模板對(duì) GPT-3 (CoT) 準(zhǔn)確率的影響。可以看到在 QAM-ALE 的模板下,GPT-3 (CoT) 可以獲得最大的平均準(zhǔn)確率和最小的方差。另外,GPT-3 (CoT) 在 2 個(gè)訓(xùn)練例子的提示下,表現(xiàn)最佳。

不同提示模板的結(jié)果比較。

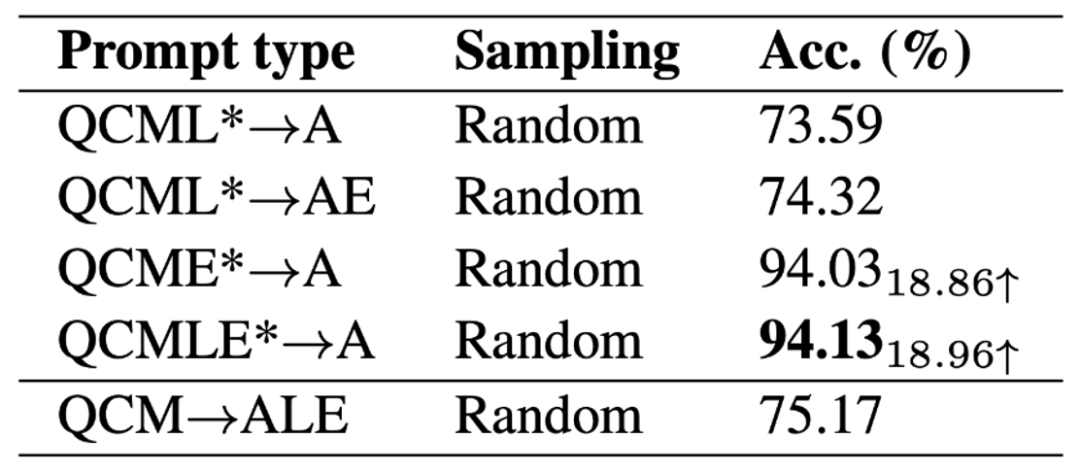

模型上限

為了探索 GPT-3 (CoT) 模型的性能上限,作者把標(biāo)注的背景知識(shí)和解釋加入模型的輸入(QCMLE*-A)。我們可以看到 GPT-3 (CoT) 可以實(shí)現(xiàn)高達(dá) 94.13% 的準(zhǔn)確率。這也提示了模型提升的一個(gè)可能方向:模型可以進(jìn)行分步推理,即先檢索到準(zhǔn)確的背景知識(shí)和生成準(zhǔn)確的解釋?zhuān)缓蟀堰@些結(jié)果作為輸入。這個(gè)過(guò)程和人類(lèi)解決復(fù)雜問(wèn)題的過(guò)程很相似。

GPT-3 (CoT) 模型的性能上限。

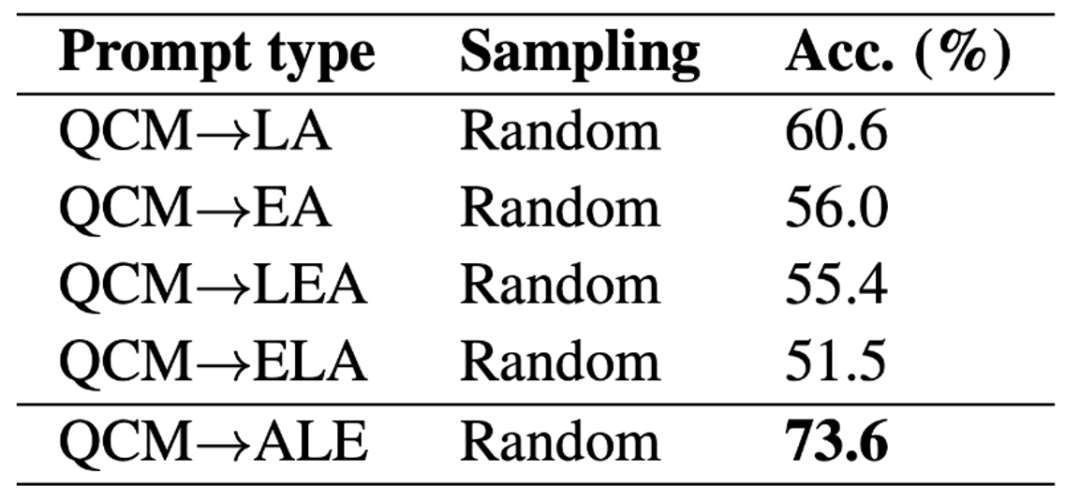

不同的 ALE 位置

作者進(jìn)一步討論了GPT-3 (CoT) 在生成預(yù)測(cè)時(shí),不同的 ALE 位置對(duì)結(jié)果的影響。在 ScienceQA 上的實(shí)驗(yàn)結(jié)果表明,如果 GPT-3 (CoT) 先生成背景知識(shí) L 或解釋 E,再生成答案 A,其預(yù)測(cè)準(zhǔn)確率會(huì)大幅下降。其主要原因是背景知識(shí) L 和解釋 E 有較多的詞語(yǔ)數(shù)量,如果先生成 LE,GPT-3 模型有可能用完最大詞數(shù),或者提前停止生成文本,從而不能得到最終的答案 A。

不同的 LE 位置。

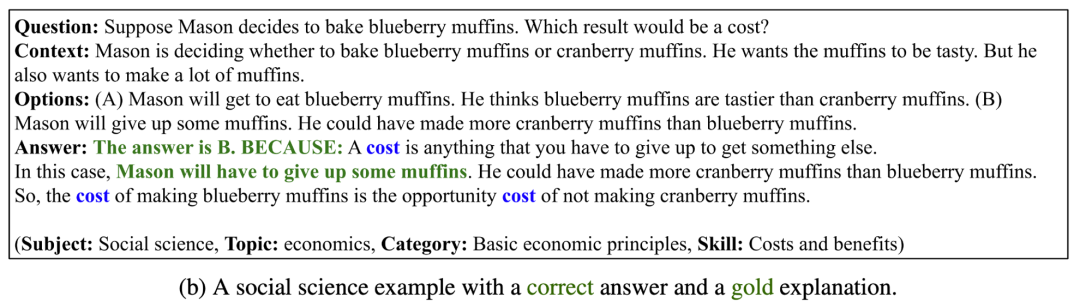

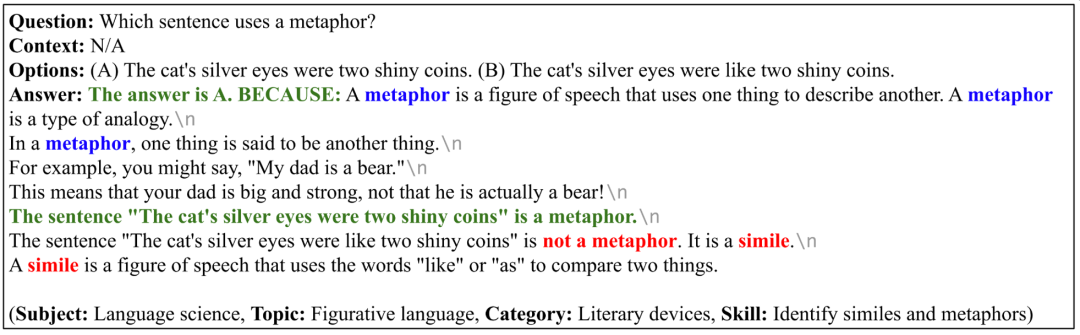

成功案例

如下 4 個(gè)例子中,GPT-3 (CoT)不但能生成正確的答案,也能給出相關(guān)、正確且完整的解釋。這說(shuō)明 GPT-3 (CoT) 在 ScienceQA 數(shù)據(jù)集上表現(xiàn)出較強(qiáng)的多步推理和解釋能力。

GPT-3 (CoT) 生成正確答案和解釋的例子。

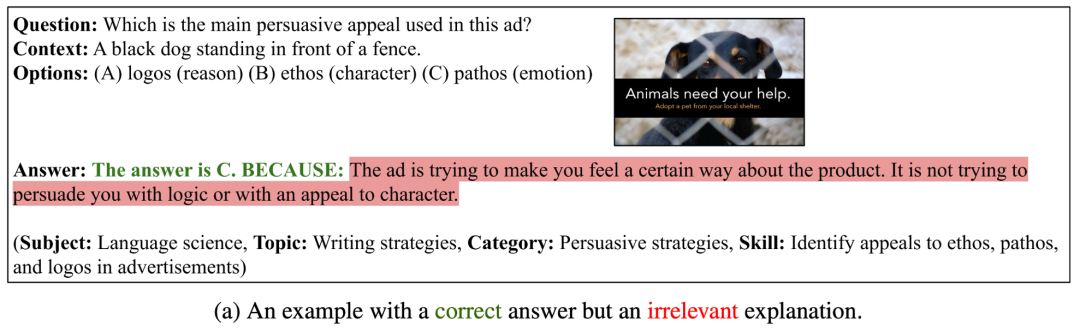

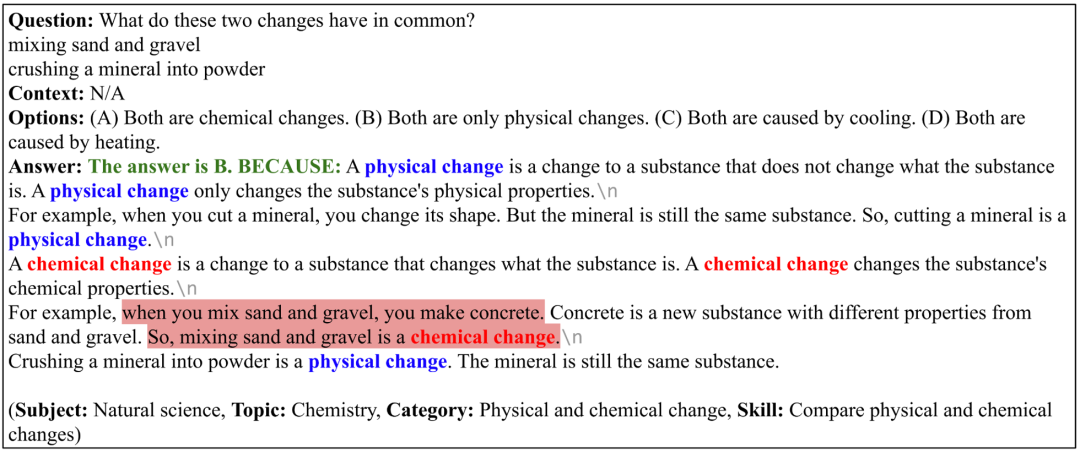

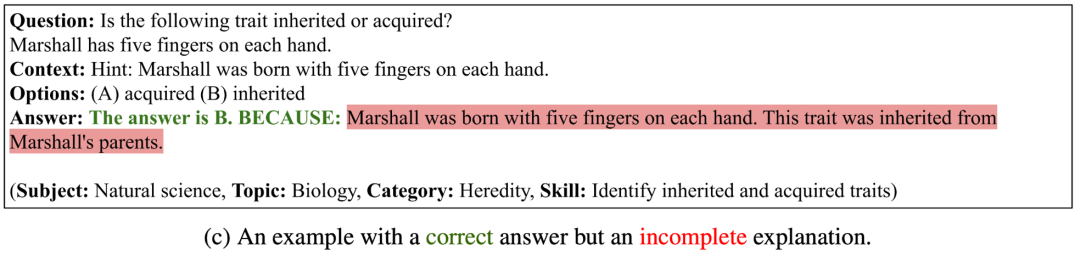

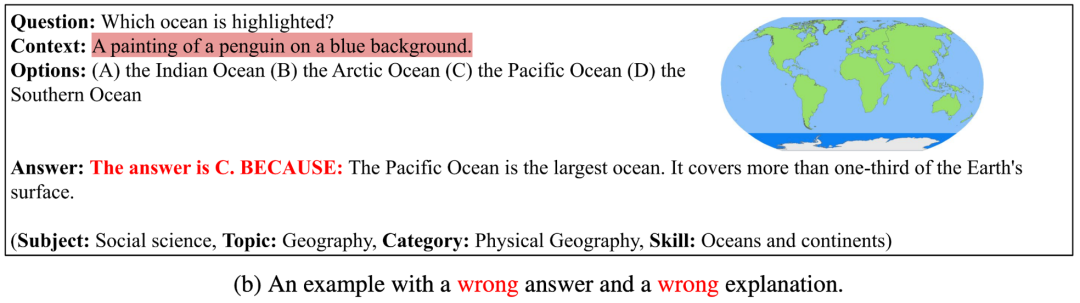

失敗案例 I

在下面的三個(gè)例子中,GPT-3 (CoT)雖然生成了正確的答案,但是生成的解釋不相關(guān)、不正確或者不完整。這說(shuō)明 GPT-3 (CoT) 對(duì)于生成邏輯一致的長(zhǎng)序列還面臨較大的困難。

GPT-3 (CoT) 能生成正確答案、但是生成的解釋不正確的例子。

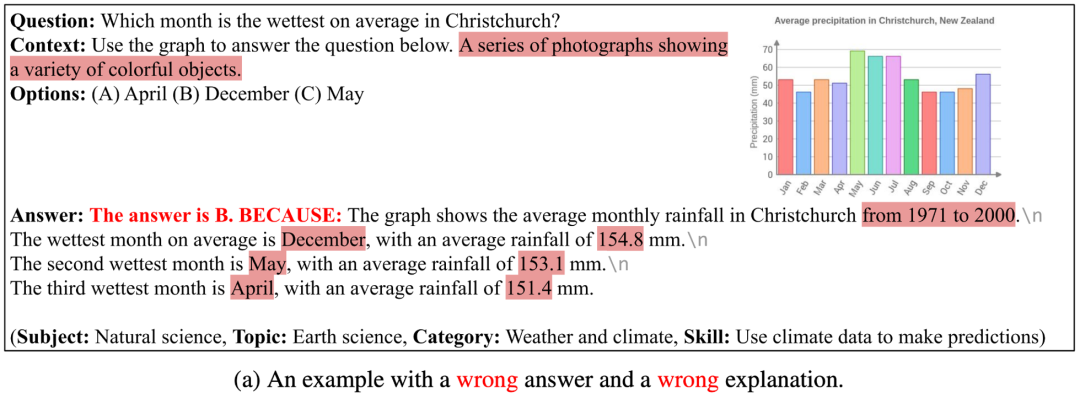

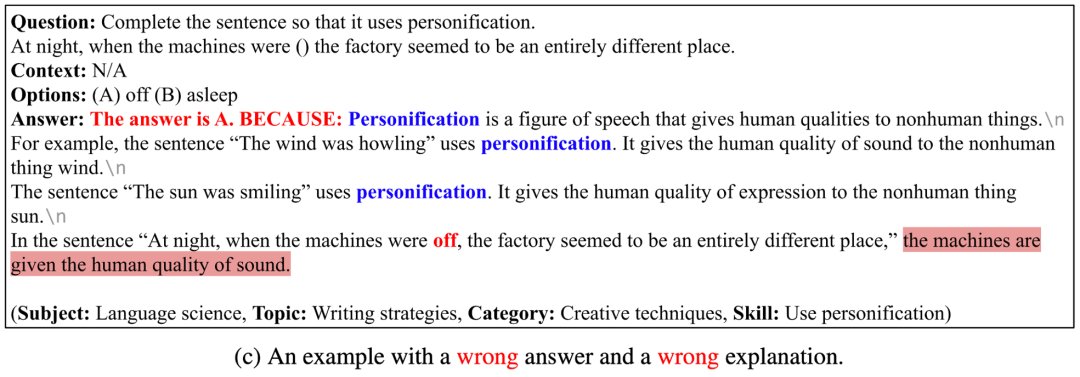

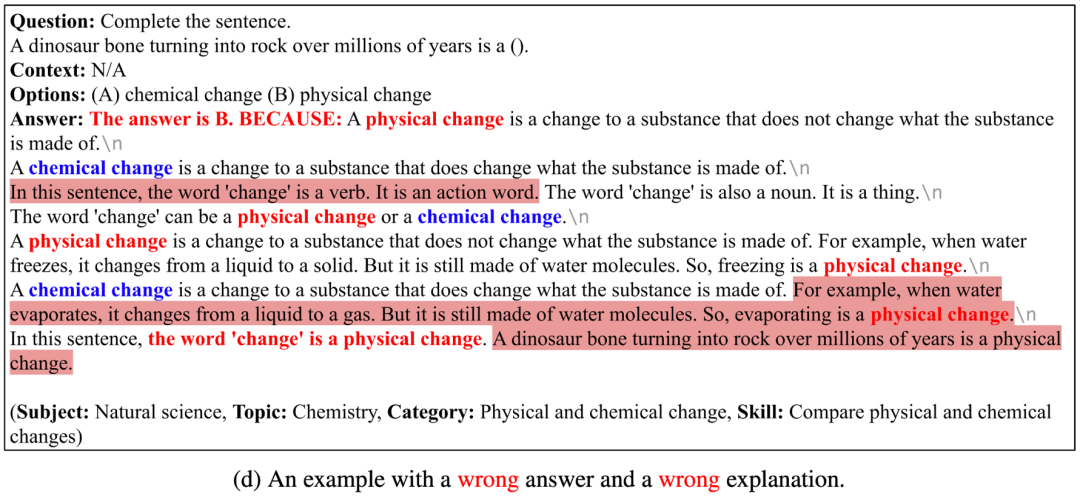

失敗案例 II

在下面的四個(gè)例子中,GPT-3 (CoT) 不能生成正確的答案,也不能生成正確的解釋。其中的原因有:(1)當(dāng)前的 image captioning 模型還不能準(zhǔn)確地描述示意圖、表格等圖片的語(yǔ)義信息,如果用圖片注釋文本表示圖片,GPT-3 (CoT) 還不能很好地回答包含圖表背景的問(wèn)題;(2)GPT-3 (CoT) 生成長(zhǎng)序列時(shí),容易出現(xiàn)前后不一致(inconsistent)或不連貫(incoherent)的問(wèn)題;(3)GPT-3 (CoT) 還不能很好地回答需要特定領(lǐng)域知識(shí)的問(wèn)題。

GPT-3 (CoT) 能生成錯(cuò)誤答案和解釋的例子。

4、結(jié)論與展望

作者提出了首個(gè)標(biāo)注詳細(xì)解釋的多模態(tài)科學(xué)問(wèn)答數(shù)據(jù)集 ScienceQA。ScienceQA 包含 21208 道來(lái)自中小學(xué)科學(xué)學(xué)科的多選題,涵蓋三大科學(xué)領(lǐng)域和豐富的話(huà)題,大部分問(wèn)題標(biāo)注有詳細(xì)的背景知識(shí)和解釋。ScienceQA 可以評(píng)估模型在多模態(tài)理解、多步推理和可解釋性方面的能力。作者在 ScienceQA 數(shù)據(jù)集上評(píng)估了不同的基準(zhǔn)模型,并提出 GPT-3 (CoT) 模型在生成答案的同時(shí),可以生成相應(yīng)的背景知識(shí)和解釋。大量的實(shí)驗(yàn)分析和案例分析對(duì)模型的改進(jìn)提出了有利的啟發(fā)。

審核編輯:郭婷

-

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25408 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5560瀏覽量

122748

原文標(biāo)題:NeurIPS 2022 | 首個(gè)標(biāo)注詳細(xì)解釋的多模態(tài)科學(xué)問(wèn)答數(shù)據(jù)集,深度學(xué)習(xí)模型推理有了思維鏈

文章出處:【微信號(hào):tyutcsplab,微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

大模型推理顯存和計(jì)算量估計(jì)方法研究

了解DeepSeek-V3 和 DeepSeek-R1兩個(gè)大模型的不同定位和應(yīng)用選擇

AI模型思維鏈功能升級(jí),提升透明度與可信度

OpenAI o3-mini模型思維鏈遭質(zhì)疑

智譜推出深度推理模型GLM-Zero預(yù)覽版

智譜GLM-Zero深度推理模型預(yù)覽版正式上線

阿里云開(kāi)源推理大模型QwQ

FPGA加速深度學(xué)習(xí)模型的案例

AI大模型與深度學(xué)習(xí)的關(guān)系

《AI for Science:人工智能驅(qū)動(dòng)科學(xué)創(chuàng)新》第二章AI for Science的技術(shù)支撐學(xué)習(xí)心得

《AI for Science:人工智能驅(qū)動(dòng)科學(xué)創(chuàng)新》第一章人工智能驅(qū)動(dòng)的科學(xué)創(chuàng)新學(xué)習(xí)心得

【《大語(yǔ)言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)知識(shí)學(xué)習(xí)

NVIDIA推出全新深度學(xué)習(xí)框架fVDB

深度學(xué)習(xí)模型有哪些應(yīng)用場(chǎng)景

深度學(xué)習(xí)模型量化方法

全新科學(xué)問(wèn)答數(shù)據(jù)集ScienceQA讓深度學(xué)習(xí)模型推理有了思維鏈

全新科學(xué)問(wèn)答數(shù)據(jù)集ScienceQA讓深度學(xué)習(xí)模型推理有了思維鏈

評(píng)論