2009年,NVIDIA黃教主發表了影響深遠的論斷:“NVIDIA是一家軟件公司”。這個時期的NVIDIA,已經開始把資源聚焦在GPGPU(GPU是圖像加速卡;GPGPU是并行計算平臺,既可以做圖形加速,還可以做其他并行計算加速),以及支撐GPGPU發展的CUDA之上。隨著AI等性能敏感場景的大規模爆發,NVIDIA市值超過了Intel等一眾競爭對手,迎來了輝煌的NVIDIA時代。

之后,更多的芯片公司,為了讓自己的芯片被客戶更好更方便地使用,逐漸把更多的資源聚焦在框架等軟件能力方面。芯片公司,逐漸地變成了軟件公司。

如今,芯片行業面臨新的挑戰:眾多互聯網客戶開始自研芯片。其本質原因是傳統芯片公司的創新不足,沒有合適的產品滿足互聯網客戶的業務發展需要。

未來,芯片公司僅僅把自己變成軟件公司還不夠,需要進一步的自我革新,從軟件公司變成互聯網公司,比客戶更懂客戶:能夠深層次理解用戶的需求和痛點,能夠提供顯著競爭優勢的性能價格比,能夠滿足客戶功能差異化和快速業務迭代,能夠支撐用戶業務和價值的快速創新。

01傳統芯片公司“閉門造車”

傳統芯片公司的傳統思路是這樣的:設計性能、成本、功耗都非常均衡的芯片,再配套相關的驅動和開發工具包,更好的則有開發庫和框架,甚至提供達到Turnkey級別的參考設計方案。

一般來說,能做到這樣的芯片公司已經足夠優秀。但世易時移,只達到這些要求,還遠遠不夠。因為這樣的方案是靜態的、局部的、短期的;缺乏動態的、宏觀的、長期的解決方案。

1.1 芯片性能足夠好,但靈活性和易用性不夠

CPU是最通用的處理器:CPU指令是最基礎的加減乘除,我們可以用這些指令最基本的指令組合出任何我們想要的程序和軟件。但隨著性能需求的不斷上升,我們不得不通過硬件加速的方式不斷地提升性能。

硬件加速的單位計算可以當做是一條非常復雜的宏指令。硬件加速的劣勢在于,由于單位計算的復雜度,導致硬件所能支持的系統靈活性急劇下降。

比如,AI處理器,為了更好地支持張量計算,提供了很強大的張量計算能力。但一方面受限于算法模型的多種多樣,另一方面受限于不同AI處理器架構的多種多樣(甚至出現同一家公司三代芯片架構均不相同的情況,這里的架構指的是加速器呈現給Host CPU的接口架構,不是具體實現的微架構),很難快速把AI模型高效的映射到特定架構的AI處理器,從而導致性能效率不高,開發效率低等易用性問題。

這些問題導致AI處理器面對的場景規模受限,場景的生命周期受限,從而導致芯片難以大規模落地,芯片的價值難以發揮。

1.2 只解決單一問題,而客戶需要綜合性解決方案

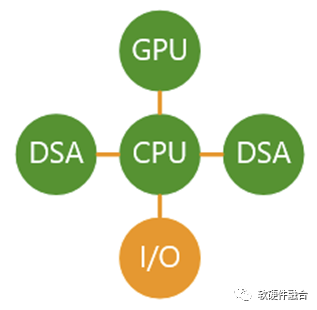

CPU是通用的解決方案,適合于幾乎所有場景;GPGPU是并行計算,適合于若干個常見的領域加速場景;DSA,只適合于某個特定領域;ASIC,只適合于某個特定場景。從CPU到ASIC,覆蓋的場景越來越小,覆蓋場景的生命周期越來越短。

我們提供芯片A幫助客戶解決問題a,提供芯片B幫助客戶解決問題b,依此類推。但這樣會產生有很多問題:

只考慮一個問題會顧此失彼,不同的芯片間沒有協同。而且即使有協同,從架構上也決定了很難高效協同。

多個個體解決方案無法組織成用戶需要的“有機”整體。如同“瞎子摸象”一般,當不同供應商給客戶提供扇子、繩子、柱子、墻壁的時候,客戶是無法組織成“大象”的。

服務器物理空間和功耗有限。無法容納這么多張單領域或場景解決方案的加速卡,客戶需要綜合性解決方案。

1.3 芯片公司架構的個性化,而客戶需要架構的一致化

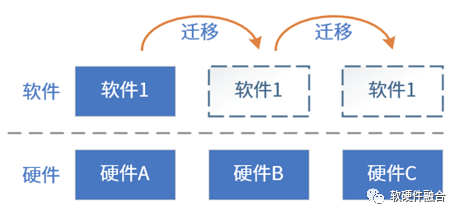

在手機等終端上,軟件依附于硬件而存在。在提供硬件的基礎上,提供相關的驅動及其他相關的開發和參考設計即可。不需要關注不同架構芯片的跨平臺問題。而在云計算、邊緣計算甚至一些超級智慧終端(如自動駕駛芯片NVIDIA Thor等)上,軟件實體和硬件實體是完全獨立的,軟件實體可以運行在不同的硬件平臺;反過來,硬件實體也可以支持不同的軟件實體運行。因此,軟件跨平臺成為非常重要的能力需求。

在軟件虛擬化時代,可以通過虛擬化技術屏蔽硬件接口/架構差異性,可以實現軟件從一個硬件遷移到另一個硬件。而在硬件虛擬化時代,軟硬件的接口直接暴露給VM/容器等虛擬化實體,以及越來越多的異構計算引擎的加入,為了繼續支持軟件可遷移,越來越需要考慮硬件架構的問題。硬件架構一致性問題,更加凸顯!

芯片設計不再是一家公司考慮一個型號一個架構的問題,而是更多的要思考“和主流生態兼容,和別人的芯片架構兼容,并且高效、標準、開放,甚至還能持續演進”的問題。

02互聯網公司自研芯片

目前,幾乎所有有實力的互聯網公司都在自研芯片,有很多文章對這些信息進行梳理,這里就不再贅述。

2.1 云計算等復雜場景的特點

互聯網及云計算公司的業務場景非常復雜,其與硬件相關的特點主要表現在:

超大的規模。例如,AWS擁有超過500萬臺服務器,分布在全球27個地理區域和87個可用區。

大量的數據。據IDC預測,到2025年,全球數據量超過175ZB,復合增長率27%,云端數據存儲占比超過50%。

復雜的網絡。關鍵是帶寬和延遲,還要關注域間隔離和跨域訪問,以及訪問控制、快速網絡變更等。

虛擬化、池化和多租戶。主機/容器等虛擬化,用于資源隔離;虛擬化+池化,資源自由組合;多租戶共享資源。核心價值在于提高資源利用率,降低成本。

安全問題。包括網絡安全、存儲安全、數據安全、可信根及“零信任”、可信計算等。

彈性和可擴展性。橫向擴展,資源數量的增減;縱向擴展,資源容量或性能的升降。

復雜系統解構。微服務/云原生,更多東西向流量。復雜系統不斷解構,與多租戶、多系統共存。

可遷移性和硬件接口一致性。運行實體和硬件環境分離:虛擬化屏蔽硬件差異,VM/容器等在不同服務器遷移。硬件接口直通VM,需要不同廠家硬件接口一致性。

特定場景服務。資源池化后,通過CPU、內存、存儲、網絡等資源的不同比例再組合,擴展出特定場景優化的實例類型。

總之,云計算等宏觀復雜場景,具有很多超出個體硬件的很多高級的特征,這需要硬件平臺能夠支持足夠的系統靈活性,來滿足系統的當前和未來各種需要。

2.2 跟場景結合的三種方式

云計算等復雜計算場景,對靈活性的要求大于對性能的要求。在性能滿足要求的情況下,CPU是最合適的云計算平臺。如今,CPU的性能逐漸瓶頸,不得不硬件加速來提升性能。

這也就是目前的矛盾之所在:一方面,芯片需要跟具體客戶的具體業務深度結合來實現業務的硬件加速;另一方面,芯片卻要適配不同客戶的業務功能差異性,以及業務邏輯的長期快速迭代。行業里目前主要有如下一些形式來應對這些挑戰。

方式一,針對場景,提供(自認為)最優的業務加速方案給客戶。

存在的問題是:

完全定制的解決方案,面向2B市場,無法滿足所有客戶的要求;

一定程度上需要客戶修改自己的業務邏輯(客戶作為云計算供應商,其云上支撐了數以千億甚至萬億價值計的云客戶的業務,更改底層服務業務邏輯的風險非常高),客戶遷移的成本和風險都很高;

并且會產生芯片供應商依賴,對云計算運營商來說并不是好的選擇。

方式二,供應商跟客戶深度合作,做滿足客戶需求的產品。大客戶自研芯片,也可以算到跟客戶深度合作這一類(內部客戶也是客戶)。

這樣做的優勢是:

能方便快捷的拿到詳細的客戶需求,了解場景痛點;

重量級種子客戶,深度打磨產品,早期種子客戶的支持,是產品成功的關鍵。

劣勢可能是:

客戶需求不是最本質的需求,需要深度洞察。比如,用戶告訴我們,需要更快、更舒適的馬車,而我們提供的可能會是更快、更舒適的汽車,甚至飛機。

需求有橫向和縱向的差異。橫向差異指的是不同客戶的個性化需求,也包括同一大客戶內部不同團隊的差異化需求;縱向差異指的是單個客戶的快速迭代。滿足一個客戶/團隊需求,可否滿足其他更多客戶/團隊的需求?因為芯片研發周期和生命周期的緣故(兩者總計為8年左右),滿足單個客戶/團隊當前的需求,可否滿足單個客戶/團隊長達8年的業務演進需求?可否滿足所有客戶/團隊長達8年的業務演進需求?

那么,是否還存在第三種解決方案?

方式三:做平臺化產品,客戶通過編程實現所需求的功能。

平臺的可編程能力,是可以非常輕松做到的。但如何確保ASIC級別極致性能的同時,依然由用戶掌控一切,由用戶編程決定業務邏輯,則是一個有挑戰性的話題。

如果能夠做到:足夠性能價格比(數量級提升的極致性能,更便宜的價格)、足夠通用(覆蓋更多客戶的更多場景)、足夠靈活(能夠覆蓋客戶長期的、快速的業務邏輯演進)、足夠易用(兼容已有開發環境和業務邏輯,客戶平滑遷移,沒有太多學習成本,沒有平臺依賴),實現“用戶軟件定義一切,平臺硬件加速一切”的目標,則是未來大家都需要面臨和解決的挑戰。

03客戶自研分析

從短期來看,當一個行業出現變革的時候,客戶比供應商更早感受到“痛苦”,也更需要更多的底層創新來驅動自身業務的競爭力提升。但從更長期的視角來看,情況卻并不一定如此。

3.1 客戶的本質訴求

互聯網行業,目前有很多客戶開始自研芯片,這是一個重要的趨勢。很多人認為,互聯網公司為了構建自己的護城河,開始構建一套“封閉”體系。而我們更多的是認為:隨著互聯網云和邊緣計算的發展,上層的軟件業務對底層硬件要求越來越高。而傳統的芯片公司,雖然有一些先進的技術,但局限于閉門造車,這些技術并沒有為客戶帶來新的更大的價值,反而在一些方面,約束了客戶的價值發揮。這些矛盾,逼迫著一些有實力自研的用戶,不得不“自己動手,豐衣足食”,開始了自研之路。

那么,“想喝牛奶,真的一定要自己養牛嗎?”用戶的本質訴求到底是什么?這里我們深入分析一下:

更高性能/成本比。性價比是永恒的話題,都希望最低廉的成本下提供最高的性能價值。

差異化。toB市場,互聯網云計算公司需要有足夠理想的硬件平臺,能夠支撐自身業務的差異化,也能夠支撐云計算提供差異化的價值給到云的用戶(也即用戶的用戶)。

可迭代。軟件的迭代很快,而為了延長設備的生命周期(也是一種降成本的手段),則需要硬件能夠盡可能支持軟件服務的更長期迭代。

快速業務創新。用戶的業務是核心競爭力,而研發芯片不是。用戶需要的是能夠自己掌控一切的開發平臺,來實現業務創新,來增強自身的核心競爭力。

無平臺依賴。平臺依賴某種程度上就是一種“壟斷”,客戶肯定不希望自己被綁定在某個特定的平臺上,這樣會降低自己的“話語權”,并且還存在巨大的技術風險。

如果存在通用的芯片方案,能夠滿足上述這些需求,用戶不會產生平臺依賴,不對用戶自身業務的核心競爭力構成威脅,并且功能更加強大,性能更加強勁,價格更具有顯著優勢,客戶還需要自研嗎?

3.2 宏觀、長期、發展的視角看客戶自研

回想互聯網巨頭自研芯片這件事情,更多的感受是,行業和技術都在巨變:云計算、邊緣計算出現后,系統的規模數量級膨脹。能深刻理解這些系統需求的莫過于互聯網公司,而芯片公司對系統的把握,就有點捉襟見肘。

但從更宏觀、更長期以及發展的視角看,整個全球產業是國際化大分工的,每個地區每個公司,都做自己最擅長的事情。最經典的例子,莫過于臺積電。臺積電之前,設計和制造是一體的,典型的企業是Intel、AMD和TI。臺積電創造性地只做foundry,不做設計,從此后才有了Fabless。記得在十多年前的時候,Intel仍如日中天,很多人羨慕Intel這種能從設計到工藝的全流程優化,所以做的產品性能成本是別人無法達到的。而如今,在臺積電、三星等的競爭下,Intel自己的設計和制造成了相互拖累。而臺積電所構筑的核心競爭優勢,使得眾多TOP級的Fabless根本就不會去想著自建制造工廠,或者說不是不想而是不能。

人類發展的過程,就是從“男耕女織”到“手工作坊”,再到流水線的“工業化大生產”,再到現在的“全球化大分工”。從更宏大更長期的視角看,隨著時間推移,很多技術會沉淀,云計算這樣的互聯網底層技術也不例外。

當然,底層的芯片公司,需要不斷地自我革新,才能真正幫助客戶,成就客戶,也成就自己。

04芯片公司需要革新,比客戶更懂客戶

4.1 系統變得越來越復雜

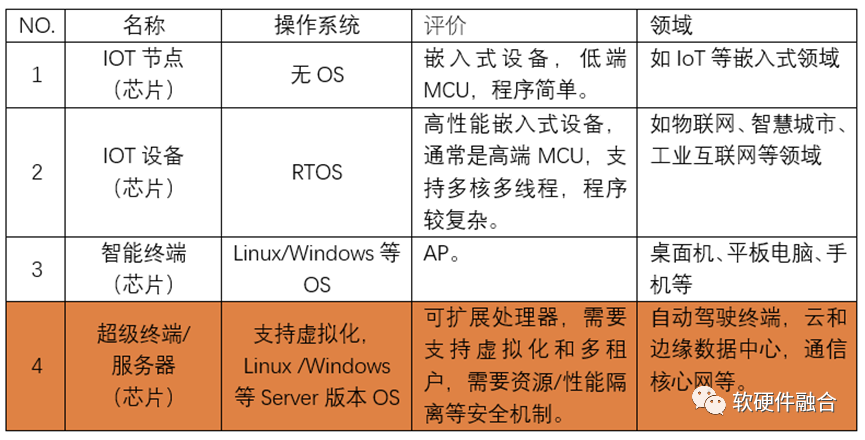

我們簡單定義一下三個層次的系統分類:

小系統。不需要跑智慧型操作系統,用于IoT等嵌入式場景的MCU芯片。這個時候,整個系統只有一個地址空間,所有的程序本質上是一個程序的不同片段。

大系統。如手機、平板和臺式電腦。需要跑Linux、安卓、iOS、Macos、windows等智慧型操作系統,需要通過MMU支持多個不同的地址空間,需要VA-PA的一級地址映射,才能實現不同的程序運行在自己獨立的地址空間里。

復雜宏系統。需要更多的地址空間,需要MMU支持GVA-GPA(HVA)-HPA的兩級地址轉換。

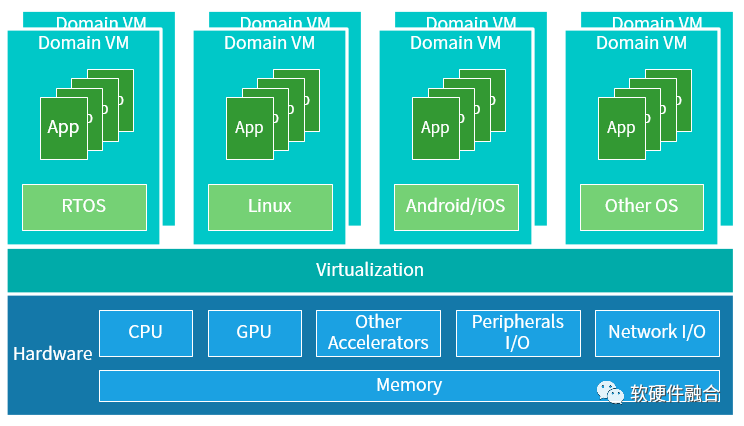

復雜系統場景如云計算、邊緣計算和超級終端場景:需要支持操作系統和虛擬化,包括虛機、容器等不同層次虛擬化;需要支持資源切分;需要支持系統、資源和性能隔離;需要支持軟件跨硬件平臺,包括硬件接口抽象和熱遷移等。

從系統的角度看:

在小系統和大系統時代,設備即系統。每個設備就是一個系統邊界,即便是通過一定的通信接口和外部聯系,但設備作為一個獨立系統,其特征足夠明顯。

但在復雜宏系統時代,每個設備只是龐大系統的一份子。軟件需要非常方便的跨不同的處理器架構、不同的芯片、不同的服務器運行,甚至需要跨云網邊端不同的設備運行。這個時候,以設備為系統邊界變得越來越模糊,系統變成了數以百萬級的設備組成的超級大系統。

4.2 芯片公司,需要變成互聯網公司

系統的規模相比以往提高了多個數量級,變成了更加復雜的宏系統:

只懂軟件,難以駕馭復雜的芯片架構設計,做出來的產品通常是面向特定領域的加速卡,無法深入,難以整合;

只懂硬件,堆疊的性能再好,用戶難以駕馭,場景覆蓋小芯片無法大規模落地;

唯有軟件和硬件的深度融合,才是正確的發展道路。

系統規模越來越多,系統的技術體系發生巨變,系統的架構在不斷重構,芯片公司/團隊也需要自我升級:

過去,小系統芯片公司。芯片公司就是純粹的芯片公司。硬件軟件的人員比例大概在1:1 - 1:2,公司的核心都在圍繞著芯片展開。

現在,大系統芯片公司。芯片公司本質上是軟件公司。NVIDIA的老黃很早前就提過,NVIDIA是一家軟件公司。做大系統芯片的公司基本上的人員比例都在1:5+,芯片人員很核心,但人數相對少,軟件人員數量顯著超過硬件人員數量。

未來,宏系統芯片公司。芯片公司本質上是互聯網公司。這個時候,芯片公司有著對萬物互聯和云網邊端融合的超級大系統的深層次理解,能夠駕馭超級大系統,能夠實現硬件和軟件的深度融合,能夠提供創新的超越用戶需求的更高價值的產品、解決方案和服務。這一時期,硬件軟件人員的比例,一般來說,通常在1:10+。

審核編輯 :李倩

-

處理器

+關注

關注

68文章

19833瀏覽量

233923 -

芯片

+關注

關注

459文章

52306瀏覽量

437757 -

互聯網

+關注

關注

54文章

11239瀏覽量

105891 -

芯片架構

+關注

關注

1文章

32瀏覽量

14709

原文標題:未來,所有芯片公司都需要進化成互聯網公司

文章出處:【微信號:算力基建,微信公眾號:算力基建】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

鯤云科技入選AII工業互聯網應用案例

物聯網未來發展趨勢如何?

安謀科技亮相2025世界互聯網大會亞太峰會,共筑AI算力新未來

智造未來,工業互聯網mes系統開啟“工業4.0”新篇章

互聯網芯事系列篇

云互聯網是什么意思

2025年互聯網板塊機遇顯現

Coremail亮相世界互聯網大會“互聯網之光”博覽會

未來,所有芯片公司都需要進化成互聯網公司

未來,所有芯片公司都需要進化成互聯網公司

評論