■機器學習的巨大成功帶來了新一波人工智能應用

(例如,交通、安全、醫療、財務、防御)提供了巨大的好處,但無法向人類用戶解釋其決策和行動。DARPA的可解釋人工智能(XAI)計劃致力于創建人工智能系統,其學習的模型和決策能夠被最終用戶理解和適當信任。實現這一目標需要學習更多的可解釋模型,設計有效的解釋界面,理解有效解釋的心理需求。XAI開發團隊正在通過創建ML技術和開發用于生成有效解釋的原則、策略和人機交互技術來解決前兩個挑戰。另一個XAI團隊正在通過總結、擴展和應用心理學解釋理論來解決第三個挑戰,以幫助XAI評估人員確定合適的評估框架,開發團隊將使用該框架測試其系統。XAI團隊于2018年5月完成了該4年計劃的第一個項目。在一系列正在進行的評估中,開發團隊正在評估他們的XAM系統的解釋如何改進用戶理解、用戶信任和用戶任務性能

機器學習(ML)技術的發展使得人工智能系統能夠獨立感知、學習、決策和行動。然而,他們將無法向人類用戶解釋他們的決定和行為。這種缺乏對于國防部來說尤為重要,國防部的挑戰要求開發更智能、更自主、更共生的系統。如果用戶要理解、適當信任和有效管理這些人工智能伙伴,可解釋的AI將是必不可少的。為了解決這一問題,DARPA于2017年5月啟動了其可解釋人工智能(XAI)計劃。DARPA將可解釋人工智能定義為能夠向人類用戶解釋其基本原理、描述其優缺點并傳達對其未來行為的理解的人工智能系統。將該程序命名為可解釋人工智能(而不是可解釋、可理解或透明人工智能)反映了DARPA的目標,即通過使用有效的解釋來創建更多人類可理解的人工智能系統。它還反映了XAI團隊對人類解釋心理學的興趣,它利用了社會科學中大量的研究和專業知識。

他們進行某種形式的邏輯推理,并能提供推理步驟的痕跡,成為解釋的依據。在使這些系統更易于解釋方面做了大量的工作,但它們沒有滿足用戶對理解的需求(例如,簡單地總結系統的內部工作并不能產生充分的解釋),并且在現實世界的復雜性面前過于脆弱。

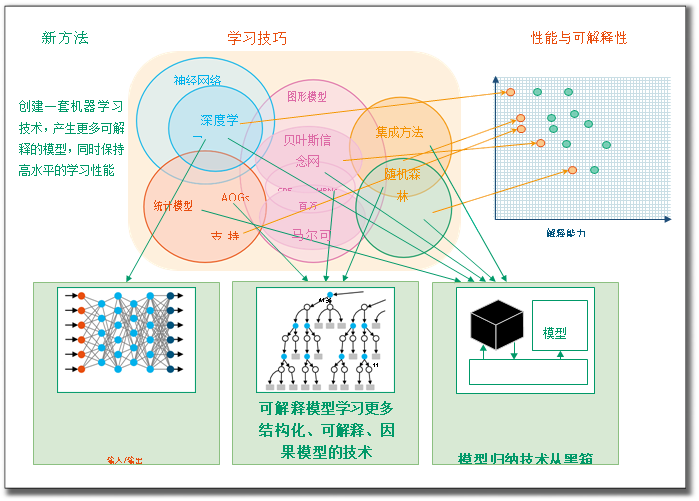

最近人工智能的成功很大程度上歸功于在其內部表示中構造模型的新的ML技術。其中包括支持向量機、隨機森林、概率圖形模型、強化學習(RL)和深度學習(DL)神經網絡。雖然這些模型表現出高性能,但它們是不透明的。隨著其使用的增加,從ML和認知心理學的角度對可解釋性的研究也在增加。類似地,最近也舉辦了許多與XAI相關的研討會,討論ML(例如,國際機器學習會議、神經信息處理系統會議)、AI(例如,國際人工智能聯合會議),和HCI(如人機交互會議、智能用戶界面會議)會議一樣,都有與XAI相關的專題會議。ML性能(例如,預測準確性)和可解釋性之間似乎存在內在的張力;通常,性能最高的方法(例如,DL)是最不可解釋的,而最可解釋的方法(例如,決策樹)是最不精確的。用各種ML技術的性能可解釋性權衡的概念圖說明了這一點。(脈輪et公司。2017年;Ras公司et公司al公司.2018年)(米勒2017年)。

當DARPA制定XAI計劃時,它設想了三種廣泛的策略來提高可解釋性,同時保持高水平的學習績效,基于當時有前景的研究(2):深度解釋、可解釋模型和模型歸納。深度解釋是指修改或混合DL技術,可以學習更多可解釋的特性或表示,或者包括解釋生成工具。(Deep explaining)。(Deep explaining)。(Deep explaining)。(Deep explaining)是指修改或混合DL技術,以了解更多可解釋的特性或表示。一些設計選擇可能產生更多可解釋的表示(例如,訓練數據選擇、體系結構層、損失函數、正則化、優化技術、訓練序列)。研究人員已經使用反褶積網絡來可視化卷積網絡層,并且已經存在將語義概念與深度網絡節點關聯的技術。生成圖像標題的方法可以擴展到訓練第二個深層網絡,該網絡生成解釋而不需要明確識別原始網絡的語義特征。

可解釋模型是學習更多結構化、可解釋或因果模型的ML技術。早期的例子包括貝葉斯規則列表、貝葉斯程序學習、因果關系學習模型以及使用隨機語法學習更多可解釋結構。(Letham等人.2015年),模型歸納是指使用任何給定的ML模型(如黑盒)進行實驗,以推斷出近似的可解釋模型的技術。例如,模型不可知解釋系統通過觀察和分析黑箱模型的輸入輸出行為來推斷解釋。里韋羅et公司。(2016年)

DARPA使用這些策略對新的ML技術組合進行分類,并為未來的從業者提供更廣泛的設計選項,涵蓋性能可解釋性交易空間。

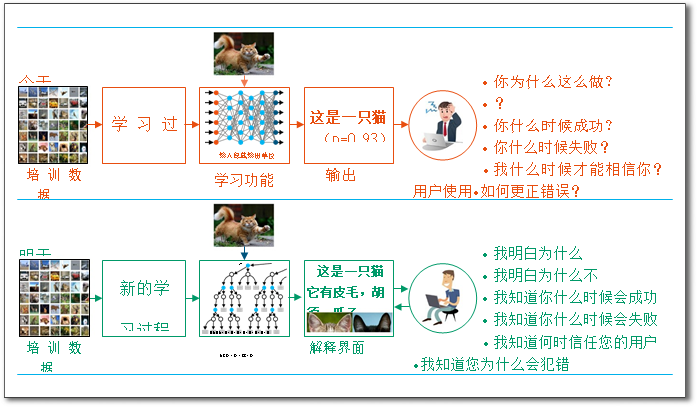

XAI計劃的目標是創建一套新的或改進的ML技術,這些技術產生可解釋的模型,當與有效的解釋技術相結合時,使最終用戶能夠理解、適當信任和有效管理新一代AI系統。。例如,從大數據分析系統接收建議的情報分析員需要了解為什么它會推薦某些活動進行進一步調查。同樣,要求自動駕駛車輛行駛路線的操作員需要了解系統的決策模型,以便在未來的任務中適當地使用該模型。說明了XAI概念:為用戶提供解釋,使他們能夠理解系統的整體優勢和劣勢,傳達對其在未來或不同情況下的行為的理解,并允許用戶糾正系統的錯誤。

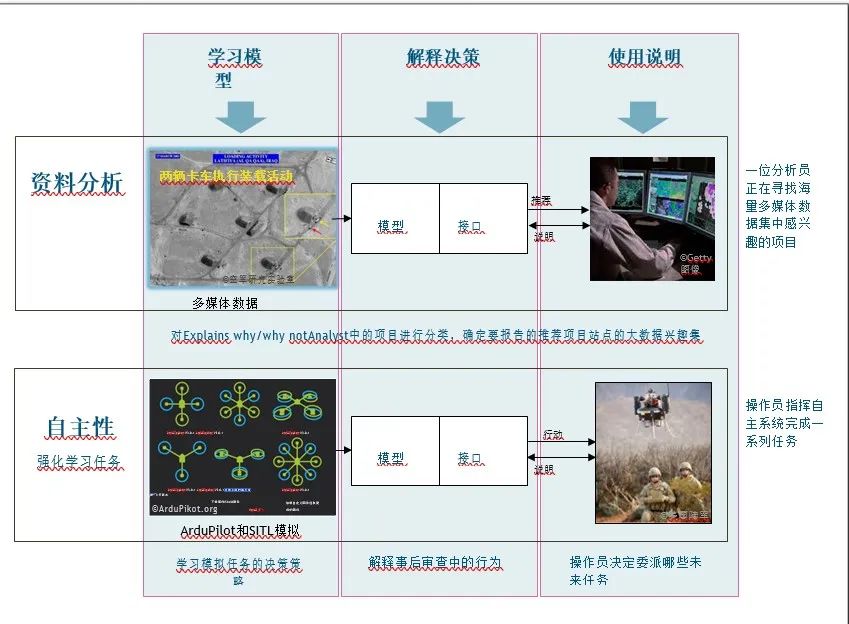

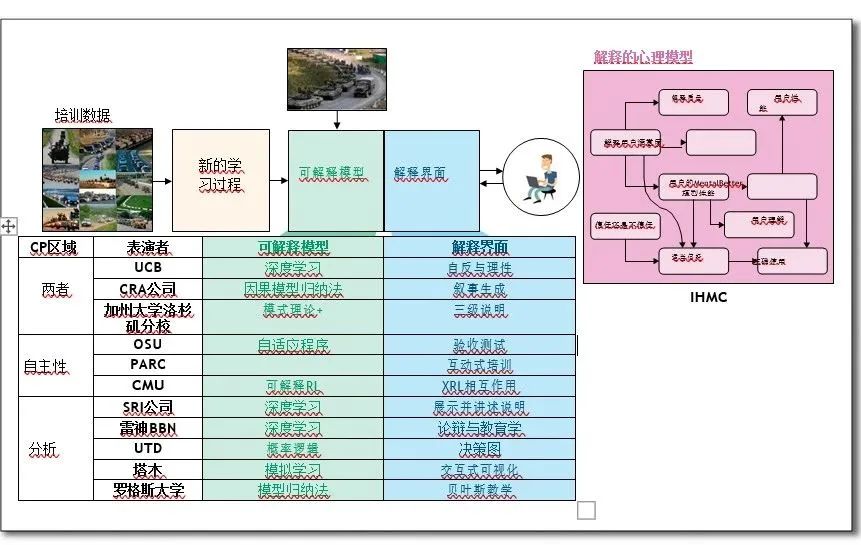

這種以用戶為中心的概念提出了相關的研究挑戰:(1)如何產生更多可解釋的模型;(2)如何設計解釋界面;(3)如何理解有效解釋的心理需求。前兩個挑戰由11個XAI研究團隊解決,他們正在開發新的ML技術來產生可解釋的模型,以及新的原則、策略和HCI技術(例如,可視化、語言理解、語言生成)來產生有效的解釋。第三個挑戰是另一個XAI研究團隊的重點,該團隊正在總結、擴展和應用心理學解釋理論。XAI計劃解決兩個與操作相關的挑戰問題領域(4)數據分析(異構多媒體數據中感興趣事件的分類)和自治(自治系統的決策策略)。這些領域代表兩個重要的ML問題類別(監督學習和RL)和國防部的興趣(情報分析和自主系統)。數據分析挑戰的動機是一個共同的問題:向情報分析師提供來自大數據的決策和建議金融機構古爾分析算法,必須決定在分析中報告哪些作為支持證據,以及進一步研究哪些。這些算法經常產生錯誤警報,必須對其進行刪減,并受到概念漂移的影響。此外,這些算法通常會提出建議,分析師必須對這些建議進行評估,以確定證據是否支持或違背其假設。有效的解釋將有助于解決這些問題。

圖1學習績效與可解釋性在幾種學習技巧之間的權衡

自主性挑戰的動機是需要有效管理AI合作伙伴。例如,國防部尋求半自主系統來增強作戰人員的能力。操作員需要了解它們的行為,以便確定在未來任務中如何以及何時最好地使用它們。有效的解釋將更好地促成這種決定。

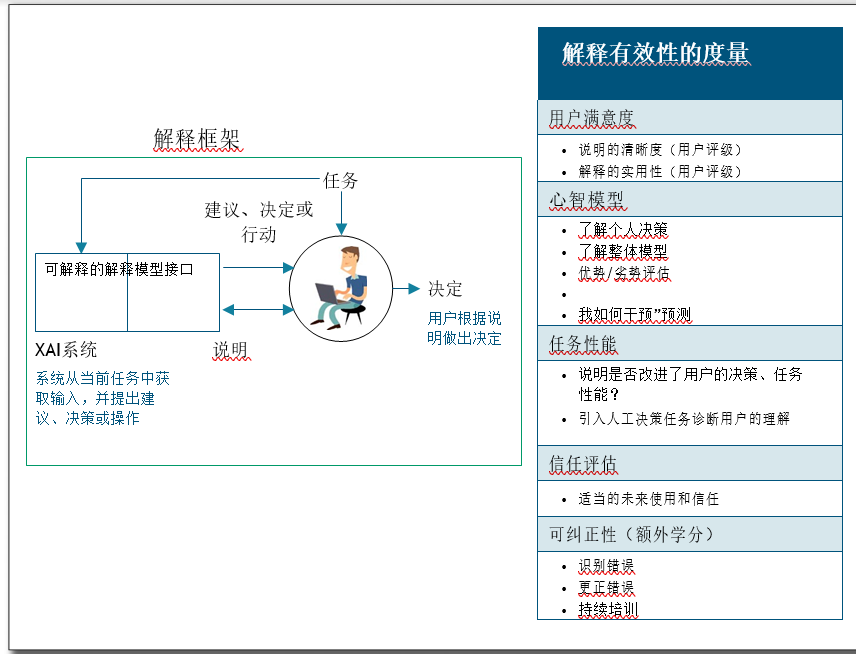

對于這兩個挑戰問題領域,衡量解釋的有效性至關重要。如果一個學習模型的可解釋性能夠被自動測量是很方便的,那么XAI系統的解釋有效性必須根據它的解釋如何幫助人類用戶來評估。這就需要人在回路心理實驗來衡量用戶的滿意度、心理模型、任務績效和適當的信任。DARPA制定了初始解釋評估框架,其中包括解釋有效性的潛在措施(5)。探索和改進此框架是XAI項目研究議程的重要組成部分。

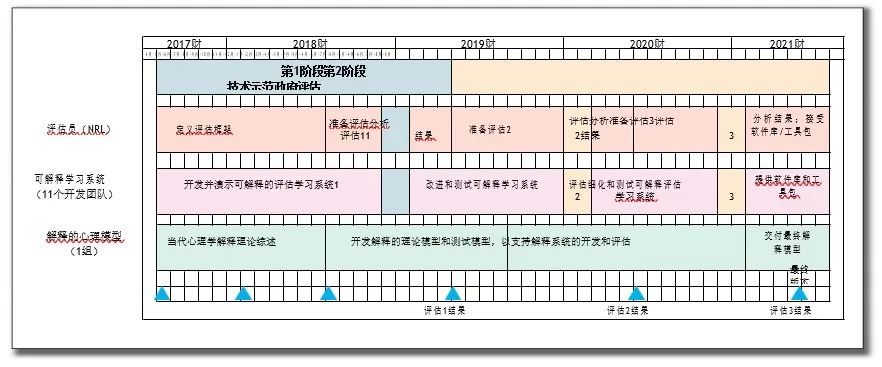

XAI計劃的目標、概念、戰略、挑戰和評估框架在該計劃的2016年廣泛機構公告中進行了描述。顯示XAI程序的計劃,該計劃由兩個階段組成。第1階段(18個月)于2017年5月開始,包括XAI系統的初始技術演示。階段2(30個月)包括針對系統開發人員和XAI評估人員選擇的挑戰性問題的一系列評估。XAI系統的首次正式評估于2018年秋季進行。本文描述了開發團隊在進行這些評估之前所取得的進展,評估結果在2019年冬季的XAI項目會議上展示。-

XAI項目開發與進展

圖7(見后面)總結了11個XAI技術領域1(TA1)開發團隊和TA2團隊[來自佛羅里達人機認知研究所(IHMC)],他們正在開發解釋的心理模型。三個TA1團隊同時致力于挑戰問題領域(自主性和數據分析),三個團隊僅致力于前者,五個團隊僅致力于后者。根據2中描述的策略,TA1團隊正在研究開發可解釋模型和解釋接口的各種技術。金融機構古爾

XAI的決策基礎

IHMC團隊(包括MacroCognition和密歇根理工大學的研究人員)的目標是開發和評估心理上合理的解釋模型,并開發可操作的概念、方法、度量和解釋推理度量。

圖2 開發可解釋模型的策略

研究解釋本身的性質。如果一個人試圖解釋(1)一個復雜系統的工作原理和(2)為什么它在一個給定的情況下會這樣做,那么他會滿意嗎?為了解決這些問題,團隊制定了人類解釋推理的自然模型,并就評估XAI系統解釋有效性的方法向執行團隊提供指導。研究小組查閱了科學哲學和心理學專業的相關文獻,從中綜合了評價解釋“正確性”的標準。該小組還收集和分析一個案例語料庫,其中個人創建或接收復雜系統工作的解釋。-

該團隊開發了解釋正確性、用戶心理模型(例如正確性、完整性)和用戶任務性能的度量。。為了獲得這種洞察力,用戶必須探索XAI系統的決策過程和性能,特別是對于邊界情況,包括深度神經網絡(DNN)的欺騙方式。這個在一系列的文章中描述了方法論(霍夫曼和克萊因2017年;霍夫曼et公司。2017年;克萊n2018年;霍夫曼et公司。2018年)。

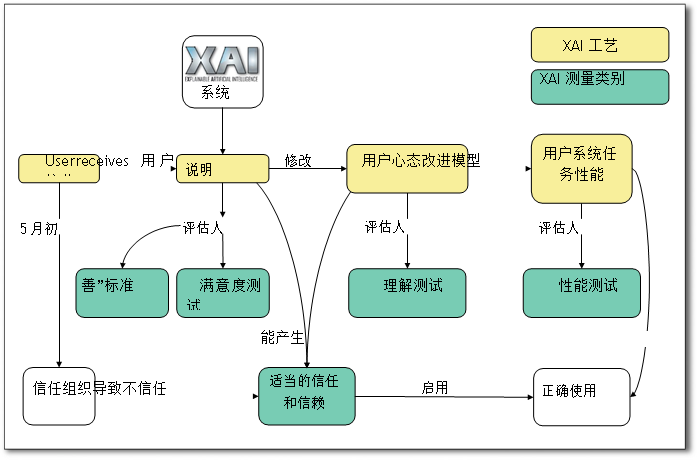

圖8說明了IHMC的XAI解釋過程模型,突出了評估解釋有效性的度量類別。用戶從XAI系統收到一個建議或決定,以及一個可以測試其優劣(相對于預先制定的標準)和用戶滿意度的解釋。該解釋有助于用戶的人工智能系統的心理模型,它可以測試的準確性和理解力。AI系統的建議和用戶的心理模型可能會啟用或降低用戶任務性能,這也可以測量。這些過程有助于用戶正確或不正確地信任AI系統。XAI evaluator使用此模型來測試開發團隊的XAI系統。

圖3 XAI概念

評估XAI項目的獨立政府評估機構是海軍研究實驗室。對于第1階段,實驗室(在IHMC的幫助下)為TA1團隊準備了一個評估框架,用作設計和實施他們的第一階段評估實驗,他們將在數據分析或自主性的挑戰問題領域選擇一個或多個測試問題;應用他們新的ML技術學習他們問題的可解釋模型;評估學習的ML模型的性能(表1);將學習模型與解釋界面相結合,形成可解釋的學習系統;使用可解釋學習系統進行用戶執行指定任務的實驗;并采用IHMC的解釋過程模型(8)和解釋有效性測量類別1)測量解釋有效性。

評估將包括以下實驗條件:(1)不作說明:XAI系統用于執行任務,不向用戶提供說明;(2) 帶解釋:XAI系統用于執行任務,并為它所做的每個建議或決策以及它所采取的每個操作生成解釋;(3) 部分解釋:XAI系統用于執行任務,僅生成部分解釋或燒蝕解釋(用于評估各種解釋特征);和(4)控制:一個基線狀態的最先進的非解釋性系統用于執行任務。

可解釋學習系統

可深入解釋的AI

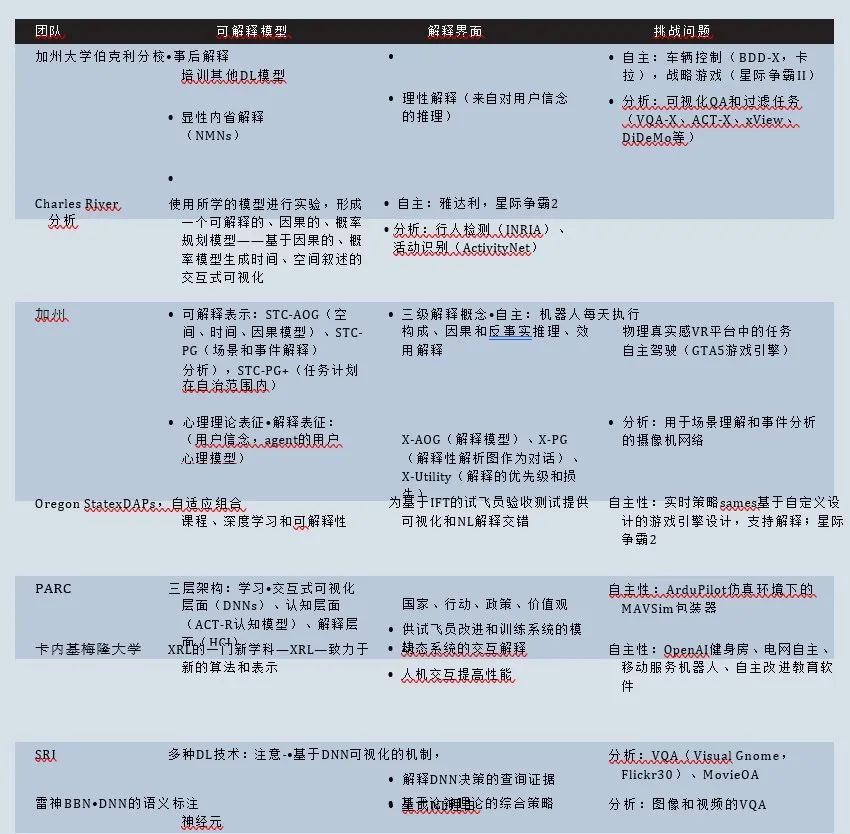

加州大學伯克利分校(UCB)團隊(包括波士頓大學、阿姆斯特丹大學和Kitware的研究人員)正在開發一個人工智能系統,該系統通過明確的結構解釋提供事后和內省解釋,具有預測性行為,允許適當的信任深度可解釋人工智能(dexainable AI,DEXAI)的關鍵挑戰是生成模型行為的精確解釋,并選擇對用戶最有用的解釋。UCB通過創建隱式或顯式解釋模型來解決前者:它們可以以可理解的方式隱式呈現復雜的潛在表征,或者構建內在可理解的顯式結構。這些DEXAI模型創建了一系列可能的解釋操作。因為這些操作是在沒有任何用戶模型的情況下生成的,所以它們被稱為自反。對于第二個挑戰,UCB提出了合理的解釋,在決定選擇哪些解釋行為時使用用戶信念的模型。UCB也正在開發一個基于這些創新的解釋界面,這些創新是由迭代設計原則提供的。(Hu等人,2017)和,(Park等人,2018年)(Ramanishka等人,2017年)(歡get公司。2018年)。

UCB正在解決這兩個挑戰問題領域。對于autonomy,DEXAI將在車輛控制(使用Berkeley Deep Drive數據集和CARLA模擬器)和策略游戲場景(星際爭霸II)中演示。對于數據-Kim和Canny2017年)分析、DEXAI將使用視覺問答(VQA)和過濾任務(例如,分別使用VQA任務和活動識別任務的大規模數據集,如VQA-X和ACT-X)、xView和獨特的可描述時刻進行演示(亨德里克斯et公司。2018年)。

圖4XAI挑戰問題領域

解釋學習的因果模型Charles River Analytics(CRA)團隊(包括馬薩諸塞大學和布朗大學的研究人員)的目標是通過因果模型解釋學習(CAMEL)方法,生成和呈現ML操作的因果解釋。駱駝解釋以交互、直觀的界面作為敘述呈現給用戶。CAMEL包括一個因果概率編程框架,該框架結合了因果建模的表示和學習方法(使用概率編程語言來描述復雜和豐富的現象。CAMEL可用于描述ML系統的功能、特定數據特征如何影響其結果,--2015年)(Pfeffer2016年)以及改變這些因素將如何影響這一結果。生成概率模型,用概率編程語言表示,自然地表達因果關系;它們非常適合于解釋ML系統的任務。CAMEL探測ML系統的內部表示,以發現它如何表示用戶定義的自然域概念。然后,通過系統地包含或刪除領域概念的實驗,建立它們對ML系統操作影響的因果模型。CRA已將此方法應用于DNN的分類和RL。一旦學會,它使用因果概率模型來推斷系統的預測或行動的解釋。因為推論可能是龐大而復雜的,并且可以包含許多交互組件,CAMEL將它們組合成解釋性的敘述,引導用戶了解主要概念的交互以及它們對ML系統輸出的影響。駱駝解釋界面,基于認知系統工程設計原理而建立HCI技術,允許用戶理解解釋性敘述并與之交互,產生對自動化的信任并實現有效的用戶系統協作。CRA正在解決這兩個挑戰問題領域。對于數據分析,CAMEL已通過行人檢測(使用INRIA行人數據集)進行了演示(CRA正在進行活動識別任務(使用ActivityNet)。對于自主性,駱駝已經在Atari游戲Amidar上進行了演示,CRA正在星際爭霸2上進行演示。Harradon等人,2018年)

圖5 評估解釋有效性

學習和交流可解釋的表征用于分析和自主加州大學洛杉磯分校(UCLA)團隊(包括俄勒岡州立大學和密歇根州立大學的研究人員)正在開發可解釋模型,該模型結合了代表性范例,包括可解釋的DNN、組合圖形模型(如and或Graph)。UCLA的系統包括一個對多模態輸入數據執行任務的執行者和一個向用戶解釋其感知、認知推理和決策的解釋者。執行者輸出空間、時間和因果解析圖(STC-PG)中的可解釋表示,用于三維場景感知(用于分析)和任務規劃(用于自主)。STC PG是合成的、概率的、屬性化的、可解釋的,并且基于圖像和視頻中的DNN特征。解釋者在對話過程中輸出解釋性解析圖,在STC-PG中定位相關子圖,并推斷用戶的意圖。(She和Chai 2017),系統分三個層次進行說明:(1) 概念組合,由描述如何從其組成部分和上下文聚合信息的解析圖片段表示,在不確定的情況下,如何在節點上做出決策,以及決策的置信水平;(2) 因果和反事實推理,通過從STC PGs中提取因果圖來實現,以預測如果采取了某些替代措施,將會發生什么;(3)效用解釋,解釋了系統為什么做出某些決策。UCLA正在使用一個通用的表示和推理框架來解決XAI挑戰問題領域。對于數據分析,加州大學洛杉磯分校演示了他們的系統使用的場景理解和事件分析攝像機網絡。對于自主性,加州大學洛杉磯分校在使用機器人在物理現實虛擬現實平臺和自主車輛駕駛游戲中執行任務的場景中演示了它發動機。

圖6 XAI計劃時間表

深度自適應程序的解釋性驗收測試俄勒岡州州立大學(OSU)正在開發用于解釋執行順序決策的學習代理的工具,并正在確定設計解釋用戶界面的最佳原則。OSU的可解釋agent模型采用可解釋深度自適應程序(XDAP),它將自適應程序、深度RL和可解釋性相結合。。對于每個選擇點,deep-RL附加一個經過訓練的deep-decision神經網絡(dNN),它可以產生高性能,但本質上是無法解釋的。

在初始xDAP訓練之后,xACT訓練每個dNN的解釋神經網絡(7)。它們提供了一組稀疏的解釋特征(x特征),用于編碼dNN決策邏輯的屬性。這種x特征是神經網絡,最初不可由人類解釋。為了解決這個問題,xACT使領域專家能夠將可解釋的描述附加到x-features,xDAP程序員能夠對環境獎勵類型和其他概念進行注釋,這些概念在學習過程中作為“注釋概念”自動嵌入到DNN中。DNN決策可以通過對相關x特征和標注概念的描述來解釋,通過神經網絡顯著性可視化工具可以進一步理解。OSU正在研究顯著性計算對解釋順序決策的效用。OSU的解釋用戶界面允許用戶瀏覽數以千計的學習代理決策,并獲得可視化和自然語言(NL)解釋。它的設計是基于信息覓食理論(IFT),它允許用戶在任何時候有效地深入到最有用的解釋性信息。評估學習決策的理由可以更有效地識別代理決策中的缺陷并提高用戶信任。OSU正在解決自治挑戰問題領域,并使用定制的實時策略游戲引擎在場景中演示了xACT。試點研究通過描述用戶如何導航AI代理游戲并傾向于解釋游戲決策,為解釋用戶界面設計提供了信息(閃避et公司。2018年)。

共同點學習和解釋帕洛阿爾托研究中心(PARC)團隊(包括卡內基梅隆大學、陸軍網絡研究所、愛丁堡大學和密歇根大學的研究人員)正在開發一種交互式感知系統,可以解釋控制模擬無人機系統的XAI系統的學習能力。

圖7 XAI研究團隊

XAI系統的解釋應該傳達它用來做決定的信息,它是否理解事物是如何工作的,以及它的目標。為了解決這個問題,帕洛阿爾托研究中心的公共基礎學習和解釋(COGLE)及其用戶就解釋中使用的術語及其含義建立了共同基礎。這是由帕洛阿爾托研究中心的內省話語模型實現的,該模型將學習和解釋過程交織在一起。在自然環境中執行任務對于自治系統來說是一個挑戰,需要經驗來創造足夠的知識來實現可靠的高性能。COGLE采用K模型對AI代理的特定領域任務知識進行編碼。K-models將這些知識組織為元素級別,其中較高(較低)級別對具有較長范圍(局部)效果的操作進行建模。它們支持基于能力的框架,為XAI系統的學習和測試提供信息和指導。COGLE的多層結構將其信息處理劃分為感知、認知建模和學習。學習層使用容量受限的遞歸和分層DNN生成無人機系統狀態和動作的抽象和合成,以支持對廣義模式的理解。它結合所學的抽象來創建與系統所學的策略相匹配的分層、透明的策略。認知層將人類可用的符號表示連接到抽象、合成和廣義模式。COGLE的解釋界面支持績效審查、風險評估和培訓。第一種方法提供了一張地圖,可以追蹤無人機系統的任務動作,并將動作或決策(飛行)路徑劃分為可解釋的部分。第二個界面的工具使用戶能夠檢查和評估系統的能力,并對任務性能進行預測。COGLE將在ArduPilot的軟件在環模擬器和離散化抽象仿真試驗臺上演示。它將由無人機操作員和分析員進行評估。基于能力的評估將幫助PARC確定如何最好地開發適當的領域可理解模型。可解釋強化學習卡內基梅隆大學正在創建一門新的可解釋強化學習學科,使動態的人-機器交互和適應,以實現最大的團隊績效。這項工作有兩個目標:開發學習內在可解釋RL策略的新方法,以及開發能夠解釋現有黑箱策略的策略。對于前者,Carnegie Mellon正在開發改進RL代理模型學習的方法,以獲取好處基于模型的方法(在內部模型空間中可視化計劃的能力),同時集成無模型方法的優點(簡單性和更高的最終性能)。這些方法包括在發現相關潛在信息后向世界模型增量添加狀態和動作的方法,通過基于復雜模型的最優控制策略的端到端訓練學習模型,學習直接集成和利用剛體物理的一般DL模型(B)以及使用遞歸架構學習可理解的預測狀態表示和科爾特2017年),(赫夫尼et公司。2018年)。卡內基梅隆大學也在開發方法,可以解釋黑匣子RL代理的行動和計劃,觀察在線或從系統日志。這涉及到回答一些問題,例如,為什么代理選擇特定的操作?或者,哪些培訓數據最有助于做出這種選擇?為了實現這一點,卡內基梅隆開發了從行為日志生成代理NL描述并檢測異常值或異常的技術。卡內基梅隆大學還對DL中的傳統影響函數方法進行了改進,使其XRL系統能夠精確地識別訓練集中對政策結果影響最大的部分。Carnegie Mellon正在解決自治挑戰問題領域,并已在多個場景中演示了XRL,包括OpenAI健身房、Atari游戲、自動車輛模擬、移動服務機器人以及自我改進的教育軟件和游戲。

圖8

基于深度注意的解釋表征/可解釋生成對抗網絡SRI國際的團隊(包括來自多倫多大學、圭爾夫大學和加利福尼亞大學圣地亞哥分校的研究人員)正在開發一個可解釋的多模態數據分析ML框架,該框架可生成顯示和講述解釋,其中包含決策的理據,以及用于生成推斷的輸入數據的可視化。DARE/X-GANS(deep attention based Representation for ExplanationExplainable generative Antigarial networks)系統采用視覺神經科學注意模型啟發的DNN結構。作為解釋的一部分,它識別、檢索并向用戶提供證據。注意機制為用戶提供了系統探測和協作的手段。

表1 測量類別

DARE/X-GANS使用生成性對抗網絡(GANS),通過創建數據來學習理解數據,同時學習具有解釋力的表示。通過使用可解釋的解碼器將無監督的簇映射到基于零件的表示上,可以解釋GAN。這涉及到生成視覺證據,給定文本查詢,使用文本到零件生成(018),零件是可解釋的特征,如人體姿勢或邊界框。然后使用此證據搜索查詢的可視數據。該系統基于從多模態數據輸入和知識庫查詢中提取的視覺概念來解釋其答案。給定解釋性問題,它提供了理由、決策所用的可視化證據以及系統內部工作的可視化。這個顯示和告訴解釋界面確保了高度直觀的解釋,注意模塊可以定位用于每個視覺任務的證據。初步研究表明,這樣的解釋大大提高了用戶任務的性能。SRI正在解決數據分析挑戰問題領域,并演示了DARE/X-GANs使用圖像和視頻數據集的VQA和多模態QA任務。可解釋的問答系統雷神BBN技術團隊(包括喬治亞理工學院的研究人員,麻省理工學院(MIT)和德克薩斯大學奧斯汀分校(University of Texas,Austin)正在開發一個系統,該系統可以回答用戶提出的有關多媒體數據的不受限制的NL問題,并提供交互式、可探索性的解釋,解釋為什么它會得出答案。可解釋問答系統(EQUAS)學習可解釋的DNN模型,其中內部結構(例如,單個神經元)已與語義概念(例如,輪子和把手)對齊,這允許在決策過程中網絡內的神經激活,轉換為NL解釋(例如,“此對象是自行車,因為它有兩個輪子和把手”)。EQUAS還使用神經可視化技術來突出顯示與最影響其決策的神經元相關的輸入區域。為了表達基于案例的解釋,EQUAS保留索引并從支持其選擇的訓練數據中檢索案例。使用對比語言、可視化和示例識別并排除被拒絕的備選方案。四種解釋模式映射到論點構建和互動教學法的關鍵要素:說教陳述、可視化、案例和拒絕替代選擇。(周et公司。2015年)。EQUAS解釋界面允許用戶瀏覽由這些解釋模式填充的解釋空間。它支持迭代和引導的協作交互,允許用戶深入到每個解釋類別的支持證據。雷神BBN正在解決分析挑戰問題領域,并展示了圖像VQA任務的初始EQUAS功能,探索不同的解釋模式如何使用戶能夠理解和預測底層VQA系統的行為。

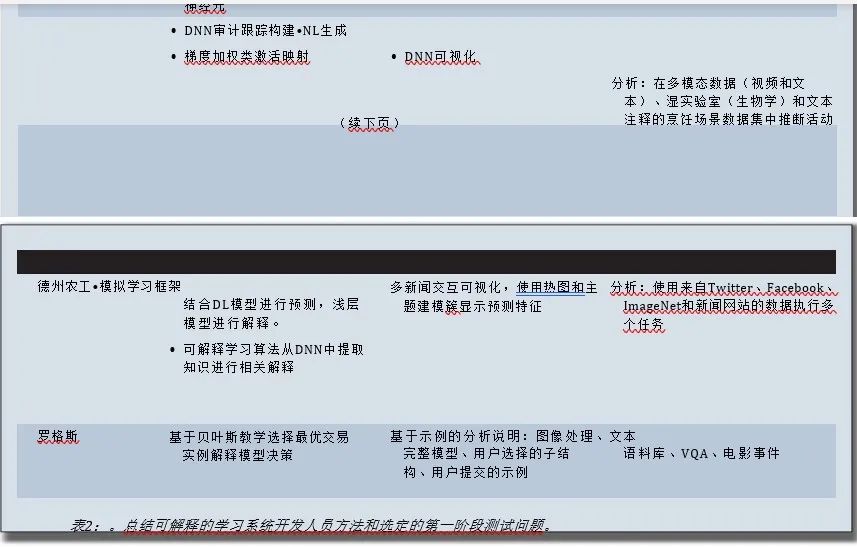

可處理的概率邏輯模型:德克薩斯大學達拉斯分校(UTD)團隊(包括加州大學洛杉磯分校(UCLA)、德克薩斯農工大學(Texas A&M)和印度理工學院(德里)正在開發一種使用可處理概率邏輯模型(TPLMs)的XAI統一方法。TPLMs是一系列表示,包括(例如)決策樹、二元決策圖、割集網絡、句子決策圖、一階算術電路和可處理馬爾可夫邏輯()。UTD系統對TPLMs進行擴展,生成查詢結果的解釋;處理連續變量、復雜約束和不可見實體;緊湊地表示復雜對象,如解析樹、列表和形狀;并能夠高效地表示和推理時間。對于可伸縮推理,系統使用提升推理、變異推理及其組合等技術,使用新算法來回答復雜的解釋查詢。為了快速和提高學習精度,它使用判別技術,導出由NNs和支持向量機與TPLMs組成的算法,使用可解釋性作為偏差來學習更多可解釋模型。然后將這些方法擴展到處理實際情況。--UTD解釋界面顯示具有多個相關解釋的可解釋表示。它的交互式組件允許用戶調試模型并提出替代解釋。UTD正在解決分析挑戰問題領域,并展示了其在多模態數據(視頻和文本)中識別人類活動的系統,例如文本注釋的烹飪場景數據集。

轉變深度學習利用淺層知識的可解釋性模型:交互式端到端系統德州農工大學(TAMU)團隊(包括來自華盛頓州立大學的研究人員)正在開發一個可解釋DL框架,該框架使用模擬學習來利用可解釋的淺層模型,并通過可視化和交互促進領域解釋。模擬學習彌補了深度模型和淺層模型之間的差距,實現了可解釋性。該系統還從原始數據中挖掘信息模式,以提高可解釋性和學習性能。系統的可解釋學習算法從DNNs中提取知識進行相關解釋。它的DL模塊通過利用淺層模型的可解釋性連接到模式生成模塊。學習系統的輸出以可視化方式顯示給用戶,包括協調和集成視圖。TAMU系統處理圖像(和文本)(Gdata)并應用于XAI analytics challenge problem(XAI分析挑戰問題)領域。它提供了對來自不同來源的檢測不準確的有效解釋,同時保持有競爭力的檢測性能。TAMU系統結合了模型級(即模型透明度)和實例級(即實例解釋)的可解釋性,以生成用戶更容易理解的說明。該系統已部署在多個任務上,使用來自Twitter、Facebook、ImageNet、CIFAR-10、在線醫療論壇和新聞網站的數據。杜邦et公司。2018年)aoet公司。2017年)

模型解釋人羅格斯大學正在擴展貝葉斯教學,通過選擇數據實現自動解釋最能代表模型推理的子集。羅格斯的方法允許解釋任何概率生成和判別模型的推論,以及有影響力的DL模型(7)。羅格斯大學還開發了一種人機合作的形式化理論,并支持復雜成分模型的交互式指導解釋。其中一個共同點是從人類學習模型構建可解釋性的核心方法,以及精心控制的行為實驗來量化可解釋性的核心方法。通過貝葉斯教學輸入數據集、概率模型和推理方法,并返回最能解釋模型推理的示例子集。對不熟悉圖像的實驗表明,對(和特定)圖像類別的推理解釋提高了人們對模型推理的準確性。對熟悉圖像類別的實驗表明,解釋允許用戶準確校準模型預測的可信度。(Vong等人。2018年)。通過交互式引導解釋,可以方便地解釋復雜模型。通過利用ML模型的組合性和協作修改,Rutgers提供了一種通過引導探索來促進理解的通用方法。交互通過一個接口發生,該接口公開模型結構并用數據的各個方面解釋每個組件。羅格斯方法已被證明有助于理解大型文本語料庫,這取決于一個人在簡短的引導性解釋之后準確總結語料庫的能力。

結論和今后的工作

DARPA的XAI項目正在開發和評估各種新的ML技術:學習可解釋特性的改進DL技術;學習更多結構化、可解釋的因果模型的方法;以及從任何黑箱模型中推斷出可解釋模型的模型歸納技術。XAI項目實施一年后,最初的技術演示和結果表明,這三種廣泛的策略值得進一步研究,并將為未來的開發人員提供涵蓋性能和可解釋性交易空間的設計選項。開發團隊的XAI系統正在被評估,以評估他們所提供的解釋的價值,在這個交易空間中定位特定技術的貢獻。

審核編輯 :李倩

-

人工智能

+關注

關注

1796文章

47791瀏覽量

240573 -

機器學習

+關注

關注

66文章

8446瀏覽量

133124 -

DARPA

+關注

關注

4文章

72瀏覽量

27902

原文標題:DARPA的可解釋人工智能程序

文章出處:【微信號:AI智勝未來,微信公眾號:AI智勝未來】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

小白學解釋性AI:從機器學習到大模型

DARPA的可解釋人工智能程序

DARPA的可解釋人工智能程序

評論