2.2 Virtqueue交互隊(duì)列

Virtio 1.1引入了Packed Virtqueue的概念,對(duì)應(yīng)的Virtio 1.0的Virtqueue被稱為Split Virtqueue。

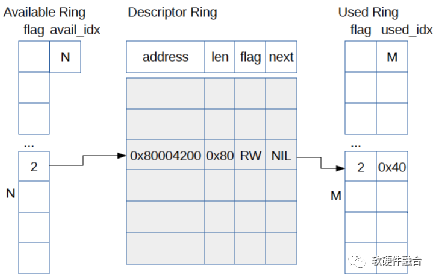

如圖3所示,為Virtio1.0的Split Virtqueue結(jié)構(gòu)。Virtqueue由三部分組成:

- 描述符表

- 可用的描述符環(huán)

- 已使用的描述符環(huán)

- Virtio 1.0的Split Virtqueue具有一些缺點(diǎn):

- 如果是虛擬化場(chǎng)景軟件模擬Virtio設(shè)備的話,因?yàn)榉稚⒌臄?shù)據(jù)結(jié)構(gòu),導(dǎo)致Cache利用率較低,每次請(qǐng)求都會(huì)有很多Cache不命中;

- 如果是硬件實(shí)現(xiàn)的話,每次描述符需要多次設(shè)備DMA訪問(wèn)。

圖3 Virtio 1.0中的Split Virtqueue

如圖4所示,Virtio 1.1引入了Packed Virtqueue的概念。整個(gè)描述符只有一個(gè)數(shù)據(jù)結(jié)構(gòu)。這樣,如果軟件實(shí)現(xiàn)Virtio設(shè)備模擬的話,可以提升描述符交互的Cache命中率。如果硬件實(shí)現(xiàn)的,可以降低設(shè)備DMA的訪問(wèn)次數(shù)。

圖4 Virtio1.1的Packed Virtqueue

2.3 Virtio交互

驅(qū)動(dòng)和設(shè)備的交互,符合生產(chǎn)者消費(fèi)者模型的數(shù)據(jù)及通知(Notification)的交互行為。驅(qū)動(dòng)把共享隊(duì)列的隊(duì)列項(xiàng)準(zhǔn)備好,通過(guò)寫寄存器的方式通知設(shè)備。設(shè)備收到驅(qū)動(dòng)發(fā)送的通知?jiǎng)t處理隊(duì)列項(xiàng)以及相應(yīng)的數(shù)據(jù)搬運(yùn)工作,結(jié)束后更新隊(duì)列狀態(tài)并通知(設(shè)備通知驅(qū)動(dòng)是通過(guò)中斷)驅(qū)動(dòng)。驅(qū)動(dòng)接收到中斷通知時(shí)候,把已經(jīng)使用的隊(duì)列項(xiàng)釋放,并更新隊(duì)列狀態(tài)。

一個(gè)典型的通用的驅(qū)動(dòng)和設(shè)備的交互流程如圖5所示。Virtio場(chǎng)景的驅(qū)動(dòng)和設(shè)備交互,驅(qū)動(dòng)給設(shè)備的通知(Notification)稱為Kick,設(shè)備給驅(qū)動(dòng)的通知稱為Interrupt(中斷)。Kick和Interrupt操作是Virtio接口的一部分,在虛擬化場(chǎng)景,Kick和Interrupt需要非常大的CPU切換代價(jià)。驅(qū)動(dòng)希望在Kick之前產(chǎn)生盡可能多的待處理緩沖項(xiàng)(一個(gè)緩沖項(xiàng)對(duì)應(yīng)一個(gè)描述符和描述符指向的數(shù)據(jù)塊);同樣的,設(shè)備希望處理盡可能多的緩沖項(xiàng)然后再發(fā)送一個(gè)中斷。通過(guò)盡量處理更多的緩沖項(xiàng)的方式,來(lái)攤薄通知的代價(jià)。

這種策略是一種理想狀態(tài),因?yàn)榇蠖鄶?shù)時(shí)候驅(qū)動(dòng)并不知道下一組緩沖項(xiàng)何時(shí)帶來(lái),因此不得不每一組緩沖項(xiàng)準(zhǔn)備好之后就必須要Kick設(shè)備。同樣的,設(shè)備在處理完相應(yīng)的緩沖項(xiàng)之后,就盡快的發(fā)送中斷給驅(qū)動(dòng),以達(dá)到盡可能小的延遲。

圖5 Virtio驅(qū)動(dòng)和設(shè)備交互示意圖

如圖6所示,在設(shè)備模擬的虛擬化場(chǎng)景下,驅(qū)動(dòng)可以暫時(shí)禁用中斷,設(shè)備也可以暫時(shí)禁用Kick。通過(guò)這樣的機(jī)制,可以最大限度的減少通知的代價(jià),并且不影響性能和延遲。Virtio 1.1支持兩種通知抑制機(jī)制,因此共有三種模式:

- 使能通知模式:完全無(wú)抑制,使能通知;

- 禁用通知模式:如圖6所示,可以完全禁止對(duì)方發(fā)通知給自己;

- 使能特定的描述符通知模式:告知對(duì)方一個(gè)特定的描述符,當(dāng)對(duì)方順序處理到此描述符處理完成時(shí)產(chǎn)生通知。

圖6 通過(guò)前后端禁用抑制通知的Virtio驅(qū)動(dòng)和設(shè)備交互

2.4 總結(jié)

如圖7,Virtio基于分層的設(shè)計(jì)思想,定義了三層Virtio設(shè)備架構(gòu):

- 最下層的總線接口。PCI是最常用的Virtio場(chǎng)景使用的總線,但Virtio協(xié)議不僅僅支持PCI,也支持MMIO和Channel IO等。

- 通用的Virtio交互接口。包括Virtqueue、功能特征位、配置空間等。Virtio交互接口是Virtio最核心的功能,通過(guò)Virtio交互接口實(shí)現(xiàn)了不同類型設(shè)備的標(biāo)準(zhǔn)化。

- 上層的特定設(shè)備接口。在Virtio協(xié)議里,定義網(wǎng)絡(luò)、塊、控制臺(tái)、SCSI、GPU等各種不同類型的設(shè)備。

圖7 分層的Virtio框架圖

Virtio的優(yōu)點(diǎn)體現(xiàn)在:

- Virtio實(shí)現(xiàn)了盡可能多的設(shè)計(jì)共享。這樣,在開發(fā)的時(shí)候就可以復(fù)用很多軟件和硬件資源,達(dá)到快速開發(fā)的目的。

- Virtio實(shí)現(xiàn)了接口的標(biāo)準(zhǔn)化。標(biāo)準(zhǔn)化體現(xiàn)在兩個(gè)方面:

- (1)一個(gè)是通用的Virtio交互接口,統(tǒng)一了不同的設(shè)備類型軟硬件交互;

- (2)另一個(gè)是基于Virtio的Virtio-net、Virtio-block等廣泛應(yīng)用于云計(jì)算虛擬化場(chǎng)景,Virtio已經(jīng)成為事實(shí)上的標(biāo)準(zhǔn)I/O接口。

而Virtio的缺點(diǎn),則同樣因?yàn)閂irtio實(shí)現(xiàn)了接口的標(biāo)準(zhǔn)化,而忽略了不同設(shè)備類型數(shù)據(jù)傳輸?shù)奶攸c(diǎn)。因此,在一些大數(shù)據(jù)量傳輸?shù)膱?chǎng)景,效率比較低下。如果是在類似HPC這樣的性能和延遲非常敏感的場(chǎng)景,Virtio就不是一個(gè)很好的選擇。

**03 **虛擬化卸載

虛擬化卸載指的是計(jì)算機(jī)虛擬化中消耗CPU資源較多的接口設(shè)備模擬、熱遷移、虛擬化管理等任務(wù)的卸載。

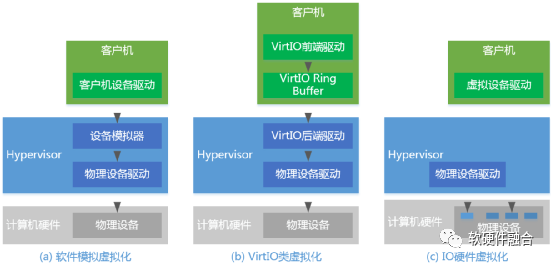

a. 接口設(shè)備的卸載

前面我們介紹了網(wǎng)絡(luò)、遠(yuǎn)程存儲(chǔ)等IO工作任務(wù)的卸載,而虛擬化卸載主要指的是跟IO相關(guān)的接口設(shè)備的卸載,例如網(wǎng)絡(luò)、存儲(chǔ)等接口設(shè)備的卸載。IO接口設(shè)備的卸載本身上也是IO硬件虛擬化的過(guò)程,比如我們通過(guò)VT-d技術(shù)實(shí)現(xiàn)從VM中pass though訪問(wèn)硬件設(shè)備,某種程度上也可以認(rèn)為是把運(yùn)行在Hypervisor中的模擬設(shè)備 “卸載”到了硬件。因此,IO接口設(shè)備的卸載本質(zhì)上和IO設(shè)備硬件虛擬化是一件事情。

如圖8,為了實(shí)現(xiàn)設(shè)備接口的標(biāo)準(zhǔn)化、加速IO處理的性能以及潛在的充分利用現(xiàn)有的虛擬化生態(tài)(例如更好的支持設(shè)備熱遷移)等原因,阿里云在神龍芯片里實(shí)現(xiàn)了硬件的Virtio接口設(shè)備,通過(guò)Virtio接口設(shè)備支持Virtio-net網(wǎng)絡(luò)驅(qū)動(dòng)和Virtio-blk存儲(chǔ)驅(qū)動(dòng)等,實(shí)現(xiàn)了類虛擬化IO設(shè)備Virtio的硬件“卸載”。

圖8 阿里云神龍芯片網(wǎng)絡(luò)和存儲(chǔ)接口示意圖

AWS的NITRO系統(tǒng)支持網(wǎng)絡(luò)、本地存儲(chǔ)和遠(yuǎn)程存儲(chǔ),NITRO實(shí)現(xiàn)了網(wǎng)絡(luò)接口設(shè)備ENA/EFA(AWS自定義接口)的硬件“卸載”以及存儲(chǔ)接口設(shè)備NVMe(遠(yuǎn)程存儲(chǔ)EBS使用的是NVMe接口,本地存儲(chǔ)也是NVMe接口)的卸載。

b. 接口設(shè)備卸載后的遷移問(wèn)題

當(dāng)把設(shè)備“卸載”到硬件,讓VM直接訪問(wèn)硬件設(shè)備,這使得VM的設(shè)備熱遷移變的非常有挑戰(zhàn)。vDPA(vhost Data Path Acceleration,vhost數(shù)據(jù)路徑加速,其中vhost是Virtio后端設(shè)備模擬的輪詢方式實(shí)現(xiàn))實(shí)現(xiàn)了一種折中的解決方案,如圖9所示,vDPA把Virtio分為了控制面和數(shù)據(jù)面:

- 控制面。vDPA控制面依然是通過(guò)要經(jīng)過(guò)Hypervisor的處理,用于設(shè)備和VM之間的配置更改和功能協(xié)商,用于建立和終止數(shù)據(jù)面。

- 數(shù)據(jù)面。vDPA數(shù)據(jù)面包括共享隊(duì)列以及相應(yīng)的通知機(jī)制,用于在設(shè)備和VM之間傳輸實(shí)際的數(shù)據(jù)。

圖9 vDPA框架示意圖

使用vDPA一個(gè)重要原因是,在熱遷移的時(shí)候可以很方便的把Virtio數(shù)據(jù)面的處理切換回傳統(tǒng)的Virtio/Vhost后端設(shè)備模擬。這樣,可以充分利用現(xiàn)有的基于KVM/Qemu對(duì)Virtio設(shè)備遷移的解決方案來(lái)完成設(shè)備的遷移。

c. 虛擬化管理的卸載

從軟件虛擬化進(jìn)化到硬件虛擬化的過(guò)程,本身就可以看作是一個(gè)硬件加速以及硬件卸載的過(guò)程。我們逐步的剝離了Hypervisor的功能,比如通過(guò)VT-x技術(shù)“卸載”了Hypervisor的CPU/內(nèi)存等的軟件模擬,以及通過(guò)VT-d以及vDPA等技術(shù)“卸載”了設(shè)備軟件模擬。這些剝離,使得Hypervisor越來(lái)越輕量,整個(gè)系統(tǒng)的虛擬化開銷也越來(lái)越少。進(jìn)一步的,我們可以把虛擬化的管理(例如Linux平臺(tái)主流的管理程序Libvirt)卸載到硬件中的嵌入式軟件運(yùn)行。

如圖10, 我們通過(guò)橋接的方式,實(shí)現(xiàn)主機(jī)軟件和硬件中嵌入式軟件通信機(jī)制。把虛擬化管理等軟件任務(wù)從主機(jī)卸載到嵌入式系統(tǒng)(依然有很小一部分任務(wù)無(wú)法卸載,如虛擬機(jī)資源分配、vCPU調(diào)度等)。這樣,可以把幾乎100%的主機(jī)資源提供給用戶,使用戶虛擬機(jī)得到近乎物理機(jī)的性能。

圖10 虛擬化管理卸載圖

通過(guò)虛擬化管理卸載到硬件中的嵌入式CPU軟件,我們可以做到物理上的業(yè)務(wù)和管理分離,整個(gè)業(yè)務(wù)主機(jī)跟云計(jì)算管理網(wǎng)絡(luò)安全的隔離,只能通過(guò)特定的接口訪問(wèn)到Lite Hypervisor,除此之外,不能訪問(wèn)主機(jī)的任何資源。這樣,即使有潛在的運(yùn)維操作失誤,也無(wú)法對(duì)業(yè)務(wù)主機(jī)造成影響。

-

接口

+關(guān)注

關(guān)注

33文章

8967瀏覽量

153337 -

DPU

+關(guān)注

關(guān)注

0文章

391瀏覽量

24763 -

i/o

+關(guān)注

關(guān)注

0文章

33瀏覽量

4686

發(fā)布評(píng)論請(qǐng)先 登錄

virtio I/O通信流程及設(shè)備框架的實(shí)現(xiàn)

《微機(jī)原理與接口技術(shù)》教學(xué)大綱

淺析單片機(jī)原理及接口技術(shù)

微機(jī)接口技術(shù)實(shí)用教程

微機(jī)原理及接口技術(shù)課件(教學(xué))

微機(jī)原理與接口技術(shù)精品課程(課件)

單片機(jī)與接口技術(shù)實(shí)驗(yàn)教程

輸入輸出設(shè)備I/O設(shè)備總結(jié)

系統(tǒng)虛擬化技術(shù)virtio總體設(shè)計(jì)思想

I/O虛擬化及Virtio接口介紹

VirtIO Networking虛擬網(wǎng)絡(luò)設(shè)備實(shí)現(xiàn)架構(gòu)

探究I/O虛擬化及Virtio接口技術(shù)(下)

探究I/O虛擬化及Virtio接口技術(shù)(下)

評(píng)論