深度學習(DL)的創新,特別是大語言模型(LLM)的快速發展,已經席卷了整個行業。深度學習模型的參數已從數百萬增加到數十億,為我們呈現了越來越多激動人心的新能力。它們正在催生新的應用,如生成式AI或醫療保健和生命科學的高級研究。亞馬遜云科技一直在芯片、服務器、數據中心互連和軟件服務等多個方面創新,加速深度學習工作負載的大規模應用。

亞馬遜云科技在2022 re:Invent 全球大會上,以其最新的自研機器學習推理芯片Amazon Inferentia2為基礎,發布了AmazonEC2 Inf2系列實例的預覽版。AmazonEC2 Inf2類型實例專門針對全球大規模運行高性能深度學習推理應用程序,為部署在EC2上的生成式AI應用提供最佳性價比,其中包含GPT-J或開放式預訓練Transformer(OPT)語言模型。

現在,亞馬遜云科技宣布Amazon EC2 Inf2實例正式可用。

Inf2實例是AmazonEC2上首個推理優化的實例,支持可擴展的分布式推理,可實現多個inferentia2芯片之間的超高速連接。用戶可以在Inf2實例中跨多個芯片高效部署具有數千億個參數的模型。與Amazon EC2 Inf1實例相比,Inf2實例的吞吐量提高4倍,延遲降低10倍。

新Inf2實例的亮點

Inf2實例目前有四種可用實例類型,最高擴展至12個Amazon Inferentia2芯片和192個vCPU配置。在BF16或FP16數據類型下,它們能夠提供2.3 petaFLOPS的綜合計算能力,并具有芯片間超高速NeuronLink互連的功能。NeuronLink可在多個Inferentia2芯片上擴展大模型,避免通信瓶頸,實現更高性能的推理。

每個Inferentia2芯片內有32 GB的高帶寬內存(HBM),最高配置的Inf2 實例可提供高達384 GB的共享加速器內存,總內存帶寬為9.8 TB/s。對于需要大內存支持的的大型語言模型而言,這種帶寬對于支持模型推理尤為重要。

基于專門為深度學習工作負載而構建的Amazon Inferentia2芯片的Amazon EC2 Inf2,相比同類實例,單位功率性能高出了50%。

AmazonInferentia2的創新之處

與亞馬遜自研機器學習訓練芯片Amazon Trainium類似,每個Amazon Inferentia2芯片都配有兩個經過優化的NeuronCore-v2引擎、高帶寬內存(HBM)堆棧和專用的集體計算引擎,以便在執行多加速器推理時實現計算與通信的并行。

每個NeuronCore-v2都有專為深度學習算法構建的標量、向量和張量三種引擎,其中張量引擎針對矩陣運算進行了優化;標量引擎針對ReLU(修正線性單元)函數等元素性操作進行了優化;向量引擎針對批處理規范化或池化等非元素向量運算進行了優化。

以下是Amazon Inferentia2芯片和服務器硬件其他創新總結:

數據類型——Amazon Inferentia2 支持多種數據類型,包括FP32、TF32、BF16、FP16 和UINT8,用戶可以為工作負載選擇最合適的數據類型。它還支持新的可配置FP8(cFP8)數據類型,該數據類型特別適用于大模型,因為它減少了模型的內存占用和I/O 要求。

動態執行和動態輸入形狀——Amazon Inferentia2 具有支持動態執行的嵌入式通用數字信號處理器(DSP),因此無需在主機上展開或執行控制流運算符。Amazon Inferentia2 還支持動態輸入形狀,這些形狀對于具有未知輸入張量大小的模型(例如處理文本的模型)至關重要。

自定義運算符——Amazon Inferentia2支持用C++語言編寫的自定義運算符。Neuron自定義C++運算符使用戶能夠編寫在NeuronCore上天然運行的C++自定義運算符。用戶可以使用標準的PyTorch自定義運算符編程接口將CPU 自定義運算符遷移到Neuron 并實現新的實驗運算符,所有這些都無需對NeuronCore 硬件有任何深入了解。

NeuronLink v2——Inf2實例是AmazonEC2類型中首個將NeuronLink V2 用于推理優化的實例,NeuronLink v2 為Inferentia2芯片間的提供超高速連接,加強分布式推理性能。NeuronLink v2使用all-reduce等聚合通信(CC)運算符,將高性能推理管道擴展到所有的推理芯片上。

新Inf2實例現已可用

用戶可在亞馬遜云科技美東(俄亥俄州)和美東(北弗吉尼亞州)地區啟動Inf2實例,以按需、預留和競價實例或Savings Plan方式調用。用戶僅需為其實際使用的服務付費。如需了解更多相關信息,請訪問Amazon EC2定價網站。

Inf2實例可使用亞馬遜云科技深度學習鏡像進行部署,并可通過Amazon SageMaker、Amazon Elastic Kubernetes Service(Amazon EKS)、Amazon Elastic Container Service(Amazon ECS)和Amazon ParallelCluster等托管服務調用。

如需了解更多信息,請訪問Amazon EC2 Inf2實例頁面,并將相關反饋發送給Amazon re:Post for EC2;或垂詢您的AmazonSupport聯系人。

審核編輯:湯梓紅

-

半導體

+關注

關注

335文章

28754瀏覽量

234957 -

AI

+關注

關注

88文章

34733瀏覽量

276816 -

亞馬遜

+關注

關注

8文章

2692瀏覽量

84527 -

深度學習

+關注

關注

73文章

5557瀏覽量

122626 -

生成式AI

+關注

關注

0文章

530瀏覽量

729

發布評論請先 登錄

Banana Pi 發布 BPI-AI2N & BPI-AI2N Carrier,助力 AI 計算與嵌入式開發

聚云科技榮獲亞馬遜云科技生成式AI能力認證

聚云科技榮獲亞馬遜云科技生成式AI能力認證 助力企業加速生成式AI應用落地

Qwen大模型助力開發低成本AI推理方案

生成式AI推理技術、市場與未來

NeuroBlade攜手亞馬遜EC2 F2實例,加速數據分析

亞馬遜云科技發布Amazon Trainium2實例

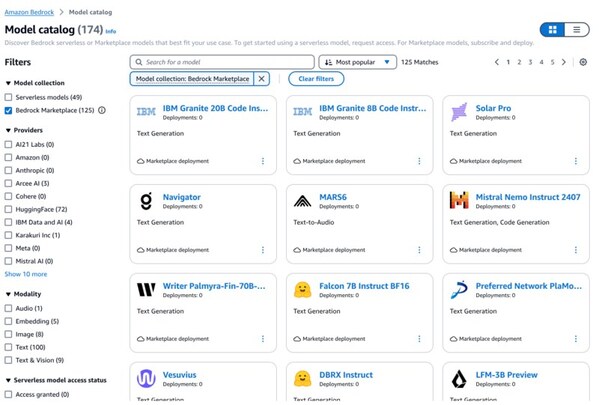

亞馬遜云科技發布Amazon Bedrock新功能

Amazon Bedrock全新升級,引領生成式AI應用新紀元

Amazon Bedrock推出多個新模型和全新強大的推理和數據處理功能

亞馬遜云科技宣布Amazon Trainium2實例正式可用

亞馬遜云科技宣布Amazon EC2 P5e實例正式可用 由英偉達H200 GPU提供支持

Mistral Large 2現已在Amazon Bedrock中正式可用

亞馬遜云科技宣布基于自研Amazon Graviton4的Amazon EC2 R8g實例正式可用

基于瑞薩RZ/V2H AI微處理器的解決方案:高性能視覺AI系統

Amazon EC2 Inf2實例正式可用 助力低成本、高性能的生成式AI推理

Amazon EC2 Inf2實例正式可用 助力低成本、高性能的生成式AI推理

評論