AI 簡報 20230616 期

1. AMD硬剛英偉達,推出Instinct MI300,單芯片可運行800億參數

原文:https://mp.weixin.qq.com/s/NeSIBtjZ71evn09NPEAc2Q美國時間本周二,AMD舉行了重磅發布會,推出了一款全新的人工智能GPU Instinct MI300,并表示這款處理器將于今年晚些時候開始向部分客戶發貨。自英偉達發布了AI芯片后,便徹底帶動了市場的投資熱情,也推動英偉達登上萬億美元市值的高峰。此次AMD發布重磅AI芯片,有望對英偉達當前的市場地位形成一定沖擊。AMD推出高性能AI芯片在這次AMD的新品發布會中,核心產品無疑是用于訓練大模型的GPU Instinct MI300。早在今年初,AMD便已經宣布了新一代Instinct MI300,是全球首款同時集成CPU、GPU的數據中心APU。如今,這款芯片的名字變成了Instinct MI300A,而純GPU產品則命名為Instinct MI300X。據AMD的CEO蘇姿豐透露,MI300A是全球首個為AI和HPC(高性能計算)打造的APU加速卡,擁有13個小芯片,總共包含1460億個晶體管,24個Zen 4 CPU核心,1個CDNA 3圖形引擎和128GB HBM3內存。相比前代MI250,MI300的性能提高八倍,效率提高五倍。AMD在發布會稍早介紹,新的Zen 4c內核比標準的Zen 4內核密度更高,比標準Zen 4的內核小35%,同時保持100%的軟件兼容性。而GPU MI300X更是本次發布會的重點,這款芯片是AMD針對大語言模型優化的版本,該產品的晶體管數量達到1530億個,內存達到了192GB,內存帶寬為5.2TB/s,Infinity Fabric帶寬為896GB/s。對比英偉達的H100,MI300X提供的HBM(高帶寬內存)密度約為H100的2.4倍,HBM帶寬是1.6倍。這意味著AMD的這款產品可以運行比英偉達H100更大的模型,在現場AMD演示了MI300X運行400億參數的Falcon模型,而OpenAI的GPT-3模型有1750億個參數。蘇姿豐還用Hugging Face基于MI300X的大模型寫了一首關于活動舉辦地舊金山的詩。這也是全球首次在單個GPU上運行這么大的模型,據AMD介紹,單個MI300X可以運行一個參數多達800億的模型。而在未來隨著AI模型越來越大,意味著需要更多GPU來運行最新的大模型,而AMD芯片上內存的增加,意味著開發人員不需要那么多GPU,可以為用戶節省大量成本。蘇姿豐表示,MI300X將于今年第三季度向一些客戶提供樣品,并于第四季度量產。同時AMD還發布了AMD Instinct Platform,集合了8個MI300X,可提供總計1.5TB的HBM3內存。對標英偉達的CUDA,AMD也介紹了自身的芯片軟件ROCm,AMD總裁Victor Peng稱,在構建強大的軟件堆棧方面,AMD取得了真正的巨大進步,ROCm軟件棧可與模型、庫、框架和工具的開放生態系統配合使用。之所以將重心放在AI芯片,也是因為AMD非常看好未來的AI市場。蘇姿豐認為,數據中心人工智能加速器的潛在市場總額將從今年的300億美元增長到2027年的1500億美元以上。硬剛英偉達,但尚未透露大客戶從AMD所介紹的產品性能來看,將成為當下AI市場的有力競爭者,尤其在ChatGPT等生成式AI的帶動下,市場對高性能GPU需求旺盛。不過當前市場中,英偉達處于絕對優勢,占據80%的市場。而AMD并沒有公布這款GPU的具體價格,但是對比英偉達H100價格大多在3萬美元以上,如果MI300X價格能夠更加實惠,將顯著的對英偉達產品造成沖擊,并有助于降低生成式AI的研發成本。有意思的是,在如此強勁的性能面前,市場卻似乎并不買單。截至當日收盤,AMD股價反而下降了3.61%,市值來到2000億元關口。而英偉達股價則拉升了3.9%,總市值達到1.01萬億美元,是AMD的五倍。此次AMD并未透露哪些公司會采用MI300X或簡配版MI300A,而在此前的發布會中,AMD都會披露新產品的大客戶。這可能讓市場認為,目前并沒有大客戶為這款芯片買單。另一方面,AMD并沒有透露新款AI芯片的具體售價,但想要有顯著的成本優勢可能不太現實,因為高密度的HBM價格昂貴。即便MI300X的內存達到了192GB,但這也不是顯著優勢,因為英偉達也擁有相同內存規格的產品。更重要的原因在于,MI300并不具備H100所擁有的Transformer Engine。Transformer Engine能夠用于加速Transformer模型,以在AI的訓練和推理中以較低的內存利用率提供更好的性能。有分析師認為,如果訓練一個新的模型,需要投入數千個GPU,并耗費一年的時間,那么幾乎不會有人會浪費2-3年或者投入3倍數量的GPU。而Transformer Engine能夠讓大模型實現三倍的性能表達。盡管市場中認為,AMD的MI300芯片應該是除了谷歌的TPU之外,能與英偉達在AI訓練端上匹敵的產品。成為當前大企業在訓練AI大模型時,除了英偉達之外的另一個重要選擇。但想要在短時間內挑戰英偉達,顯然還是比較困難的。就如AMD總裁VictorPeng說的那樣,“盡管這是一個過程,但我們在構建強大的軟件堆棧方面取得了很大進展,該軟件堆棧與開放的模型、庫、框架和工具生態系統兼容。”無論如何需要市場中有大客戶切實的使用AMD新款芯片。小結AMD此次重磅發布的MI300系列芯片,無疑為AI市場注入了一劑強心針,不僅預示著AMD在持續看好未來的AI市場,也將表明AMD將在這一市場中與英偉達正面競爭。至少對于相關企業及用戶而言,有更多的選擇是一件好事。

2. 價格最高降75%、API函數調用上線、上下文長度提高4倍,OpenAI凌晨再給ChatGPT、GPT-4加碼!

原文:https://mp.weixin.qq.com/s/GcsAk_qqqWfwck4KSdvJew就在今天凌晨,OpenAI 馬不停蹄地又雙叒叕更新啦!這一次,不僅重磅升級了 ChatGPT 背后的 GPT-3.5-turbo 模型、以及最先進的 GPT-4 文本生成模型,而且大幅降低了價格,另外還為 gpt-3.5-turbo 提供 16000 個 Token 的語境窗口(Context Window)上下文選項。更新速覽詳細來看,在今天的更新中,OpenAI 主要聚焦在下面幾個維度:

- 全新的 16k 上下文 GPT-3.5-Turbo 模型版本(今天向所有人提供)

- 升級版的 GPT-4 和 GPT-3.5-Turbo 模型

- Chat Completions API 中的新函數調用功能

- 最先進的 V2 嵌入模型降價 75%

- gpt-3.5-turbo 的輸入 Token 成本降低 25%

- 宣布 gpt-3.5-turbo-0301 和 gpt-4-0314 模型的淘汰時間表

- GPT-4 的 API 權限將開放給更多的人

由于它提供了 4 倍于 gpt-3.5-turbo 的上下文長度,這意味著 gpt-3.5-turbo-16k 模型現在可以在一次請求中支持 20 頁的文本。這對于需要模型處理和生成較大塊文本響應的開發者來說是一個相當大的提升。不過,想要廣泛使用還需要再等一等。

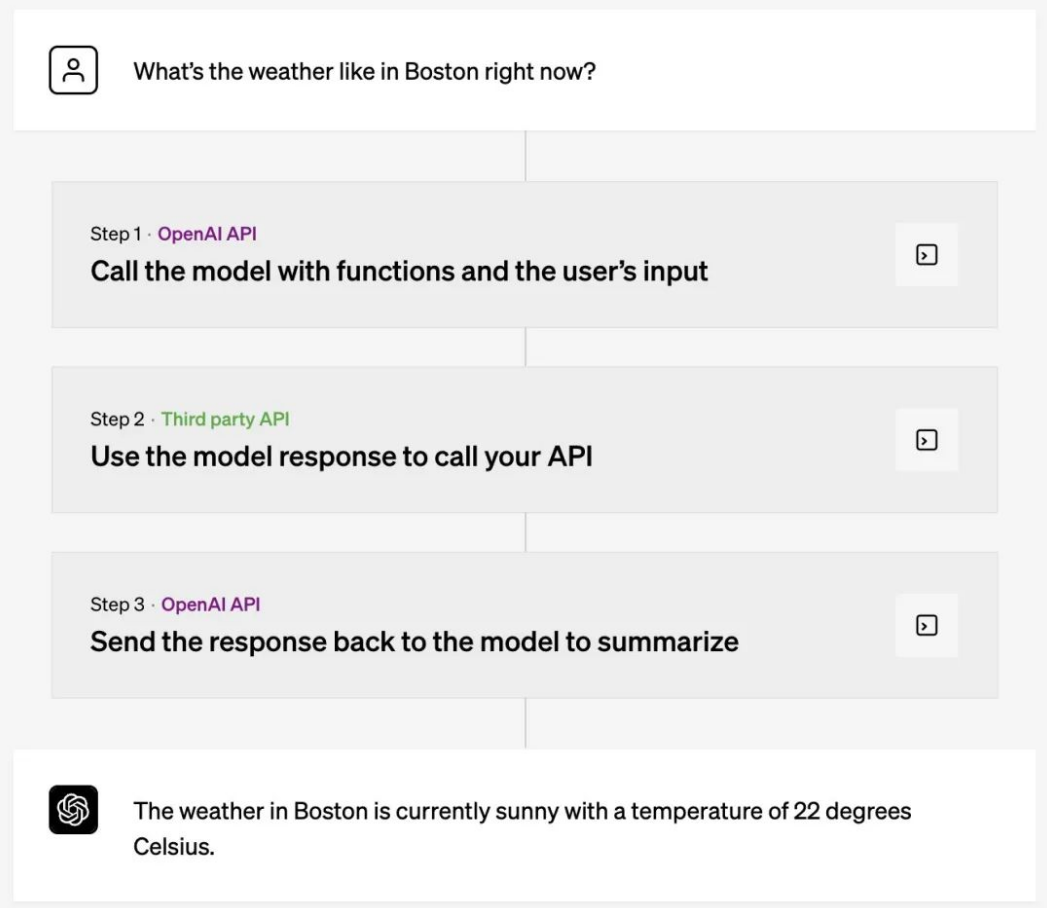

由于它提供了 4 倍于 gpt-3.5-turbo 的上下文長度,這意味著 gpt-3.5-turbo-16k 模型現在可以在一次請求中支持 20 頁的文本。這對于需要模型處理和生成較大塊文本響應的開發者來說是一個相當大的提升。不過,想要廣泛使用還需要再等一等。 再者,gpt-3.5-turbo-0613 版本與 GPT-4 一樣有著函數調用功能,以及通過系統消息提供的更可靠的可引導性,這兩個特性使開發者能夠更有效地引導模型的響應。函數調用支持新版 GPT-4 和 GPT-3.5要論最最最為重磅的更新,便是開發者現在可以向 gpt-4-0613 和 gpt-3.5-turbo-0613 描述函數,并讓模型智能地選擇輸出一個包含參數的 JSON 對象來調用這些函數。這是一種全新的方式,開發者可以更可靠地將 GPT 的能力與外部工具和 API 連接起來。簡單來看,OpenAI 聯合創始人Greg Brockman 解釋道,這是插件的底層機制,允許開發者與自己的工具集成起來:那該具體怎么用?OpenAI 舉了三個例子,其表示,這些模型已經過微調,既可以檢測到何時需要調用一個函數(取決于用戶的輸入),又可以用符合函數簽名的 JSON 來響應。函數調用允許開發人員更可靠地從模型中獲得結構化的數據。例如,開發人員可以:

再者,gpt-3.5-turbo-0613 版本與 GPT-4 一樣有著函數調用功能,以及通過系統消息提供的更可靠的可引導性,這兩個特性使開發者能夠更有效地引導模型的響應。函數調用支持新版 GPT-4 和 GPT-3.5要論最最最為重磅的更新,便是開發者現在可以向 gpt-4-0613 和 gpt-3.5-turbo-0613 描述函數,并讓模型智能地選擇輸出一個包含參數的 JSON 對象來調用這些函數。這是一種全新的方式,開發者可以更可靠地將 GPT 的能力與外部工具和 API 連接起來。簡單來看,OpenAI 聯合創始人Greg Brockman 解釋道,這是插件的底層機制,允許開發者與自己的工具集成起來:那該具體怎么用?OpenAI 舉了三個例子,其表示,這些模型已經過微調,既可以檢測到何時需要調用一個函數(取決于用戶的輸入),又可以用符合函數簽名的 JSON 來響應。函數調用允許開發人員更可靠地從模型中獲得結構化的數據。例如,開發人員可以:- 創建聊天機器人,通過調用外部工具(例如,像 ChatGPT 插件)來回答問題

- 將自然語言轉換為 API 調用或數據庫查詢

- 從文本中提取結構化數據

如果,現在你有 GPT-4 訪問權限,那么這些模型可以用函數調用功能。

如果,現在你有 GPT-4 訪問權限,那么這些模型可以用函數調用功能。

舊模型即將廢棄今天,OpenAI 將開始對 3 月份宣布的 gpt-4 和 gpt-3.5-turbo 的初始版本進行升級和廢棄處理。使用穩定模型名稱(gpt-3.5-turbo、gpt-4 和 gpt-4-32k)的應用程序將在 6 月 27 日自動升級到上面列出的新模型。為了比較不同版本的模型性能,OpenAI 還提供開源的 Evals 庫(https://github.com/openai/evals)支持公共和私人評估 LLM,幫助開發者評測模型的變化將如何影響你的用例。當然,對于需要更多時間過渡的開發者,OpenAI 也表示,可以繼續使用舊的模型。這些舊型號將在 9 月 13 日之后,徹底棄用。加量不加價,即日起生效除了以上功能更新之外,OpenAI 宣布下調價格,即日起生效。首先,對于 OpenAI 最受歡迎的嵌入模型——text-embedding-ada-002,OpenAI 將成本降低 75%,至每 1K Token 是 0.0001 美元。其次,對于最受歡迎的聊天模型——GPT-3.5 Turbo,OpenAI 將輸入 Token 的成本直降 25%,現在每 1K 輸入 Token 只需 0.0015 美元,每 1K 輸出 token 只需 0.002 美元,這相當于 1 美元大約有 700 頁的文本。再者,最新推出的 gpt-3.5-turbo-16k 的價格是每 1K 輸入 token 是 0.003 美元,每 1K 輸出 Token 為 0.004 美元。OpenAI 表示,降低成本是通過提高其系統的效率來實現的。毫無疑問,這是初創公司關注的關鍵領域,因為它在研發和基礎設施上花費了數億美元。

舊模型即將廢棄今天,OpenAI 將開始對 3 月份宣布的 gpt-4 和 gpt-3.5-turbo 的初始版本進行升級和廢棄處理。使用穩定模型名稱(gpt-3.5-turbo、gpt-4 和 gpt-4-32k)的應用程序將在 6 月 27 日自動升級到上面列出的新模型。為了比較不同版本的模型性能,OpenAI 還提供開源的 Evals 庫(https://github.com/openai/evals)支持公共和私人評估 LLM,幫助開發者評測模型的變化將如何影響你的用例。當然,對于需要更多時間過渡的開發者,OpenAI 也表示,可以繼續使用舊的模型。這些舊型號將在 9 月 13 日之后,徹底棄用。加量不加價,即日起生效除了以上功能更新之外,OpenAI 宣布下調價格,即日起生效。首先,對于 OpenAI 最受歡迎的嵌入模型——text-embedding-ada-002,OpenAI 將成本降低 75%,至每 1K Token 是 0.0001 美元。其次,對于最受歡迎的聊天模型——GPT-3.5 Turbo,OpenAI 將輸入 Token 的成本直降 25%,現在每 1K 輸入 Token 只需 0.0015 美元,每 1K 輸出 token 只需 0.002 美元,這相當于 1 美元大約有 700 頁的文本。再者,最新推出的 gpt-3.5-turbo-16k 的價格是每 1K 輸入 token 是 0.003 美元,每 1K 輸出 Token 為 0.004 美元。OpenAI 表示,降低成本是通過提高其系統的效率來實現的。毫無疑問,這是初創公司關注的關鍵領域,因為它在研發和基礎設施上花費了數億美元。3. Altman、Hinton 中國首秀:GPT 終將過時,AI 是當今世界最迫切的問題!

原文:https://mp.weixin.qq.com/s/TsjS-2b-UEE7zsWLA2f7AAOpenAI、DeepMind 和 Stability AI 的科學家科普 AI 治理,Google、Meta 和微軟的領航人物共論開源未來,圖靈獎得主與斯坦福、UC Berkeley、MIT 的教授展開學術辯論——這描述的并不是遠在大洋彼岸的 NeurIPS 或 ACL 會議,而是由中國智源研究院主辦的年度盛會:北京智源大會。今年的北京智源大會于 6 月 9-10 日召開,20 場論壇、100 場報告、頂尖的專家、頂尖的觀眾,匯聚了 AI 領域純粹、專業的前沿思想。OpenAI 創始人 Sam Altman 以及“深度學習三巨頭”中的兩位 Yann LeCun 與 Geoffrey Hinton 現身于分論壇視頻連線的大熒幕上,Max Tegmark 與 Stuart Russell 等來自頂尖學府的教授親赴現場。CSDN 在現場參加了這場為時兩天的 AI 盛會。科技大咖智聚京城,共論當前 AI 領域最前沿的爭議焦點:

- 對 AI 保持樂觀主義的 Yann LeCun,認為 AI 還遠遠未發展到還需要操心的程度。GPT 終將過時,未來的 AI 會面臨三大挑戰,解決后將能訓練出「世界模型」(World Model)。

- 曾用一份“暫停 6 個月 AI 研究”的公開信震驚業界的 Max Tegmark 教授則表示,罔顧 AI 的最壞結果將會是人類滅絕。對齊問題將是學術界接下來的一大難題:如此龐大而復雜的智能模型,要怎樣才能保持和人類同一水準的價值觀和道德觀?

- 一亮相便轟動北京會場的 Sam Altman,則發表了一份真誠的呼吁:國際科技界需要團結一心,攜手促進 AGI 安全的透明化,為未來十年內誕生的“超級智能”做好準備。

- 學術界還有一部分人,對這些圍繞 GPT 的話題并不買賬,而是關心更深遠的 AI 話題。Stuart Russell 教授直言,目前的大語言模型缺乏「內部目標」,而人類也不理解它們的“黑匣子”里都發生了什么。

- Geoffrey Hinton 則帶來了一場精彩絕倫的謝幕演講:“超級智能”已成雛形,但人類尚未給它建立道德準則——現在為時不晚。

- AGI 可能很快會出現,超級智能在未來十年內可能會成為現實。

- 目前已經取得了一些全球合作的突破,但全球合作仍然面臨困難。

- AI 安全性的研究是一個復雜的問題,需要考慮多個因素,并需要大量的投入,希望中國和美國的研究人員能做出貢獻。

- 當被問及是否打算重新開放 GPT 的源代碼時,Altman 表示已經作出了一定的努力,未來將會有許多開源大模型誕生。但開源模型在 AI 發展中起了重要作用,當模型變得更大時,就更需要謹慎安全問題。

- 楊立昆即將參加一個辯論,與 Joshua Bengio、Max Tegmark 和 Melanie Mitchell 討論人工智能是否會威脅人類生存。

- Max Tegmark 和 Joshua Bengio 認為強大的人工智能系統可能對人類構成風險,而楊立昆和 Melanie Mitchell 則持相反觀點。

- 楊立昆指出,他并不是想說“AI 完全不存在風險”,而是認為“目前的 AI 風險可以被謹慎的工程設計減輕或抑制”。

- 楊立昆表示自己不能預測超級智能在未來能造成多大的影響,因為超級智能尚未問世。他舉了一個例子:如果你去問一個 1930 年的航空工程師,“我該如何確保渦輪噴氣發動機的安全可靠性?”那他肯定答不出來,因為渦輪噴氣發動機在 1930 年還沒被發明出來。

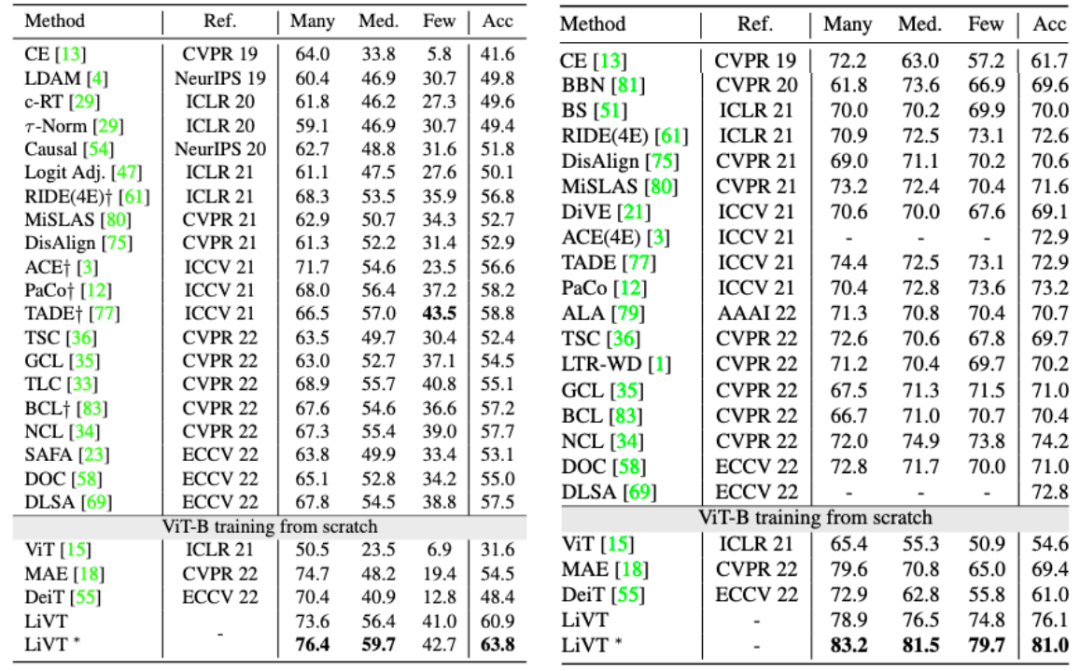

4. CVPR23|清華大學提出LiVT:用視覺Transformer學習長尾數據,解決不平衡標注數據不在話下

原文:https://mp.weixin.qq.com/s/1MfOWcE9x7Vk7tP2n1V4bg背景在機器學習領域中,學習不平衡的標注數據一直是一個常見而具有挑戰性的任務。近年來,視覺 Transformer 作為一種強大的模型,在多個視覺任務上展現出令人滿意的效果。然而,視覺 Transformer 處理長尾分布數據的能力和特性,還有待進一步挖掘。目前,已有的長尾識別模型很少直接利用長尾數據對視覺 Transformer(ViT)進行訓練。基于現成的預訓練權重進行研究可能會導致不公平的比較結果,因此有必要對視覺 Transformer 在長尾數據下的表現進行系統性的分析和總結。

?

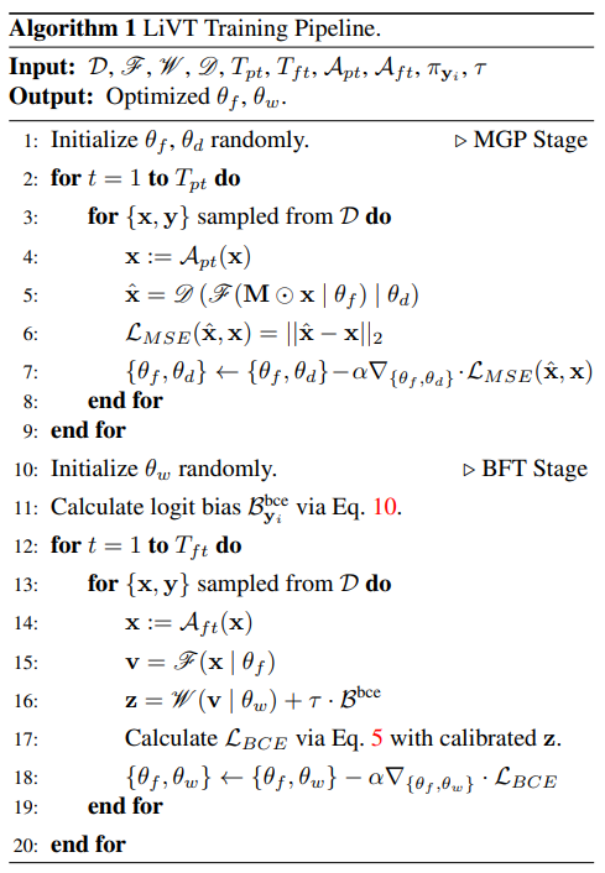

?論文鏈接:https://arxiv.org/abs/2212.02015代碼鏈接:https://github.com/XuZhengzhuo/LiVT本文旨在填補這一研究空白,詳細探討了視覺 Transformer 在處理長尾數據時的優勢和不足之處。本文將重點關注如何有效利用長尾數據來提升視覺 Transformer 的性能,并探索解決數據不平衡問題的新方法。通過本文的研究和總結,研究團隊有望為進一步改進視覺 Transformer 模型在長尾數據任務中的表現提供有益的指導和啟示。這將為解決現實世界中存在的數據不平衡問題提供新的思路和解決方案。文章通過一系列實驗發現,在有監督范式下,視覺 Transformer 在處理不平衡數據時會出現嚴重的性能衰退,而使用平衡分布的標注數據訓練出的視覺 Transformer 呈現出明顯的性能優勢。相比于卷積網絡,這一特點在視覺 Transformer 上體現的更為明顯。另一方面,無監督的預訓練方法無需標簽分布,因此在相同的訓練數據量下,視覺 Transformer 可以展現出類似的特征提取和重建能力。基于以上觀察和發現,研究提出了一種新的學習不平衡數據的范式,旨在讓視覺 Transformer 模型更好地適應長尾數據。通過這種范式的引入,研究團隊希望能夠充分利用長尾數據的信息,提高視覺 Transformer 模型在處理不平衡標注數據時的性能和泛化能力。文章貢獻本文是第一個系統性的研究用長尾數據訓練視覺 Transformer 的工作,在此過程中,做出了以下主要貢獻:首先,本文深入分析了傳統有監督訓練方式對視覺 Transformer 學習不均衡數據的限制因素,并基于此提出了雙階段訓練流程,將視覺 Transformer 模型內在的歸納偏置和標簽分布的統計偏置分階段學習,以降低學習長尾數據的難度。其中第一階段采用了流行的掩碼重建預訓練,第二階段采用了平衡的損失進行微調監督。

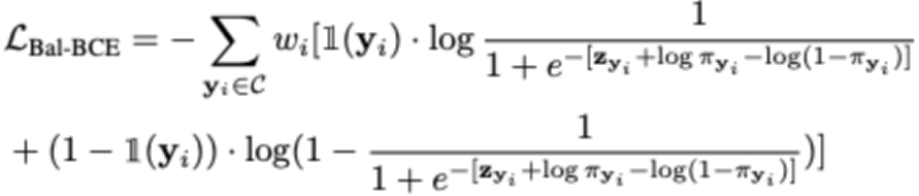

其次,本文提出了平衡的二進制交叉熵損失函數,并給出了嚴格的理論推導。平衡的二進制交叉熵損失的形式如下:

其次,本文提出了平衡的二進制交叉熵損失函數,并給出了嚴格的理論推導。平衡的二進制交叉熵損失的形式如下: 與之前的平衡交叉熵損失相比,本文的損失函數在視覺 Transformer 模型上展現出更好的性能,并且具有更快的收斂速度。研究中的理論推導為損失函數的合理性提供了嚴密的解釋,進一步加強了我們方法的可靠性和有效性。

與之前的平衡交叉熵損失相比,本文的損失函數在視覺 Transformer 模型上展現出更好的性能,并且具有更快的收斂速度。研究中的理論推導為損失函數的合理性提供了嚴密的解釋,進一步加強了我們方法的可靠性和有效性。 基于以上貢獻,文章提出了一個全新的學習范式 LiVT,充分發揮視覺 Transformer 模型在長尾數據上的學習能力,顯著提升模型在多個數據集上的性能。該方案在多個數據集上取得了遠好于視覺 Transformer 基線的性能表現。

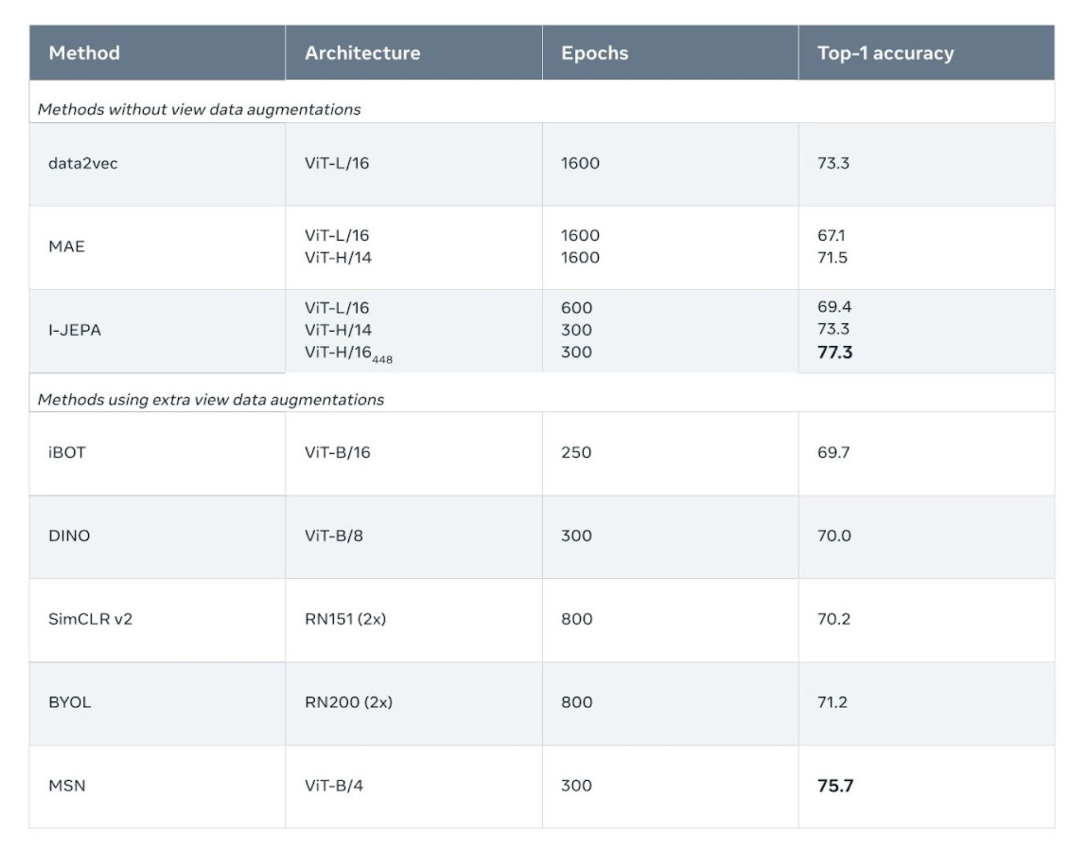

基于以上貢獻,文章提出了一個全新的學習范式 LiVT,充分發揮視覺 Transformer 模型在長尾數據上的學習能力,顯著提升模型在多個數據集上的性能。該方案在多個數據集上取得了遠好于視覺 Transformer 基線的性能表現。 不同參數量下在 ImageNet-LT 上的準確性。

不同參數量下在 ImageNet-LT 上的準確性。 同時,本文還驗證了在相同的訓練數據規模的情況下,使用ImageNet的長尾分布子集(LT)和平衡分布子集(BAL)訓練的 ViT-B 模型展現出相近的重建能力。如 LT-Large-1600 列所示,在 ImageNet-LT 數據集中,可以通過更大的模型和 MGP epoch 獲得更好的重建結果。總結本文提供了一種新的基于視覺 Transformer 處理不平衡數據的方法 LiVT。LiVT 利用掩碼建模和平衡微調兩個階段的訓練策略,使得視覺 Transformer 能夠更好地適應長尾數據分布并學習到更通用的特征表示。該方法不僅在實驗中取得了顯著的性能提升,而且無需額外的數據,具有實際應用的可行性。

同時,本文還驗證了在相同的訓練數據規模的情況下,使用ImageNet的長尾分布子集(LT)和平衡分布子集(BAL)訓練的 ViT-B 模型展現出相近的重建能力。如 LT-Large-1600 列所示,在 ImageNet-LT 數據集中,可以通過更大的模型和 MGP epoch 獲得更好的重建結果。總結本文提供了一種新的基于視覺 Transformer 處理不平衡數據的方法 LiVT。LiVT 利用掩碼建模和平衡微調兩個階段的訓練策略,使得視覺 Transformer 能夠更好地適應長尾數據分布并學習到更通用的特征表示。該方法不僅在實驗中取得了顯著的性能提升,而且無需額外的數據,具有實際應用的可行性。5. LeCun世界模型首項研究來了:自監督視覺,像人一樣學習和推理,已開源

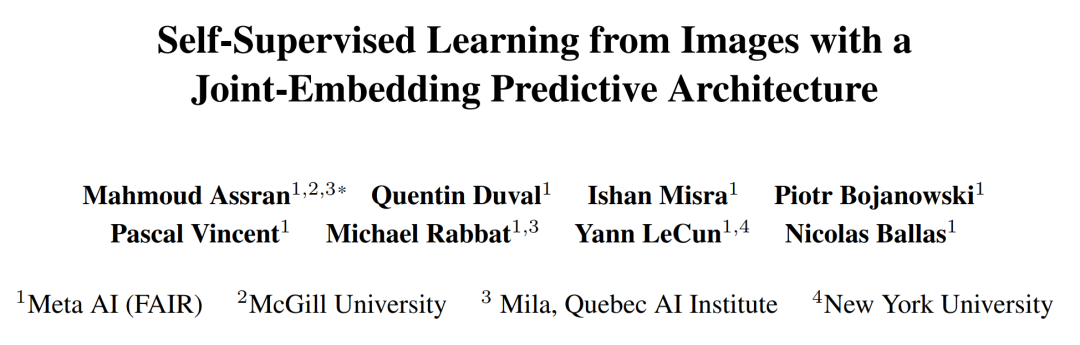

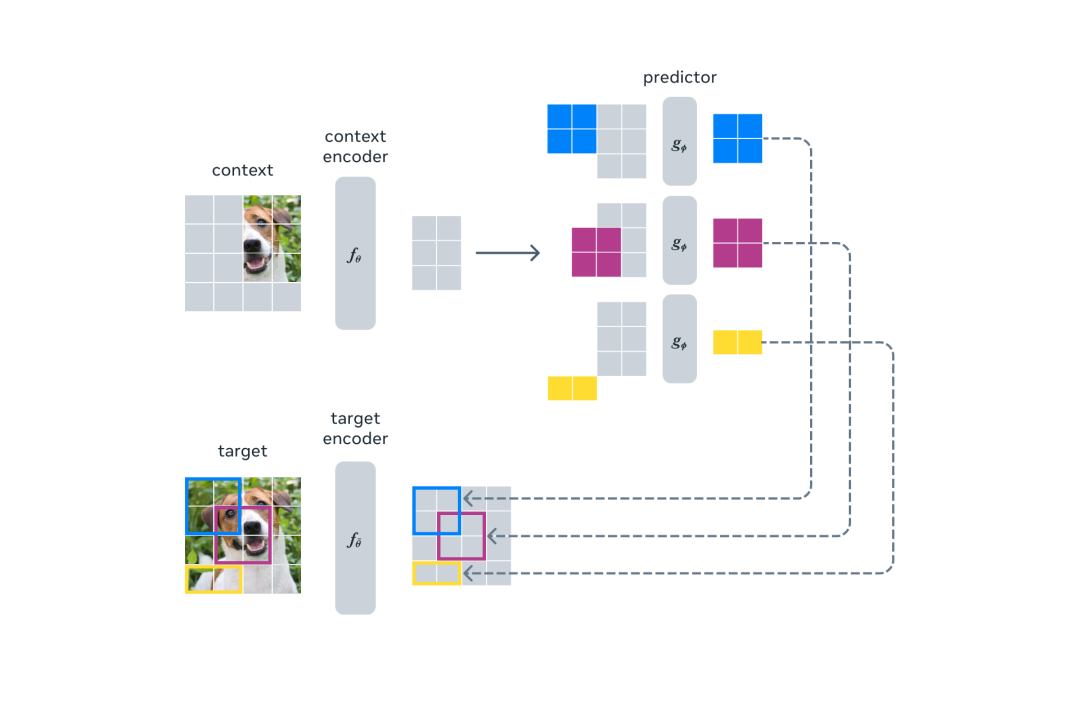

原文:https://mp.weixin.qq.com/s/A_MmOIOQ08SzWntpd6VYGg去年初,Meta 首席 AI 科學家 Yann LeCun 針對「如何才能打造出接近人類水平的 AI」提出了全新的思路。他勾勒出了構建人類水平 AI 的另一種愿景,指出學習世界模型(即世界如何運作的內部模型)的能力或許是關鍵。這種學到世界運作方式內部模型的機器可以更快地學習、規劃完成復雜的任務,并輕松適應不熟悉的情況。LeCun 認為,構造自主 AI 需要預測世界模型,而世界模型必須能夠執行多模態預測,對應的解決方案是一種叫做分層 JEPA(聯合嵌入預測架構)的架構。該架構可以通過堆疊的方式進行更抽象、更長期的預測。6 月 9 日,在 2023 北京智源大會開幕式的 keynote 演講中,LeCun 又再次講解了世界模型的概念,他認為基于自監督的語言模型無法獲得關于真實世界的知識,這些模型在本質上是不可控的。今日,Meta 推出了首個基于 LeCun 世界模型概念的 AI 模型。該模型名為圖像聯合嵌入預測架構(Image Joint Embedding Predictive Architecture, I-JEPA),它通過創建外部世界的內部模型來學習, 比較圖像的抽象表示(而不是比較像素本身)。I-JEPA 在多項計算機視覺任務上取得非常不錯的效果,并且計算效率遠高于其他廣泛使用的計算機視覺模型。此外 I-JEPA 學得的表示也可以用于很多不同的應用,無需進行大量微調。

舉個例子,Meta 在 72 小時內使用 16 塊 A100 GPU 訓練了一個 632M 參數的視覺 transformer 模型,還在 ImageNet 上實現了 low-shot 分類的 SOTA 性能,其中每個類只有 12 個標簽樣本。其他方法通常需要 2 到 10 倍的 GPU 小時數,并在使用相同數據量訓練時誤差率更高。相關的論文《Self-Supervised Learning from Images with a Joint-Embedding Predictive Architecture》已被 CVPR 2023 接收。當然,所有的訓練代碼和模型檢查點都將開源。

舉個例子,Meta 在 72 小時內使用 16 塊 A100 GPU 訓練了一個 632M 參數的視覺 transformer 模型,還在 ImageNet 上實現了 low-shot 分類的 SOTA 性能,其中每個類只有 12 個標簽樣本。其他方法通常需要 2 到 10 倍的 GPU 小時數,并在使用相同數據量訓練時誤差率更高。相關的論文《Self-Supervised Learning from Images with a Joint-Embedding Predictive Architecture》已被 CVPR 2023 接收。當然,所有的訓練代碼和模型檢查點都將開源。

通過自監督學習獲取常識型知識I-JEPA 基于一個事實,即人類僅通過被動觀察就可以了解關于世界的大量背景知識,這些常識信息被認為是實現智能行為的關鍵。通常,AI 研究人員會設計學習算法來捕獲現實世界的常識,并將其編碼為算法可訪問的數字表征。為了高效,這些表征需要以自監督的方式來學習,即直接從圖像或聲音等未標記的數據中學習,而不是從手動標記的數據集中學習。在高層級上,JEPA 的一個輸入中某個部分的表征是根據其他部分的表征來預測的。同時,通過在高抽象層次上預測表征而不是直接預測像素值,JEPA 能夠直接學習有用的表征,同時避免了生成模型的局限性。相比之下,生成模型會通過刪除或扭曲模型輸入的部分內容來學習。然而,生成模型的一個顯著缺點是模型試圖填補每一點缺失的信息,即使現實世界本質上是不可預測的。因此,生成模型過于關注不相關的細節,而不是捕捉高級可預測的概念。

- 論文地址:https://arxiv.org/pdf/2301.08243.pdf

- GitHub 地址:https://t.co/DgS9XiwnMz

自監督學習的通用架構,其中系統學習捕獲其輸入之間的關系。邁向能力廣泛的 JEPA 的第一步I-JEPA 的核心思路是以更類似于人類理解的抽象表征來預測缺失信息。與在像素 /token 空間中進行預測的生成方法相比,I-JEPA 使用抽象的預測目標,潛在地消除了不必要的像素級細節,從而使模型學習更多語義特征。另一個引導 I-JEPA 產生語義表征的核心設計是多塊掩碼策略。該研究使用信息豐富的上下文來預測包含語義信息的塊,并表明這是非常必要的。

自監督學習的通用架構,其中系統學習捕獲其輸入之間的關系。邁向能力廣泛的 JEPA 的第一步I-JEPA 的核心思路是以更類似于人類理解的抽象表征來預測缺失信息。與在像素 /token 空間中進行預測的生成方法相比,I-JEPA 使用抽象的預測目標,潛在地消除了不必要的像素級細節,從而使模型學習更多語義特征。另一個引導 I-JEPA 產生語義表征的核心設計是多塊掩碼策略。該研究使用信息豐富的上下文來預測包含語義信息的塊,并表明這是非常必要的。 I-JEPA 使用單個上下文塊來預測源自同一圖像的各種目標塊的表征。I-JEPA 中的預測器可以看作是一個原始的(和受限的)世界模型,它能夠從部分可觀察的上下文中模擬靜態圖像中的空間不確定性。更重要的是,這個世界模型是語義級的,因為它預測圖像中不可見區域的高級信息,而不是像素級細節。預測器如何學習建模世界的語義。對于每張圖像,藍框外的部分被編碼并作為上下文提供給預測器。然后預測器輸出它期望在藍框內區域的表示。為了可視化預測,Meta 訓練了一個生成模型, 它生成了由預測輸出表示的內容草圖,并在藍框內顯示樣本輸出。很明顯,預測器識別出了應該填充哪些部分的語義(如狗的頭部、鳥的腿、狼的前肢、建筑物的另一側)。為了理解模型捕獲的內容,Meta 訓練了一個隨機解碼器,將 I-JEPA 預測的表示映射回像素空間,這展示出了探針操作后在藍框中進行預測時的模型輸出。這種定性評估表明,I-JEPA 正確捕獲了位置不確定性,并生成了具有正確姿態的高級對象部分(如狗的頭部、狼的前肢)。簡而言之,I-JEPA 能夠學習對象部分的高級表示,而不會丟棄它們在圖像中的局部位置信息。高效率、強性能I-JEPA 預訓練在計算上也很高效,在使用更多計算密集型數據增強來生成多個視圖時不會產生任何開銷。目標編碼器只需要處理圖像的一個視圖,上下文編碼器只需要處理上下文塊。實驗發現,I-JEPA 在不使用手動視圖增強的情況下學習了強大的現成語義表示,具體可見下圖。此外 I-JEPA 還在 ImageNet-1K 線性探針和半監督評估上優于像素和 token 重建方法。

I-JEPA 使用單個上下文塊來預測源自同一圖像的各種目標塊的表征。I-JEPA 中的預測器可以看作是一個原始的(和受限的)世界模型,它能夠從部分可觀察的上下文中模擬靜態圖像中的空間不確定性。更重要的是,這個世界模型是語義級的,因為它預測圖像中不可見區域的高級信息,而不是像素級細節。預測器如何學習建模世界的語義。對于每張圖像,藍框外的部分被編碼并作為上下文提供給預測器。然后預測器輸出它期望在藍框內區域的表示。為了可視化預測,Meta 訓練了一個生成模型, 它生成了由預測輸出表示的內容草圖,并在藍框內顯示樣本輸出。很明顯,預測器識別出了應該填充哪些部分的語義(如狗的頭部、鳥的腿、狼的前肢、建筑物的另一側)。為了理解模型捕獲的內容,Meta 訓練了一個隨機解碼器,將 I-JEPA 預測的表示映射回像素空間,這展示出了探針操作后在藍框中進行預測時的模型輸出。這種定性評估表明,I-JEPA 正確捕獲了位置不確定性,并生成了具有正確姿態的高級對象部分(如狗的頭部、狼的前肢)。簡而言之,I-JEPA 能夠學習對象部分的高級表示,而不會丟棄它們在圖像中的局部位置信息。高效率、強性能I-JEPA 預訓練在計算上也很高效,在使用更多計算密集型數據增強來生成多個視圖時不會產生任何開銷。目標編碼器只需要處理圖像的一個視圖,上下文編碼器只需要處理上下文塊。實驗發現,I-JEPA 在不使用手動視圖增強的情況下學習了強大的現成語義表示,具體可見下圖。此外 I-JEPA 還在 ImageNet-1K 線性探針和半監督評估上優于像素和 token 重建方法。 I-JEPA 還能與以往在語義任務上依賴手動數據增強的方法競爭。相比之下,I-JEPA 在對象計數和深度預測等低級視覺任務上取得了更好的性能。通過使用較小剛性歸納偏置的更簡單模型,I-JEPA 適用于更廣泛的任務集合。

I-JEPA 還能與以往在語義任務上依賴手動數據增強的方法競爭。相比之下,I-JEPA 在對象計數和深度預測等低級視覺任務上取得了更好的性能。通過使用較小剛性歸納偏置的更簡單模型,I-JEPA 適用于更廣泛的任務集合。 low shot 分類準確性:使用 1% 標簽時 ImageNet-1k 上的半監督評估結果(每類只有 12 張標簽圖像)。AI 智能向人類水平更近了一步I-JEPA 展示了無需通過手動圖像變換來編碼額外知識時,學習有競爭力的現成圖像表示的潛力。繼續推進 JEPA 以從更豐富模態中學習更通用世界模型將變得特別有趣,比如人們從一個短上下文中對視頻中的將來事件做出長期空間和時間預測,并利用音頻或文本 prompt 對這些預測進行調整。Meta 希望將 JEPA 方法擴展到其他領域,比如圖像 - 文本配對數據和視頻數據。未來,JEPA 模型可以在視頻理解等任務中得到應用。這是應用和擴展自監督方法來學習更通用世界模型的重要一步。

low shot 分類準確性:使用 1% 標簽時 ImageNet-1k 上的半監督評估結果(每類只有 12 張標簽圖像)。AI 智能向人類水平更近了一步I-JEPA 展示了無需通過手動圖像變換來編碼額外知識時,學習有競爭力的現成圖像表示的潛力。繼續推進 JEPA 以從更豐富模態中學習更通用世界模型將變得特別有趣,比如人們從一個短上下文中對視頻中的將來事件做出長期空間和時間預測,并利用音頻或文本 prompt 對這些預測進行調整。Meta 希望將 JEPA 方法擴展到其他領域,比如圖像 - 文本配對數據和視頻數據。未來,JEPA 模型可以在視頻理解等任務中得到應用。這是應用和擴展自監督方法來學習更通用世界模型的重要一步。6. 視頻版Midjourney免費開放,一句話拍大片!網友:上一次這么激動還是上次了

https://mp.weixin.qq.com/s/Eeuea9l_iQ87eMghCIHpMQ家人們,現在做個影視級視頻,也就是一句話的事了!例如只需簡單輸入“叢林(Jungle)”,大片鏡頭便可立刻呈現:而且圍繞著“叢林”變換幾個搭配的詞語,比如“河流”、“瀑布”、“黃昏”、“白天”等,這個AI也能秒懂你的意思。還有下面這些自然美景、宇宙奇觀、微觀細胞等高清視頻,統統只需一句話。這就是Stable Diffusion和《瞬息全宇宙》背后技術公司Runway,出品的AI視頻編輯工具Gen2。而且就在最近,一個好消息突然襲來——Gen2可以免費試用了!這可把網友們開心壞了,紛紛開始嘗鮮了起來。體驗Gen2實錄如此好玩的技術,我們當然也要親手體驗上一番。例如我們給Gen2投喂了一句中文:

上海外灘夜景,影視風格。

一個航拍視角的視頻片段便立即被做了出來。如果想讓視頻的風格變換一下,也可以上傳一張圖片,例如我們用的是一張賽博朋克風格的城市照片。

目前Runway官網可免費體驗Gen2的功能是文生視頻(Text to Video),但Gen1也開放了視頻生視頻(Video to Video)的功能。例如一個國外小哥可能受《瞬息全宇宙》的啟發,憑借Gen1也玩了一把更刺激的穿越。他先是在家錄了一段打響指的視頻,然后“啪的一下”,瞬間讓自己步入歐洲皇室貴族的“片場”:

更多內容請查閱源文檔。

7. 分割一切模型(SAM)的全面綜述調研

https://mp.weixin.qq.com/s/39imonlyIdSHYW9VnQhOjw人工智能(AI)正在向 AGI 方向發展,這是指人工智能系統能夠執行廣泛的任務,并可以表現出類似于人類的智能水平,狹義上的 AI 就與之形成了對比,因為專業化的 AI 旨在高效執行特定任務。可見,設計通用的基礎模型迫在眉睫。基礎模型在廣泛的數據上訓練,因而能夠適應各種下游任務。最近 Meta 提出的分割一切模型(Segment Anything Model,SAM)突破了分割界限,極大地促進了計算機視覺基礎模型的發展。SAM 是一個提示型模型,其在 1100 萬張圖像上訓練了超過 10 億個掩碼,實現了強大的零樣本泛化。許多研究人員認為「這是 CV 的 GPT-3 時刻,因為 SAM 已經學會了物體是什么的一般概念,甚至是未知的物體、不熟悉的場景(如水下、細胞顯微鏡)和模糊的情況」,并展示了作為 CV 基本模型的巨大潛力。為了充分了解 SAM,來自香港科技大學(廣州)、上海交大等機構的研究者對其進行了深入研究并聯合發表論文《 A Comprehensive Survey on Segment Anything Model for Vision and Beyond 》。

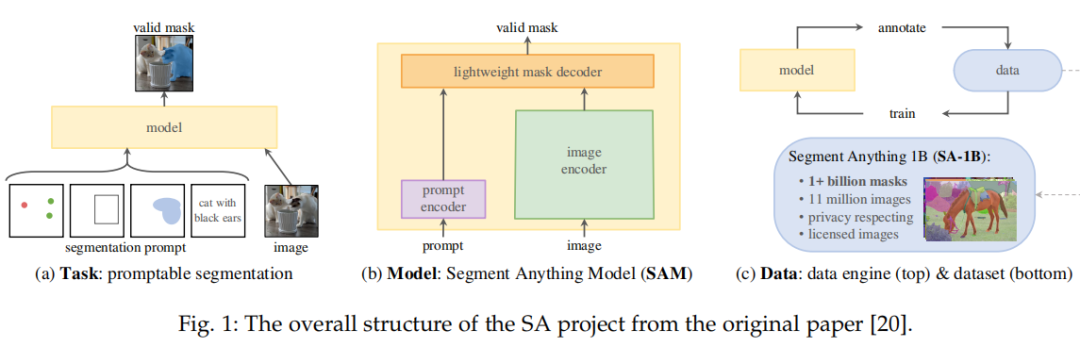

論文鏈接:https://arxiv.org/abs/2305.08196作為首個全面介紹基于 SAM 基礎模型進展的研究,該論文聚焦于 SAM 在各種任務和數據類型上的應用,并討論了其歷史發展、近期進展,以及對廣泛應用的深遠影響。本文首先介紹了包括 SAM 在內的基礎模型的背景和術語,以及對分割任務有重要意義的最新方法;然后,該研究分析并總結了 SAM 在各種圖像處理應用中的優勢和限制,包括軟件場景、真實世界場景和復雜場景,重要的是,該研究得出了一些洞察,以指導未來的研究發展更多用途廣泛的基礎模型并改進 SAM 的架構;最后該研究還總結了 SAM 在視覺及其他領域的應用。下面我們看看論文具體內容。SAM 模型概覽SAM 源自于 2023 年 Meta 的 Segment Anything (SA) 項目。該項目發現在 NLP 和 CV 領域中出現的基礎模型表現出較強的性能,研究人員試圖建立一個類似的模型來統一整個圖像分割任務。然而,在分割領域的可用數據較為缺乏,這與他們的設計目的不同。因此,如圖 1 所示,研究者將路徑分為任務、模型和數據三個步驟。

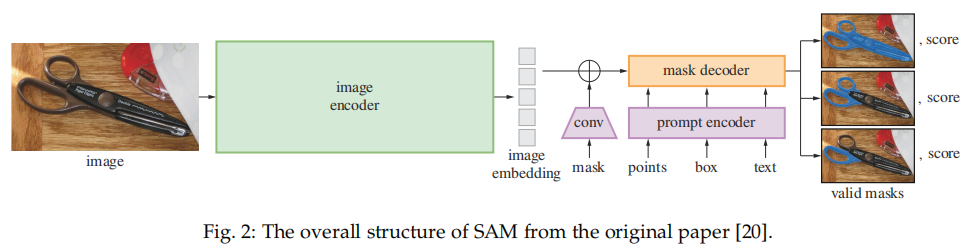

SAM 架構如下所示,主要包含三個部分:圖像編碼器;提示編碼器;以及掩碼解碼器。

SAM 架構如下所示,主要包含三個部分:圖像編碼器;提示編碼器;以及掩碼解碼器。

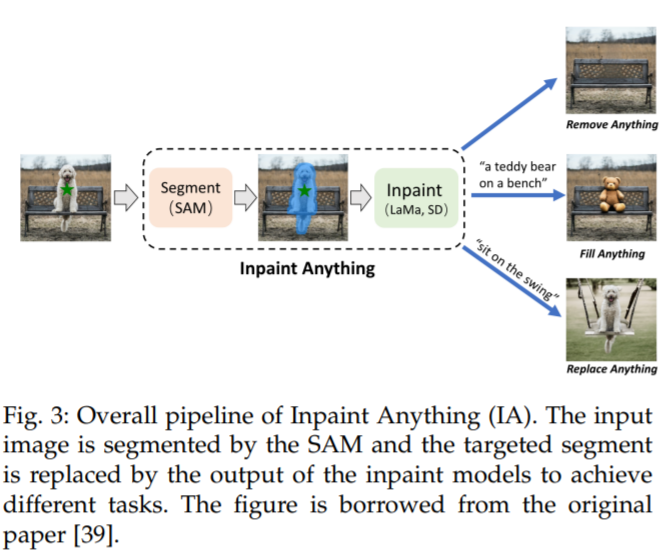

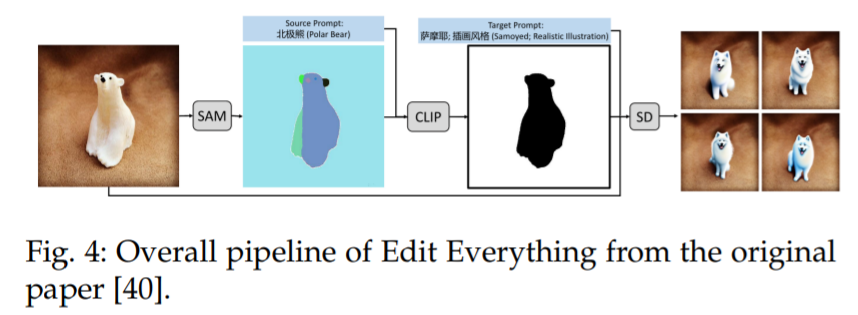

一個類似的想法也可以在 Edit Everything [40] 中看到,如圖 4 所示,該方法允許用戶使用簡單的文本指令編輯圖像。

一個類似的想法也可以在 Edit Everything [40] 中看到,如圖 4 所示,該方法允許用戶使用簡單的文本指令編輯圖像。

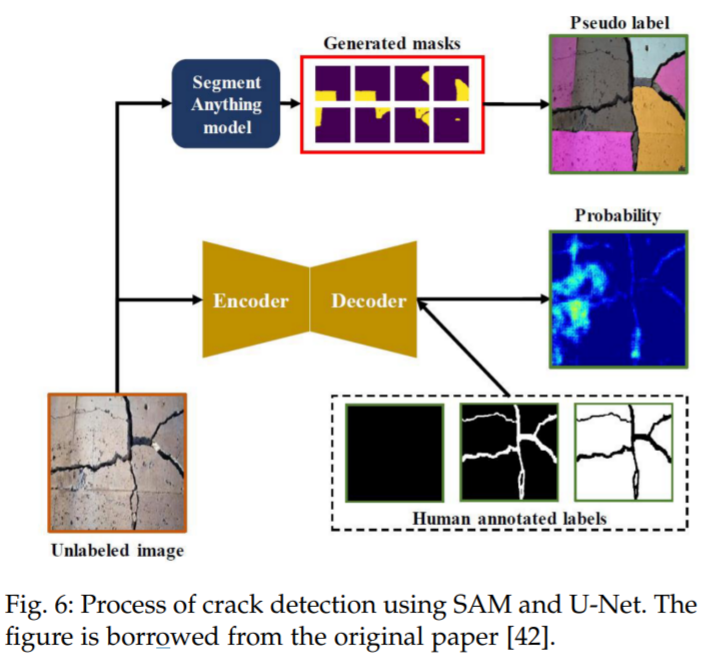

與裂縫檢測中的復雜圖像案例不同,由于隕石坑的形狀主要集中在圓形或橢圓形,所以使用 SAM 作為檢測工具來進行隕石坑檢測更為合適。隕石坑是行星探索中最重要的形態特征之一,檢測和計數它們是行星科學中一個重要但耗時的任務。盡管現有的機器學習和計算機視覺工作成功地解決了隕石坑檢測中的一些特定問題,但它們依賴于特定類型的數據,因此在不同的數據源中無法很好地工作。在 [110] 中,研究者提出了一種使用 SAM 對不熟悉對象進行零樣本泛化的通用隕石坑檢測方案。這個流程使用 SAM 來分割輸入圖像,對數據類型和分辨率沒有限制。然后,它使用圓形 - 橢圓形指數來過濾不是圓形 - 橢圓形的分割掩碼。最后,使用一個后處理過濾器來去除重復的、人為的和假陽性的部分。這個流程在當前領域顯示出其作為通用工具的巨大潛力,并且作者還討論了只能識別特定形狀的缺點。復雜場景除了上述的常規場景,SAM 是否能解決復雜場景(如低對比度場景)中的分割問題,也是一個有意義的問題,可以擴大其應用范圍。為了探索 SAM 在更復雜場景中的泛化能力,Ji 等人 [22] 在三種場景,即偽裝動物、工業缺陷和醫學病變中,定量地將其與尖端模型進行比較。他們在三個偽裝物體分割(COS)數據集上進行實驗,即擁有 250 個樣本的 CAMO [116],擁有 2026 個樣本的 COD10K [117],以及擁有 4121 個樣本的 NC4K [118]。并將其與基于 Transformer 的模型 CamoFormer-P/S [119] 和 HitNet [120] 進行比較。結果表明,SAM 在隱蔽場景中的技巧不足,并指出,潛在的解決方案可能依賴于在特定領域的先驗知識的支持。在 [29] 中也可以得出同樣的結論,作者在上述同樣的三個數據集上,將 SAM 與 22 個最先進的方法在偽裝物體檢測上進行比較。Cao 等人 [115] 提出了一個新的框架,名為 Segment Any Anomaly + (SAA+),用于零樣本異常分割,如圖 7 所示。該框架利用混合提示規范化來提高現代基礎模型的適應性,從而無需領域特定的微調就能進行更精確的異常分割。作者在四個異常分割基準上進行了詳細的實驗,即 VisA [122],MVTecAD [123],MTD [124] 和 KSDD2 [125],并取得了最先進的性能。

與裂縫檢測中的復雜圖像案例不同,由于隕石坑的形狀主要集中在圓形或橢圓形,所以使用 SAM 作為檢測工具來進行隕石坑檢測更為合適。隕石坑是行星探索中最重要的形態特征之一,檢測和計數它們是行星科學中一個重要但耗時的任務。盡管現有的機器學習和計算機視覺工作成功地解決了隕石坑檢測中的一些特定問題,但它們依賴于特定類型的數據,因此在不同的數據源中無法很好地工作。在 [110] 中,研究者提出了一種使用 SAM 對不熟悉對象進行零樣本泛化的通用隕石坑檢測方案。這個流程使用 SAM 來分割輸入圖像,對數據類型和分辨率沒有限制。然后,它使用圓形 - 橢圓形指數來過濾不是圓形 - 橢圓形的分割掩碼。最后,使用一個后處理過濾器來去除重復的、人為的和假陽性的部分。這個流程在當前領域顯示出其作為通用工具的巨大潛力,并且作者還討論了只能識別特定形狀的缺點。復雜場景除了上述的常規場景,SAM 是否能解決復雜場景(如低對比度場景)中的分割問題,也是一個有意義的問題,可以擴大其應用范圍。為了探索 SAM 在更復雜場景中的泛化能力,Ji 等人 [22] 在三種場景,即偽裝動物、工業缺陷和醫學病變中,定量地將其與尖端模型進行比較。他們在三個偽裝物體分割(COS)數據集上進行實驗,即擁有 250 個樣本的 CAMO [116],擁有 2026 個樣本的 COD10K [117],以及擁有 4121 個樣本的 NC4K [118]。并將其與基于 Transformer 的模型 CamoFormer-P/S [119] 和 HitNet [120] 進行比較。結果表明,SAM 在隱蔽場景中的技巧不足,并指出,潛在的解決方案可能依賴于在特定領域的先驗知識的支持。在 [29] 中也可以得出同樣的結論,作者在上述同樣的三個數據集上,將 SAM 與 22 個最先進的方法在偽裝物體檢測上進行比較。Cao 等人 [115] 提出了一個新的框架,名為 Segment Any Anomaly + (SAA+),用于零樣本異常分割,如圖 7 所示。該框架利用混合提示規范化來提高現代基礎模型的適應性,從而無需領域特定的微調就能進行更精確的異常分割。作者在四個異常分割基準上進行了詳細的實驗,即 VisA [122],MVTecAD [123],MTD [124] 和 KSDD2 [125],并取得了最先進的性能。

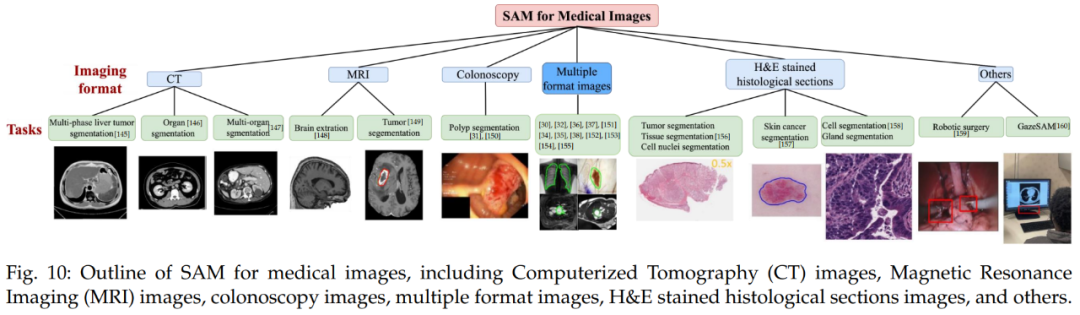

更多模型和應用:視覺及其他視覺相關首先是醫療成像。醫療圖像分割的目的是展示相應組織的解剖或病理結構,可以用于計算機輔助診斷和智能臨床手術。下圖 10 為醫療圖像 SAM 概覽,包括了計算機斷層掃描(CT)圖像、磁共振成像(MRI)圖像、結腸鏡檢查圖像、多格式圖像、H&E 染色組織切片圖像等。

更多模型和應用:視覺及其他視覺相關首先是醫療成像。醫療圖像分割的目的是展示相應組織的解剖或病理結構,可以用于計算機輔助診斷和智能臨床手術。下圖 10 為醫療圖像 SAM 概覽,包括了計算機斷層掃描(CT)圖像、磁共振成像(MRI)圖像、結腸鏡檢查圖像、多格式圖像、H&E 染色組織切片圖像等。 其次是視頻。在計算機視覺領域,視頻目標跟蹤(VOT)和視頻分割被認為是至關重要且不可或缺的任務。VOT 涉及在視頻幀中定位特定目標,然后在整個視頻的其余部分對其進行跟蹤。因此,VOT 具有各種實際應用,例如監視和機器人技術。SAM 在 VOT 領域做出了杰出貢獻。參考文獻 [46] 中引入了跟蹤一切模型(Track Anything Model, TAM),高效地在視頻中實現了出色的交互式跟蹤和分割。下圖 11 為 TAM pipeline。結語本文首次全面回顧了計算機視覺及其他領域 SAM 基礎模型的研究進展。首先總結了基礎模型(大語言模型、大型視覺模型和多模態大模型)的發展歷史以及 SAM 的基本術語,并著重于 SAM 在各種任務和數據類型中的應用,總結和比較了 SAM 的并行工作及其后續工作。研究者還討論 SAM 在廣泛的圖像處理應用中的巨大潛力,包括軟件場景、真實世界場景和復雜場景。此外,研究者分析和總結了 SAM 在各種應用程序中的優點和局限性。這些觀察結果可以為未來開發更強大的基礎模型和進一步提升 SAM 的穩健性和泛化性提供一些洞見。文章最后總結了 SAM 在視覺和其他領域的大量其他令人驚嘆的應用。

其次是視頻。在計算機視覺領域,視頻目標跟蹤(VOT)和視頻分割被認為是至關重要且不可或缺的任務。VOT 涉及在視頻幀中定位特定目標,然后在整個視頻的其余部分對其進行跟蹤。因此,VOT 具有各種實際應用,例如監視和機器人技術。SAM 在 VOT 領域做出了杰出貢獻。參考文獻 [46] 中引入了跟蹤一切模型(Track Anything Model, TAM),高效地在視頻中實現了出色的交互式跟蹤和分割。下圖 11 為 TAM pipeline。結語本文首次全面回顧了計算機視覺及其他領域 SAM 基礎模型的研究進展。首先總結了基礎模型(大語言模型、大型視覺模型和多模態大模型)的發展歷史以及 SAM 的基本術語,并著重于 SAM 在各種任務和數據類型中的應用,總結和比較了 SAM 的并行工作及其后續工作。研究者還討論 SAM 在廣泛的圖像處理應用中的巨大潛力,包括軟件場景、真實世界場景和復雜場景。此外,研究者分析和總結了 SAM 在各種應用程序中的優點和局限性。這些觀察結果可以為未來開發更強大的基礎模型和進一步提升 SAM 的穩健性和泛化性提供一些洞見。文章最后總結了 SAM 在視覺和其他領域的大量其他令人驚嘆的應用。

———————End———————

RT-Thread線下入門培訓

7月 - 上海,南京

1.免費2.動手實驗+理論3.主辦方免費提供開發板4.自行攜帶電腦,及插線板用于筆記本電腦充電5.參與者需要有C語言、單片機(ARM Cortex-M核)基礎,請提前安裝好RT-Thread Studio 開發環境

報名通道

立即掃碼報名

(報名成功即可參加)

掃碼添加rtthread2020可參加活動可加微信拉進活動現場微信群

主辦單位

報名鏈接:https://jinshuju.net/f/UYxS2k

點擊閱讀原文,進入RT-Thread 官網

原文標題:【AI簡報20230616】英偉達推出Instinct MI300、OpenAI凌晨再給ChatGPT、GPT-4加碼!

-

RT-Thread

+關注

關注

32文章

1396瀏覽量

41781

原文標題:【AI簡報20230616】英偉達推出Instinct MI300、OpenAI凌晨再給ChatGPT、GPT-4加碼!

文章出處:【微信號:RTThread,微信公眾號:RTThread物聯網操作系統】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

擺脫依賴英偉達!OpenAI首次轉向使用谷歌芯片

OpenAI簡化大模型選擇:薩姆·奧特曼制定路線圖

OpenAI即將發布GPT-4.5與GPT-5

OpenAI即將推出GPT-5模型

AMD將DeepSeek-V3模型集成至Instinct MI300X GPU

消息稱AMD Instinct MI400 AI加速器將配備8個計算芯片

AMD集成DeepSeek-V3模型至Instinct MI300X GPU

OpenAI將發布更智能GPT模型及AI智能體工具

英偉達GB300 AI服務器訂單配置初定

IBM與AMD攜手將在IBM云上部署AMD Instinct MI300X加速器

OpenAI調整硬件戰略:2026年起將自研AI芯片

解鎖 GPT-4o!2024 ChatGPT Plus 代升級全攻略(附國內支付方法)

Llama 3 與 GPT-4 比較

三星首度引入AMD MI300X,緩解AI GPU短缺

OpenAI 推出 GPT-4o mini 取代GPT 3.5 性能超越GPT 4 而且更快 API KEY更便宜

【AI簡報20230616】英偉達推出Instinct MI300、OpenAI凌晨再給ChatGPT、GPT-4加碼!

【AI簡報20230616】英偉達推出Instinct MI300、OpenAI凌晨再給ChatGPT、GPT-4加碼!

評論