最近,ChatGPT熱潮席卷全球。

ChatGPT(Chat Generative Pre-trained Transformer)是由OpenAI于2022年12月推出的對話AI模型,僅發(fā)布2個月便實現(xiàn)月活突破1億,成為歷史上用戶增長最快的消費級應(yīng)用之一。

ChatGPT火出圈背后是“人類反饋強化模型”的應(yīng)用。在問答模式的基礎(chǔ)上,ChatGPT可以進行推理、編寫代碼、文本創(chuàng)作等等,這樣的特殊優(yōu)勢和用戶體驗使得應(yīng)用場景流量大幅增加。

隨著ChatGPT用戶數(shù)快速增長,需求量火爆引發(fā)宕機。在龐大用戶群涌入的情況下,ChatGPT服務(wù)器2天宕機5次,火爆程度引人注目的同時也催生了對算力基礎(chǔ)設(shè)施建設(shè)更高的要求,特別是底層芯片。那么,ChatGPT將帶動哪些芯片的需求?

AI服務(wù)器需求激增

當前,ChatGPT在問答模式的基礎(chǔ)上進行推理、編寫代碼、文本創(chuàng)作等,用戶人數(shù)及使用次數(shù)均提升,同時在一些新應(yīng)用場景也產(chǎn)生了較大的流量,比如智能音箱、內(nèi)容生產(chǎn)、游戲NPC、陪伴機器人等。隨著終端用戶使用頻率提高,數(shù)據(jù)流量暴漲,對服務(wù)器的數(shù)據(jù)處理能力、可靠性及安全性等要求相應(yīng)提升。

從技術(shù)原理來看,ChatGPT基于Transformer技術(shù),隨著模型不斷迭代,層數(shù)也越來越多,對算力的需求也就越來越大。從運行條件來看,ChatGPT完美運行的三個條件:訓(xùn)練數(shù)據(jù)+模型算法+算力,需要在基礎(chǔ)模型上進行大規(guī)模預(yù)訓(xùn)練,存儲知識的能力來源于1750億參數(shù),需要大量算力。

資料顯示,ChatGPT是基于GPT-3.5優(yōu)化的一個模型,GPT-3.5是GPT-3.0的微調(diào)版本。OpenAI的GPT-3.0模型存儲知識的能力來源于1750億參數(shù),單次訓(xùn)練費用約460萬美元,GPT-3.5在微軟AzureAI超算基礎(chǔ)設(shè)施上進行訓(xùn)練,總算力消耗約3640PF-days(即假如每秒計算一千萬億次,需要計算3640天)。

可以說,ChatGPT拉動了芯片產(chǎn)業(yè)量價齊升,即不僅對人工智能底層芯片數(shù)量產(chǎn)生了更大的需求,而且對底層芯片算力也提出了更高的要求,即拉動了高端芯片的需求。據(jù)悉,采購一片英偉達頂級GPU成本為8萬元,GPU服務(wù)器成本通常超過40萬元。支撐ChatGPT的算力基礎(chǔ)設(shè)施至少需要上萬顆英偉達GPU A100,高端芯片需求的快速增加會進一步拉高芯片均價。

隨著ChatGPT流量激增,作為算力載體的AI服務(wù)器將迎來重要發(fā)展機遇。預(yù)計,全球AI服務(wù)器市場將從2020年的122億美元成長到2025年288億美元,年復(fù)合增長率達到18.8%。

這些芯片將受益

從芯片構(gòu)成來看,AI服務(wù)器主要是CPU+加速芯片,通常搭載GPU、FPGA、ASIC等加速芯片,利用CPU與加速芯片的組合可以滿足高吞吐量互聯(lián)的需求。

1.CPU

作為計算機系統(tǒng)的運算和控制核心,是信息處理、程序運行的最終執(zhí)行單元。其優(yōu)勢在于有大量的緩存和復(fù)雜的邏輯控制單元,擅長邏輯控制、串行的運算;劣勢在于計算量較小,且不擅長復(fù)雜算法運算和處理并行重復(fù)的操作。因此,CPU在深度學(xué)習(xí)中可用于推理/預(yù)測。

目前,服務(wù)器CPU向多核心發(fā)展,滿足處理能力和速度提升需要,比如AMD EPYC 9004核心數(shù)量最多可達96個。不過,系統(tǒng)性能優(yōu)劣不能只考慮CPU核心數(shù)量,還要考慮操作系統(tǒng)、調(diào)度算法、應(yīng)用和驅(qū)動程序等。

2.GPU

GPU高度適配AI模型構(gòu)建,由于具備并行計算能力,可兼容訓(xùn)練和推理,目前GPU被廣泛應(yīng)用于加速芯片。以英偉達A100為例,在訓(xùn)練過程中,GPU幫助高速解決問題:2048個A100 GPU可在一分鐘內(nèi)成規(guī)模地處理 BERT之類的訓(xùn)練工作負載。在推理過程中,多實例GPU (MIG)技術(shù)允許多個網(wǎng)絡(luò)同時基于單個A100運行,從而優(yōu)化計算資源的利用率。在A100其他推理性能增益的基礎(chǔ)之上,僅結(jié)構(gòu)稀疏支持一項就能帶來高達兩倍的性能提升。在BERT等先進的對話式AI模型上,A100可將推理吞吐量提升到高達CPU的249倍。

目前,ChatGPT引發(fā)了GPU應(yīng)用熱潮。其中,百度即將推出文心一言(ERNIE Bot)。蘋果則引入AI加速器設(shè)計的M2系列芯片(M2 pro和M2 max)將被搭載于新款電腦。隨著ChatGPT的使用量激增,OpenAI需要更強的計算能力來響應(yīng)百萬級別的用戶需求,因此增加了對英偉達GPU的需求。

AMD計劃推出與蘋果M2系列芯片競爭的臺積電4nm工藝“Phoenix”系列芯片,以及使用Chiplet工藝設(shè)計的“Alveo V70”AI芯片。這兩款芯片均計劃在今年推向市場,分別面向消費電子市場以及AI推理領(lǐng)域。

3.FPGA

FPGA具有可編程靈活性高、開發(fā)周期短、現(xiàn)場可重編功能、低延時、方便并行計算等特點,可通過深度學(xué)習(xí)+分布集群數(shù)據(jù)傳輸賦能大模型。

4.ASIC

ASIC在批量生產(chǎn)時與通用集成電路相比具有體積更小、功耗更低、可靠性提高、性能提高、保密性增強、成本降低等優(yōu)點,可進一步優(yōu)化性能與功耗。隨著機器學(xué)習(xí)、邊緣計算、自動駕駛的發(fā)展,大量數(shù)據(jù)處理任務(wù)的產(chǎn)生,對于芯片計算效率、計算能力和計能耗比的要求也越來越高,ASIC通過與CPU結(jié)合的方式被廣泛關(guān)注,國內(nèi)外龍頭廠商紛紛布局迎戰(zhàn)AI時代的到來。

其中,谷歌最新的TPU v4集群被稱為Pod,包含4096個v4芯片,可提供超過1 exaflops的浮點性能。英偉達GPU+CUDA主要面向大型數(shù)據(jù)密集型HPC和AI應(yīng)用;基于Grace的系統(tǒng)與NVIDIAGPU緊密結(jié)合,性能比NVIDIADGX系統(tǒng)高出10倍。百度昆侖2代AI芯片采用全球領(lǐng)先的7nm 制程,搭載自研的第二代 XPU 架構(gòu),相比一代性能提升2-3倍;昆侖芯3代將于2024年初量產(chǎn)。

5.光模塊

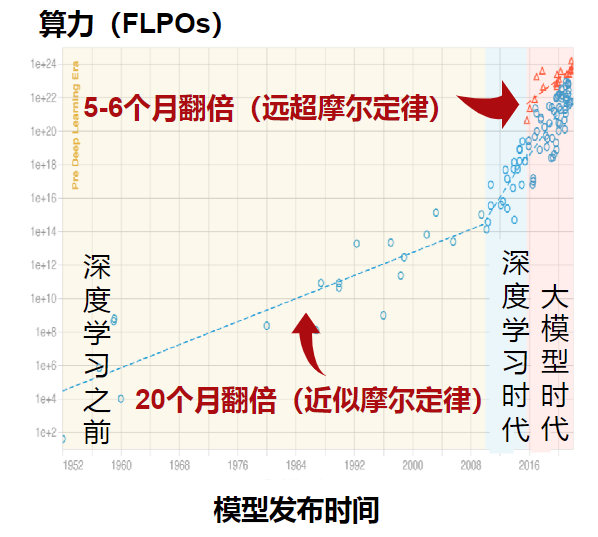

當前,AI時代模型算力需求已經(jīng)遠超摩爾定律的速度增長,特別是在深度學(xué)習(xí)、大模型時代之后,預(yù)計5-6個月翻倍。然而,數(shù)據(jù)傳輸速率成為容易被忽略的算力瓶頸。伴隨數(shù)據(jù)傳輸量的增長,光模塊作為數(shù)據(jù)中心內(nèi)設(shè)備互聯(lián)的載體,需求量隨之增長。

來源:Google Scholar

未來算力升級路徑

最近,ChatGPT的興起推動著人工智能在應(yīng)用端的蓬勃發(fā)展,這也對計算設(shè)備的運算能力提出了前所未有的需求。雖然AI芯片、GPU、CPU+FPGA等芯片已經(jīng)對現(xiàn)有模型構(gòu)成底層算力支撐,但面對未來潛在的算力指數(shù)增長,短期使用Chiplet異構(gòu)技術(shù)加速各類應(yīng)用算法落地,長期來看打造存算一體芯片(減少芯片內(nèi)外的數(shù)據(jù)搬運),或?qū)⒊蔀槲磥硭懔ι壍臐撛诜绞健?br />1. Chiplet

Chiplet是布局先進制程、加速算力升級的關(guān)鍵技術(shù)。Chiplet異構(gòu)技術(shù)不僅可以突破先進制程的封鎖,并且可以大幅提升大型芯片的良率、降低設(shè)計的復(fù)雜程度和設(shè)計成本、降低芯片制造成本。不過,雖然Chiplet技術(shù)加速了算力升級,但需要犧牲一定的體積和功耗,因此將率先在基站、服務(wù)器、智能電車等領(lǐng)域廣泛使用。

目前,Chiplet已廣泛應(yīng)用于服務(wù)器芯片。AMD是Chiplet服務(wù)器芯片的引領(lǐng)者,其基于Chiplet的第一代AMDEPYC處理器中,裝載8個“Zen”CPU核,2個DDR4內(nèi)存通道和32個PCIe通道。2022年AMD正式發(fā)布第四代EPYC處理器,擁有高達96顆5nm的Zen4核心,并使用新一代的Chiplet工藝,結(jié)合5nm和6nm工藝來降低成本。

英特爾第14代酷睿Meteor Lake首次采用intel 4工藝,首次引入Chiplet小芯片設(shè)計,預(yù)計將于2023年下半年推出,至少性能功耗比的目標要達到13代 Raptor Lake的1.5倍水平。

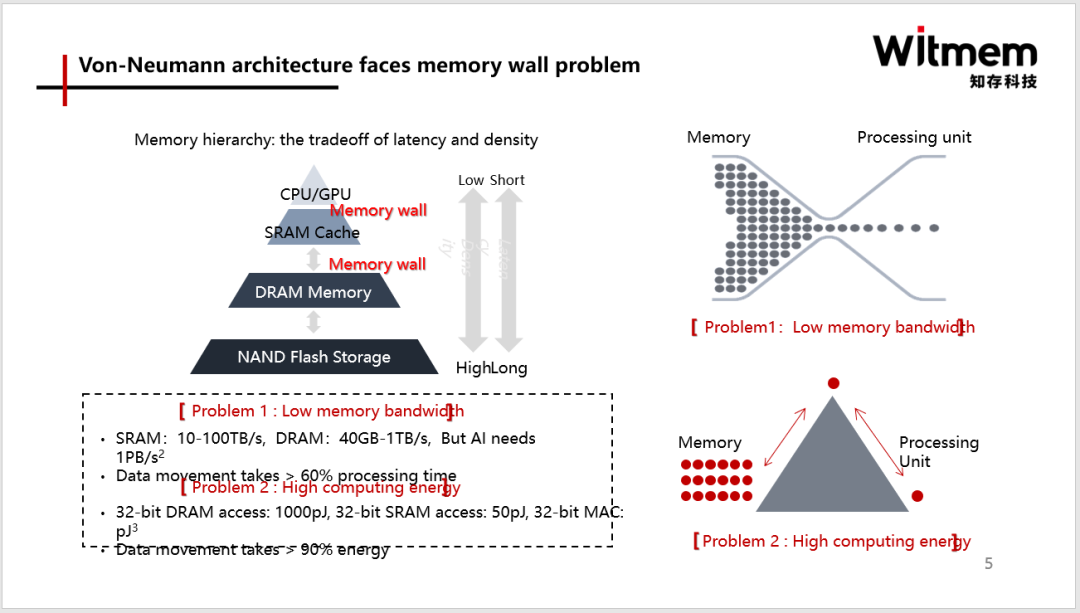

2.存算一體

正如上文提到的,AI時代模型算力需求遠超摩爾定律的速度增長,單純靠縮微化制程已經(jīng)無法滿足需求而且成本急速攀升。實際上,從現(xiàn)有芯片架構(gòu)來看,超過60%時間是花在數(shù)據(jù)搬運上,超過90%的功耗也損失在數(shù)據(jù)搬運上,能效非常低。因此,存儲墻”成為了數(shù)據(jù)計算應(yīng)用的一大障礙。而存算一體是算力需求上升的主要解決技術(shù)路線之一。

存內(nèi)計算的計算原理可以理解成是用存儲器做計算,其計算單元不再是邏輯器件、CPU、GPU或者NPU,與這些架構(gòu)是完全不一樣的。存內(nèi)計算直接運算單元是存儲單元本身。存算一體技術(shù)通過在存儲器中疊加計算能力,以新的高效運算架構(gòu)進行二維和三維矩陣運算。

以上信息由英利檢測(Teslab)原創(chuàng)發(fā)布,歡迎一起討論,我們一直在關(guān)注這方面的發(fā)展,如有引用也請注明出處。

國家高新技術(shù)企業(yè);唯一覆蓋中國和歐美運營商認證服務(wù)機構(gòu);業(yè)內(nèi)最為優(yōu)秀第三方認證服務(wù)商之一;專業(yè)的人做專業(yè)的事;

入庫:┆移動┆聯(lián)通┆電信┆中國廣電┆

歐美:┆GCF┆PTCRB┆VzW┆ATT┆TMO┆FCC┆

中國:┆CCC┆SRRC┆CTA┆

號碼:┆IMEI┆MAC┆MEID┆EAN┆

-

芯片

+關(guān)注

關(guān)注

459文章

51927瀏覽量

433734 -

AI

+關(guān)注

關(guān)注

87文章

33554瀏覽量

274218 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1584瀏覽量

8665

發(fā)布評論請先 登錄

相關(guān)推薦

ChatGPT新增實時搜索與高級語音功能

大聯(lián)大推出基于MediaTek Genio 130與ChatGPT的AI語音助理方案

蘋果iOS 18.2公測版發(fā)布,Siri與ChatGPT深度融合

OpenAI推出ChatGPT搜索功能

ChatGPT:怎樣打造智能客服體驗的重要工具?

ChatGPT熱潮席卷全球ChatGPT將帶動哪些芯片的需求?ChatGPT帶來的啟示

ChatGPT熱潮席卷全球ChatGPT將帶動哪些芯片的需求?ChatGPT帶來的啟示

評論