電子發(fā)燒友網報道(文/李彎彎)在人工智能時代,越來越多的AI應用需要從云端擴展到邊緣端,比如智能耳機、智能攝像機、智能手環(huán)、物流機器人等,在邊緣端部署AI已經成為趨勢。如今AI大模型迅猛發(fā)展,AI大模型在端側的部署也成了業(yè)界關注的焦點。

如何把AI模型在邊緣端部署

首先得軟硬件適配,硬件方面,適配的AI芯片越多越好,這樣對于工程師來說,就降低了端側模型適配遷移的難度,即使換一個設備也可以輕松部署上去;軟件方面,主要的操作系統(tǒng)需要做適配,包括Linux、Windows、Android 、iOS等,這樣無論是手機、PC都可以部署。還有框架適配,也是越全越好,比如PaddlePaddle、TensorFlow、PyTorch、Caffe、MXNet等。

其次是需要對模型進行壓縮,在保證高精度的同時,最好也能夠讓模型跑得更快更省內存,這里需要采用模型壓縮技術,比如模型量化、剪枝和蒸餾技術。尤其是如今AI大模型迅猛發(fā)展,未來大模型在端側的部署也少不了要用到壓縮技術。

可以說,模型壓縮技術是實現AI大模型在邊/端部署的核心技術。模型壓縮技術可在保有大模型原有性能和精度基本不變前提下降低對推理算力的需求。

具體來看,量化,即將浮點計算轉成低比特定點計算;網絡剪枝,即去除神經網絡中冗余的通道、神經元節(jié)點等;知識蒸餾,即將大模型作為教師模型,用其輸出訓練性能接近、結構更簡的模型。

以清華大學唐杰教授團隊2022年8月發(fā)布的1300億參數模型 GLM-130B 為例,原模型支持在一臺 A100 40G*8或 V100 32G*8 服務器上進行推理,而將模型量化至 INT 4精度后,相較INT 8精度其所需 GPU 內存降低50%,且可在一臺4×RTX 3090(24G)或 8×RTX 2080Ti (11G )服務器上進行推理。

眾多廠商實現AI大模型的端側部署

谷歌、高通、華為等廠商已經實現AI大模型在端側的部署。今年5月份,在Google/O開發(fā)者大會上,Google宣布了一個專門針對移動設備優(yōu)化系統(tǒng)的TensorFlow新版本TensorFlowLite。這款被稱為TensorFlowLite的軟件庫,是可在移動設備上運行的深度學習工具,它允許開發(fā)人員在用戶的移動設備上實時地運行人工智能應用。

該軟件庫在設計上追求高速度和小儲存,支持iOS和Android系統(tǒng)。如果開發(fā)者使用其他系統(tǒng),也可以經過一系列復雜而冗長的編譯流程,將TensorFlow編譯成移動操作系統(tǒng)所支持的軟件庫,這樣并不會改變TensorFlow的功能。

TensorFlowLite還提供了有限的預訓練人工智能模型,包括MobileNet和InceptionV3物體識別計算機模型,以及SmartReplay自然語言處理模型。開發(fā)者用自己的數據集做的定制模型也可以部署在上面。TensorFlowLite使用Android神經網絡應用程序界面(API),可以在沒有加速硬件時直接調用CPU來處理,確保其可以兼容不同設備。

高通技術公司產品管理高級副總裁兼AI負責人Ziad Asghar此前表示,隨著生成式AI的飛速普及,混合處理的重要性空前突顯。混合處理AI的重要性空前突顯,正如傳統(tǒng)計算從大型主機和瘦客戶端演變?yōu)楫斍霸贫撕瓦吘壗K端相結合的模式,AI處理必須在云端和終端混合進行才能發(fā)揮其最大潛能。

根據高通的演示,將手機設置成“飛行模式”,再通過手機端全棧AI優(yōu)化,這一模型能夠完全在終端側運行,實現在15秒內完成20步推理,生成飽含細節(jié)的圖像。很重要的是,即便在飛行模式下,這些AI能力都可以得到實現,例如將Stable Diffusion的能力集成到相機應用中之后,用戶在任何一個地點拍攝照片,再要求AI將照片背景改為夕陽之下的萬里長城。

Ziad Asghar透露,如果在云端運行一個超過10億參數的生成式AI模型,可能需要數百瓦的功耗,而在終端側運行需要的功耗僅有幾毫瓦。這賦予了高通在生成式AI領域的獨特優(yōu)勢。不久的將來,擁有 100 億或更高參數的模型將能夠在終端上運行。

在今年3月春季旗艦新品發(fā)布會上,華為帶來全新智慧搜圖功能,基于多模態(tài)大模型技術,在手機端側對模型進行小型化處理,在業(yè)界率先實現了首創(chuàng)的、精準的自然語言手機圖庫搜索體驗。用戶可以像與人對話一樣,通過語音喚醒小藝,使用自然語言在手機圖庫中搜索出匹配如 “山頂看日出”、“圍爐煮茶”、“藍色珊瑚中的小丑魚”等描述的照片。

相較于傳統(tǒng)圖庫使用標簽進行照片搜索,存在準確率低、響應速度慢等問題,智慧搜圖更加“聰明”。結合多模態(tài)大模型技術,智慧搜圖對億級的圖文數據進行預訓練,增加了對泛化通用語義的理解,支持包含顏色、形狀、物體、行為、時間和地點等多信息組合的自然語言搜索,同時還實現了端側輕量化應用。

小結

由于AI在邊緣或者端側的部署具有諸多優(yōu)勢,近年來AI在邊緣側的應用滲透率也越來越高。AI大模型迅猛發(fā)展,未來在終端的部署也是必然趨勢,眾多廠商已經對此進行探索,并有所突破,期待AI大模型未來能夠是實實在在賦能各行各業(yè)。

-

AI

+關注

關注

88文章

34781瀏覽量

277140

發(fā)布評論請先 登錄

邊緣AI實現的核心環(huán)節(jié):硬件選擇和模型部署

Deepseek海思SD3403邊緣計算AI產品系統(tǒng)

首創(chuàng)開源架構,天璣AI開發(fā)套件讓端側AI模型接入得心應手

AI大模型端側部署正當時:移遠端側AI大模型解決方案,激活場景智能新范式

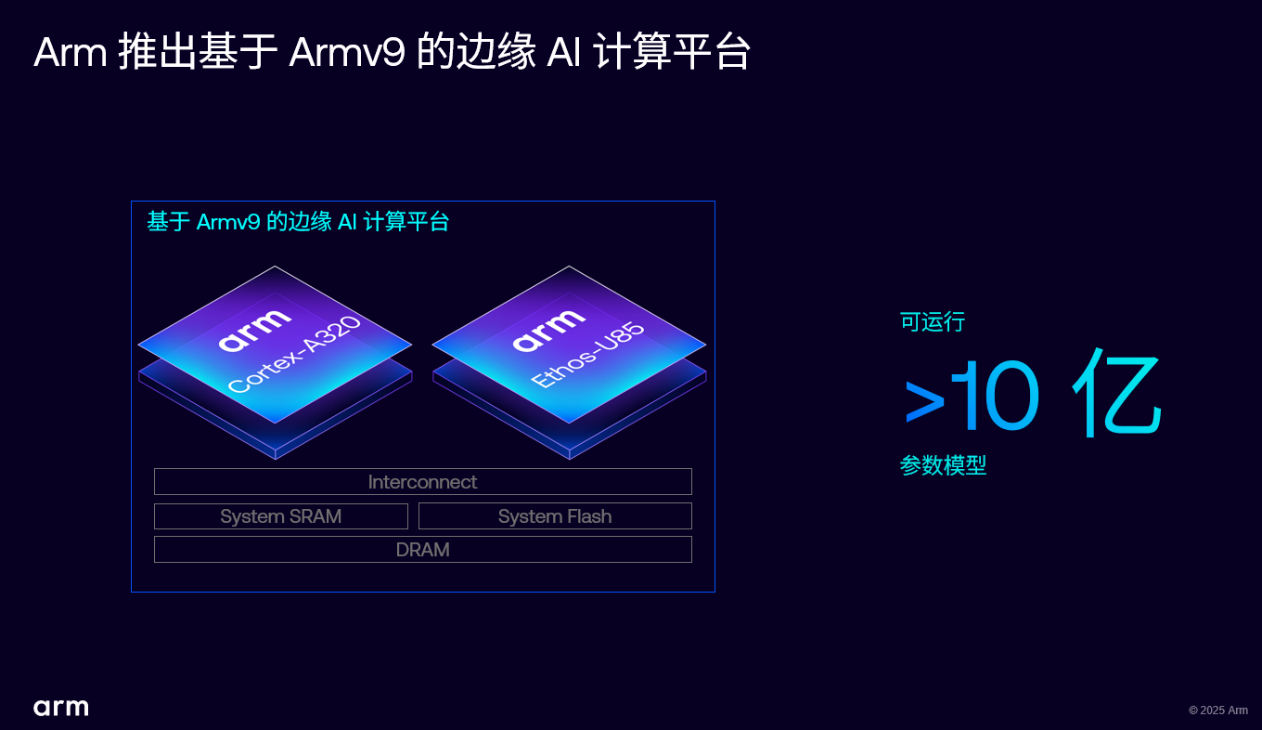

Arm 推出 Armv9 邊緣 AI 計算平臺,以超高能效與先進 AI 能力賦能物聯網革新

AI賦能邊緣網關:開啟智能時代的新藍海

研華邊緣AI Box MIC-ATL3S部署Deepseek R1模型

邊緣AI應用越來越普遍,AI模型在邊緣端如何部署?

邊緣AI應用越來越普遍,AI模型在邊緣端如何部署?

評論