隨著數據生成的不斷增加,線性性能擴展已成為橫向擴展存儲的絕對要求。存儲網絡就像汽車道路系統:如果道路不是為速度而建造的,那么汽車的潛在速度就無關緊要了。即使是法拉利在充滿障礙的非鋪裝的土路上也會很慢。

連接存儲節點的以太網網絡架構可能會阻礙橫向擴展存儲性能。NVIDIA 加速以太網可以消除性能瓶頸,從而為一般應用程序,特別是 AI/ML 實現最高的存儲性能。

橫向擴展存儲需要強大的網絡

全球每秒有 54000 張照片被拍攝。當您閱讀本文時,這一數字將會更高。無論您的業務是什么,您都有可能擁有大量需要存儲和分析的數據,而且數據量每天都在增長。

以前使用越來越大的存儲文件服務器的縱向擴展方法已被橫向擴展方法所取代,以提供在容量和性能方面線性擴展的存儲。

借助橫向擴展存儲或分布式存儲,可以配置和連接多個較小的節點,使其成為一個邏輯單元。單個文件或對象可以分布在多個節點上。

當需要更大的規模時,可以輕松添加額外的存儲節點,以提高存儲容量和性能。這既適用于傳統的企業存儲供應商解決方案,也適用于軟件和硬件獨立采購的軟件定義解決方案。

分布式存儲實現了靈活的擴展和成本效益,但需要高性能網絡來連接存儲節點。許多數據中心交換機不適合存儲的獨特流量特性,實際上可能會削弱橫向擴展存儲解決方案的性能。

存儲流量與傳統流量的區別

對于許多用例來說,網絡流量是一致且同構的,傳統以太網就足夠了。但是,存儲設備生成的流量可能會導致以下詳述問題。

01

網絡壓力

當前的存儲解決方案受益于更快的 SSD 和存儲接口,如 NVMe 和 PCIe Gen 4(即將推出 PCIe Gen 5),旨在提供更高的性能。02

擁塞

當存儲網絡架構飽和時,網絡擁塞就不可避免,就像高速公路上交通量過多時造成道路擁堵一樣。網絡擁塞對于橫向擴展存儲來說尤其成問題,因為每個存儲節點都需要提供快速的數據傳輸。但當出現擁塞時,許多數據中心交換機都存在公平問題,其中一些節點的速度會比其他節點慢得多。單個文件或對象通常分布在多個節點上,因此任何降低單個節點速度的操作都會有效地降低整個集群的速度。03

突發流量

大多數存儲工作負載都是突發的,會產生密集的數據傳輸,并在短時間內反復需要大量帶寬。當這種情況發生時,網絡交換機必須使用其緩沖區來吸收突發,直到瞬時突發結束,從而防止數據包丟失。否則,數據包丟失將需要重新傳輸數據,從而顯著降低應用程序性能。04

存儲巨型幀

傳統的數據中心網絡流量使用的最大數據包大小( MTU)為 1.5KB。當橫向擴展存儲節點可以使用 9KB 的“巨型幀”時,它們的性能會更好,這樣可以在提高吞吐量的同時降低? CPU 處理開銷。許多使用商用交換機 ASIC 構建的數據中心交換機在處理巨型幀時表現不佳或不可預測。05

低延遲

提高存儲 IOP 的方法之一是通過為基于閃存介質中的讀/寫操作實現幾個數量級延遲降低。?然而,當網絡引入高延遲時,尤其是由于過度緩沖,這些昂貴的性能改進可能會丟失。

訓練和推理都需要足夠的數據量和高速訪問,以確保 GPU 處理器足夠快地輸入數據,使其保持被充分使用。在訓練期間,所有節點都會執行寫操作,以提高模型的準確性。這導致了突發,使得交換機必須有效地處理擁塞。最后,較低的存儲延遲使 GPU 能夠更有效地處理計算任務。

為什么 ASIC 不適合存儲流量

大多數數據中心交換機都是使用商用交換機 ASIC 構建的,這些 ASIC 針對傳統的數據流量模式和數據包大小進行了成本優化。為了在實現帶寬目標的同時保持低成本,以太網交換機芯片供應商通過使用分離緩沖區架構,這犧牲了公平性。

每個交換機都有一個緩沖區,用于吸收流量突發,并在發生擁塞時防止數據包丟失。常見的方法是擁有一個跨多個端口共享的緩沖區。然而,并非所有共享緩沖區都是相同的——存在不同的緩沖區架構。

商用交換機沒有完全共享的緩沖區,而是使用入口共享緩沖區或出口共享緩沖區。

對于入口共享緩沖區,在一組傳入端口和特定內存切片之間存在靜態映射。這些端口只能使用分配切片中的內存,而不能使用整個緩沖區,即使緩沖區的其余部分可用并且沒有人在使用它。

對于出口共享緩沖區,在一組輸出端口和特定緩沖區內存切片之間進行映射。同樣,每組出口只能使用其分配的緩沖區切片,而不能使用整個緩沖區。

對于這兩種體系結構,保持在同一內存切片中的流與在內存切片之間傳輸的流存在行為的不同。如果許多流使用具有相同緩沖區的端口,那么這些端口將面臨更高的延遲和更低的吞吐量,而使用緩沖區其他切片的流量將享受更高的性能。

存儲性能取決于存儲流量(和其他流量)使用的端口以及這些端口緩沖區切片的繁忙程度。這就是為什么使用分離緩沖區的交換機經常遇到公平性、可預測性和微突發吸收相關的問題。

為什么深度緩沖區交換機

在存儲方面未得到優化

深度緩沖區交換機通常指的是提供更多緩沖區(GB 而不是 MB)的交換機。深度緩沖區交換機通常被推廣用作路由器,因為如果網絡速度不匹配或出現多對一通信情況,它們可以吸收并保持大量流量突發。

但在大多數數據中心應用程序(包括橫向擴展存儲)中,深度緩沖區交換機會對性能產生負面影響,原因如下:

01

作業完成時間

對于并行文件系統,響應速度最慢的存儲節點決定了獲取文件所需的時間。與具有切片的片上緩沖區的商用交換機 ASIC 不同,深度緩沖區交換機同時具有片上和片外緩沖區,并且它們都是切片的,而非完全共享的緩沖區。

想象一下,在流離開交換機之前,有多少種流進入交換機的方式。它們可以保持在一個片上內存切片內(速度最快),在片上內存切片間傳輸(速度較慢),或在片上和片外內存切片間傳輸(速度非常慢)。

所有這些流的行為都會有所不同,因此會導致存儲流量的公平性和可預測性問題。由于這些問題會降低一個或多個節點的速度,因此會對作業完成時間產生負面影響,并降低整個分布式存儲集群的速度。

02

延遲

交換機緩沖區越大,每個數據包必須經過的隊列就越長,延遲也就越大。深度緩沖區交換機的測試平均端口到端口延遲超過 500 微秒。與同代的完全共享緩沖區交換機相比,NVIDIA Spectrum 1 的延遲僅為 0.3 微秒。而交換/路由數據包需要的時間是納秒而不是微秒。

深度緩沖區延遲高出 1000 倍。您可能想知道,這只是發生在擁塞的時候嗎?不會。在擁塞的情況下,深度緩沖區的延遲會高得多;事實上,最高可達 20 毫秒,或高出 50000 倍。對于數據中心之間的路由器來說,500 微秒的延遲可能還可以,但在數據中心內,這意味著閃存存儲性能的不可用。

03

功率和成本

深緩沖區交換機即使在空閑時也需要數百瓦的功率才能運行,這使得其持續的運營成本更高。深度緩沖區交換機的初始購買成本也高得多。如果性能更好,這可能是合理的,但實際測試證明恰恰相反。

選擇不合適的網絡交換機會嚴重拖慢存儲工作負載,使昂貴的快速存儲變得像更便宜、更慢的存儲一樣。

借助 NVIDIA Spectrum 可以降低資本支出和運營支出。節省的電力還可以用于機架內的其他用途。

NVIDIA Spectrum 交換機

針對存儲進行了優化

使用商用交換 ASIC,流要么保持在同一個內存切片上,要么在內存切片之間流動。

借助 NVIDIA Spectrum 交換機,由于完全共享的緩沖區,所有流的行為都是相同的。這種架構的價值在于最大的突發吸收能力以及最佳的公平和可預測的性能。通過交換機的所有流都得到相同的處理,并且通常享有相同的良好性能,無論它們使用哪個入口和出口。

深度緩沖區交換機和

NVIDIA Spectrum 的基準測試

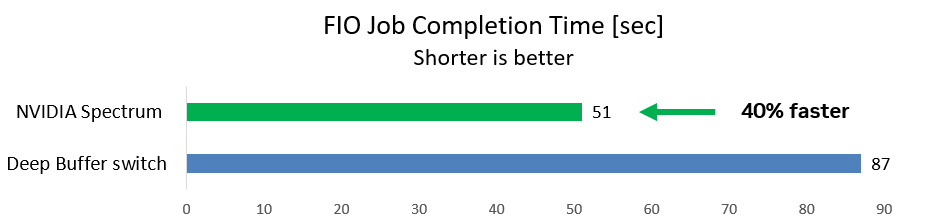

第一種情況使用一個通用的存儲基準 FIO 工具,在后臺流量運行時從兩個發起端發送到一個目標端的寫操作。這是一種典型的存儲場景。

該團隊測量了 FIO 工作完成所需的時間(越短越好)。使用深度緩沖區交換機,FIO 作業耗時 87 秒。使用 NVIDIA Spectrum 交換機,作業運行速度提高 40%,僅需 51 秒即可完成。

圖 1:與深度緩沖區交換機相比,NVIDIA Spectrum 交換機的存儲寫入操作快 40%

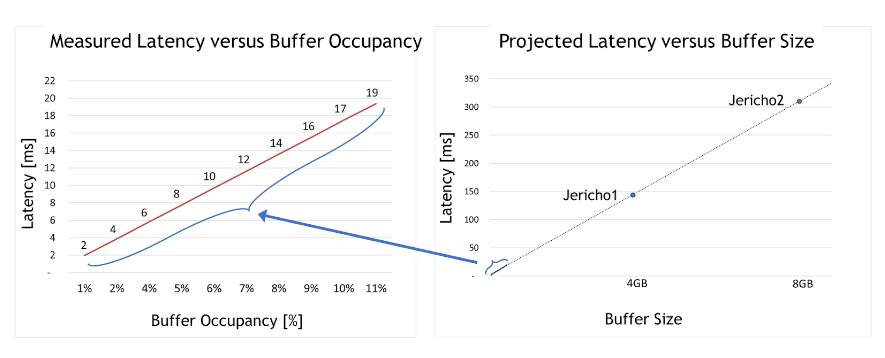

深度緩沖區交換機大大增加了延遲,從而降低了存儲速度并降低了應用程序性能。但是延遲能有多高?

對于第二種情況,該團隊采用了深度緩沖區交換機,并測試了在不同的擁塞用例下延遲是如何受到影響的。最大緩沖區占用率僅為整個緩沖區大小的 10% 左右。

圖 2:與緩沖區大小和緩沖區占用率相比的實際和預測延遲

從圖 2 左側的圖表中可以得出兩個有意義的見解。首先,深度緩沖區交換機延遲比 Spectrum 交換機高 50000 倍(2 – 19 毫秒,而 Spectrum 僅為 300 納秒)。

其次,緩沖區占用率和延遲之間存在明顯的線性相關性。換句話說,測試證明,占用的緩沖區越大,延遲就越大。

有了這一理解,圖 2 右側的圖表顯示了每個深度緩沖區 ASIC(如 Jericho 1 、Jericho 2 或 Ramon)的最大延遲。這些非常高的延遲數通常與數據中心應用程序不兼容,尤其與快速存儲解決方案不兼容。

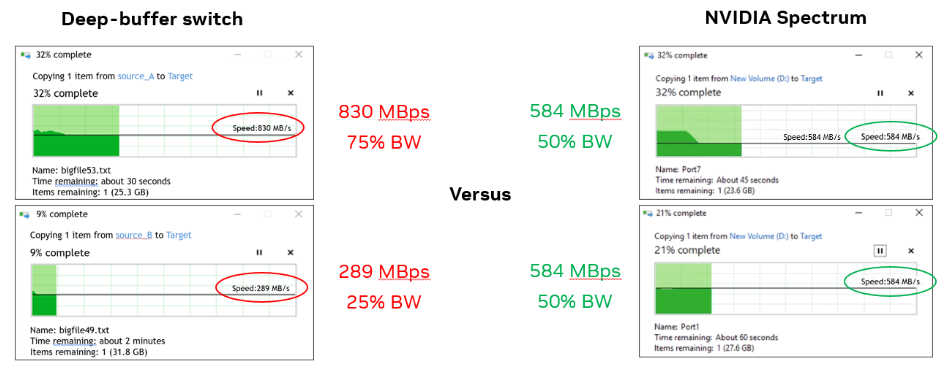

對于第三種情況,該團隊使用了兩臺 Windows 計算機,并同時將每臺計算機中的一個文件復制到同一目標存儲中。

使用深度緩沖區交換機時,一臺 Windows 計算機的帶寬是另一臺計算機的三倍( 830MBps 與 290MBps 相比)。使用 Spectrum 交換機時,每臺計算機的帶寬均為 584 MBps(如預期的 50%)。

實際測試表明,深度緩沖區交換機對數據中心應用程序(如吸收數據包和防止數據丟失)沒有積極影響。

長距離或廣域網連接可能需要深度緩沖區交換機;然而,它們對于數據中心應用程序來說不是理想選擇,并且會產生負面影響,特別是當工作負載擴展到僅兩個節點之外時,如本用例中所示。

圖 3 :深度緩沖區交換機為每個節點提供了不公平的帶寬(左圖),而 NVIDIA Spectrum 交換機提供了相等的帶寬(右圖)

這三個用例證明了為什么深度緩沖區交換機會對 AI/ML 和存儲工作負載產生不利影響,而 Spectrum 交換機則提供了最大化的性能。

總結

NVIDIA Spectrum Ethernet switches?是專為 AI/ML 和存儲工作負載而構建的,其性能優于具有分離緩沖區或深度緩沖區的交換機。它們可以更好地處理擁塞,防止數據包丟失,并且在處理巨型幀(首選存儲)方面表現出色。NVIDIA Spectrum 以太網交換機可以提供良好的應用程序性能,網絡延遲也較低。

掃描下方二維碼,查看更多有關 NVIDIA Spectrum Ethernet switches 的信息。

?

?更多精彩內容 使用 NVIDIA Spectrum-X 網絡平臺加速生成式 AI 工作負載

COMPUTEX2023 | NVIDIA 推出面向超大規模生成式 AI 的加速以太網平臺

原文標題:借助 NVIDIA Spectrum 以太網最大限度地提高存儲網絡性能

文章出處:【微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

-

英偉達

+關注

關注

22文章

3944瀏覽量

93582

原文標題:借助 NVIDIA Spectrum 以太網最大限度地提高存儲網絡性能

文章出處:【微信號:NVIDIA_China,微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

加速網絡性能:融合以太網 RDMA (RoCE) 的影響

以太網與光纖網絡的優劣比較

以太網速率對網絡性能的影響

NVIDIA SuperNIC推進現代AI基礎設施發展

NVIDIA 以太網加速 xAI 構建的全球最大 AI 超級計算機

最大限度地提高GSPS ADC中的SFDR性能:雜散源和Mitigat方法

全雙工以太網有哪些特點

以太網交換模式有哪幾種

淺析以太網的發展走勢

簡單認識NVIDIA網絡平臺

借助 NVIDIA Spectrum 以太網最大限度地提高存儲網絡性能

借助 NVIDIA Spectrum 以太網最大限度地提高存儲網絡性能

評論