論騷操作,硅谷恐怕沒有CEO能比得上黃仁勛。

去年,黃仁勛向微軟、谷歌和亞馬遜這些云計(jì)算廠商提出了一個(gè)計(jì)劃:這些廠商都有很多搭載了英偉達(dá)GPU的服務(wù)器,由英偉達(dá)租用這些服務(wù)器,然后讓英偉達(dá)的工程師對(duì)其進(jìn)行“優(yōu)化”,再以英偉達(dá)的名義租給普通的AI企業(yè),從中賺取差價(jià)。

說簡單點(diǎn),以前微軟會(huì)直接把云服務(wù)賣給中小公司,現(xiàn)在由英偉達(dá)進(jìn)來當(dāng)中間商。當(dāng)然按照英偉達(dá)官方的說法,此舉是為了“向云計(jì)算廠商展示在數(shù)據(jù)中心配置GPU的正確方法”[1]。

服務(wù)器還是那個(gè)服務(wù)器,但經(jīng)過英偉達(dá)“優(yōu)化”后,客戶就從微軟優(yōu)化到英偉達(dá)了。但就是這樣一個(gè)匪夷所思的提議,除了亞馬遜之外,各大云計(jì)算廠商居然都同意了。

2023年3月,英偉達(dá)正式上線云計(jì)算服務(wù)DGX Cloud。事實(shí)證明,經(jīng)過英偉達(dá)工程師的優(yōu)化后,DGX Cloud在訓(xùn)練大模型時(shí)表現(xiàn)得的確更好;在此基礎(chǔ)上,英偉達(dá)還破例允許短期租賃。僅僅半年時(shí)間,英偉達(dá)就拿下了軟件公司ServiceNow等大客戶。

科技公司愿意配合英偉達(dá)騷操作的真實(shí)原因,可能還是因?yàn)橛ミ_(dá)手中握有大模型時(shí)代最稀缺的資源——H100。

當(dāng)下,幾乎所有的企業(yè)都沒有足夠的算力。連OpenAI創(chuàng)始人阿爾特曼,都曾在一次聽證會(huì)上無奈地表示:“如果人們減少使用ChatGPT,我們會(huì)非常高興,因?yàn)槲覀兊腉PU非常短缺[2]。”

買了多少H100,甚至可以成為決定AI成就的關(guān)鍵因素。這也讓英偉達(dá)有了“挾H100以令諸侯”的底氣。

計(jì)算機(jī)的“稀土”

通常來說,科技企業(yè)會(huì)通過購買云計(jì)算廠商的服務(wù),來滿足算力需求。從2023年3月開始,微軟Azure、亞馬遜AWS等云計(jì)算廠商也先后上架了HGX H100的租賃服務(wù),HGX H100是由4個(gè)或8個(gè)H100組成的服務(wù)器。

然而,當(dāng)下供需嚴(yán)重失衡,云計(jì)算廠商這點(diǎn)H100存貨已經(jīng)遠(yuǎn)遠(yuǎn)滿足不了市場的胃口。2023年H1的財(cái)報(bào)中,微軟專門更新了一條風(fēng)險(xiǎn)因素:如果無法獲得足夠多的AI芯片,云計(jì)算業(yè)務(wù)可能會(huì)中斷。

許多初創(chuàng)公司需要排隊(duì)等待3-12個(gè)月,一旦友商搶在自己前面,那可能就是幾十上百億估值的損失。

無數(shù)“H100窮人”們,只能被迫發(fā)揮主觀能動(dòng)性,看誰的路子更野。

面對(duì)《紐約時(shí)報(bào)》的采訪,一位創(chuàng)業(yè)者將H100比作“稀土”。早些時(shí)候,他跑去請(qǐng)求美國國家科學(xué)基金會(huì)投資自己,僅僅因?yàn)榛饡?huì)底下一個(gè)項(xiàng)目剛好有少數(shù)空置的H100。

在硅谷,AI創(chuàng)業(yè)者打招呼的方式,都變成了“我認(rèn)識(shí)一個(gè)有H100的家伙”——不知道的還以為在買賣毒品[4]。

GPU Utils曾測算過H100搶購潮背后具體的需求數(shù)據(jù):

對(duì)需要自己訓(xùn)練大模型、追求大力出奇跡的企業(yè)來說,沒有個(gè)上萬塊H100都不好意思出門。由前DeepMind聯(lián)合創(chuàng)始人蘇萊曼創(chuàng)辦的InflectionAI,成立方才一年,已買了2.2萬個(gè)H100;至于Meta這樣財(cái)大氣粗的公司,很可能會(huì)購買10萬個(gè)甚至更多。

對(duì)微軟Azure等云計(jì)算廠商來說,每一家也都需要至少3萬個(gè)H100。而其余幾家私有云,還將消耗總計(jì)約10萬個(gè)H100。

測算后發(fā)現(xiàn),僅美國大型科技公司和少數(shù)幾家明星初創(chuàng)公司,需求量已達(dá)到約43萬個(gè)[5]。如果再算上其他初創(chuàng)企業(yè)、研究機(jī)構(gòu)、大學(xué),乃至富裕國家的追逐、再加之黃牛、黑市等不可控因素,實(shí)際需求很可能遠(yuǎn)大于這個(gè)數(shù)字。然而據(jù)英國《金融時(shí)報(bào)》爆料,今年H100的出貨量大約是55萬個(gè)[6]。

H100之所以令人如饑似渴,其中一個(gè)核心原因在于其近乎壟斷的市場地位。

面對(duì)大模型訓(xùn)練對(duì)極致效率的需求,H100在大多數(shù)情況下都是最優(yōu)解。

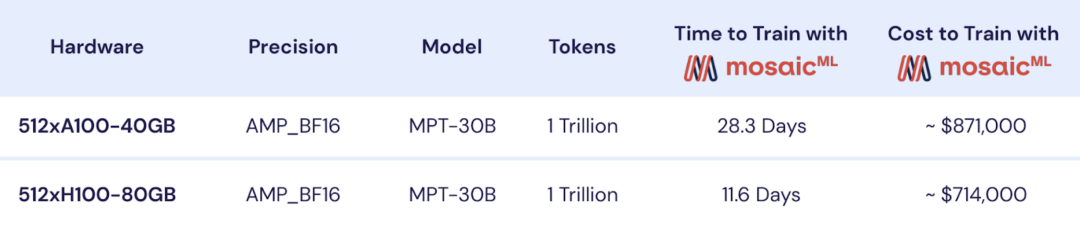

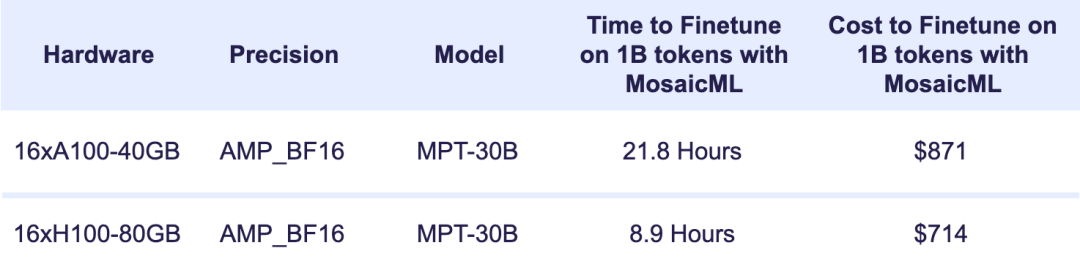

MPT-30B是第一個(gè)使用H100訓(xùn)練的開源LLM(大語言模型),實(shí)際訓(xùn)練只耗費(fèi)了11.6天;相比之下,使用前一代的A100訓(xùn)練則需要28.3天[7]。如若換成參數(shù)規(guī)模更龐大的AI,例如1800B的GPT-4,效率差異會(huì)更加明顯。跑馬圈地的時(shí)代,時(shí)間就是一切。

除此之外,H100在模型推理上的效率也遠(yuǎn)高于A100。盡管H100的首發(fā)價(jià)約為3.3萬美元,如今二手市場價(jià)格更上漲至4-5萬美元;但若將H100和A100的性能分別除以各自的價(jià)格,能發(fā)現(xiàn)H100的性價(jià)比實(shí)際也高于A100。

MPT-30B的具體訓(xùn)練、推理情況

黃仁勛說,“Buy more GPUs , the more money you save(買得多,省得多)”,似乎不無道理。

也正因?yàn)槿绱耍幢忝绹拗屏薍/A100的對(duì)華出口,國內(nèi)科技公司仍在搶購閹割版的H/A800——盡管閹割版的芯片間數(shù)據(jù)傳輸速度只有前者一半,意味著需要在大模型訓(xùn)練上花費(fèi)更多時(shí)間。

除需求量龐大之外,造成H100短缺的另一個(gè)原因是產(chǎn)能的嚴(yán)重不足。

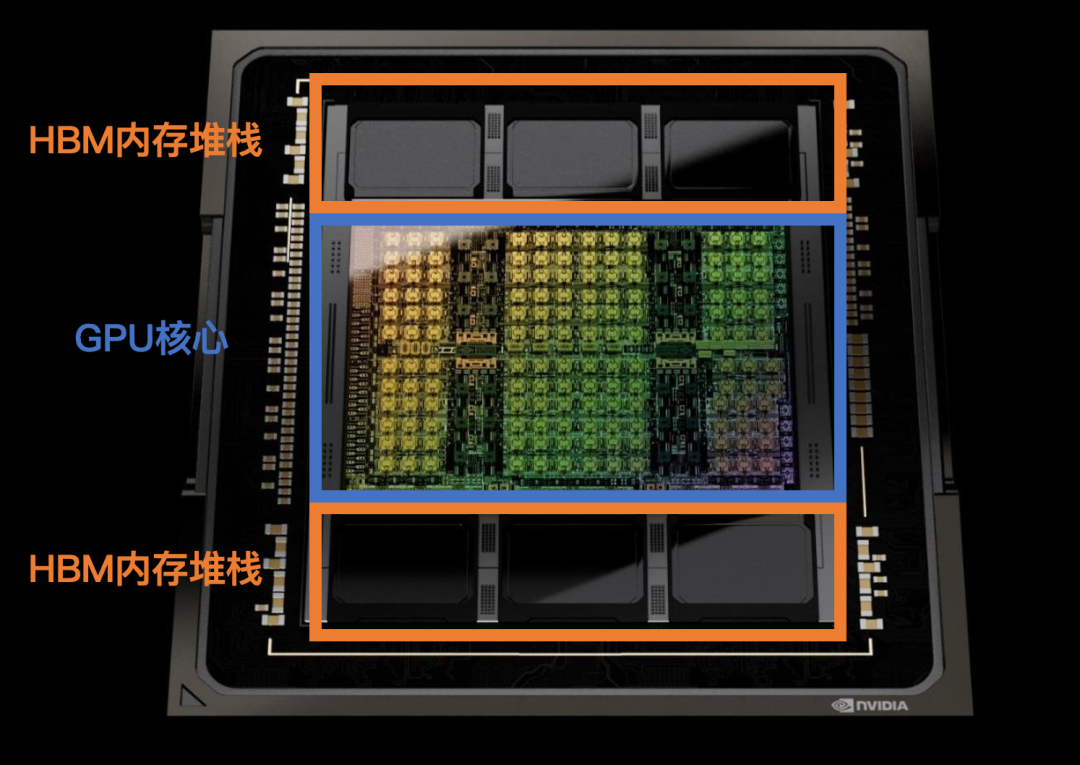

H100芯片需要使用SK海力士的HBM內(nèi)存,以及臺(tái)積電的CoWoS封裝——兩者都因過于昂貴,此前并沒能大規(guī)模市場化,預(yù)備產(chǎn)能并不多。由于產(chǎn)能爬坡尚需時(shí)間,有分析師預(yù)測H100的短缺至少會(huì)持續(xù)至明年一季度,也有人認(rèn)為要到明年年底才有可能有所緩解[9]。

H100內(nèi)部結(jié)構(gòu)

H100的空前盛況,讓黃仁勛在短短一年時(shí)間內(nèi)體驗(yàn)了一回坐過山車的感覺。

去年二季度,消費(fèi)市場萎靡不振加上挖礦企業(yè)扎堆倒閉,英偉達(dá)交出了一份不及格的財(cái)報(bào),“GPU滯銷,幫幫我們”的表情包一度遍地都是。一年之后,黃仁勛成功向資本市場展示了什么叫“反向暴雷”,同比營收暴漲854%,大幅超出了最樂觀分析師的預(yù)測。

巔峰換來了漫天的吹捧,但黃仁勛心里清楚,英偉達(dá)的頭上一直懸著一把劍。

不可避免的戰(zhàn)爭

今年8月,傳奇工程師吉姆·凱勒對(duì)媒體評(píng)論道,“我不認(rèn)為GPU是運(yùn)行AI的全部,世界憎惡壟斷[11]。”

此番發(fā)言雖有給自家AI芯片打廣告之嫌,卻也是業(yè)界的共識(shí)。

事實(shí)上,那些購買了最多H100的大型科技公司,基本都不太“安分”:微軟、谷歌、Meta,或多或少都嘗試過自研AI芯片。

這讓英偉達(dá)面臨著一個(gè)異常尷尬的處境:在AI芯片領(lǐng)域,自己與“大客戶”之間,未來幾乎必有一戰(zhàn)。

大型科技公司們選擇自研AI芯片,最初都源于一個(gè)非常質(zhì)樸的需求——省錢,其中最典型的便是谷歌。

早在2014年,谷歌已啟動(dòng)了自研芯片計(jì)劃。彼時(shí),OpenAI的首席科學(xué)家伊利亞還在谷歌工作,打造出了一套頗具顛覆性的AI模型。該模型脫胎于伊利亞的“大力出奇跡”理念,只需要灌入足夠多且正確的數(shù)據(jù),它便能更好地完成翻譯、語音識(shí)別等工作。然而待到實(shí)際應(yīng)用時(shí),谷歌卻犯了難:

如果將AI服務(wù)安裝至10億多臺(tái)安卓手機(jī)中,哪怕每個(gè)人每天只使用3分鐘,谷歌都需要2倍于當(dāng)前數(shù)據(jù)中心的算力。當(dāng)時(shí)谷歌已經(jīng)建了15個(gè)數(shù)據(jù)中心,每個(gè)造價(jià)上億美金,“超級(jí)加倍”顯然不切實(shí)際。

最終,谷歌自研出了性能更強(qiáng)、功耗更低的TPU,大大提升了單個(gè)數(shù)據(jù)中心的算力供應(yīng),以一種更經(jīng)濟(jì)實(shí)惠的方式解決了算力難題。

TPU的出現(xiàn),令黃仁勛如坐針氈,開始了“爆改GPU”,很快在性能上實(shí)現(xiàn)了反超,其最新成果便是H100。不過,H100的售價(jià)實(shí)在過于昂貴。

如果按重量售賣H100,那么其每盎司售價(jià)將達(dá)到黃金的一半;即便對(duì)地球上最賺錢的科技公司而言,這筆“英偉達(dá)稅”也堪稱天文數(shù)字。

然而,H100的實(shí)際制造成本并不高。據(jù)金融咨詢公司Raymond James測算,H100的成本約為3320美金,僅占首發(fā)價(jià)的1/10,黃仁勛含淚賺10倍[12]。

自研芯片的經(jīng)濟(jì)收益毋庸置疑,但除此之外其實(shí)還有另一個(gè)好處:垂直整合打造差異化。

堆疊算力不是簡單的往車?yán)锛悠停枰紤]軟件適配性、自身業(yè)務(wù)需求等一系列問題。例如AI所使用的深度學(xué)習(xí)框架有多個(gè)派別,谷歌是TensorFlow,Meta用的PyTorch,而百度則有PaddlePaddle,硬件需要根據(jù)不同框架做適配。

專門定制的AI芯片,可以更加緊貼自身AI業(yè)務(wù)的需求。所以Meta在今年又重啟了自研芯片計(jì)劃,針對(duì)PyTorch框架定制了全新的MTIA芯片。

對(duì)大公司來說,考量芯片的核心其實(shí)不是算力,而是“單位美元提供的算力”,也就是成本。谷歌的TPU和特斯拉的Dojo都證明了,定制服務(wù)的成本是可以接受的。

眼下,“反抗的星火”已經(jīng)點(diǎn)燃。據(jù)外媒爆料,大型科技公司的云計(jì)算團(tuán)隊(duì),已開始頻繁勸說客戶改用其自研芯片,而不是英偉達(dá)的GPU。英偉達(dá)固然是目前為止絕對(duì)的贏家,但沒人知道平衡什么時(shí)候會(huì)被打破。

不過,面對(duì)這場不可避免的戰(zhàn)爭,英偉達(dá)也留了后手。

挾H100以令諸侯

英偉達(dá)打出的第一張牌,叫CoreWeave。

CoreWeave成立于2017年,最初是一家以太坊挖礦公司,后來轉(zhuǎn)型做起了云計(jì)算業(yè)務(wù)。據(jù)CoreWeave創(chuàng)始人透露,2022年公司收入為3000萬美金,僅有微軟Azure的1/1133,在硅谷幾乎沒什么存在感。

然而到了2023年,CoreWeave突然一夜成名,接連簽下Inflection AI和Stability AI兩個(gè)大客戶,年?duì)I收預(yù)計(jì)將達(dá)到5億美金,一年翻16倍。除此之外,微軟甚至決定在未來幾年花費(fèi)數(shù)十億美金購買其服務(wù);其中僅2024年的訂單,已有20億美金。

改變CoreWeave命運(yùn)的貴人,正是英偉達(dá)。

今年4月,英偉達(dá)參與了對(duì)CoreWeave的投資;但比起美元,英偉達(dá)還給了它一項(xiàng)更稀有的資源——H100。CoreWeave是全球第一家上線HGX H100租賃服務(wù)的云計(jì)算企業(yè),比微軟Azure還要早一個(gè)月。

這番安排,其實(shí)是黃仁勛的有意為之。

H100近乎壟斷的市場地位加之嚴(yán)重短缺的現(xiàn)狀,讓英偉達(dá)手中多了一層權(quán)力:他可以自由決定優(yōu)先供貨的對(duì)象。

相比自己跟Big Tech們同床異夢的塑料友誼,CoreWeave和英偉達(dá)是實(shí)打?qū)嵉母锩鼞?zhàn)友。因此,英偉達(dá)削減了對(duì)大型科技公司的H100供應(yīng),轉(zhuǎn)而將這部分產(chǎn)能交給了CoreWeave等“自家兄弟”——它們?cè)_保不會(huì)自研芯片。

從結(jié)果來看,這一戰(zhàn)略不僅避免了囤積現(xiàn)象的出現(xiàn),也確實(shí)搶到了大型科技公司的蛋糕:

例如前文提到的Stability AI,在2022年底時(shí)一直將亞馬遜AWS視作唯一云服務(wù)商;然而到了今年3月,困于算力不足的Stability AI,悄悄叩開了CoreWeave的大門。

事實(shí)上,英偉達(dá)手中并非僅有CoreWeave一張牌。這位手握H100的投資人,還投資了同為云計(jì)算公司的Lambda Labs,以及三家從事大模型、應(yīng)用開發(fā)的明星初創(chuàng)企業(yè)。

在畝產(chǎn)十萬大模型的當(dāng)下,H100是比美元還珍貴的硬通貨,也為英偉達(dá)創(chuàng)造了一個(gè)寶貴的窗口期:盡可能讓更多公司用上H100,趁早建立起生態(tài),“把朋友搞得多多的”。

那么這個(gè)窗口期能持續(xù)多久呢?

尾聲

英偉達(dá)的一系列“騷操作”已經(jīng)引來了美國反壟斷機(jī)構(gòu)的注意,同時(shí),全球瘋搶H100的現(xiàn)狀,很可能不會(huì)長期持續(xù)下去。

正如前文所述,H100產(chǎn)能受限是因?yàn)榕_(tái)積電和SK海力士的預(yù)備產(chǎn)能不足;隨著新產(chǎn)線陸續(xù)落地,短缺狀況會(huì)逐漸得到緩解。

除此之外,旺盛的需求也未必會(huì)延續(xù)下去。

事實(shí)上,越來越多的科技公司和研究機(jī)構(gòu)都選擇將大模型開源。隨著市場上的優(yōu)質(zhì)開源模型越來越多,初創(chuàng)企業(yè)和研究機(jī)構(gòu)可以不必再自己動(dòng)手訓(xùn)練,轉(zhuǎn)而直接下載開源模型,根據(jù)自身業(yè)務(wù)需求進(jìn)行開發(fā)或者推理。

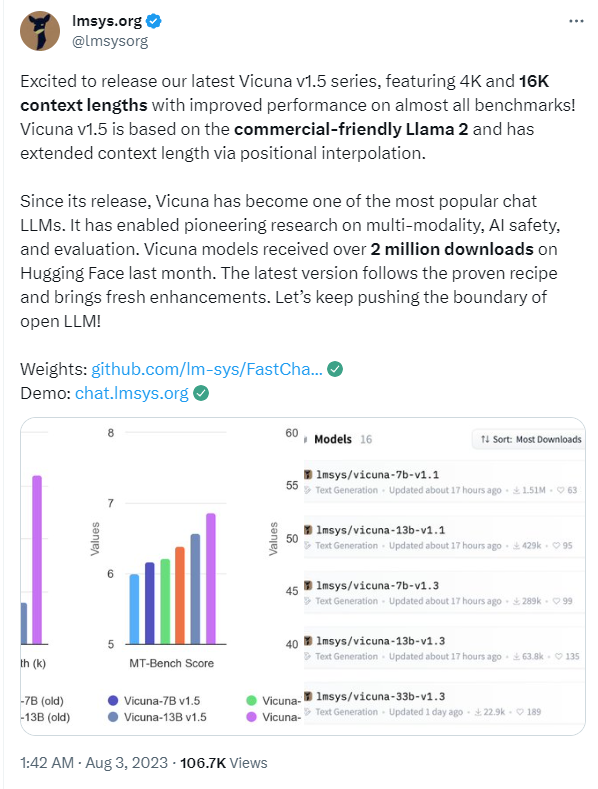

Meta發(fā)布開源大模型Llama后,斯坦福、卡內(nèi)基梅隆等多所高校的研究人員就曾聯(lián)合起來,以此為基礎(chǔ)打造了開源大模型Vicuna,很快便突破了200萬次下載。

Vicuna

在肉眼可見的未來,算力的主要使用場景很可能會(huì)從訓(xùn)練轉(zhuǎn)向推理——屆時(shí),H100便不再是獨(dú)孤求敗了。因?yàn)椴煌谧非髽O致效率的訓(xùn)練場景,AI推理其實(shí)更看重性價(jià)比。

另一方面,以大模型為代表的生成式AI如今面臨的問題在于:面對(duì)高昂的算力成本,除了英偉達(dá),大家都還沒賺到錢。

2006年CUDA平臺(tái)推出時(shí),英偉達(dá)以超脫于行業(yè)的前瞻性推動(dòng)了AI的飛速進(jìn)步。而如今,英偉達(dá)氣勢如虹的業(yè)績似乎也是一種拷問:它是不是已經(jīng)從AI的推動(dòng)者,變成了AI前進(jìn)的阻力?

-

云計(jì)算

+關(guān)注

關(guān)注

39文章

7972瀏覽量

139382 -

英偉達(dá)

+關(guān)注

關(guān)注

22文章

3922瀏覽量

93134 -

AI芯片

+關(guān)注

關(guān)注

17文章

1968瀏覽量

35696

原文標(biāo)題:英偉達(dá)的反擊:挾H100以令諸侯

文章出處:【微信號(hào):IC大家談,微信公眾號(hào):IC大家談】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

GPU 維修干貨 | 英偉達(dá) GPU H100 常見故障有哪些?

特朗普要叫停英偉達(dá)對(duì)華特供版 英偉達(dá)H20出口限制 或損失55億美元

英偉達(dá)A100和H100比較

加速拋棄英偉達(dá),微軟又發(fā)布一顆芯片 #微軟 #英偉達(dá) #半導(dǎo)體 #芯片 #電路知識(shí)

英偉達(dá)H100芯片市場降溫

亞馬遜云科技宣布Amazon EC2 P5e實(shí)例正式可用 由英偉達(dá)H200 GPU提供支持

英偉達(dá)或取消B100轉(zhuǎn)用B200A代替

英偉達(dá)TITAN AI顯卡曝光,性能狂超RTX 4090達(dá)63%!# 英偉達(dá)# 顯卡

英偉達(dá)帶領(lǐng)芯片股飆升 英偉達(dá)大漲4.76%

英偉達(dá)在AI芯片市場還能領(lǐng)先多久?

英偉達(dá)H20 AI芯片:中國市場新動(dòng)向與業(yè)績預(yù)期

英偉達(dá)H200芯片將大規(guī)模交付

馬斯克自曝訓(xùn)練Grok 3用了10萬塊NVIDIA H100

只能跑Transformer的AI芯片,卻號(hào)稱全球最快?

英偉達(dá)的反擊:挾H100以令諸侯

英偉達(dá)的反擊:挾H100以令諸侯

評(píng)論