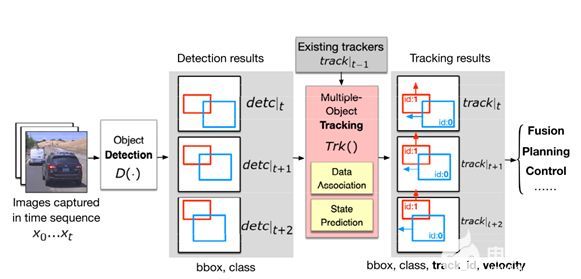

多目標(biāo)跟蹤的作用是獲取目標(biāo)在整個(gè)圖像/LiDAR序列上的完整軌跡和狀態(tài),這兩年在SLAM、導(dǎo)航、規(guī)劃任務(wù)上應(yīng)用很多。多目標(biāo)跟蹤的基本框架就是預(yù)測(cè)+關(guān)聯(lián),很多MOT使用學(xué)習(xí)方法進(jìn)行預(yù)測(cè),但是計(jì)算量很大。實(shí)時(shí)方法一般使用卡爾曼濾波進(jìn)行狀態(tài)更新,但會(huì)受限于選擇的是勻速模型還是勻加速模型。

筆者最近閱讀了IROS 2023的開(kāi)源方案Poly-MOT,來(lái)源于哈工大機(jī)器人國(guó)重實(shí)驗(yàn)室。這個(gè)方案也是基于EKF進(jìn)行更新,但是為不同目標(biāo)建立了不同的物理模型,實(shí)現(xiàn)了nuScenues上的跟蹤SOTA效果。因?yàn)闆](méi)有使用學(xué)習(xí)方案,也就不需要GPU,降低了硬件要求。

今天筆者將為大家分享這項(xiàng)工作,當(dāng)然筆者水平有限,如果有理解不當(dāng)?shù)牡胤綒g迎大家一起討論~

1、效果展示

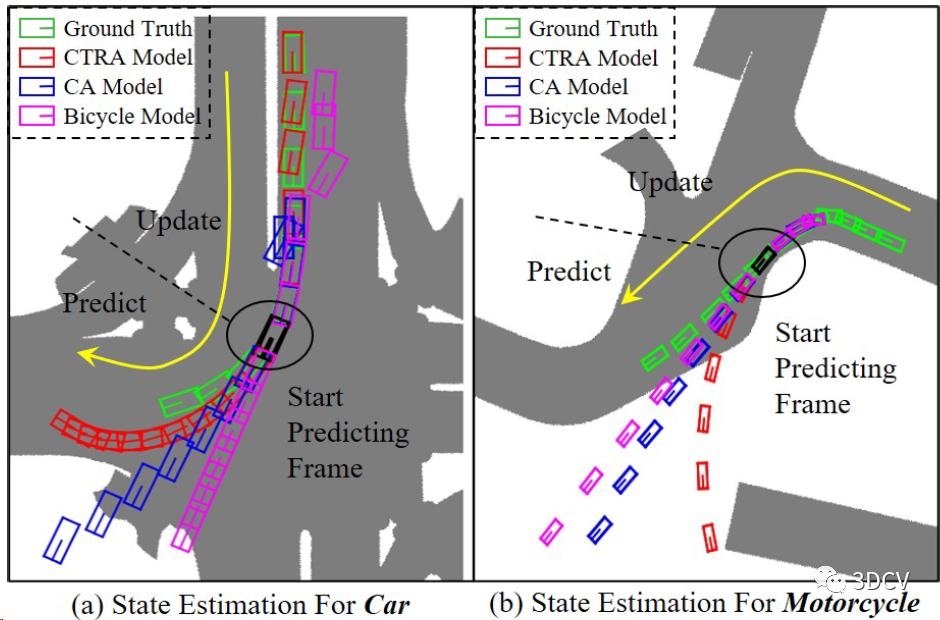

Poly-MOT跟蹤效果的直接對(duì)比,也體現(xiàn)了文章的核心思想,就是為不同類(lèi)別建立不同的運(yùn)動(dòng)模型。汽車(chē)使用他們?cè)O(shè)計(jì)的CTRA模型,摩托車(chē)使用他們?cè)O(shè)計(jì)的Bicycle模型,CA表示勻速模型。可以發(fā)現(xiàn)引入專(zhuān)用模型后的跟蹤軌跡明顯變好了。

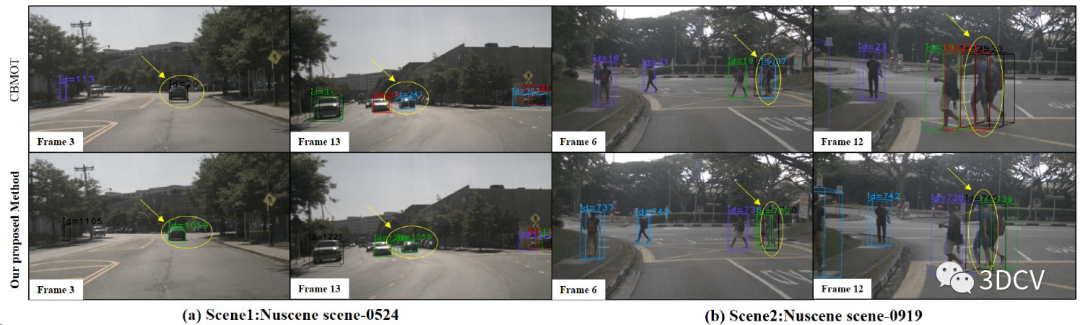

Poly-MOT和CBMOT的跟蹤性能對(duì)比,Poly-MOT對(duì)于小目標(biāo)和密集目標(biāo)的跟蹤魯棒性更高。CBMOT是2021 IROS提出的相機(jī)-雷達(dá)融合方案,同時(shí)使用了CenterPoint和CenterTrack兩個(gè)檢測(cè)器。

代碼已經(jīng)開(kāi)源了,感興趣的小伙伴可以實(shí)際運(yùn)行一下。

2、導(dǎo)讀

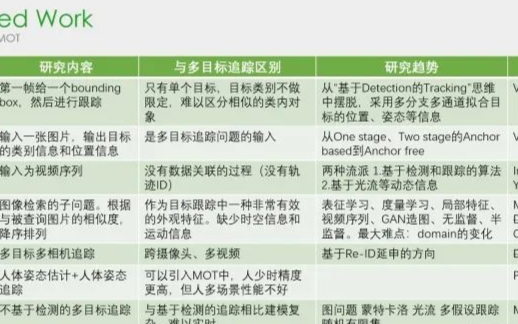

三維多目標(biāo)跟蹤(MOT)通過(guò)提供周?chē)矬w的運(yùn)動(dòng)軌跡,使移動(dòng)機(jī)器人能夠完成明智的運(yùn)動(dòng)規(guī)劃和導(dǎo)航任務(wù)。然而,現(xiàn)有的3D MOT方法通常采用單個(gè)相似性度量和物理模型來(lái)對(duì)所有對(duì)象執(zhí)行數(shù)據(jù)關(guān)聯(lián)和狀態(tài)估計(jì)。在大規(guī)模現(xiàn)代數(shù)據(jù)集和真實(shí)場(chǎng)景中,有各種各樣的對(duì)象類(lèi)別,它們通常表現(xiàn)出獨(dú)特的幾何屬性和運(yùn)動(dòng)模式。這樣,這種區(qū)分將使各種物體類(lèi)別在同一標(biāo)準(zhǔn)下表現(xiàn)不同,導(dǎo)致軌跡和探測(cè)之間的錯(cuò)誤匹配,并危及下游任務(wù)(導(dǎo)航等)的可靠性。為此,我們提出了Poly-MOT,一種基于檢測(cè)跟蹤框架的高效3D MOT方法,使跟蹤器能夠?yàn)槊總€(gè)對(duì)象類(lèi)別選擇最合適的跟蹤標(biāo)準(zhǔn)。具體來(lái)說(shuō),Poly-MOT利用各種對(duì)象類(lèi)別的不同運(yùn)動(dòng)模型來(lái)準(zhǔn)確描述不同類(lèi)型的運(yùn)動(dòng)。我們還將物體剛性結(jié)構(gòu)的約束引入到具體的運(yùn)動(dòng)模型中,以準(zhǔn)確描述物體的高度非線(xiàn)性運(yùn)動(dòng)。此外,我們引入了一個(gè)兩階段的數(shù)據(jù)關(guān)聯(lián)策略,以確保對(duì)象可以從三個(gè)自定義度量中找到其類(lèi)別的最佳相似性度量,并減少丟失的匹配。在nuScenes數(shù)據(jù)集上,我們提出的方法達(dá)到了75.4% AMOTA的最高性能。

3、算法解析

重新梳理一下問(wèn)題:

給定每幀LiDAR的3D目標(biāo)檢測(cè)結(jié)果,跟蹤多個(gè)目標(biāo)在整個(gè)序列上的軌跡和狀態(tài)。

現(xiàn)有方法是怎么做的?

現(xiàn)有框架基本就是預(yù)測(cè)+關(guān)聯(lián),基于勻速或者勻加速模型,使用卡爾曼濾波預(yù)測(cè)當(dāng)前幀目標(biāo)在下一幀的位置和狀態(tài),然后和下一幀目標(biāo)檢測(cè)結(jié)果計(jì)算IoU,如果超過(guò)閾值則認(rèn)為匹配成功,重復(fù)這個(gè)過(guò)程實(shí)現(xiàn)整個(gè)序列的關(guān)聯(lián)。

這么做有什么問(wèn)題?

現(xiàn)有方法是對(duì)所有目標(biāo)類(lèi)別都建立相同的預(yù)測(cè)和關(guān)聯(lián)模型,但顯然不同目標(biāo)的運(yùn)動(dòng)規(guī)律是不一樣的,通用模型肯定會(huì)降低精度。

如何解決?

Poly-MOT將不同目標(biāo)分為CTRA和Bicycle兩類(lèi),依據(jù)物理規(guī)律建立兩個(gè)不同的預(yù)測(cè)模型,并建立多個(gè)度量函數(shù)來(lái)進(jìn)行重復(fù)性數(shù)據(jù)關(guān)聯(lián)。

具體原理是啥?

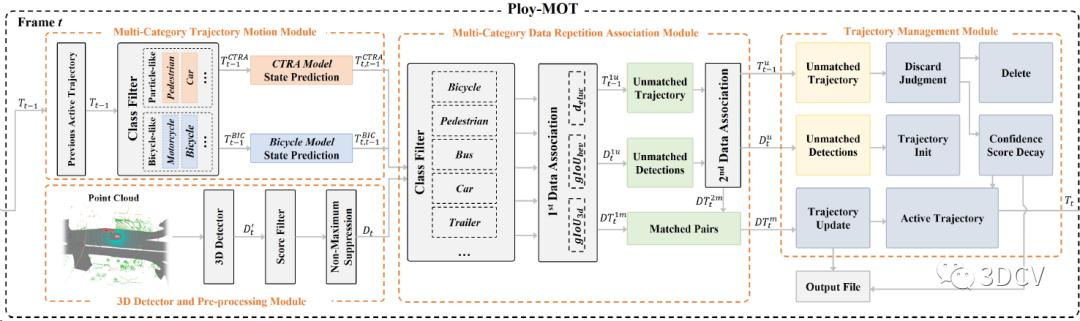

Poly-MOT的pipeline包括四個(gè)部分:預(yù)處理模塊、多類(lèi)別軌跡運(yùn)動(dòng)模塊、多類(lèi)別數(shù)據(jù)關(guān)聯(lián)模塊和軌跡管理模塊。

(1)、預(yù)處理

這部分主要是做目標(biāo)檢測(cè)的NMS,為了降低計(jì)算量在NMS之前還加了一步分?jǐn)?shù)閾值處理(SF),直接過(guò)濾掉低置信度的檢測(cè)結(jié)果。后面也證明了SF不僅可以提高速度,也可以提高精度。感覺(jué)如果能用GPU來(lái)算NMS會(huì)再快一些。

Poly-MOT主要在nuScenes上跑,因此得到的3D目標(biāo)檢測(cè)結(jié)果是[x, y, z, w, l, h, θ, vx, vy],xyz表示box中心坐標(biāo),wlh表示box的寬長(zhǎng)高,θ是航向角,vx和vy是物體速度,注意有些數(shù)據(jù)集是沒(méi)有速度真值的。

(2)、多類(lèi)別軌跡運(yùn)動(dòng)建模

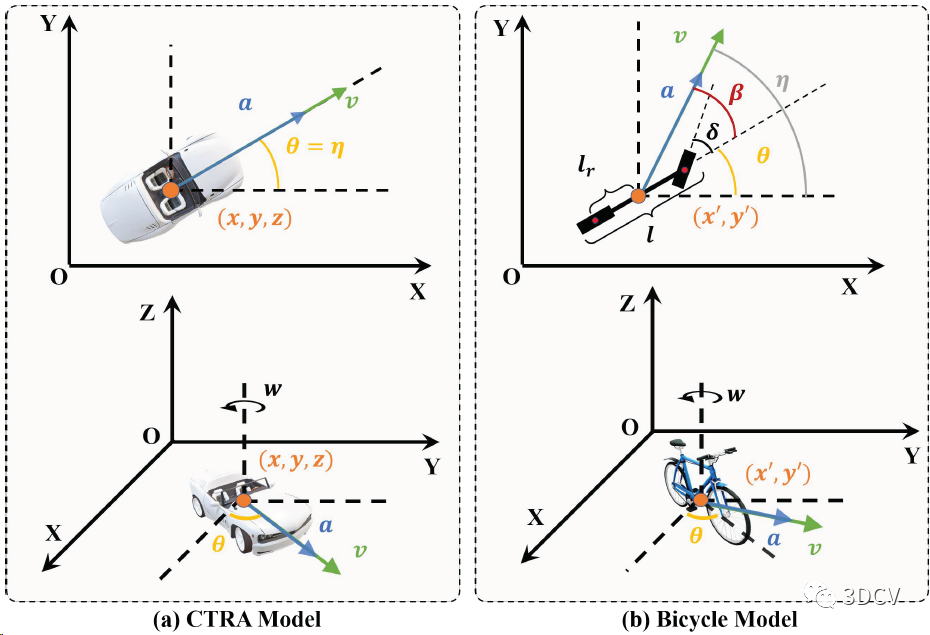

這部分是文章的主要?jiǎng)?chuàng)新點(diǎn),放棄了恒速或恒加速模型,將目標(biāo)分為CTRA和Bicycle 兩類(lèi)模型,并引入剛體結(jié)構(gòu)約束來(lái)建模目標(biāo)的非線(xiàn)性。

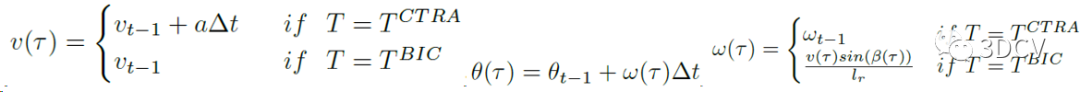

CTRA(汽車(chē)和人):角速度ω和加速度a視為常量,航向角θ、速度v和加速度a的方向共線(xiàn)。CTRA類(lèi)的目標(biāo)狀態(tài)為10維向量[x, y, z, v, a, θ, ω, w, l, h]。

Bicycle(摩托車(chē)、自行車(chē)等類(lèi)似物體):速度方向和航向角可變,轉(zhuǎn)向角和速度不變。Bicycle類(lèi)的目標(biāo)狀態(tài)也是10維向量[x′, y′, z, v, a, θ, δ, w, l, h],x′和y′表示重心坐標(biāo),δ為轉(zhuǎn)向角。注意兩類(lèi)模型都假設(shè)加速度a、坐標(biāo)z和box尺寸wlh不變。

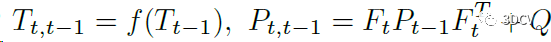

目標(biāo)狀態(tài)更新使用的是擴(kuò)展卡爾曼濾波:

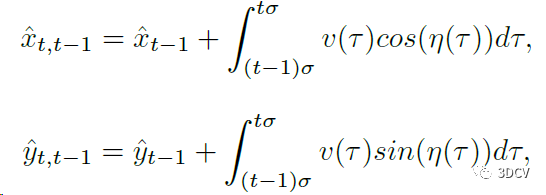

其中T表示目標(biāo)狀態(tài),P表示協(xié)方差矩陣,F(xiàn)表示雅可比矩陣,Q表示噪聲,f表示狀態(tài)轉(zhuǎn)移方程。x和y的轉(zhuǎn)移方程為:

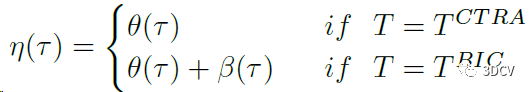

其中η表示速度和x軸的夾角,其轉(zhuǎn)移方程為:

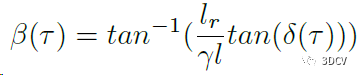

β表示速度和航向夾角,其轉(zhuǎn)移方程為:

其中γ表示物體軸距和車(chē)體長(zhǎng)度的比值,lr表示物體重心到后輪的距離,β也是CTRA和Bicycle的最主要區(qū)別,物理意義是自行車(chē)模型的瞬心不在物體主體上。

速度、航向角、角速度的轉(zhuǎn)移方程依次為:

這也就是完整的狀態(tài)更新模型。

(3)、多類(lèi)別數(shù)據(jù)關(guān)聯(lián)

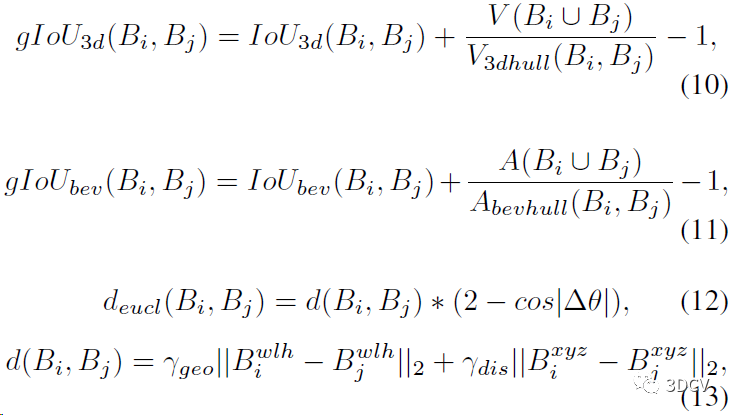

Poly-MOT數(shù)據(jù)關(guān)聯(lián)部分的核心思想是,為不同類(lèi)別設(shè)計(jì)不同的度量來(lái)降低假陽(yáng)性匹配,并設(shè)計(jì)兩階段關(guān)聯(lián)減少假陰性匹配。兩階段關(guān)聯(lián)維護(hù)了兩個(gè)大的代價(jià)矩陣,主要是為了使用不同的度量來(lái)進(jìn)行重復(fù)關(guān)聯(lián)。

B表示預(yù)測(cè)或者檢測(cè)的狀態(tài),第一級(jí)關(guān)聯(lián)包括并集上的3d廣義IoU、并集上的BEV廣義IoU以及歐氏距離:

第二級(jí)關(guān)聯(lián)是給所有類(lèi)別的目標(biāo)再計(jì)算一次BEV的gIoU。進(jìn)行兩階段匹配之后,獲得的是匹配對(duì)、當(dāng)前檢測(cè)中的未關(guān)聯(lián)目標(biāo)、當(dāng)前預(yù)測(cè)中的未關(guān)聯(lián)目標(biāo)。

(4)、軌跡管理

這部分包括軌跡更新、軌跡初始化、軌跡刪除和輸出文件,軌跡更新就是對(duì)匹配對(duì)應(yīng)用EKF更新?tīng)顟B(tài),軌跡初始化就是連續(xù)跟蹤幀數(shù)超過(guò)閾值就認(rèn)為是活躍軌跡,同理軌跡刪除。

4、實(shí)驗(yàn)結(jié)果

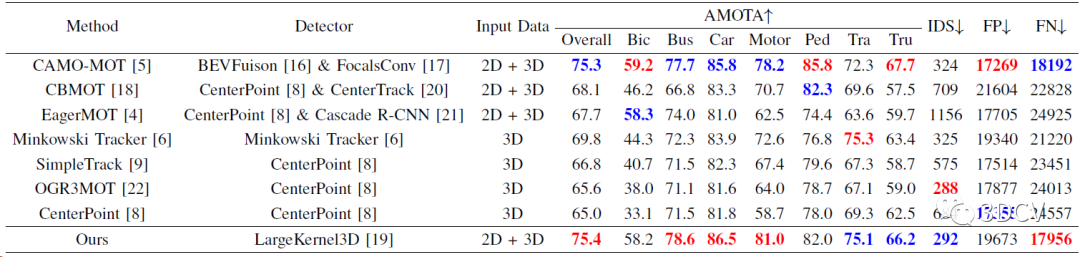

實(shí)驗(yàn)是在nuScenes數(shù)據(jù)集進(jìn)行,主要使用AMOTA來(lái)評(píng)估。Poly-MOT運(yùn)行設(shè)備是Intel 9940X,沒(méi)有使用深度學(xué)習(xí)也就不需要GPU。運(yùn)行速度是3 FPS,看起來(lái)不快,如果能設(shè)計(jì)CUDA加速在GPU上應(yīng)該會(huì)跑的很快,而且已經(jīng)超過(guò)了同類(lèi)方案SimpleTrack(0.51 FPS)、Minkowski Tracker(1.7 FPS)。

在nuScenes測(cè)試集上的定量對(duì)比結(jié)果,截止今天,還是以75.4%的性能實(shí)現(xiàn)了nuScenes多目標(biāo)跟蹤的第一!注意Poly-MOT只使用了LiDAR數(shù)據(jù),而第二的CAMO-MOT是多模態(tài)的MOT方案。

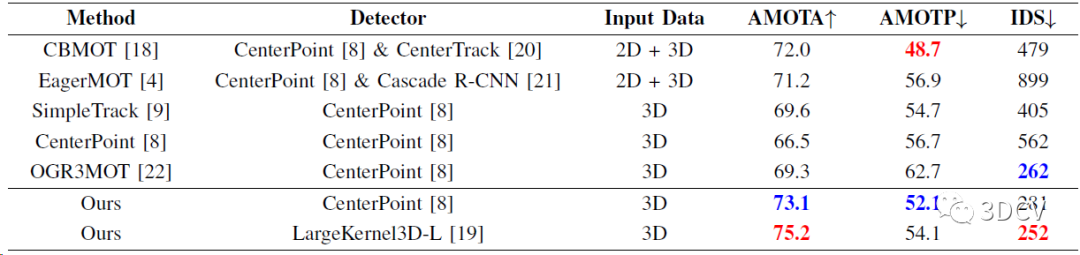

在nuScenes測(cè)試集上的定量對(duì)比結(jié)果,同樣實(shí)現(xiàn)SOTA。

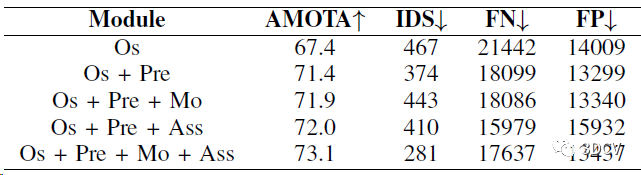

Pipeline各部分的消融實(shí)驗(yàn),Os是原始狀態(tài),Pre是預(yù)處理模塊,Mo是軌跡運(yùn)動(dòng)模塊,Ass是數(shù)據(jù)關(guān)聯(lián)模塊。特別注意Os和Os+Pre之間的差距,說(shuō)明預(yù)處理模塊很重要。

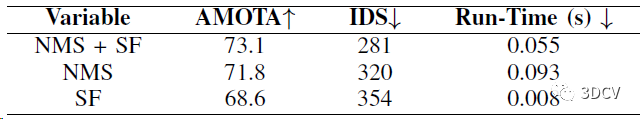

預(yù)處理模塊中閾值處理和NMS的消融實(shí)驗(yàn),驗(yàn)證預(yù)處理模塊不僅可以提高精度,還可以提高運(yùn)行速度,因?yàn)榈椭眯哦鹊腷ox都被濾掉了。

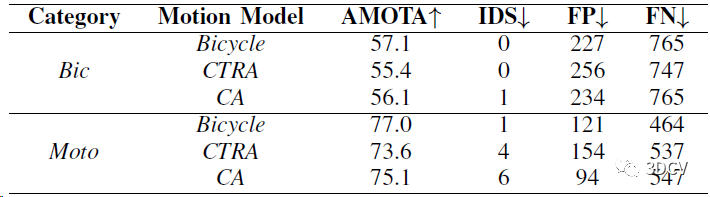

最后一個(gè)消融實(shí)驗(yàn),驗(yàn)證對(duì)于不同目標(biāo),建模合適的運(yùn)動(dòng)規(guī)律可以很大程度提高跟蹤性能。不知道為啥兩個(gè)測(cè)試對(duì)象都是Bicycle類(lèi)。

5、總結(jié)

今天筆者為大家分享了Poly-MOT跟蹤方案,不需要GPU就可以實(shí)現(xiàn)SOTA精度,文章寫(xiě)得很好,各種實(shí)驗(yàn)做得也很全。更有意義的是提出了一種新的設(shè)計(jì)思想,而不是單純的堆砌模塊。感興趣的小伙伴可以運(yùn)行一下代碼~

-

模塊

+關(guān)注

關(guān)注

7文章

2788瀏覽量

50421 -

目標(biāo)檢測(cè)

+關(guān)注

關(guān)注

0文章

225瀏覽量

16023 -

卡爾曼濾波

+關(guān)注

關(guān)注

3文章

166瀏覽量

25083

原文標(biāo)題:IROS'23開(kāi)源,nuScenes跟蹤第一!無(wú)需學(xué)習(xí)的超強(qiáng)多目標(biāo)跟蹤!

文章出處:【微信號(hào):3D視覺(jué)工坊,微信公眾號(hào):3D視覺(jué)工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

視頻跟蹤目標(biāo)跟蹤算法簡(jiǎn)介(上海凱視力成信息科技有限...

基于聚類(lèi)融合的多目標(biāo)跟蹤算法

無(wú)人機(jī)編隊(duì)視頻序列中的多目標(biāo)精確跟蹤

多傳感器多目標(biāo)跟蹤中的數(shù)據(jù)關(guān)聯(lián)

多傳感器多目標(biāo)跟蹤的JPDA算法

基于傳感器網(wǎng)絡(luò)的多目標(biāo)跟蹤和特征管理方法

改進(jìn)霍夫森林框架的多目標(biāo)跟蹤算法

深度學(xué)習(xí):多目標(biāo)跟蹤方向調(diào)研報(bào)告

新技術(shù)可有效地使用目標(biāo)檢測(cè)的對(duì)抗示例欺騙多目標(biāo)跟蹤

多目標(biāo)跟蹤過(guò)程中的數(shù)據(jù)關(guān)聯(lián)技術(shù)綜述

基于卷積特征的多伯努利視頻多目標(biāo)跟蹤算法

視頻目標(biāo)跟蹤分析

最常見(jiàn)的目標(biāo)跟蹤算法

基于MobileNet的多目標(biāo)跟蹤深度學(xué)習(xí)算法

多目標(biāo)跟蹤算法總結(jié)歸納

IROS'23開(kāi)源,nuScenes跟蹤第一!無(wú)需學(xué)習(xí)的超強(qiáng)多目標(biāo)跟蹤!

IROS'23開(kāi)源,nuScenes跟蹤第一!無(wú)需學(xué)習(xí)的超強(qiáng)多目標(biāo)跟蹤!

評(píng)論