作者 / 技術與社會部 Anoop Sinha 以及 Google Research、Responsible AI 和以人為本技術團隊 Marian Croak

標準基準是衡量重要產品質量的公認方法,存在于許多領域。一些標準基準用于衡量安全性:例如,當汽車制造商宣傳 "整體安全評分五星" 時,會引用某項基準。機器學習 (ML) 和 AI 技術領域已經存在標準基準:例如,MLCommons Association 運用 MLPerf 基準,來衡量如 Google 的 TPU 等尖端 AI 硬件的速度。然而,盡管圍繞 AI 安全已經做了大量工作,目前仍然沒有類似的 AI 安全標準基準。

MLCommons

https://mlcommons.org/en/

MLPerf

https://mlcommons.org/en/news/mlperf-inference-storage-q323/

AI 安全

https://blog.google/technology/ai/our-responsible-approach-to-building-guardrails-for-generative-ai/

我們很高興能夠為非營利組織 MLCommons Association 開展標準 AI 安全基準制定的工作提供支持。制定有效且值得信賴的基準,不僅要有先進的 AI 安全測試技術,還需要綜合廣泛的觀點。MLCommons 的工作旨在匯集學術界和業界的專家研究人員來制定衡量 AI 系統安全性的標準基準,并以每個人都能理解的分數呈現。我們鼓勵社區的所有成員 (從 AI 研究人員到政策專家)加入我們,為這項工作奉獻自己的力量。

加入我們

https://mlcommons.org/ai-safety

改善健康診斷 https://blog.google/technology/health/how-ai-can-improve-health-for-everyone-everywhere/ 能源使用情況 https://blog.google/outreach-initiatives/sustainability/google-transportation-energy-emissions-reduction/

在計算機硬件領域,基準 (如 SPEC、TPC) 現已展現出驚人的能力,讓整個行業能夠在追求進步的過程中,保持研究、工程甚至營銷部門的步調一致。我們相信,標準 AI 安全基準有助于在這一重要領域實現同樣的目標。

SPEC https://en.wikipedia.org/wiki/Standard_Performance_Evaluation_Corporation TPC https://en.wikipedia.org/wiki/Transaction_Processing_Performance_Council

在學術研究和企業工作中,人們開展了一系列 AI 安全測試 (如 RealToxicityPrompts、Stanford HELM 公平性、偏差、毒性測量以及 Google 的生成式 AI 指引)。但是,大多數測試都側重于為 AI 系統提供提示,并對輸出進行算法評分,雖然這是一個有用的開端,但僅限于測試提示的范圍。此外,他們通常使用開放數據集進行提示和響應,而這些提示和響應可能已被 (通常是無意中) 納入訓練數據中。

RealToxicityPrompts https://arxiv.org/abs/2009.11462 Stanford HELM https://crfm.stanford.edu/2022/11/17/helm.html Google 的生成式 AI 指引 https://blog.google/technology/ai/our-responsible-approach-to-building-guardrails-for-generative-ai/

負責任的 AI 開發者使用多種安全措施,包括自動測試、手動測試、紅隊測試 (red teaming,其中人類測試人員試圖產生對抗性結果)、軟件方面的限制、數據和模型最佳實踐以及審計。但是,確定是否已采取足夠的預防措施可能具有挑戰性,尤其是在開發 AI 系統的公司群體不斷發展且具有多元化特點的情況下。標準 AI 基準能夠提供強大的工具,幫助供應商和用戶衡量 AI 安全性,以及鼓勵資源生態系統和專注于提高 AI 安全性的專業提供商,推進社區以負責任的方式發展。

同時,如果沒有社區參與,就無法制定成熟、有效且值得信賴的 AI 安全基準。這項工作需要研究人員和工程師齊心協力,為安全測試技術提供創新且實用的改進,使測試更加嚴格高效。同樣,企業也需要團結一致,提供測試數據、工程支持和經濟支持。AI 安全的某些方面可能具有主觀性,要建立得到廣泛共識支持的可信基準需要考慮多方觀點,包括公眾代言人、政策制定者、學者、工程師、數據工作者、商界領袖和企業家的觀點。

Google 以 2018 年宣布的 AI 準則為基礎,致力于以安全、可靠和值得信賴的特定標準開發和使用 AI (您可以參閱我們 2019 年、2020 年、2021 年、2022 年的更新)。我們還在關鍵承諾方面取得了重大進展,這將幫助您大膽且負責任地開發 AI,從而造福所有人。

宣布 https://blog.google/technology/ai/ai-principles/ AI 準則 https://ai.google/responsibility/principles/ 2019 年 https://ai.google/static/documents/ai-principles-2019-progress-update.pdf 2020 年 https://ai.google/static/documents/ai-principles-2020-progress-update.pdf 2021 年 https://ai.google/static/documents/ai-principles-2021-progress-update.pdf 2022 年 https://ai.google/static/documents/ai-principles-2022-progress-update.pdf 進展 https://static.googleusercontent.com/media/publicpolicy.google/en//resources/whcommitments.pdf

Google 正在以多種方式支持 MLCommons Association 在制定 AI 安全基準方面所作的工作。

測試平臺:我們聯合其他公司提供資金,支持測試平臺的開發。 技術專長和資源:我們不斷提供技術專長和資源,例如 Monk 膚色示例數據集,以幫助確保基準設計優良且有效。 數據集:我們正在為多語言表征偏差以及針對刻板印象危害 (如 SeeGULL 和 SPICE) 的外部測試提供內部數據集。此外,我們還共享以負責任和包容性的方式收集人工注釋為重點的數據集,如 DICES 和 SRP。

Monk 膚色量表示例數據集 https://skintone.google/mste-dataset SPICE https://github.com/google-research-datasets/SPICE/tree/main DICES https://arxiv.org/abs/2306.11247 SRP https://www.kaggle.com/datasets/google/jigsaw-specialized-rater-pools-dataset

我們相信,這些基準有助于推進 AI 安全研究,確保以負責任的方式開發和部署 AI 系統。AI 安全屬于集體行動問題。前沿模型論壇 (Frontier Model Forum) 和 AI 伙伴關系 (Partnership on AI) 等團體也在重要的標準化舉措方面發揮著領導作用。我們很高興從一開始便與這些團體和 MLCommons 一起開展這項工作,也期待通過更多的共同努力,來促進以負責任的方式開發新的生成式 AI 工具。歡迎您持續關注我們,及時獲悉更多資訊。

集體行動問題 https://blog.google/technology/ai/a-shared-agenda-for-responsible-ai-progress/ 前沿模型論壇 https://blog.google/outreach-initiatives/public-policy/google-microsoft-openai-anthropic-frontier-model-forum/ AI 伙伴關系 https://partnershiponai.org/

原文標題:攜手 MLCommons,制定有效且值得信賴的 AI 安全基準

文章出處:【微信公眾號:谷歌開發者】歡迎添加關注!文章轉載請注明出處。

-

谷歌

+關注

關注

27文章

6231瀏覽量

108142

原文標題:攜手 MLCommons,制定有效且值得信賴的 AI 安全基準

文章出處:【微信號:Google_Developers,微信公眾號:谷歌開發者】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

貨架傾斜監測:保障倉儲安全的關鍵

威盛電子推出天車安全AI監控方案

國芯科技與美電科技攜手推出AI傳感器模組

Banana Pi 與瑞薩電子攜手共同推動開源創新:BPI-AI2N

芯海科技BMS:讓每塊電池的安全都值得信賴

芯海科技BMS:讓每塊電池的安全都值得信賴

smart與元戎啟行攜手,共研智能駕駛AI大模型

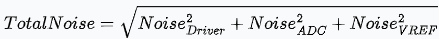

探討電壓基準噪聲對模數轉換器(ADC)的有效位數(ENOB)和無噪聲分辨率的影響

徐工汽車榮獲2025年度值得用戶信賴創新城市物流裝備鼎新獎

MLCommons推出AI基準測試0.5版

Momenta以AI技術助力交通安全建設

浪潮信息AS13000G7榮獲MLPerf? AI存儲基準測試五項性能全球第一

攜手 MLCommons,制定有效且值得信賴的 AI 安全基準

攜手 MLCommons,制定有效且值得信賴的 AI 安全基準

評論