寫(xiě)在前面&&筆者的個(gè)人理解

目前基于Transformer結(jié)構(gòu)的算法模型已經(jīng)在計(jì)算機(jī)視覺(jué)(CV)領(lǐng)域展現(xiàn)出了巨大的影響力。他們?cè)诤芏嗷A(chǔ)的計(jì)算機(jī)視覺(jué)任務(wù)上都超過(guò)了之前的卷積神經(jīng)網(wǎng)絡(luò)(CNN)算法模型,下面是筆者找到的最新的在不同基礎(chǔ)計(jì)算機(jī)視覺(jué)任務(wù)上的LeaderBoard榜單排名,通過(guò)LeaderBoard可以看到,基于Transformer算法模型在各類(lèi)計(jì)算機(jī)視覺(jué)任務(wù)上的統(tǒng)治地位。

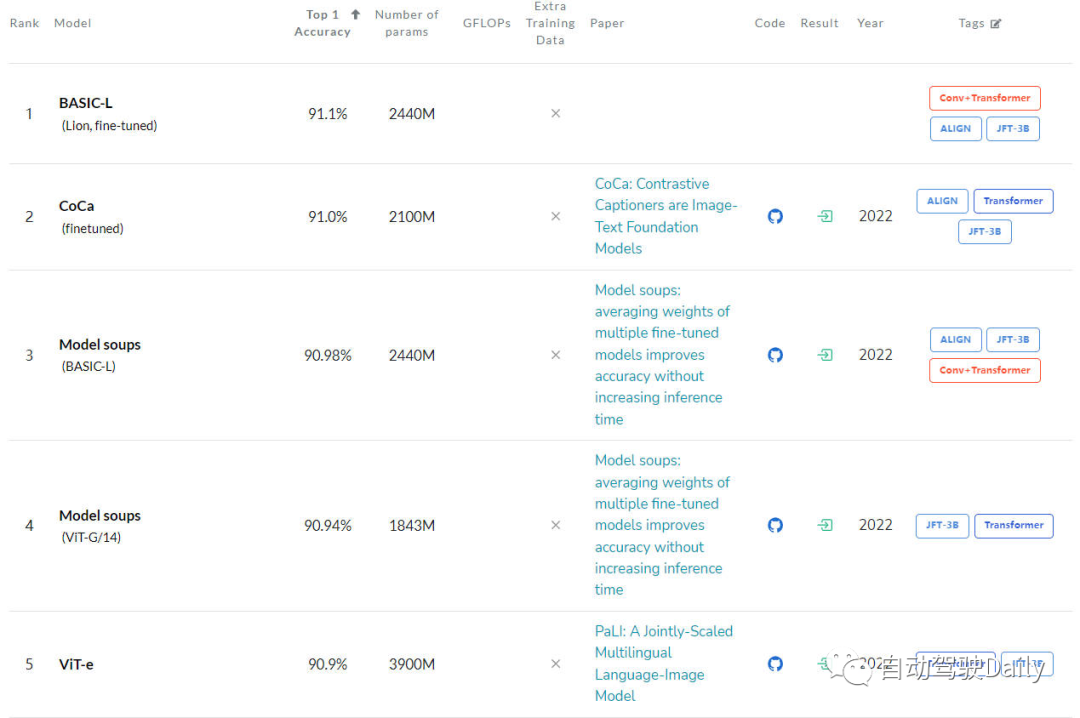

圖像分類(lèi)任務(wù)

首先是在ImageNet上的LeaderBoard,通過(guò)榜單可以看出,前五名當(dāng)中,每個(gè)模型都使用了Transformer結(jié)構(gòu),而CNN結(jié)構(gòu)只有部分使用,或者采用和Transformer相結(jié)合的方式。

圖像分類(lèi)任務(wù)的LeaderBoard

目標(biāo)檢測(cè)任務(wù)

接下來(lái)是在COCO test-dev上的LeaderBoard,通過(guò)榜單可以看出,前五名當(dāng)中,一半以上都是基于DETR這類(lèi)算法結(jié)構(gòu)進(jìn)行延伸的。

目標(biāo)檢測(cè)任務(wù)的LeaderBoard

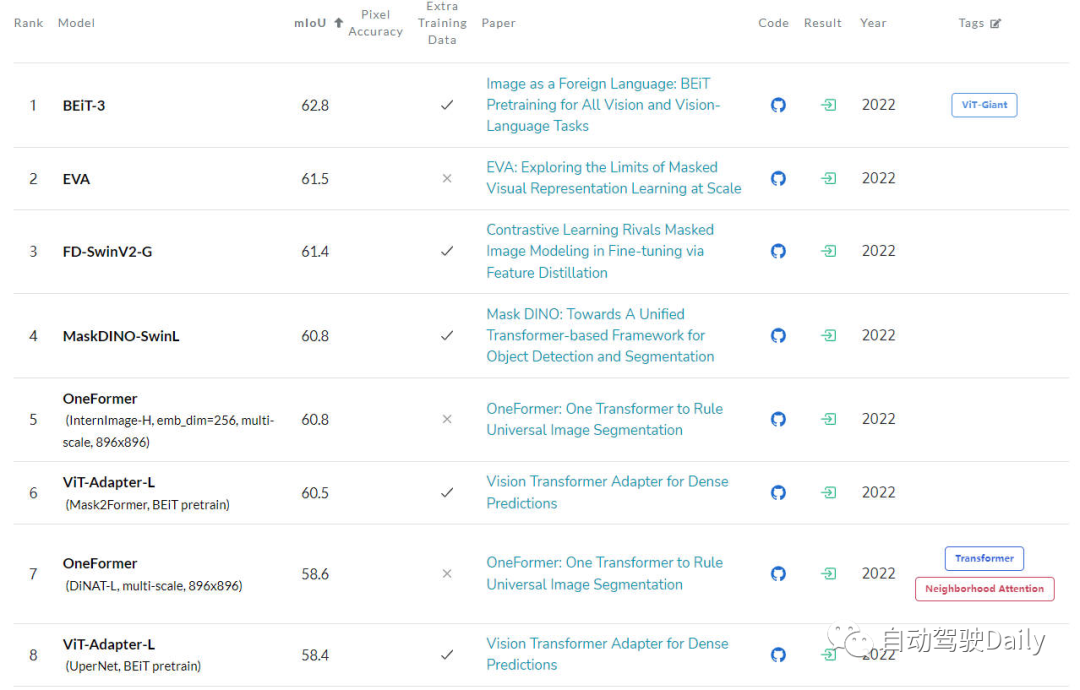

語(yǔ)義分割任務(wù)

最后是在ADE20K val上的LeaderBoard,通過(guò)榜單也可以看出,在榜單的前幾名中,Transformer結(jié)構(gòu)依舊占據(jù)是當(dāng)前的主力軍。

語(yǔ)義分割任務(wù)的LeaderBoard

雖然目前Transformer展現(xiàn)出了巨大的發(fā)展前景,但是現(xiàn)在的計(jì)算機(jī)視覺(jué)社區(qū)還并沒(méi)有完全掌握Vision Transformer的內(nèi)部工作原理,也沒(méi)有掌握其決策(輸出的預(yù)測(cè)結(jié)果)的基礎(chǔ),那對(duì)其可解釋性的需求就逐漸凸顯了出來(lái)。因?yàn)橹挥辛私饬诉@類(lèi)模型是如何做出決策的,才不僅可以提高它們的性能,還可以建立對(duì)人工智能系統(tǒng)的信任。

所以本文的主要?jiǎng)訖C(jī)就是探索Vision Transformer的不同可解釋性方法,并根據(jù)不同算法的研究動(dòng)機(jī)、結(jié)構(gòu)類(lèi)型以及應(yīng)用場(chǎng)景進(jìn)行分類(lèi),從而形成了一篇綜述文章。

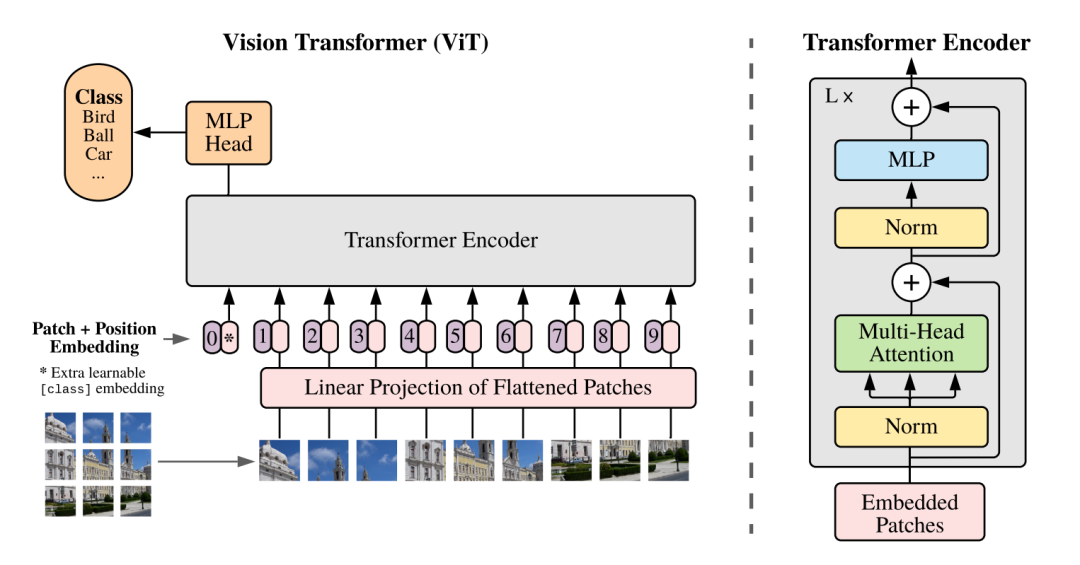

刨析Vision Transformer

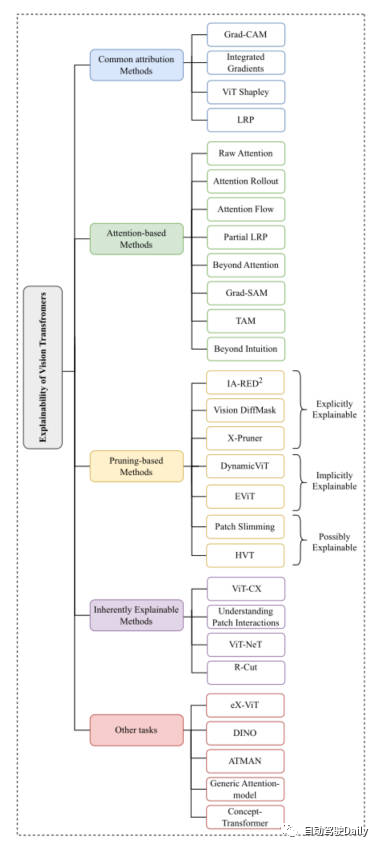

因?yàn)閯偛盘岬剑琕ision Transformer的結(jié)構(gòu)在各類(lèi)基礎(chǔ)的計(jì)算機(jī)視覺(jué)任務(wù)中都取得了非常不錯(cuò)的成績(jī)。所以之后計(jì)算機(jī)視覺(jué)社區(qū)涌現(xiàn)出了很多方法來(lái)增強(qiáng)它的可解釋性。本文我們主要以分類(lèi)任務(wù)為主線,從Common Attribution Methods、Attention-based Methods、Pruning-based Methods、Inherently Explainable Methods、Other Tasks這五個(gè)方面中,挑選出最新以及經(jīng)典的工作進(jìn)行介紹。這里放一下論文中出現(xiàn)的思維導(dǎo)圖,大家可以根據(jù)自身感興趣的內(nèi)容,進(jìn)行更加細(xì)致的閱讀~

本文思維導(dǎo)圖

Common Attribution Methods

基于屬性方法的解釋通常的出發(fā)點(diǎn)是對(duì)模型的輸入特征如何一步一步得到最終輸出結(jié)果過(guò)程的解釋。這類(lèi)方法主要用于衡量模型的預(yù)測(cè)結(jié)果和輸入特征之間的相關(guān)性。

在這些方法中,例如Grad-CAM以及Integrated Gradients算法是直接應(yīng)用于了基于視覺(jué)Transformer的算法上。一些其他的方法像SHAP和Layer-Wise Relevance Propagation(LRP)已經(jīng)被用來(lái)探索基于ViT的架構(gòu)上了。但是由于SHAP這類(lèi)方法到的計(jì)算成本非常大,所以最近的ViT Shapely算法被設(shè)計(jì)出來(lái)用于適配ViT的相關(guān)應(yīng)用研究。

Attention-based Methods

Vision Transformer正是得益于其注意力機(jī)制使其擁有了強(qiáng)大的特征提取能力。而在基于注意力的可解釋性方法中,對(duì)注意力權(quán)重結(jié)果進(jìn)行可視化則是一種非常有效的方法。本文對(duì)其中的幾種可視化技術(shù)進(jìn)行介紹

Raw Attention:該方法顧名思義,就是對(duì)網(wǎng)絡(luò)模型中間層得到的注意力權(quán)重圖進(jìn)行可視化,從而對(duì)模型的效果進(jìn)行分析。

Attention Rollout:該技術(shù)通過(guò)對(duì)網(wǎng)絡(luò)的不同層中擴(kuò)展注意力權(quán)重來(lái)跟蹤從輸入token到中間embedding之間的信息傳輸。

Attention Flow:該方法將注意力圖視為一個(gè)流量網(wǎng)絡(luò),并使用最大流量算法計(jì)算從中間embedding到輸入token的最大流量值。

partialLRP:該方法是用于可視化Vision Transformer中的多頭注意力機(jī)制提出來(lái)的,同時(shí)還考慮了每個(gè)注意力頭的重要性。

Grad-SAM:該方法用于緩解僅依靠原始注意力矩陣來(lái)解釋模型預(yù)測(cè)的局限性,促使研究人員將梯度以用于原始的注意力權(quán)重中。

Beyond Intuition:該方法也是一種用于解釋注意力的方法,包括注意力感知和推理反饋兩個(gè)階段。

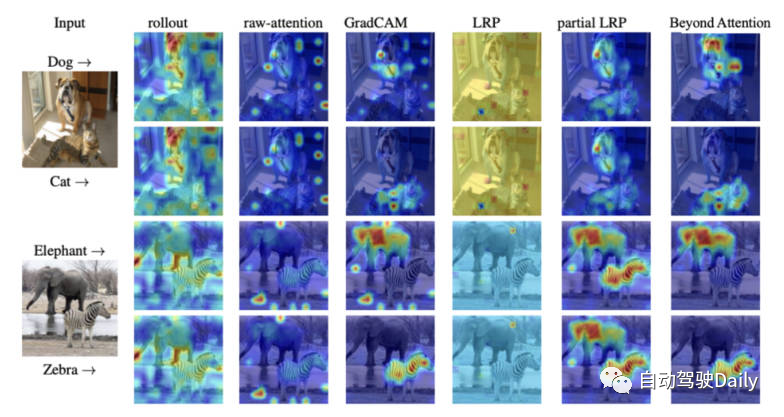

最后放一張不同可解釋性方法的注意力可視化圖,大家可以自行感受一下不同可視化方法的區(qū)別。

不同可視化方法的注意力圖對(duì)比

Pruning-based Methods

剪枝是一種非常有效的方法,被廣泛應(yīng)用于優(yōu)化transformer結(jié)構(gòu)的效率和復(fù)雜性。剪枝方法通過(guò)對(duì)冗余或者沒(méi)用的信息進(jìn)行刪減,從而降低模型的參數(shù)量和計(jì)算復(fù)雜度。雖然剪枝算法側(cè)重于提高模型的計(jì)算效率,但是該類(lèi)算法依舊可以實(shí)現(xiàn)對(duì)模型的可解釋性。

本文中針對(duì)基于Vision-Transformer的剪枝方法,大體可以分成三大類(lèi):explicitly explainable(顯式可解釋?zhuān)mplicitly explainable(隱式可解釋?zhuān)ossibly explainable(可能可解釋?zhuān)?/p>

Explicitly Explainable

在基于剪枝的方法當(dāng)中,有幾類(lèi)方法可以提供簡(jiǎn)單而且更可解釋的模型。

IA-RED^2:該方法的目標(biāo)是在算法模型的計(jì)算效率以及可解釋性之間實(shí)現(xiàn)一個(gè)最優(yōu)的平衡。并且在這個(gè)過(guò)程當(dāng)中,保持原有ViT算法模型的靈活性。

X-Pruner:該方法是一種用于剪枝顯著性單元的方法,通過(guò)創(chuàng)建一個(gè)可解釋性的感知掩碼來(lái)衡量每個(gè)可預(yù)測(cè)單元在預(yù)測(cè)特定類(lèi)中的貢獻(xiàn)。

Vision DiffMask:該剪枝方法包括在每個(gè)ViT層上加入門(mén)控機(jī)制,通過(guò)門(mén)控機(jī)制,可以實(shí)現(xiàn)在屏蔽輸入的同時(shí)保持模型的輸出。除此之外,該算法模型可以清晰地觸發(fā)剩余圖像中的子集,從而實(shí)現(xiàn)更好地對(duì)模型預(yù)測(cè)的理解。

Implicitly Explainable

基于剪枝的方法當(dāng)中,也有一些經(jīng)典的方法可以被劃分為隱式的可解釋性模型類(lèi)別中。

Dynamic ViT:該方法采用輕量級(jí)預(yù)測(cè)模塊,根據(jù)當(dāng)前的特征去估計(jì)每個(gè)token的重要性程度。然后將該輕量級(jí)的模塊加入到ViT的不同層中,以分層的方式來(lái)修剪冗余的token。最重要的是,該方法通過(guò)逐步定位對(duì)分類(lèi)貢獻(xiàn)最大的關(guān)鍵圖像部分來(lái)增強(qiáng)可解釋性。

Efficient Vision Transformer(EViT):該方法的核心思想是通過(guò)重組token的方式來(lái)加速EViT。通過(guò)計(jì)算注意力得分,EViT保留最相關(guān)的token,同時(shí)將不太相關(guān)的token融合到另外的token中。同時(shí)論文的作者為了評(píng)估EViT的可解釋性,對(duì)多個(gè)輸入圖像可視化了token的識(shí)別過(guò)程。

Possibly Explainable

雖然這類(lèi)方法最初并不是為了提高ViT的可解釋性,但是這類(lèi)方法為進(jìn)一步研究模型的可解釋性提供了很大的潛力。

Patch Slimming:通過(guò)自上而下的方法來(lái)專(zhuān)注圖像中的冗余patch來(lái)加速ViT。該算法選擇性的保留了關(guān)鍵補(bǔ)丁的能力來(lái)突出重要的視覺(jué)特征,從而增強(qiáng)可解釋性。

Hierarchical Visual Transformer(HVT):該方法的引入用于去增強(qiáng)ViT的可擴(kuò)展性和性能。隨著模型深度的增加,序列長(zhǎng)度逐漸減小。此外,通過(guò)將ViT塊劃分為多個(gè)階段,并在每個(gè)階段應(yīng)用池化操作,顯著提高了計(jì)算效率。考慮到對(duì)模型最重要組成部分的逐漸集中,有機(jī)會(huì)探索其對(duì)增強(qiáng)可解釋性和可解釋性的潛在影響。

Inherently Explainable Methods

在不同的可解釋方法中,有一類(lèi)方法主要是開(kāi)發(fā)能夠內(nèi)在地解釋算法模型,然而,這些模型通常難以達(dá)到與更復(fù)雜的黑盒模型相同的精度水平。因此,必須在可解釋性和性能之間考慮謹(jǐn)慎的平衡。接下來(lái)對(duì)一些經(jīng)典的工作進(jìn)行簡(jiǎn)要的介紹。

ViT-CX:該方法針對(duì)ViT模型定制的基于掩碼的解釋方法。這種方法依賴patch embedding以及其對(duì)模型輸出的影響,而不是聚焦對(duì)它們的關(guān)注。該方法包括掩碼生成和掩碼聚合兩個(gè)階段,從而提供更有意義的顯著性圖。

ViT-NeT:該方法是一種新的神經(jīng)樹(shù)解碼器,通過(guò)樹(shù)形結(jié)構(gòu)和原型來(lái)描述決策過(guò)程。同時(shí),該算法還可以對(duì)結(jié)果進(jìn)行可視化解釋。

R-Cut:該方法是通過(guò)Relationship Weighted Out and Cut來(lái)增強(qiáng)ViT的可解釋性。該方法包括兩個(gè)模塊,分別是Relationship Weighted Out和Cut模塊。前者側(cè)重于從中間層提取特定類(lèi)的信息,強(qiáng)調(diào)相關(guān)特征。后者執(zhí)行細(xì)粒度的特征分解。通過(guò)對(duì)兩個(gè)模塊的集成,可以生成密集的特定于類(lèi)的可解釋性映射。

Other Tasks

就如同在文章開(kāi)頭提到的,除了分類(lèi)之外,基于ViT的架構(gòu)對(duì)其他CV任務(wù)的解釋性仍在探索中。有幾種專(zhuān)門(mén)針對(duì)其他任務(wù)提出的可解釋性方法,接下來(lái)就對(duì)相關(guān)領(lǐng)域的最新工作進(jìn)行介紹~

eX-ViT:該算法是一種基于弱監(jiān)督語(yǔ)義分割的新型可解釋視覺(jué)轉(zhuǎn)換器。此外,為了提高可解釋性,引入了屬性導(dǎo)向損失模塊,該模塊包含全局級(jí)屬性導(dǎo)向損失、局部級(jí)屬性可判別性損失和屬性多樣性損失三種損失。前者使用注意圖來(lái)創(chuàng)建可解釋的特征,后兩者則增強(qiáng)屬性學(xué)習(xí)。

DINO:該方法是一種簡(jiǎn)單的自監(jiān)督方法,并且是一種不帶標(biāo)簽的自蒸餾方法。最終學(xué)習(xí)到的注意圖能夠有效地保留圖像的語(yǔ)義區(qū)域,從而實(shí)現(xiàn)可以解釋的目的。

Generic Attention-model:該方法是一種基于Transformer架構(gòu)做預(yù)測(cè)的算法模型。該方法應(yīng)用于三種最常用的架構(gòu),即純自注意、自注意與共同注意相結(jié)合和編碼器-解碼器注意。為了檢驗(yàn)?zāi)P偷慕忉屝裕髡呤褂昧艘曈X(jué)問(wèn)答任務(wù),然而,它也適用于其他CV任務(wù),如目標(biāo)檢測(cè)和圖像分割。

ATMAN:這是一種模態(tài)不可知的擾動(dòng)方法,利用注意機(jī)制生成輸入相對(duì)于輸出預(yù)測(cè)的相關(guān)性圖。該方法試圖通過(guò)記憶效率注意操作來(lái)理解變形預(yù)測(cè)。

Concept-Transformer:該算法通過(guò)突出顯示用戶定義的高級(jí)概念的注意分?jǐn)?shù)來(lái)生成模型輸出的解釋?zhuān)瑥亩_保可信性和可靠性。

未來(lái)展望

雖然目前基于Transformer架構(gòu)的算法模型已經(jīng)在各類(lèi)計(jì)算機(jī)視覺(jué)任務(wù)上取得了非常出色的成績(jī)。但是目前來(lái)看,對(duì)于如何利用可解釋性方法的好處來(lái)促進(jìn)模型調(diào)試和改進(jìn),以及提高模型的公平性和可靠性,特別是在ViT應(yīng)用中,一直缺乏明顯的研究。

所以本文以圖像分類(lèi)任務(wù)出發(fā),對(duì)現(xiàn)有的基于Vision Transformer的可解釋性算法模型進(jìn)行歸類(lèi)整理,從而幫助人們更好的理解此類(lèi)模型架構(gòu),希望可以對(duì)大家有所幫助。

-

算法

+關(guān)注

關(guān)注

23文章

4702瀏覽量

94939 -

計(jì)算機(jī)視覺(jué)

+關(guān)注

關(guān)注

9文章

1706瀏覽量

46613 -

Transformer

+關(guān)注

關(guān)注

0文章

151瀏覽量

6426

原文標(biāo)題:更深層的理解視覺(jué)Transformer, 對(duì)視覺(jué)Transformer的剖析

文章出處:【微信號(hào):vision263com,微信公眾號(hào):新機(jī)器視覺(jué)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

如何更改ABBYY PDF Transformer+界面語(yǔ)言

視覺(jué)新范式Transformer之ViT的成功

Transformer模型的多模態(tài)學(xué)習(xí)應(yīng)用

用于語(yǔ)言和視覺(jué)處理的高效 Transformer能在多種語(yǔ)言和視覺(jué)任務(wù)中帶來(lái)優(yōu)異效果

基于卷積的框架有效實(shí)現(xiàn)及視覺(jué)Transformer背后的關(guān)鍵成分

普通視覺(jué)Transformer(ViT)用于語(yǔ)義分割的能力

視覺(jué)Transformer在CV中的現(xiàn)狀、趨勢(shì)和未來(lái)方向

基于視覺(jué)transformer的高效時(shí)空特征學(xué)習(xí)算法

CVPR 2023 | 清華大學(xué)提出LiVT,用視覺(jué)Transformer學(xué)習(xí)長(zhǎng)尾數(shù)據(jù)

如何入門(mén)面向自動(dòng)駕駛領(lǐng)域的視覺(jué)Transformer?

使用 Vision Transformer 和 NVIDIA TAO,提高視覺(jué) AI 應(yīng)用的準(zhǔn)確性和魯棒性

汽車(chē)領(lǐng)域擁抱Transformer需要多少AI算力?

Faster Transformer v1.0源碼詳解

LLM的Transformer是否可以直接處理視覺(jué)Token?

視覺(jué)Transformer基本原理及目標(biāo)檢測(cè)應(yīng)用

更深層的理解視覺(jué)Transformer, 對(duì)視覺(jué)Transformer的剖析

更深層的理解視覺(jué)Transformer, 對(duì)視覺(jué)Transformer的剖析

評(píng)論