(電子發燒友網 文/黃晶晶)無疑生成式AI的火熱帶動了互聯網廠商、運營商、云服務商以及各類應用方等對數據中心、AI服務器的大力投入。同時,像中國的“東數西算”工程正構筑著堅實的算力基建。為了適應大數據、人工智能的發展,必須要解決如何增強算力、存力和運力的問題。那么高速的數據傳輸是不可缺少的核心環節。在此背景下,我們需要前瞻布局哪些數據傳輸的接口技術來適應發展呢?最近,Rambus 解決方案營銷高級總監Tim Messegee接受采訪,分享了他對于數據中心高速接口技術和市場的洞見。

圖:Rambus 解決方案營銷高級總監Tim Messegee

圖:Rambus 解決方案營銷高級總監Tim Messegee

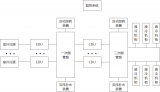

Tim Messegee表示,總體上,新數據中心的架構設計應考慮到性能、可擴展性、可靠性和安全性,滿足生成式AI和大數據應用的具體需求。新數據中心首先需要配備高性能計算(HPC)基礎設施來滿足生成式AI和大數據應用的密集計算需求,比如使用功能強大的處理器、GPU、內存、網絡、專用硬件加速器等高效處理大量數據并執行復雜計算。

新數據中心架構的設計應該使內存、存儲等易于擴展。例如,CXL技術可以幫助建立內存池,從架構上將CPU和內存分離,不僅能夠共享內存,還能在性能需求日益增加的情況下更加輕松地增加內存。

突破數據傳輸的瓶頸

業界一直都存在“內存墻”的問題,其根源還是數據傳輸的速率性能瓶頸。Tim Messegee說道,與“木桶定律”中的例子一樣,限制數據中心數據傳輸速率的元素不止一個,而是所有相關元素的性能。顯然,解決這一問題需要強大的 CPU、高速內存、高帶寬網絡以及許多其他方面的支持。

實際上大家都不希望自己是最短板的那一塊。而以Rambus來看,其擅長的是提供先進內存接口芯片和接口IP解決方案幫助滿足數據中心對帶寬不斷增長的需求。對此,Tim Messegee進行了解析。

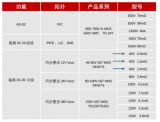

具體來看,DDR5 DIMM芯片組:Rambus DDR5內存接口芯片組由 DDR5 RCD、SPD Hub 和溫度傳感器組成,專為滿足最新一代DDR5內存系統的大容量、高帶寬性能要求而量身定制。這些芯片使服務器和客戶端計算系統能夠處理最苛刻的工作負載和應用。

CXL技術:CXL可使數據中心從原來每臺服務器擁有專用的處理和內存以及網絡和加速器等其他資源的模式,轉變為使用共享資源池的分解模式,共享資源池可根據特定工作負載的需求進行高效組合。

PCIe 6接口子系統IP:PCIe 接口是在 CPU、GPU、FPGA 和特定工作負載加速器等不同計算節點之間以高帶寬和低延遲傳輸數據的關鍵骨干。Rambus PCIe 6解決方案支持下一代數據中心的性能要求,具有延遲、功耗、面積和安全性方面的優勢。

HBM內存控制器:HBM是一種高性能內存標準,具有功耗低、外形小的特點。Rambus HBM 3.0和2E/2控制器可為AI/ML、圖形和HPC應用提供高帶寬、低延遲的內存性能。

新的接口技術何時落地

以上列舉了幾種應用于數據中心的先進的接口技術,包括DDR5、PCIe 6.0、HBM、CXL等。然而它們有各自的應用進程。

首先是DDR5。Tim Messegee表示,DDR5內存已于2021年進入市場。我們現在看到服務器和PC市場都在使用DDR5內存。根據IDC的預測,DDR5的跨越點,即DDR5位出貨量超過DDR4位出貨量的時刻將在2023年底出現。隨著時間的推移,DDR5有望在數據中心和消費市場得到更廣泛的應用。

其次,PCIe在服務器和PC之外也得到了廣泛應用,其規模經濟效益使其對物聯網、汽車等領域以數據為中心的應用極具吸引力。盡管如此,PCIe 6.0的初期部署將針對需要盡可能高帶寬的應用,這些應用都是數據中心的核心,如AI/ML、HPC、云計算、網絡等。Tim Messegee預計第一代PCIe 6.0系統將在2026年問世。

再者,HBM正在成為超級計算機的首選內存。市場對AI/ML的需求推動了 HBM 在數據中心的廣泛應用。如今,英偉達推出的H200 GPU以及GH200超級芯片開始配備141GB HBM3E。HBM的發展大致以兩年為一個周期,技術還在不斷演進當中。

此外,隨著CXL標準從1.0發展到 3.0,行業頭部廠商正在積極支持CXL。Tim Messegee說,要真正在市場上得到廣泛應用,可能還需要一段時間。可以肯定的是,由于CXL的特性,最早采用這項技術的將是那些需要最高帶寬、最低延遲和多設備一致性的應用。目前,我們預計CXL將于2026年在數據中心得到廣泛應用。

誠然,特定技術的應用周期取決于多種因素,包括市場需求、軟硬件生態、成本和性能優勢等。Tim Messegee指出,一般來說,內存和總線技術升級通常需要更長的時間,這是因為它們需要與整個生態兼容,而且所有相互連接的軟硬件元素都需要時間來驗證和檢驗。因此,一項技術的采用情況會因技術特性、復雜程度和市場需求而異。總之,隨著數據中心建設的加速,DDR5、PCIe 6.0、HBM和CXL等高速連接技術將在未來幾年繼續發展和普及,但其采用率可能會因技術和細分市場的不同而有所差異。

觀察市場的反饋,Tim Messegee看到的趨勢是,許多為數據中心開發的技術正在向客戶端擴散。AI推理向邊緣以及AI賦能的客戶端和終端系統轉移,這一趨勢將繼續加速。我們的IP解決方案可以集成到客戶端系統的芯片中,我們的產品路線圖上有支持未來客戶端平臺的Rambus芯片解決方案。

小結:

AI大模型的參數量越來越龐大,內容形式也越來越豐富,隨著數據中心工作負載的增加,DDR、HBM、PCIe和CXL等內存技術將繼續為數據中心提供更高容量、更低延遲和更高能效的數據傳輸速率以滿足不斷增長的算力需求。同時,Rambus也希望通過內存解決方案的不斷改進總體上為提高數據中心的整體能效帶來真正的機會。

Tim Messegee表示,總體上,新數據中心的架構設計應考慮到性能、可擴展性、可靠性和安全性,滿足生成式AI和大數據應用的具體需求。新數據中心首先需要配備高性能計算(HPC)基礎設施來滿足生成式AI和大數據應用的密集計算需求,比如使用功能強大的處理器、GPU、內存、網絡、專用硬件加速器等高效處理大量數據并執行復雜計算。

新數據中心架構的設計應該使內存、存儲等易于擴展。例如,CXL技術可以幫助建立內存池,從架構上將CPU和內存分離,不僅能夠共享內存,還能在性能需求日益增加的情況下更加輕松地增加內存。

突破數據傳輸的瓶頸

業界一直都存在“內存墻”的問題,其根源還是數據傳輸的速率性能瓶頸。Tim Messegee說道,與“木桶定律”中的例子一樣,限制數據中心數據傳輸速率的元素不止一個,而是所有相關元素的性能。顯然,解決這一問題需要強大的 CPU、高速內存、高帶寬網絡以及許多其他方面的支持。

實際上大家都不希望自己是最短板的那一塊。而以Rambus來看,其擅長的是提供先進內存接口芯片和接口IP解決方案幫助滿足數據中心對帶寬不斷增長的需求。對此,Tim Messegee進行了解析。

具體來看,DDR5 DIMM芯片組:Rambus DDR5內存接口芯片組由 DDR5 RCD、SPD Hub 和溫度傳感器組成,專為滿足最新一代DDR5內存系統的大容量、高帶寬性能要求而量身定制。這些芯片使服務器和客戶端計算系統能夠處理最苛刻的工作負載和應用。

CXL技術:CXL可使數據中心從原來每臺服務器擁有專用的處理和內存以及網絡和加速器等其他資源的模式,轉變為使用共享資源池的分解模式,共享資源池可根據特定工作負載的需求進行高效組合。

PCIe 6接口子系統IP:PCIe 接口是在 CPU、GPU、FPGA 和特定工作負載加速器等不同計算節點之間以高帶寬和低延遲傳輸數據的關鍵骨干。Rambus PCIe 6解決方案支持下一代數據中心的性能要求,具有延遲、功耗、面積和安全性方面的優勢。

HBM內存控制器:HBM是一種高性能內存標準,具有功耗低、外形小的特點。Rambus HBM 3.0和2E/2控制器可為AI/ML、圖形和HPC應用提供高帶寬、低延遲的內存性能。

新的接口技術何時落地

以上列舉了幾種應用于數據中心的先進的接口技術,包括DDR5、PCIe 6.0、HBM、CXL等。然而它們有各自的應用進程。

首先是DDR5。Tim Messegee表示,DDR5內存已于2021年進入市場。我們現在看到服務器和PC市場都在使用DDR5內存。根據IDC的預測,DDR5的跨越點,即DDR5位出貨量超過DDR4位出貨量的時刻將在2023年底出現。隨著時間的推移,DDR5有望在數據中心和消費市場得到更廣泛的應用。

其次,PCIe在服務器和PC之外也得到了廣泛應用,其規模經濟效益使其對物聯網、汽車等領域以數據為中心的應用極具吸引力。盡管如此,PCIe 6.0的初期部署將針對需要盡可能高帶寬的應用,這些應用都是數據中心的核心,如AI/ML、HPC、云計算、網絡等。Tim Messegee預計第一代PCIe 6.0系統將在2026年問世。

再者,HBM正在成為超級計算機的首選內存。市場對AI/ML的需求推動了 HBM 在數據中心的廣泛應用。如今,英偉達推出的H200 GPU以及GH200超級芯片開始配備141GB HBM3E。HBM的發展大致以兩年為一個周期,技術還在不斷演進當中。

此外,隨著CXL標準從1.0發展到 3.0,行業頭部廠商正在積極支持CXL。Tim Messegee說,要真正在市場上得到廣泛應用,可能還需要一段時間。可以肯定的是,由于CXL的特性,最早采用這項技術的將是那些需要最高帶寬、最低延遲和多設備一致性的應用。目前,我們預計CXL將于2026年在數據中心得到廣泛應用。

誠然,特定技術的應用周期取決于多種因素,包括市場需求、軟硬件生態、成本和性能優勢等。Tim Messegee指出,一般來說,內存和總線技術升級通常需要更長的時間,這是因為它們需要與整個生態兼容,而且所有相互連接的軟硬件元素都需要時間來驗證和檢驗。因此,一項技術的采用情況會因技術特性、復雜程度和市場需求而異。總之,隨著數據中心建設的加速,DDR5、PCIe 6.0、HBM和CXL等高速連接技術將在未來幾年繼續發展和普及,但其采用率可能會因技術和細分市場的不同而有所差異。

觀察市場的反饋,Tim Messegee看到的趨勢是,許多為數據中心開發的技術正在向客戶端擴散。AI推理向邊緣以及AI賦能的客戶端和終端系統轉移,這一趨勢將繼續加速。我們的IP解決方案可以集成到客戶端系統的芯片中,我們的產品路線圖上有支持未來客戶端平臺的Rambus芯片解決方案。

小結:

AI大模型的參數量越來越龐大,內容形式也越來越豐富,隨著數據中心工作負載的增加,DDR、HBM、PCIe和CXL等內存技術將繼續為數據中心提供更高容量、更低延遲和更高能效的數據傳輸速率以滿足不斷增長的算力需求。同時,Rambus也希望通過內存解決方案的不斷改進總體上為提高數據中心的整體能效帶來真正的機會。

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

-

IP

+關注

關注

5文章

1718瀏覽量

149966 -

數據中心

+關注

關注

16文章

4859瀏覽量

72381 -

AI

+關注

關注

87文章

31521瀏覽量

270339 -

高速接口

+關注

關注

1文章

45瀏覽量

14809

發布評論請先 登錄

相關推薦

Meta AI數據中心網絡用了哪家的芯片

? 在Meta,我們相信開放的硬件會推動創新。在當今世界,越來越多的數據中心基礎設施致力于支持新興的AI技術,開放硬件在協助分解方面發揮著重要作用。通過將傳統數據中心

AI數據中心的能源危機,需要更高效的PSU

電子發燒友網報道(文/梁浩斌)數據中心在近年AI的浪潮中得到極大的發展,算力需求的膨脹帶動全球數據中心建設規模呈現爆發式增長。而在數據中心數量增長的同時,也面臨著能源問題。 ? 如今大

Credo新品發布!AEC高速互連如何賦能數據中心?

全球數據中心的井噴式發展下,何種線纜能高效傳輸龐大的數據?有源電纜AEC能否成為高速互連技術新突破口? 2024年,我國發布了一系列關于

AI時代,我們需要怎樣的數據中心?AI重新定義數據中心

超過60%的中國企業計劃在未來12至24個月內部署生成式人工智能。AI、模型的構建,將顛覆數據中心基礎設施的建設、運維和運營。一個全新的數據中心智能化時代已經拉開序幕。

發表于 07-16 11:33

?779次閱讀

數據中心交換機高速率發展,需要哪些電感與電容元件?

電子發燒友網報道(文/李寧遠)在算力向更高水平發展的推動下,數據迎來了爆炸性增長。數據中心需要處理越來越多的數據,并且這些

AI加持下的數據中心,需要怎樣的高速接口技術?

AI加持下的數據中心,需要怎樣的高速接口技術?

評論