隨著人工智能技術(shù)的迅速發(fā)展,Transformer在自然語言處理、機(jī)器翻譯、問答系統(tǒng)等領(lǐng)域取得了顯著的性能提升。然而,這些模型的部署面臨著巨大的挑戰(zhàn),主要源于其龐大的模型尺寸和內(nèi)存消耗。

在部署過程中,網(wǎng)絡(luò)壓縮是一種常用的解決方案,可以有效減小模型的體積,提高模型在移動(dòng)設(shè)備等資源受限環(huán)境下的部署效率。其中,量化技術(shù)是將大模型中的浮點(diǎn)數(shù)參數(shù)轉(zhuǎn)換為整數(shù),并進(jìn)行存儲(chǔ)和計(jì)算的方法。由于Transformer的網(wǎng)絡(luò)參數(shù)越來越多、計(jì)算量越來越大,對(duì)于存儲(chǔ)和計(jì)算資源有限的邊緣設(shè)備來說,模型部署帶來了很大的挑戰(zhàn)。

網(wǎng)絡(luò)量化是一種常見的解決方案,通過將模型參數(shù)量化為整數(shù),可以大幅度減少模型的存儲(chǔ)空間和計(jì)算量,從而實(shí)現(xiàn)在邊緣設(shè)備上高效部署Transformer。

后摩智能也在Transformer量化提出了一些領(lǐng)先的算法方案。在本文中,我們將重點(diǎn)介紹兩種針對(duì)Transformer的量化方案:

RPTQ(Reorder-based Post-training Quantization)

PB-LLM(Partially Binarized Large Language Models)

這兩種方法分別針對(duì)激活量化和權(quán)重量化,旨在實(shí)現(xiàn)極端低位量化,同時(shí)保持語言推理能力。

RPTQ:

量化激活通道的新思路

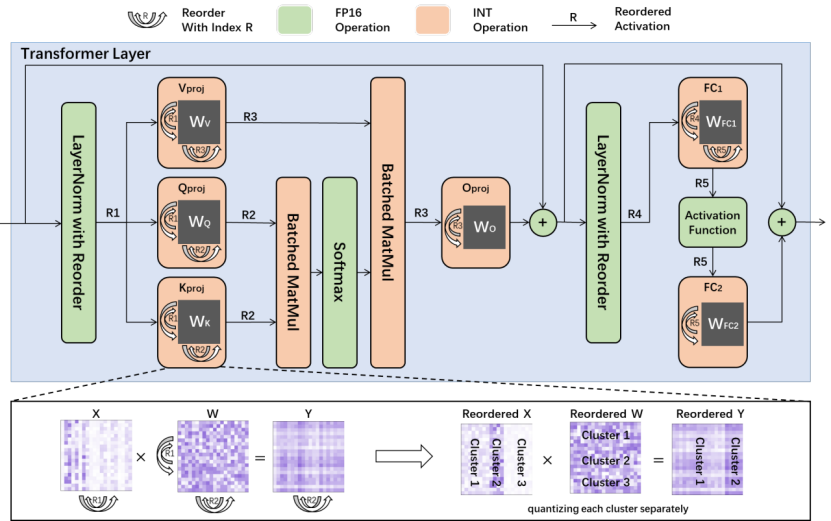

RPTQ(Reorder-based Post-training Quantization)是后摩智能團(tuán)隊(duì)與華中科技大學(xué)等合作單位提出的一種全新的量化方法,旨在解決量化Transformer時(shí)激活通道之間的數(shù)值范圍差異問題。

相較于以往的研究,RPTQ首次將3位激活引入了LLMs,實(shí)現(xiàn)了顯著的內(nèi)存節(jié)省,例如在量化OPT-175B模型方面,內(nèi)存消耗降低了高達(dá)80%。RPTQ的關(guān)鍵思想是通過重新排列激活通道并按簇量化,從而減少通道范圍差異的影響。同時(shí),通過操作融合,避免了顯式重新排序的操作,使得RPTQ的開銷幾乎為零。通過這種方法,RPTQ有效地解決了激活通道數(shù)值范圍差異導(dǎo)致的量化誤差問題。

PB-LLM:

實(shí)現(xiàn)極端低位量化的新突破

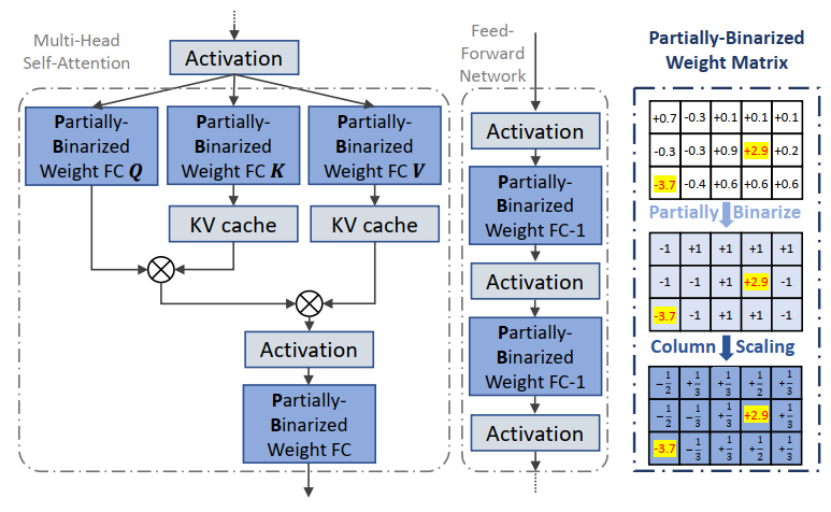

PB-LLM(Partially Binarized Large Language Models)是后摩智能團(tuán)隊(duì)與伊利諾伊理工和伯克利大學(xué)等單位合作提出的另一種創(chuàng)新性量化方法,主要針對(duì)權(quán)重量化。目前該篇論文已被接收至ICLR 2024,ICLR 以介紹和發(fā)布人工智能、統(tǒng)計(jì)學(xué)和數(shù)據(jù)科學(xué)領(lǐng)域深度學(xué)習(xí)的尖端研究而聞名,被認(rèn)為是“深度學(xué)習(xí)的頂級(jí)會(huì)議”。

相較于傳統(tǒng)的二值化方法,PB-LLM采用了部分二值化的策略,即將一部分顯著權(quán)重分配到高位存儲(chǔ),從而在實(shí)現(xiàn)極端低位量化的同時(shí),保持了Transformer的語言推理能力。通過對(duì)顯著權(quán)重的充分利用,PB-LLM取得了顯著的性能提升,為Transformer的內(nèi)存消耗和計(jì)算復(fù)雜度提供了有效的解決方案。這是學(xué)術(shù)界首次探索對(duì)Transformer權(quán)重?cái)?shù)值二值化的工作。

后摩智能的技術(shù)優(yōu)勢(shì):突破性內(nèi)存計(jì)算技術(shù)驅(qū)動(dòng)AI發(fā)展

后摩智能作為大算力存算一體領(lǐng)域的先行者,憑借著RPTQ和PB-LLM等創(chuàng)新性量化方法的提出,取得了在大型語言模型中實(shí)現(xiàn)極端低位量化的突破。同時(shí),后摩智能團(tuán)隊(duì)在內(nèi)存計(jì)算領(lǐng)域擁有深厚的研究實(shí)力和豐富的實(shí)踐經(jīng)驗(yàn),與行業(yè)內(nèi)多家頂尖機(jī)構(gòu)展開了廣泛的合作。這使得后摩智能得以不斷推動(dòng)內(nèi)存計(jì)算技術(shù)的發(fā)展,為人工智能技術(shù)的應(yīng)用提供了更多創(chuàng)新性解決方案。

總的來說,后摩智能的RPTQ和PB-LLM等突破性量化方法為解決大型語言模型部署中的內(nèi)存消耗和計(jì)算復(fù)雜度問題提供了有效的解決方案。隨著內(nèi)存計(jì)算技術(shù)的不斷演進(jìn),后摩智能將繼續(xù)致力于推動(dòng)人工智能技術(shù)的發(fā)展,實(shí)現(xiàn)萬物智能的愿景。

審核編輯:劉清

-

人工智能

+關(guān)注

關(guān)注

1805文章

48936瀏覽量

248303 -

自然語言處理

+關(guān)注

關(guān)注

1文章

628瀏覽量

14108 -

LLM

+關(guān)注

關(guān)注

1文章

324瀏覽量

792

原文標(biāo)題:后摩前沿 | Transformer 壓縮部署的前沿技術(shù):RPTQ與PB-LLM

文章出處:【微信號(hào):后摩智能,微信公眾號(hào):后摩智能】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

Transformer壓縮部署的前沿技術(shù):RPTQ與PB-LLM

Transformer壓縮部署的前沿技術(shù):RPTQ與PB-LLM

評(píng)論