私有本地化部署:AI硬件的未來

隨著當下AI的高速發展,今年將會迎來“大模型應用爆發元年”。市面上不少大模型產品應運而生,在大模型普惠應用井噴的時代,這類產品的使用存在許多門檻和風險,比如高昂的服務器部署成本、在運行過程中會過度依賴網絡狀態、以及難以保障數據的安全性等問題。

為了解決大模型產品使用期間所產生的算力成本高、網絡波動、數據隱私等問題,Firefly開源團隊推出可本地化部署的人工智能盒子:AIBOX-1684X

Firefly人工智能新品:AI算力小魔盒

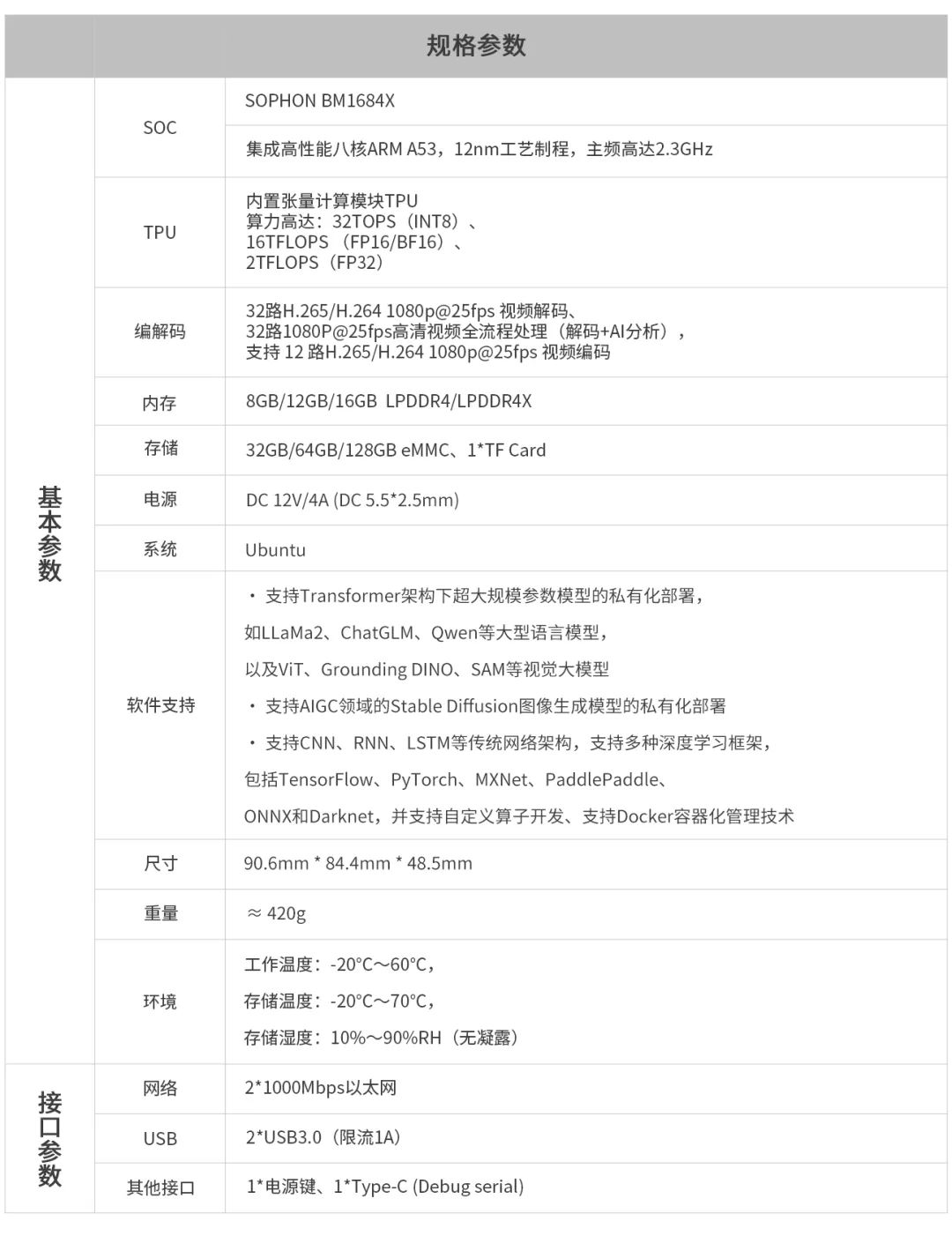

AIBOX-1684X支持主流大模型私有化部署,僅掌心大小的體積就能把AI能力私有化,能夠滿足個性化的AI部署!其算力高達32Tops,擁有八核2.3GHz處理器,兼具穩定性、私密性、精致小巧等特性。

支持主流大模型

AIBOX-1684X幾乎支持目前主流大模型的本地化運行,包括LLaMa3,ChatGLM3,Qwen等語言大模型,SAM等視覺大模型,以及Stable Diffusion AI繪圖。

私有化部署:我的AI我做主

○ 本地化部署,無懼斷網

無需網絡即可使用AI的能力,不受網絡狀態影響,任務運行更穩定。

支持主流

○ 開源透明,安全無風險

使用全開源AI模型部署工具鏈,透明可信任,做到零安全隱患。

○ 精致小巧,隨處部署

僅掌心大小,10cm內的小方盒,表面柔潤精致的鋁合金切割工藝,在哪部署都合適。

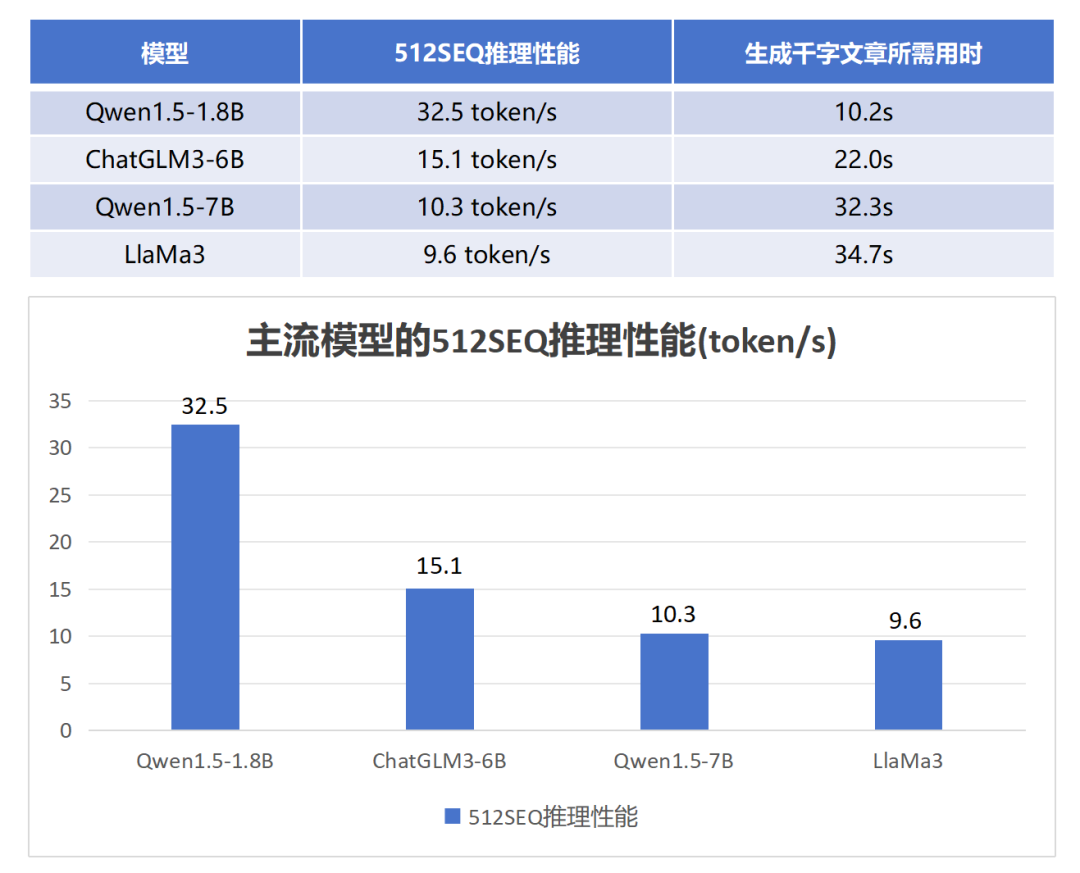

極致性能:讓AI秒回,無需多等

千字文本生成僅需10.2秒

AIBOX在本地運行時,擁有極快的響應時間,能夠更好地提升用戶體驗。例如在Qwen1.5-1.8B模型中,推理性能可達到32.5 token/s,相當于其生成一篇1000字的文章僅需約10.2秒,可實現自然語言的快速問答。

標準圖像生成僅需7秒

支持 AIGC 領域的 Stable DiffusionV1.5 圖像生成模型,在Stable Diffusion V1.5模型中,生成512* 512尺寸的圖片僅需約7秒。

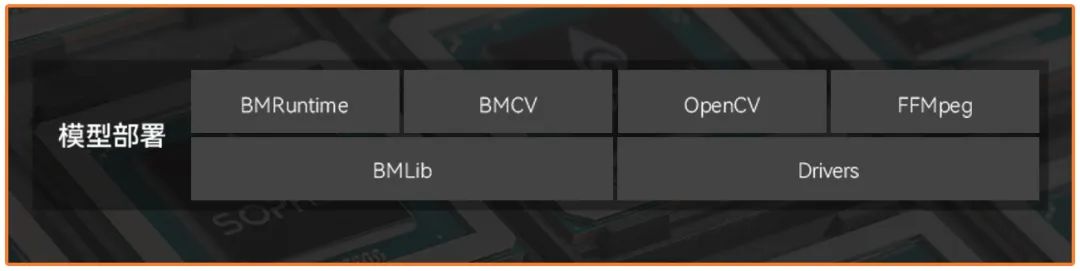

支持多種深度學習框架

AIBOX支持所有主流大模型深度學習框架,包括TensorFlow、PyTorch、MXNet、PaddlePaddle、ONNX和Darknet,并支持自定義算子開發。

高配硬件性能,AI運行暢通無阻

搭載SOPHON算能AI處理器BM1684X,擁有八核ARM Cortex-A53,最高主頻2.3GHz,最高支持32路1080P H.264/H.265的視頻解碼,32路1080P高清視頻全流程處理(解碼+AI分析)

-

硬件

+關注

關注

11文章

3466瀏覽量

67284 -

AI

+關注

關注

88文章

34553瀏覽量

276108 -

AIGC

+關注

關注

1文章

385瀏覽量

2311

發布評論請先 登錄

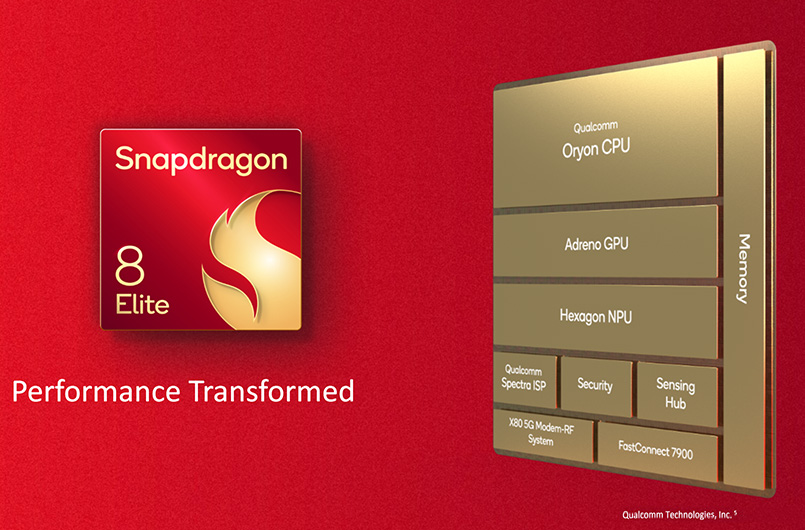

端側 AI 芯片:終端智能落地的核心引擎

首創開源架構,天璣AI開發套件讓端側AI模型接入得心應手

端側AI應用——“后DeepSeek時代”產業機遇分析

AIGC入門及鴻蒙入門

中信建投建議關注端側AI模組機會

端側AI浪潮已來!炬芯科技發布新一代端側AI音頻芯片,能效比和AI算力大幅度提升

端側AI應用趨熱:NPU如何解決其關鍵痛點

蔡司工業CT掃描電鏡等直擊醫療質量痛點

AI硬件大爆發,這個小魔盒直擊端側AIGC的痛點

AI硬件大爆發,這個小魔盒直擊端側AIGC的痛點

評論