電信公司正在利用生成式 AI,通過自動化流程、改善客戶體驗和優化網絡運營來提高員工生產力。

Amdocs 是一家領先的通信和媒體公司軟件和服務提供商,打造了一個電信專用生成式 AI 平臺——amAIz,為電信公司提供了一個開放、安全、經濟高效且跨大語言模型(LLM)的框架。Amdocs 正在利用 NVIDIA DGX Cloud 和 NVIDIA AI Enterprise 軟件,提供基于商用 LLM 的解決方案,以及適用于特定領域的模型,使服務提供商能夠構建和部署企業級生成式 AI 應用程序。

Amdocs 也在使用 NVIDIA NIM,這是一組易于使用的推理微服務,旨在加速生成式 AI 在企業中的大規模部署。該多功能微服務支持來自開放社區的模型和 NVIDIA API 產品目錄中的 NVIDIA AI Foundation 模型,以及自定義 AI 模型。NIM 旨在推動高吞吐量、低延遲的無縫 AI 推理,同時保持預測的高準確性。

客戶計費用例

電信公司的聯絡中心會收到大量客戶的計費查詢電話。他們向客服尋求解釋,因為各種操作可能會影響他們的賬單,包括客戶的移動計劃、促銷期結束或意外收費。

Amdocs 正在開發一種基于 LLM 的解決方案,該解決方案通過對賬單問題提供即時準確的解釋來幫助客戶。該解決方案旨在減少客服代理的工作量,使他們能夠專注于更復雜的任務。

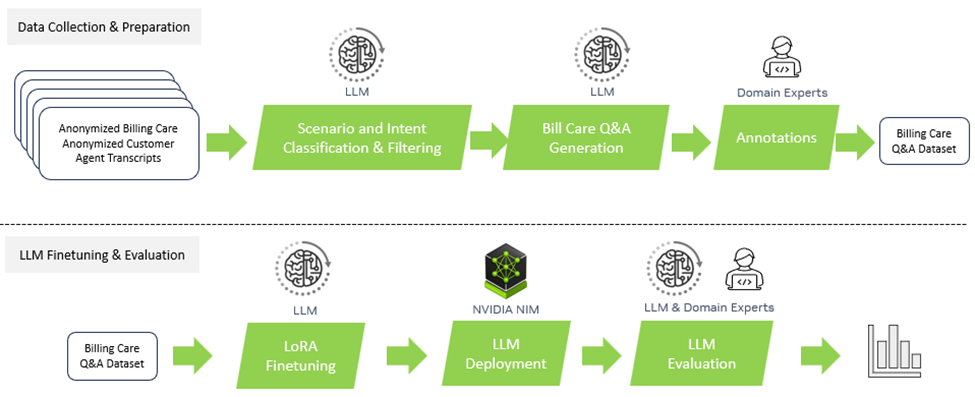

圖 1 顯示了從數據收集和準備到 LLM 微調,再到評估的總體流程。

圖 1. 從數據收集和準備到 LLM 微調和評估的整體流程

數據收集和準備

為了解決這個問題,他們從匿名的通話記錄和賬單中創建了一個新的數據集,由電信客服專家標記。該數據集包含數百個注釋問題和答案,這些問題和答案被分類到相關場景中。大部分數據用于微調,性能在一個小測試集(幾十個樣本)上報告。

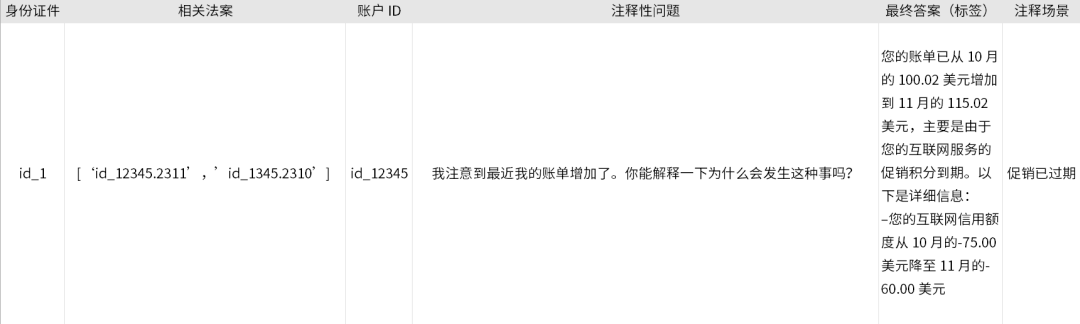

表 1 顯示了所收集數據的一個示例。該問題與計費更改有關,注釋的答案基于客戶歷史賬單。

表 1. 移動計劃促銷到期場景中收集的數據示例

在這個過程中,Amdocs 使用 OpenAI GPT-4 LLM 這一工具來過濾通話記錄并將其分類到不同場景中。然后,LLM 被用于生成潛在的問答對,這些問答對被領域專家重新訪問和標記。

數據格式和提示工程

作為基線,Amdocs 使用 Llama2-7b-chat、Llama2-13b-chat 和 Mixtral-8x7b LLM 來增強具有意向分類和賬單問答功能的客戶服務聊天機器人。Amdocs 設計了帶有指令的提示,其中包括目標賬單(原始 XML 格式的連續一到兩個計費月)及其相關問題。

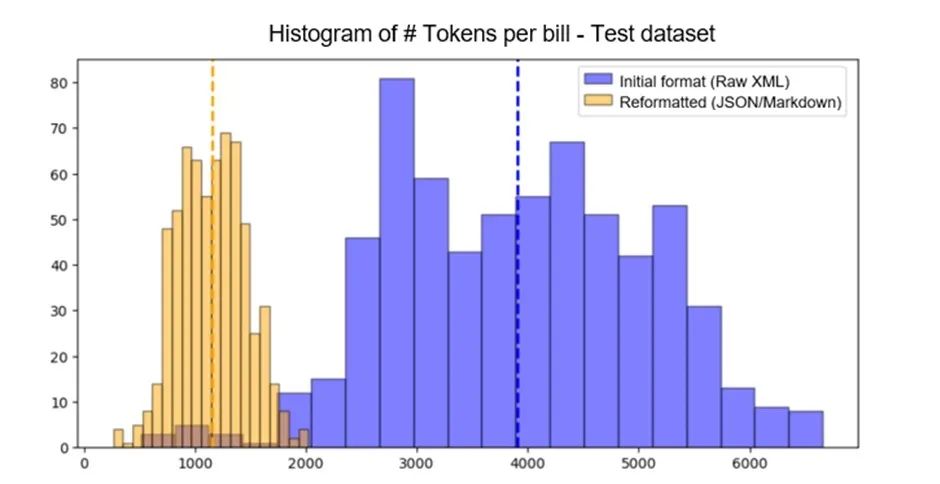

使用基準 LLM 和零樣本或少樣本推理的初始實驗表現不佳,主要是由于從客戶賬單中提取相關信息的復雜性。此外,原始 XML 格式需要詳細說明 LLM 的計費格式。因此,由于某些 LLM(例如,Llama2 的 4K tokens)的最大上下文長度的限制,Amdocs 在將賬單和指令納入提示中時面臨挑戰。

為了適應上下文窗口,Amdocs 的第一項工作是簡化提示中的計費格式說明。圖 2 顯示了使用 Llama2 標記器(tokenizer),重新格式化后的 token 平均數量從 3909 個減少到 1153 個。

圖 2. 使用新計費格式減少的 token 數量

NVIDIA DGX Cloud 上的 LLM 微調

由于注釋數據量有限,Amdocs 探索了參數高效微調(PEFT)方法,如低秩自適應(LoRA)。他們用兩種基礎 LLM 架構(Llama2 和 Mixtral)進行了幾次微調實驗,研究了一到兩個時期的幾個 LoRA 超參數。

Amdocs 的實驗是在 NVIDIA DGX Cloud 上進行的,這是一個面向開發者的端到端 AI 平臺,提供基于最新 NVIDIA 架構的可擴展能力,并與世界領先的云服務提供商共同設計。Amdocs 使用的 NVIDIA DGX Cloud 實例包含以下組件:

8 個 NVIDIA 80GB Tensor Core GPU

88 個 CPU 核心

1TB 系統內存

在多 GPU 環境下執行微調周期,每個周期不到一個小時。

使用 NVIDIA NIM 部署 LLM

NVIDIA NIM 基于NVIDIA Triton推理服務器所構建,采用 TensorRT-LLM 對 NVIDIA GPU 上的 LLM 推理進行優化。NIM 通過預先優化的推理容器來推動無縫的 AI 推理,這些容器開箱即用,在加速的基礎設施上提供極佳的延遲和吞吐量,同時確保預測的準確性。無論是在本地還是在云中,NIM 都提供了以下優勢:

簡化 AI 應用程序開發

為最新的生成式 AI 模型預先配置的容器

通過服務級別協議提供企業支持,并定期更新 CVE 的安全性

支持最新的社區前沿的 LLM

成本效益和性能

對于該應用程序,Amdocs 使用自托管的 NVIDIA NIM 實例來部署經過微調的 LLM。他們公開了類似 OpenAI 的 API 端點,為他們的客戶端應用程序啟用了統一的解決方案,該解決方案使用 LangChain 的 ChatOpenAI 客戶端。

在微調探索過程中,Amdocs 創建了一個流程,通過 NIM 自動部署 LoRA 微調檢查點。對于微調后的 Mixtral-8x7B 模型,該過程花費了大約 20 分鐘。

結果

Amdocs 已經看到了這一過程的多重效率。

準確性提高:通過與 NVIDIA 合作,顯著提高了 AI 生成響應的準確性,準確性提高了 30%。這類改進對于加快推動生成式 AI 在電信行業的廣泛應用和滿足面向消費者的生成式 AI 服務的需求至關重要。

使用 NVIDIA NIM,Amdocs 在成本和延遲方面都有所改進。

運營成本降低:Amdocs 在 NVIDIA 基礎設施上的電信檢索增強生成(RAG)使部署用例所消耗的 token 在數據預處理和推理方面分別降低了 60% 和 40%,以更低的成本提供相同水平的準確性。

延遲降低:該協作成功地將查詢延遲減少了約 80%,從而確保最終用戶體驗到近乎實時的響應速度。這項加速提升了用戶在商業、醫療、運營等領域的體驗。

LLM 準確性評估

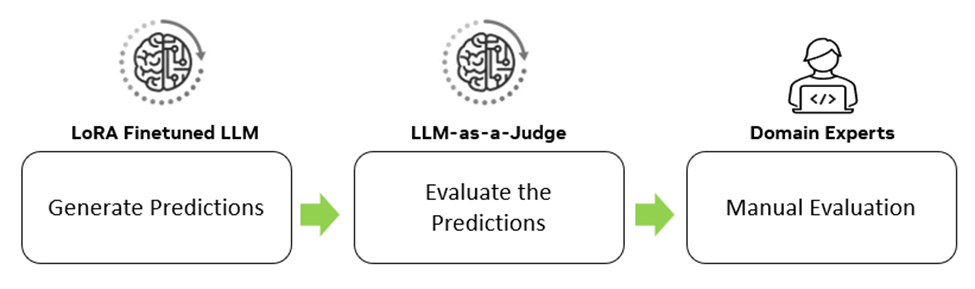

為了在微調階段評估測試數據集上跨模型和提示的性能,Amdocs 使用了圖 3 中的高級流程。

圖 3. 包括 LLM-as-a-Judge 和人類專家在內的 LLM 評估過程

對于每個實驗,Amdocs 首先在測試數據集上生成 LLM 輸出預測。

然后,使用外部 LLM-as-a-Juage 來評估預測,提供準確性和相關性的指標。對符合預定義標準的實驗進行自動回歸測試,以驗證預測細節的準確性。由此得出的分數是多種指標的混合,包括以下:

F1 分數

無幻覺指示器

準確結論指示器

回答相關性

對話一致性

無回退指示器

完整性

毒性指標

最后,手動評估性能最佳的模型,以確認總體準確性。這一過程確保了微調后的 LLM 既有效又可靠。

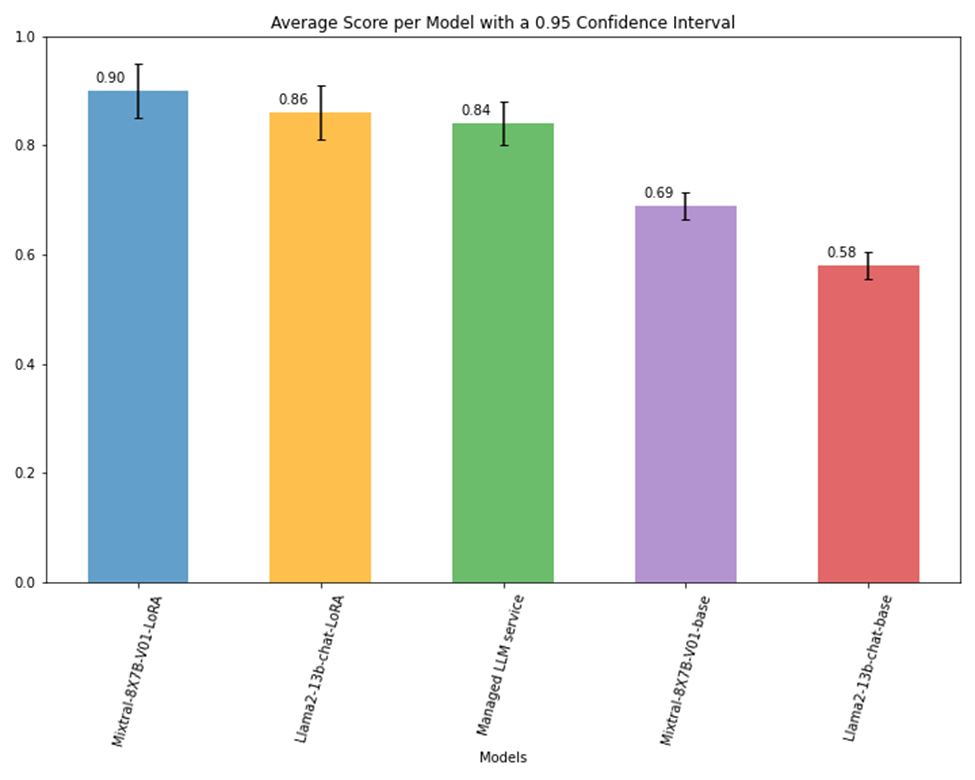

圖 4 顯示了不同 LLM 的總體準確度得分。Amdocs 觀察到,與基礎版本相比,Mixtral-8x7B 和 Llama2-13b-cat 的 LoRA 微調版本的準確率分別提高了 20-30%。結果還顯示,與托管 LLM 服務相比,準確率提高了 6%。

圖 4. 前三名模型的平均得分提升情況

Token 消耗

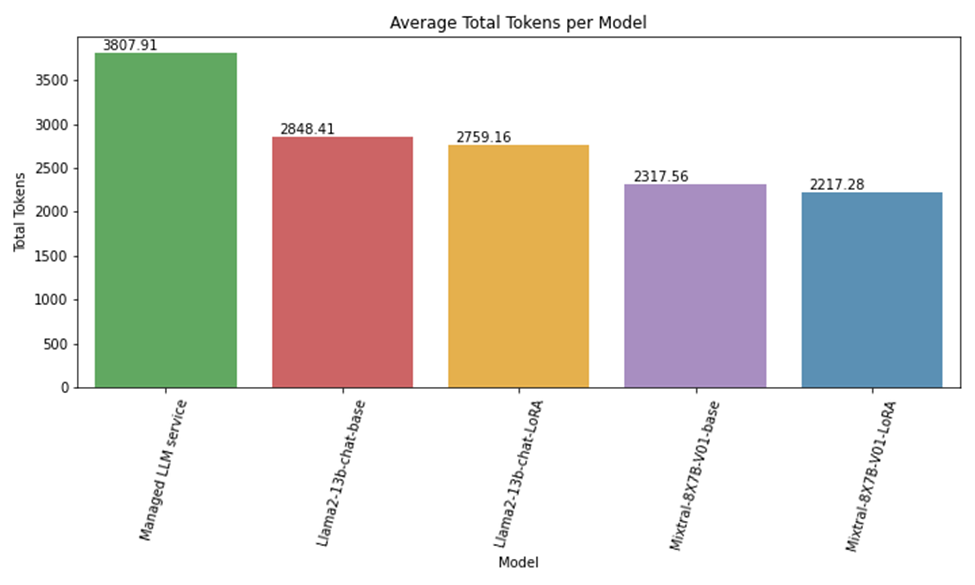

重新格式化計費數據導致輸入 token 減少了 60%。雖然經過微調的 LLM 產生了相當或更好的性能,但這些模型也使輸入 token 額外節省了約 40%。這歸因于最小化提示指令的域自定義。

圖 5 顯示了 Mixtral-8x7B、Llama2-13b 和托管 LLM 服務的 token 消耗之間的比較。輸入 token 數量的差異主要是由于托管 LLM 服務為很好地執行任務中所需的詳細指令。對于域定制的 Llama2 和 Mixtral-8x7B 模型,減少是由于持續的上下文格式改進。

圖 5. Mixtral-8x7B、Llama2 和托管 LLM 服務的標記消耗情況

LLM 延遲

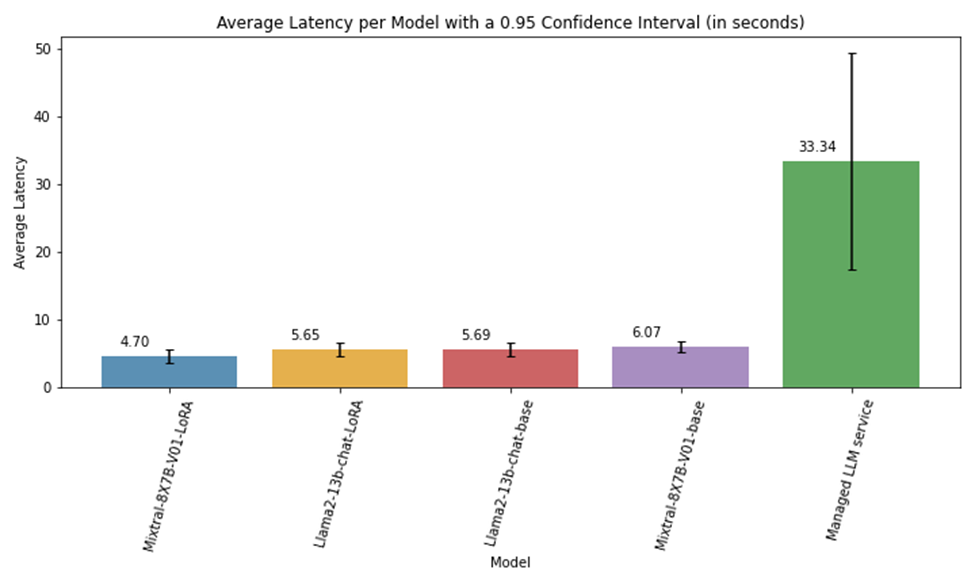

在使用 NVIDIA NIM 對 NVIDIA 80GB GPU 上部署的模型進行評估期間,Amdocs 觀察到平均推理速度比先進的托管 LLM 服務快 4-6 倍,約 80%。

圖 6 顯示了使用單個 LLM 調用執行的延遲實驗,并計算了整個生成周期的平均延遲。Llama2-13b 模型部署在一個 GPU 上,而 Mixtral-8x7B 部署在兩個 GPU 上。當使用自托管端點時,響應延遲更加一致,如圖 6 所示的 0.95 置信區間線所示。

圖 6.每個模型的平均延遲(以秒為單位)

結論和下一步行動

NVIDIA NIM 推理微服務改善了延遲,使 Amdocs 應用程序中的處理速度更快。通過優化數據格式和微調 LLM,Amdocs 提高了其計費問答系統的準確性,同時顯著降低了成本。在整個過程中,Amdocs 面臨著不同的挑戰,需要創造性的數據格式化、及時的工程設計和模型相關的定制。定義一個明確的模型評估策略和嚴格的測試是他們成功的關鍵。

Amdocs 正在采取下一步行動,通過使用 Multi-LoRA 為不同的應用程序創建定制模型,這是一種能夠在推理過程中動態加載多個模型自適應的技術。這種方法優化了內存使用,因為只有基本模型是一致加載的,而模型層自適應是根據需要動態加載的。

通過與 NVIDIA 合作,Amdocs 啟動了將生成式 AI 集成到其核心產品組合中的戰略。該戰略從確定應用領域開始,通過用戶體驗設計使生成式 AI 的功能對用戶更加友好,并優先處理快速工程。Amdocs 將繼續使用 NVIDIA DGX Cloud 和 NVIDIA AI Enterprise 軟件,以電信公司分類法定制大語言模型(LLM), 以進一步提高準確性并優化生成式 AI 訓練和推理的成本。

Amdocs 計劃在多個戰略方向上繼續將生成式 AI 集成到 amAIz 平臺中。

使用 AI 驅動的語言和情感分析增強客戶查詢路由

增強其 AI 解決方案的推理能力,以提供針對客戶特定需求的建議

解決需要廣泛的領域知識、多模式和多步驟解決方案的復雜場景,如網絡診斷和優化

這些戰略將使運營和創新更加高效和有效。

審核編輯:劉清

-

NVIDIA

+關注

關注

14文章

5267瀏覽量

105883 -

OpenAI

+關注

關注

9文章

1204瀏覽量

8679 -

生成式AI

+關注

關注

0文章

528瀏覽量

717

原文標題:Amdocs 使用 NVIDIA NIM 加速生成式 AI 性能并降低成本

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

Amdocs使用NVIDIA NIM加速生成式AI性能并降低成本

Amdocs使用NVIDIA NIM加速生成式AI性能并降低成本

評論