電子發燒友網報道(文/黃晶晶)數據中心向來是耗電大戶,過去出于更經濟的考慮氣冷型服務器占據主流,如今隨著大語言模型的快速發展以及Meta的Llama-3和Mistral的Mixtral 8x22B等開源模型不斷推出,采用液冷技術的總擁有成本效益更加突出。未來液冷服務器的比重將顯著上升。

液冷產品簡化AI基礎設施

最近,Supermicro推出可立即部署式液冷型AI數據中心,此數據中心專為云原生解決方案而設計,通過SuperCluster加速各界企業對生成式AI的運用,并針對NVIDIA AI Enterprise軟件平臺優化,適用于生成式AI的開發與部署。

Supermicro的SuperCluster解決方案針對LLM訓練、深度學習以及大規模與大批量推理優化Supermicro的SuperCluster支持NVIDIA AI Enterprise,其中包括NVIDIA NIM微服務和NVIDIA NeMo平臺,能實現端對端生成式AI客制,并針對NVIDIA Quantum-2 InfiniBand以及具有每GPU 400Gb/s網速的新型NVIDIA Spectrum-X以太網絡平臺優化,可擴展到具有數萬個GPU的大型計算叢集。

通過Supermicro的4U液冷技術,NVIDIA近期推出的Blackwell GPU能在單一GPU上充分發揮20 PetaFLOPS的AI性能,且與較早的GPU相比,能提供4倍的AI訓練性能與30倍的推理性能,并節省額外成本。

Supermicro總裁兼首席執行官梁見后表示,我們的解決方案針對NVIDIA AI Enterprise軟件優化,滿足各行各業的客戶需求,并提供世界規模級效率的全球制造產能。因此我們得以縮短交付時間,更快提供搭配NVIDIA HGX H100和H200,以及即將推出的B100、B200和GB200解決方案的可立即使用型液冷或氣冷計算叢集。

液冷型被越來越多的采用

Supermicro提供的數據中心的液冷配置設計可幾近免費,并通過能持續降低用電量的優勢為客戶提供額外價值。采用液冷方案的整體擁有成本將非常可觀,例如來自于后期運營過程當中的電力消耗的減少,5年可以節省高達6000萬美元的電費支出。Supermicro從液冷板到CDU乃至冷卻塔,其機柜級全方位液冷解決方案最大可以降低數據中心40%的持續用電量。

液冷并非新的技術,它存在已經超過30年,不過在采訪中,梁見后表示,之前液冷方案需求量小,并且交期長約4-12個月,以小型OEM為主。如今,Supermicro與客戶重新進行子系統和組件設計來提升數據中心的性能,并改善了交期,滿足更快的交付要求。

今年以來,客戶要求新建數據中心時直接采用液冷方案,也希望將舊有的氣冷數據中心部分轉換成液冷配置。在此需求刺激下,公司液冷業務的增長非常快,產能處于供不應求的狀態。

公司在荷蘭、美國和馬來西亞等全球各地擴大生產規模,預計2-3個月內馬來西亞新廠區即可投產。產能爬坡,供應能力增加,令客戶享受更低成本的初始投資方案以及更低的總擁有成本。

隨著大語言模型的服務器集群的需求增長,液冷方案有望成為主流。過去三十年液冷的市場份額估計都不到1%,但數據中心對液冷方案的采用逐漸增多,這一市占有望提高到15%以上。

不斷拓展液冷型產品線

NVIDIA創始人兼首席執行官黃仁勛對于Supermicro的設計給出高度評價,他表示生成式AI正在推動整個計算堆棧的重置,新的數據中心將會通過GPU進行計算加速,并針對AI優化。Supermicro設計了頂尖的NVIDIA加速計算和網絡解決方案,使價值數兆美元的全球數據中心能夠針對AI時代優化。

Supermicro目前的生成式AI SuperCluster液冷型產品包括Supermicro NVIDIA HGX H100/H200 SuperCluster,具有256個H100/H200 GPU,為5個機柜規模的可擴展計算單元(包括1 個專用網絡機柜)。即將推出的SuperCluster液冷型產品包括Supermicro NVIDIA HGX B200 SuperCluster液冷型,Supermicro NVIDIA GB200 NVL72 或NVL36 SuperCluster液冷型。

當然除了液冷型之外,也推出了氣冷型產品,例如氣冷型Supermicro NVIDIA HGX H100/H200 SuperCluster,具有256個HGX H100/H200 GPU,為9個機柜規模的可擴展計算單元(包括1個專用網絡機柜),以及后續將推出的Supermicro NVIDIA HGX B100/B200 SuperCluster氣冷型。

Supermicro是主流的AI 服務器制造商之一。受益于 ChatGPT 引發的人工智能熱潮,再加上與英偉達的密切合作,這兩年Supermicro業績飆升,并受到資本市場的追捧。如今,Supermicro的液冷服務器技術直擊 AI 處理器功耗高的痛點,技術創新和產能提升下,公司的液冷服務器業務將成為強勁的成長動力。

-

NVIDIA

+關注

關注

14文章

5274瀏覽量

105915 -

gpu

+關注

關注

28文章

4921瀏覽量

130796 -

Supermicro

+關注

關注

0文章

32瀏覽量

9506 -

液冷

+關注

關注

4文章

124瀏覽量

5368

發布評論請先 登錄

硅谷GPU云服務器是什么意思?使用指南詳解

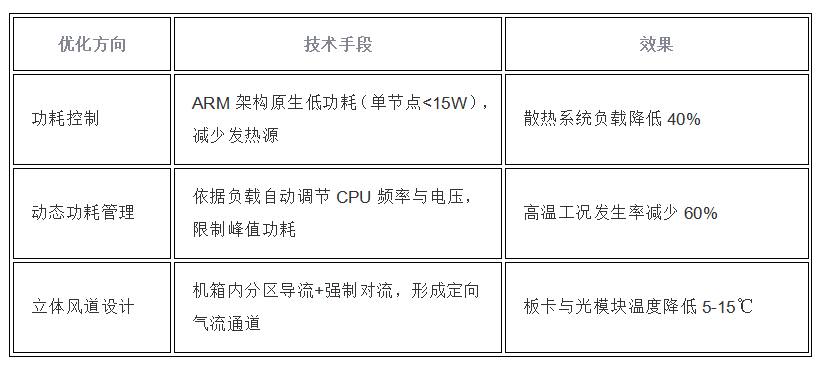

高密度ARM服務器的散熱設計

AI服務器液冷散熱如何實現動態平衡?

影響服務器GPU租用價格的因素

GPU云服務器租用費用貴嗎

GPU云服務器租用多少錢

租用GPU服務器一般多少錢

英偉達CEO確認:液冷Grace Blackwell服務器無過熱問題

ADS1298將SPI提升到更高頻率將無法讀取任何信息,為什么?

GPU高性能服務器配置

gpu服務器與cpu服務器的區別對比,終于知道怎么選了!

算力服務器為什么選擇GPU

NVIDIA最新GPU帶動,液冷服務器市占有望從1%提升到15%

NVIDIA最新GPU帶動,液冷服務器市占有望從1%提升到15%

評論