RNN(Recurrent Neural Network,循環神經網絡)是一種具有循環連接的神經網絡,它能夠處理序列數據,并且具有記憶能力。與傳統的前饋神經網絡(Feedforward Neural Network)相比,RNN能夠處理時間序列數據,例如文本、音頻、視頻等。

- RNN的基本概念

1.1 什么是RNN

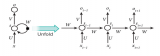

RNN是一種具有循環連接的神經網絡,其核心思想是將前一個時間步的輸出作為下一個時間步的輸入,從而實現對時間序列數據的處理。RNN的循環結構使得網絡能夠在處理當前時間步的數據時,考慮到之前時間步的信息,從而實現對時間序列數據的建模。

1.2 RNN的特點

RNN具有以下特點:

(1)能夠處理序列數據:RNN能夠處理時間序列數據,例如文本、音頻、視頻等。

(2)具有記憶能力:RNN的循環結構使得網絡能夠在處理當前時間步的數據時,考慮到之前時間步的信息。

(3)參數共享:RNN在處理序列數據時,共享相同的權重矩陣,從而減少了模型的參數數量。

(4)梯度消失和梯度爆炸問題:由于RNN的循環結構,網絡在訓練過程中容易出現梯度消失和梯度爆炸問題。

- RNN的原理

2.1 RNN的基本結構

RNN的基本結構包括輸入層、隱藏層和輸出層。輸入層接收序列數據的輸入,隱藏層負責處理輸入數據并生成狀態,輸出層根據隱藏層的狀態生成最終的輸出。

2.2 RNN的前向傳播

RNN的前向傳播過程如下:

(1)初始化隱藏狀態:在序列的第一個時間步,初始化隱藏狀態為零向量或隨機向量。

(2)計算隱藏狀態:對于序列中的每個時間步,計算隱藏狀態。隱藏狀態的計算公式為:

h_t = f(W * x_t + U * h_(t-1) + b)

其中,h_t表示當前時間步的隱藏狀態,x_t表示當前時間步的輸入,W表示輸入到隱藏層的權重矩陣,U表示前一時間步隱藏狀態到當前時間步隱藏層的權重矩陣,b表示隱藏層的偏置項,f表示激活函數。

(3)計算輸出:根據隱藏狀態計算輸出。輸出的計算公式為:

y_t = g(V * h_t + c)

其中,y_t表示當前時間步的輸出,V表示隱藏層到輸出層的權重矩陣,c表示輸出層的偏置項,g表示激活函數。

2.3 RNN的反向傳播

RNN的反向傳播過程如下:

(1)計算梯度:根據輸出層的損失函數,計算輸出層到隱藏層的梯度。

(2)通過時間反向傳播:從序列的最后一個時間步開始,逆序地計算每個時間步的梯度。對于每個時間步,梯度的計算公式為:

d_h_t = (d_y_t * V^T) + d_h_(t+1) * U^T

其中,d_h_t表示當前時間步隱藏狀態的梯度,d_y_t表示輸出層的梯度,V^T表示權重矩陣V的轉置,d_h_(t+1)表示下一時間步隱藏狀態的梯度,U^T表示權重矩陣U的轉置。

(3)更新參數:根據梯度和學習率更新網絡的參數。

- RNN的結構

3.1 基本RNN

基本RNN是最簡單的RNN結構,它只包含一個隱藏層。基本RNN在處理序列數據時,每個時間步的隱藏狀態只考慮前一個時間步的信息。

3.2 長短期記憶網絡(LSTM)

LSTM是一種特殊的RNN結構,它通過引入門控機制解決了RNN的梯度消失問題。LSTM包含三個門:輸入門、遺忘門和輸出門。輸入門控制當前時間步的輸入信息,遺忘門控制前一個時間步的信息,輸出門控制當前時間步的輸出信息。

3.3 門控循環單元(GRU)

GRU是另一種特殊的RNN結構,它在LSTM的基礎上進行了簡化。GRU只包含兩個門:更新門和重置門。更新門控制當前時間步的信息,重置門控制前一個時間步的信息。

-

音頻

+關注

關注

29文章

3025瀏覽量

83046 -

神經網絡

+關注

關注

42文章

4808瀏覽量

102797 -

數據

+關注

關注

8文章

7241瀏覽量

91020 -

rnn

+關注

關注

0文章

89瀏覽量

7061

發布評論請先 登錄

什么是RNN (循環神經網絡)?

機器翻譯三大核心技術原理 | AI知識科普 2

遞歸神經網絡(RNN)

神經網絡中最經典的RNN模型介紹

rnn是什么神經網絡

rnn是什么神經網絡

評論