目前,從單攝像頭中進行動作捕捉(motioncapture)的最好方法是優化驅動的:通過優化3D人體模型的參數從而使二次投影與視頻中的測量結果相匹配(例如,人像分割、光流、關鍵點檢測等)。優化模型容易受到局部最小值(local minima)的影響。這成為了限制動作捕捉的瓶頸,致使每次捕捉動作時必須用干凈的綠布作為背景,并且要手動初始化或切換成多攝像頭作為輸入源。在本項研究中,我們提出了一個用于單攝像頭輸入的基于學習的動作捕捉模型。我們的模型沒有直接優化網格和骨骼參數,而是通過優化神經網絡權重來預測給定單目RGB視頻的3D形狀和骨骼構造。我們的的模型是使用來自合成數據的強監督與來自一個端到端框架中(a)骨骼關鍵點(b)密集型網格運動(c)人物背景分割可微渲染中的自監督進行聯合訓練的通過檢驗,我們證實,我們的模型結合了監督學習和測試時間優化二者的優點:監督學習在適時情況下初始化參數,在測試中確保良好的姿態和表面初始化,不需要手動操作。通過可微渲染的反向傳播進行的自監督,使得(無監督的)模型適應測試數據,并且相較預訓練固定模型而言,可提供更好的擬合性。我們在此表示,此次提出的模型將隨著經驗的不斷積累,以及總結過去的低誤差解決方案而不斷改進。

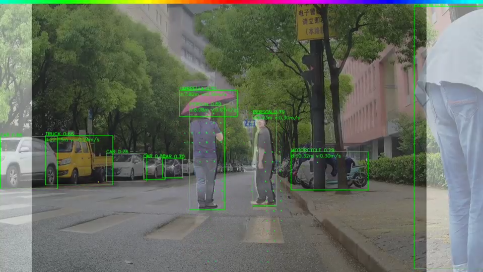

從“自然環境下”的單目裝置中詳細了解人體及其運動將為自動化健身房、舞蹈教師、康復指導、患者監護以及更安全的人機交互的應用開辟道路。這也會影響到電影行業,因為目前,人物動作捕捉(MOCAP)和重定向,仍需要藝術家花費繁重的勞動力,或者使用昂貴的多攝像機設置和綠屏才能達到理想的精度。

當前,大多數動作捕捉系統都是優化驅動,其并不能從經驗中獲益。單目動作捕捉系統優化3D人體模型的參數以在視頻中與測量結果相匹配(如人像分割、光流等)。背景雜亂和優化困難顯著影響追蹤性能,這導致過去在工作中總使用綠色的背景幕布,并且進行細致的初始化工作。此外,通過這些費力的方法所捕捉到的動作數據,并不能隨著時間的推移而改進。這意味著每次處理視頻時,都需要從頭重復進行優化和手動操作。

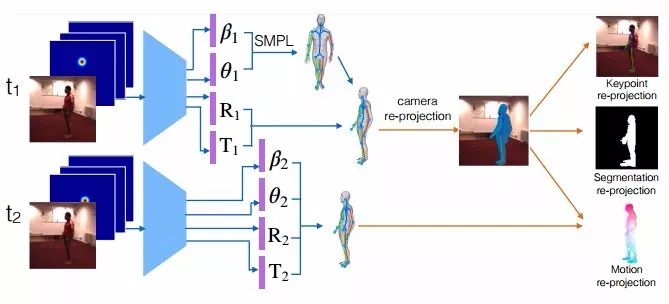

圖1 動作捕捉的自監督學習

給定一個視頻序列和一組2D肢體關節熱圖,我們的網絡可預測SMPL3D人體網格模型的肢體參數。神經網絡權重使用合成數據進行預訓練,并使用可微關鍵點、分割和二次投影誤差分別針對檢測到的2D關鍵點、2D分割和2D光流的自監督缺失驅動(self-supervised losses driven)進行微調。通過在測試時運用自監督損失(self-supervised losses)微調其參數,本文提出的模型要比基于模型的純監督或純優化具有更高的3D重建精度。其中,基于模型的純監督或純優化模型既不能適應也不能從訓練數據中受益。

我們提出了一個在單目視頻中進行動作捕捉的神經網絡模型,學習將一個圖像序列映射到一個相應的3D網格序列中。深度學習模型的成功在于從大規模注釋數據集中進行監督。然而,詳細的3D網格標注是非常繁瑣而耗時的,因此在實際生活中,大規模的標注3D人體姿態是不現實的。在真實視頻中,我們的工作通過將手動渲染模型的大規模合成數據中的強監督、與3D關鍵點的3D轉2D可微渲染、動作和分割以及真實獨目視頻中2D相應檢測量的匹配中所包含的監督相結合,從而避免了真實視頻中缺乏3D網格注釋這一問題。我們的自監督利用了2D身體關節檢測、2D圖底分割和2D光流技術的最新研發成果,分別使用真實或合成數據集(如MPII、COCO和flying chairs)的強大監督進行學習。事實上,注釋2D身體關節比注釋3D關節或3D網格更容易,而光流被證明可以很容易地從合成數據泛化到真實數據。我們展示了最先進的2D關節、光流和2D人像分割模型是如何用于推理出自認環境下視頻中密集的3D人體結構的,而這些工作是難以通過手動操作來完成。與之前基于優化的動作捕捉研究相比,我們現在對光流和分割損耗使用的可微變形(differentiable warping)和可微相機投影技術,使得模型可以通過標準的反向傳播進行端對端的訓練。

我們使用SMPL作為我們的密集人體3D網格模型。它由一定數量的固定拓撲結構頂點和三角形拓撲結構組成,其中,全局姿勢由身體各部分之間的角度θ控制,局部姿勢由網格表面參數β控制。對于給定姿勢和表面參數,密集網格可以以一種分析法(可微分)形式生成,然后將其全局旋轉并轉換到期望的位置。我們模型的任務是對渲染過程進行逆向工程,并且預測SMPL模型(θ和β)的參數以及每個輸入幀中的焦距、3D旋轉和3D翻譯,在檢測到的人身周圍提供圖像分割。

給定兩個連續幀中的3D網絡預測,我們可以對網格頂點的3D動作向量進行差分投影,并將它們與已評估的2D可見光流向量進行有針對性的匹配(圖1)。可微動作渲染和匹配需要對頂點可見性進行評估,對于這一點,我們使用光線投射(ray casting),以及用來執行代碼加速的我們神經模型實現。類似地,在每一幀中,3D關鍵點都會被投影,并且他們與相應被檢測到的2D關鍵點之間的距離將會被懲罰。最后,重要的是,可微分割匹配使用倒角距離(Chamferdistances)針對人類前景2D分割的投影頂點的欠擬合和過度擬合進行懲罰。請注意,由于3D網格是無紋理的,因此我們的預測中,二次投影的誤差只存在于形態上而非設計的紋理上。

我們提供了在SURREAL和H3.6M數據集上進行的3D密集型人體形態追蹤的定量和定性分析結果。我們將其與相應的優化版本進行比較,在這些版本中,網格參數通過最小化我們的自監督損失而優化,并且在測試時不使用自監督,進而達到屏蔽監督模型的效果。優化基線很容易陷入局部極小值,而且它對初始化非常敏感。相比之下,我們的基于學習的MOCAP模型通過預訓練(合成數據)可在測試時提供良好的姿態初始化。此外,自監督適應模型比預訓練的非適應模型的3D重建誤差低。最后,我們的ablation研究突出了三種自監督損失的互補性。

相關研究

3D動作捕捉

使用多臺攝像機進行3D動作捕捉(四個或四個以上)是一個已被詳細研究的問題,其中現有的方法取得了令人印象深刻的結果。然而,即使對于僅有骨架的捕捉/追蹤,單個單目照相機的動作捕捉仍是一個尚待解決的問題。由于單目動作捕捉中的模糊和遮擋可能是嚴重的,大多數方法依賴于先前的姿勢和動作模型。早期的研究考慮線性動作模型。諸如高斯過程動力學模型、以及雙高斯過程這樣的非線性先驗,都已經被提出,并且被證明優于其線性對應結構。最近,Bogo等人提出了一種靜態圖像姿勢和3D密集形狀預測模型,其工作分為兩個階段:首先,從圖像中預測一個三維人體骨架,然后使用優化過程將參數3D形狀擬合到預測骨架,在此過程中骨架保持不變。相反,我們的研究通過測試時間適應,將3D骨架和3D網格估計結合到一個端到端的可微框架中。

3D人體姿態評估

早期的3D姿態評估研究考慮了優化方法和硬編碼的擬人約束(anthropomorphic constraints)(例如肢體對稱),以消除2D-to-3D提升期間的模糊性,。許多最近研究使用深度神經網絡和大型監督訓練集,對于給定給定RGB圖像,學習直接復歸為3D人體姿勢。一些研究已經探索使用2D身體姿態作為中間表征,或者作為多任務設置中的輔助任務,其中豐富的被標注的2D姿勢訓練實例有助于特征學習,并補充有限的3D人體姿勢監督,這需要一個Vicon系統,因此被限制只能在實驗室儀器化的環境中進行。Rogez和Schmid通過將合成的3D人體模型與逼真的背景相結合,獲得了大規模的RGB到3D的合成注釋,也在這項研究中使用的數據集。

深度幾何學習

我們的可微渲染器遵循最近將深度學習和幾何推理相結合的研究。可微變形和可后置攝像頭投影已經被用于學習3D攝像機動作,以及學習一個以端到端的自監督的方式進行的3D攝像機和3D物體聯合動作,從而使光度損失最小化。Garg等人學習單目深度預測器,由光度誤差監督,給定一個立體圖像且已知基線作為輸入。《gvnn:幾何計算機視覺的神經網絡庫》中貢獻了一個深度學習庫,有許多幾何操作,包括一個可后置的攝像頭投影層,類似于Yan等人和吳等人所使用的攝像頭。

結論

我們已經提出了一個基于學習的用于密集人體3D動作追蹤的模型,用合成數據進行監督,并并通過動網格、關鍵點和分割的可微渲染進行自監督,并與2D等價量相匹配。我們發現,我們的模型通過使用未標記的視頻數據得到了改進,這對于動作捕捉非常有價值,其中,密集3D對照數據難以進行標記。未來研究的一個明確方向是對網格參數的迭代加性反饋,以獲得更高的3D重建精度,然后同樣以自監督的方式,在參數SMPL模型的頂部學習殘差自由形態變形(residual free formdeformation)。 我們的模型在人類3D姿勢之外的擴展將使神經智能體以人類的經驗學習3D,而其僅由視頻動作進行監督。

-

攝像頭

+關注

關注

61文章

4960瀏覽量

97833 -

RGB

+關注

關注

4文章

804瀏覽量

59685

原文標題:卡內基梅隆大學提出基于學習的動作捕捉模型,用自監督學習實現人類3D動作追蹤

文章出處:【微信號:AItists,微信公眾號:人工智能學家】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

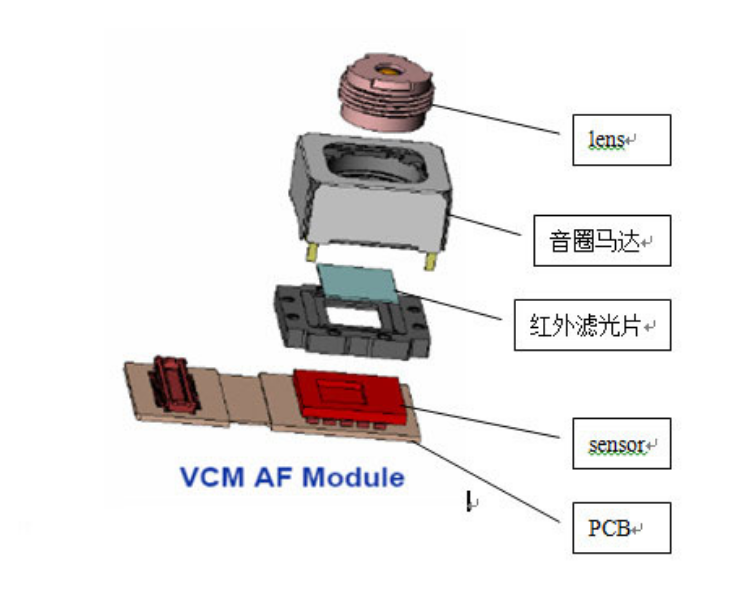

一文聊聊自動駕駛攝像頭

社區安裝IPC攝像頭,跟安裝一般安防監控攝像頭有什么區別?

攝像頭及紅外成像的基本工作原理

單攝像頭輸入的基于學習的動作捕捉模型實例分析

單攝像頭輸入的基于學習的動作捕捉模型實例分析

評論