隨著人工智能 (AI) 的演進,人們對使用小語言模型 (SLM) 在嵌入式設備上執行 AI 工作負載的興趣愈發高漲。

以下的演示展現了端點 AI 在物聯網和邊緣計算領域的發展潛力。在此演示中,當用戶輸入一個句子后,系統將基于該句擴展生成一個兒童故事。這項演示受到了微軟“Tiny Stories”論文和 Andrej Karpathy 的 TinyLlama2 項目的啟發,TinyLlama2 項目使用了 2,100 萬個故事來訓練小語言模型生成文本。

該演示搭載了 Arm Ethos-U85 NPU,并在嵌入式硬件上運行小語言模型。盡管大語言模型 (LLM) 更加廣為人知,但由于小語言模型能夠以更少的資源和較低的成本提供出色的性能,而且訓練起來也更為簡易且成本更低,因此越來越受到關注。

在嵌入式硬件上實現

基于 Transformer 的小語言模型

我們的演示展示了 Ethos-U85 作為一個小型低功耗平臺,具備運行生成式 AI 的能力,并凸顯了小語言模型在特定領域中的出色表現。TinyLlama2 模型相較 Meta 等公司的大模型更為簡化,很適合用于展示 Ethos-U85 的 AI 性能,可作為端點 AI 工作負載的理想之選。

為開發此演示,我們進行了大量建模工作,包括創建一個全整數的 INT8(和 INT8x16)TinyLlama2 模型,并將其轉換為適合 Ethos-U85 限制的固定形狀 TensorFlow Lite 格式。

我們的量化方法表明,全整數語言模型在取得高準確度和輸出質量之間實現了良好平衡。通過量化激活、歸一化函數和矩陣乘法,我們無需進行浮點運算。由于浮點運算在芯片面積和能耗方面成本較高,這對于資源受限的嵌入式設備來說是一個關鍵考量。

Ethos-U85 在 FPGA 平臺上以 32 MHz 的頻率運行語言模型,其文本生成速度可達到每秒 7.5 到 8 個詞元 (token),與人類的閱讀速度相當,同時僅消耗四分之一的計算資源。在實際應用的系統級芯片 (SoC) 上,該性能最多可提高十倍,從而顯著提升了邊緣側 AI 的處理速度和能效。

兒童故事生成特性采用了 Llama2 的開源版本,并結合了 Ethos NPU 后端,在 TFLite Micro 上運行演示。大部分推理邏輯以 C++ 語言在應用層編寫,并通過優化上下文窗口內容,提高了故事的連貫性,確保 AI 能夠流暢地講述故事。

由于硬件限制,團隊需要對 Llama2 模型進行適配,以確保其在 Ethos-U85 NPU 上高效運行,這要求對性能和準確性進行仔細考量。INT8 和 INT16 混合量化技術展示了全整數模型的潛力,這有利于 AI 社區更積極地針對邊緣側設備優化生成式模型,并推動神經網絡在如 Ethos-U85 等高能效平臺上的廣泛應用。

Arm Ethos-U85 彰顯卓越性能

Ethos-U85 的乘法累加 (MAC) 單元可以從 128 個擴展至 2,048 個,與前一代產品 Ethos-U65 相比,其能效提高了 20%。另外相較上一代產品,Ethos-U85 的一個顯著特點是能夠原生支持 Transformer 網絡。

Ethos-U85 支持使用前代 Ethos-U NPU 的合作伙伴能夠實現無縫遷移,并充分利用其在基于 Arm 架構的機器學習 (ML) 工具上的既有投資。憑借其卓越能效和出色性能,Ethos-U85 正愈發受到開發者青睞。

如果在芯片上采用 2,048 個 MAC 配置,Ethos-U85 可以實現 4 TOPS 的性能。在演示中,我們使用了較小的配置,即在 FPGA 平臺上采用 512 個 MAC,并以 32 MHz 的頻率運行具有 1,500 萬個參數的 TinyLlama2 小語言模型。

這一能力凸顯了將 AI 直接嵌入設備的可能性。盡管內存有限(320 KB SRAM 用于緩存,32 MB 用于存儲),Ethos-U85 仍能高效處理此類工作負載,為小語言模型和其他 AI 應用在深度嵌入式系統中的廣泛應用奠定了基礎。

將生成式 AI 引入嵌入式設備

開發者需要更加先進的工具來應對邊緣側 AI 的復雜性。Arm 通過推出 Ethos-U85,并支持基于 Transformer 的模型,致力于滿足這一需求。隨著邊緣側 AI 在嵌入式應用中的重要性日益增加,Ethos-U85 正在推動從語言模型到高級視覺任務等各種新用例的實現。

Ethos-U85 NPU 提供了創新前沿解決方案所需的卓越性能和出色能效。我們的演示顯示了將生成式 AI 引入嵌入式設備的重要進展,并凸顯了在 Arm 平臺上部署小語言模型便捷可行。

Arm 正為邊緣側 AI 在廣泛應用領域帶來新機遇,Ethos-U85 也因此成為推動新一代智能、低功耗設備發展的關鍵動力。

-

ARM

+關注

關注

134文章

9347瀏覽量

377015 -

嵌入式

+關注

關注

5148文章

19645瀏覽量

317021 -

物聯網

+關注

關注

2930文章

46188瀏覽量

391608 -

AI

+關注

關注

88文章

35008瀏覽量

278766

原文標題:Arm Ethos-U85 NPU:利用小語言模型在邊緣側實現生成式 AI

文章出處:【微信號:Arm社區,微信公眾號:Arm社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

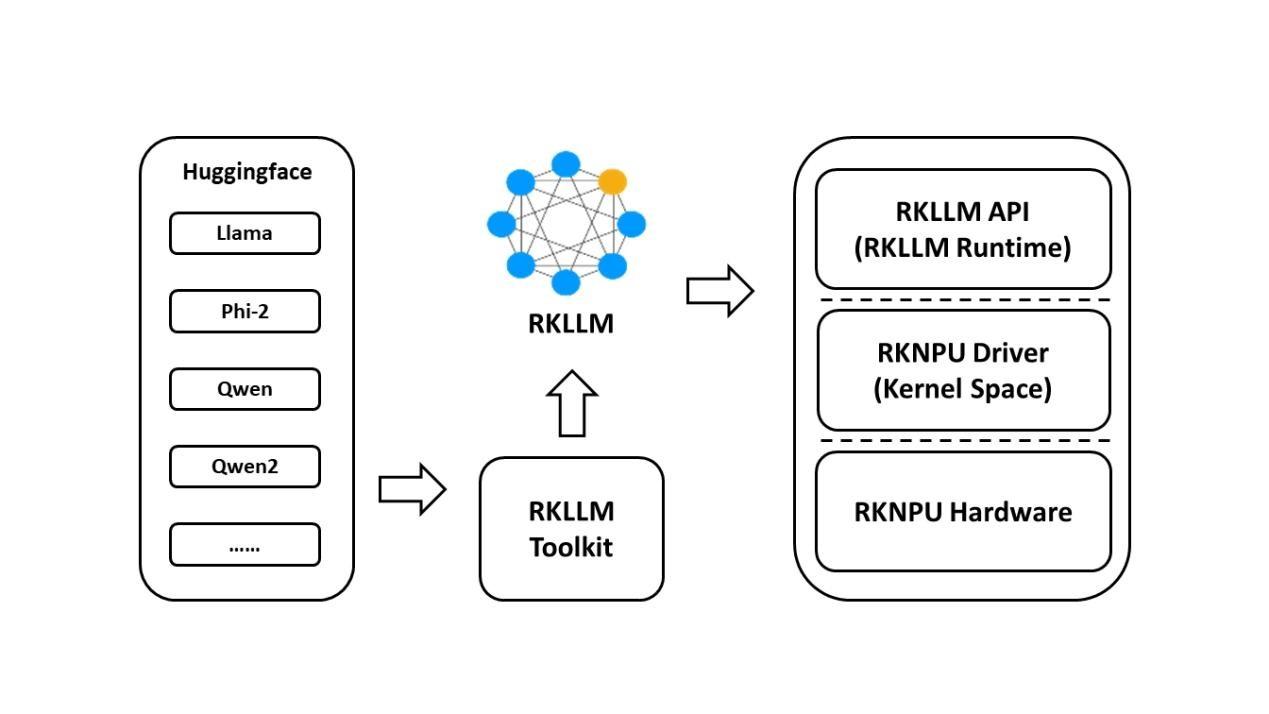

基于RK3576開發板的RKLLM大模型部署教程

后摩智能NPU適配通義千問Qwen3系列模型

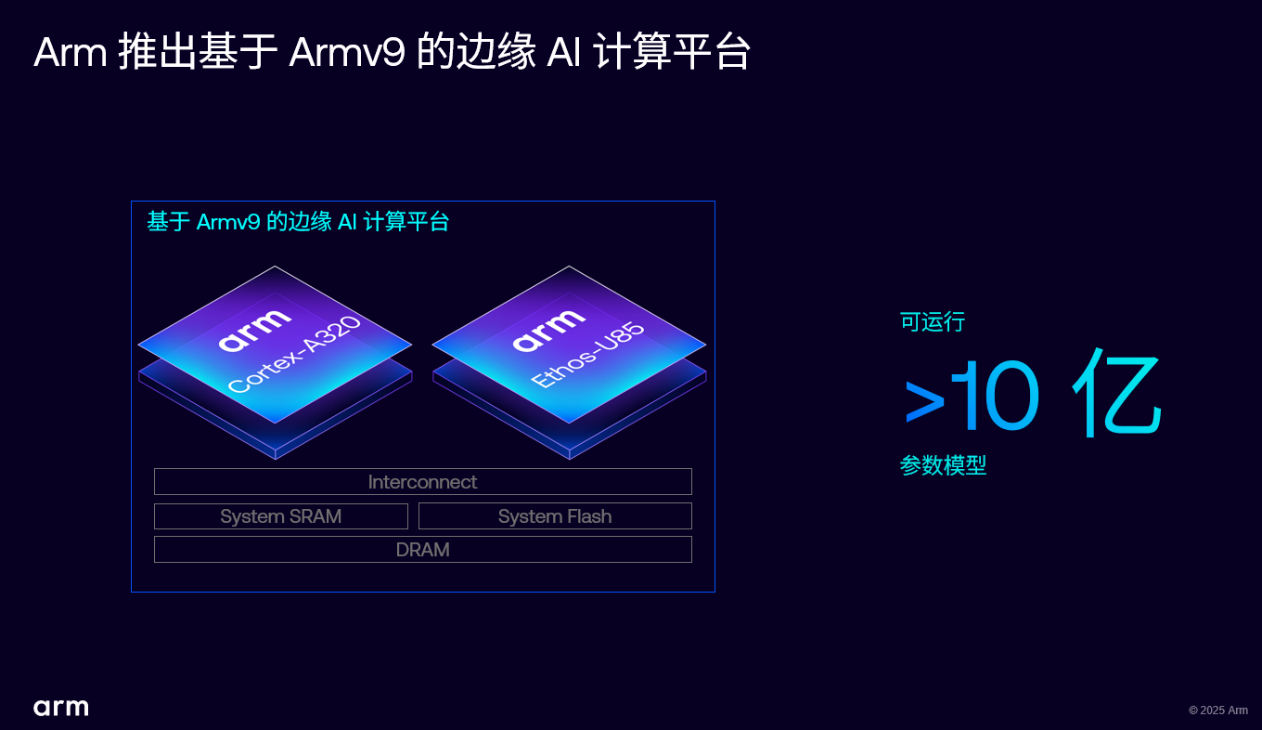

Arm 推出 Armv9 邊緣 AI 計算平臺,以超高能效與先進 AI 能力賦能物聯網革新

Arm推出全球首個Armv9邊緣AI計算平臺

RK3588開發板上部署DeepSeek-R1大模型的完整指南

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

如何在Arm Ethos-U85上使用ExecuTorch

云端語言模型開發方法

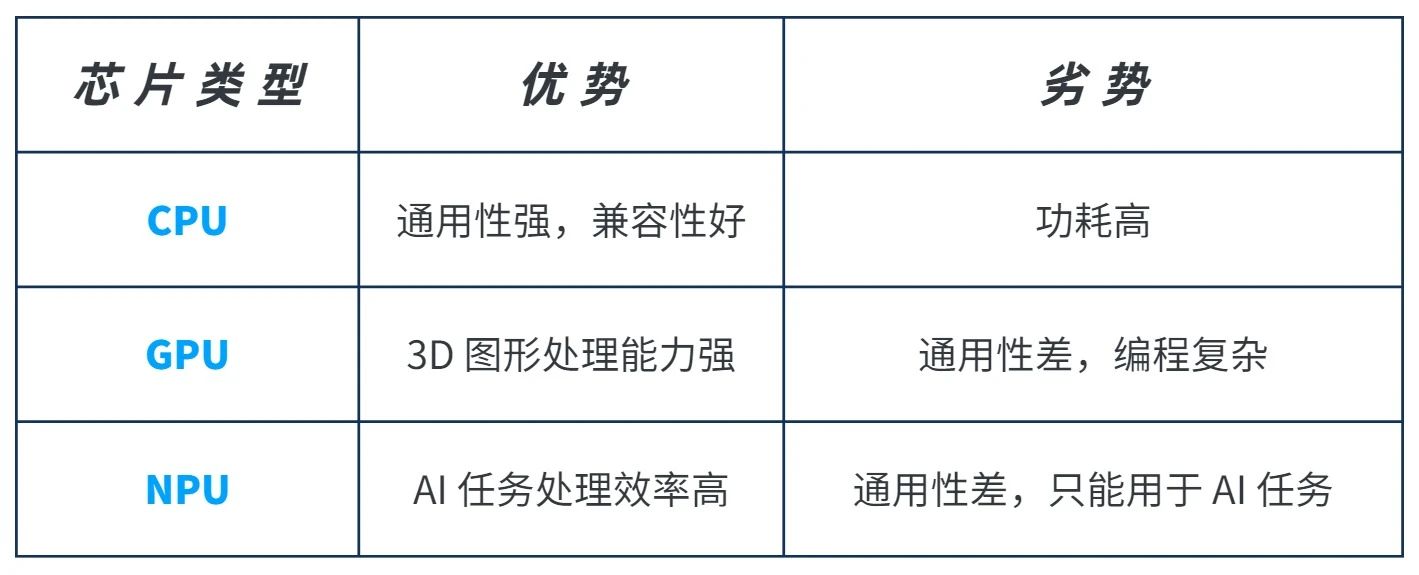

NPU支持的編程語言有哪些

什么是NPU?什么場景需要配置NPU?

如何利用ARMxy ARM嵌入式計算機的NPU進行深度學習模型的訓練和優化?

基于Arm Ethos-U85 NPU部署小語言模型

基于Arm Ethos-U85 NPU部署小語言模型

評論