前言

在RT-Thread論壇上忽然看到了單片機和大模型對話的文章,想著春節期間看到大語言模型的熱度持續攀升,恰巧手頭有塊RA8D1 Vision Board開發板,于是嘗試著在Vision Board上對接下大語言模型的API,實現智能對話功能。

測試平臺

●Vision Board

●RT-Thread Studio

●RT-Thread 5.0.2

●MobaXterm

實現過程(以Vision Board為例)

1. 登錄 DeepSeek-API :

https://api-docs.deepseek.com/zh-cn/

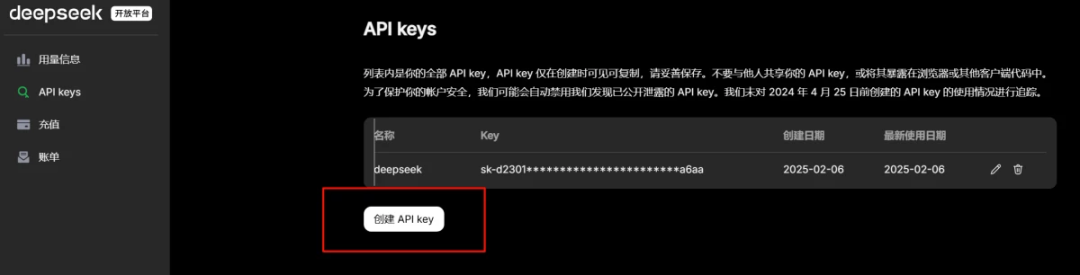

2. 創建 DeepSeek 的API-KEY:

3. 基于Vision Board新建wifi示例工程

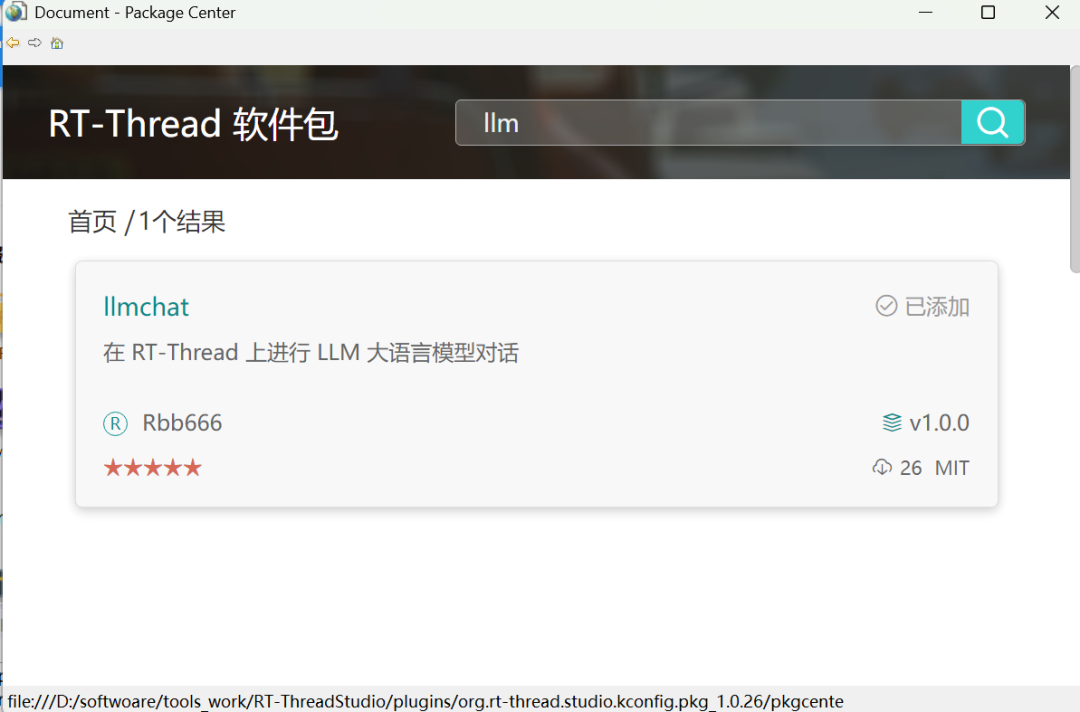

4. 配置LLM軟件包:雙擊 RT-Thread Settings,選擇添加軟件包,搜索llm關鍵字

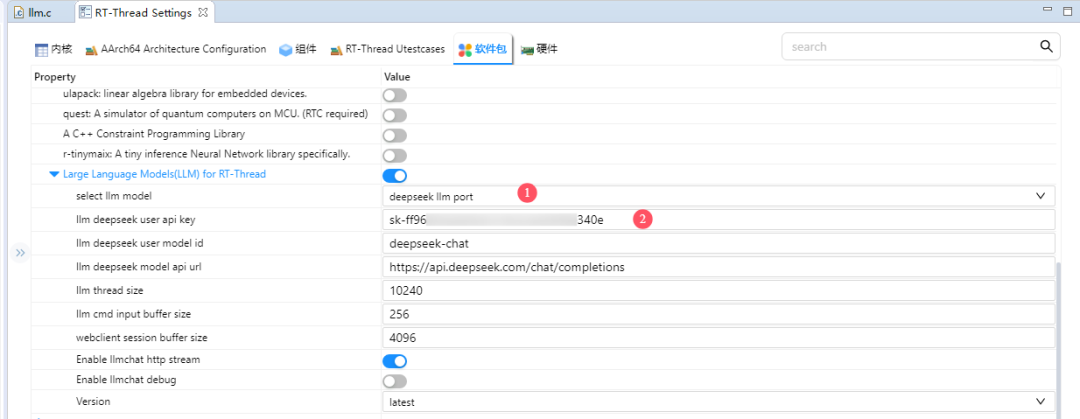

5. 添加此軟件包到工程,接下來進行軟件包配置,輸入上面獲取的API-KEY:

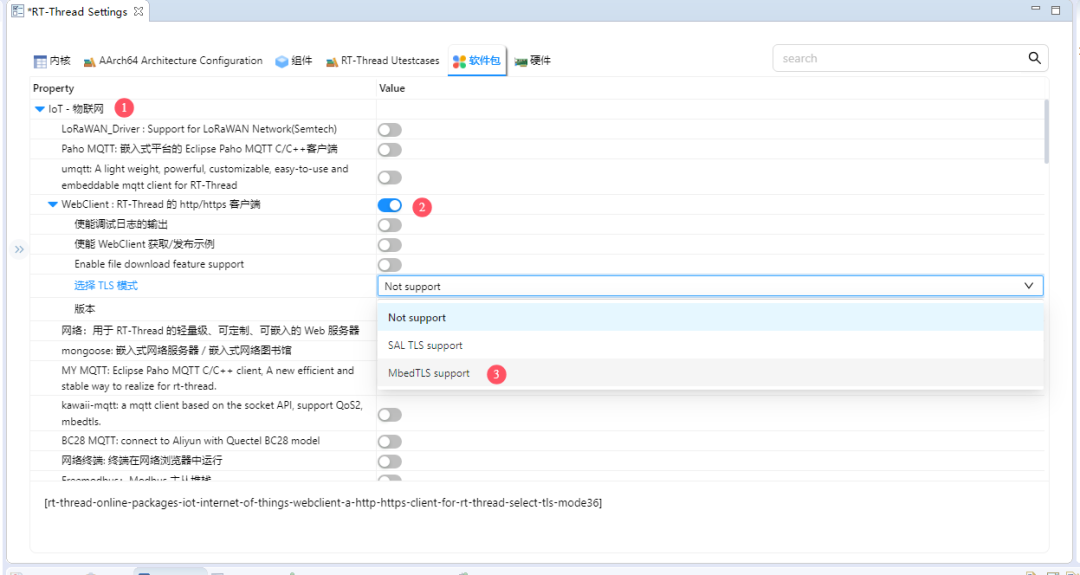

6. 配置WebClient-TLS模式:

在RT-Thread Settings->軟件包->IoT-物聯網->WebClient->選擇TLS模式目錄下,選擇MbedTLS support。

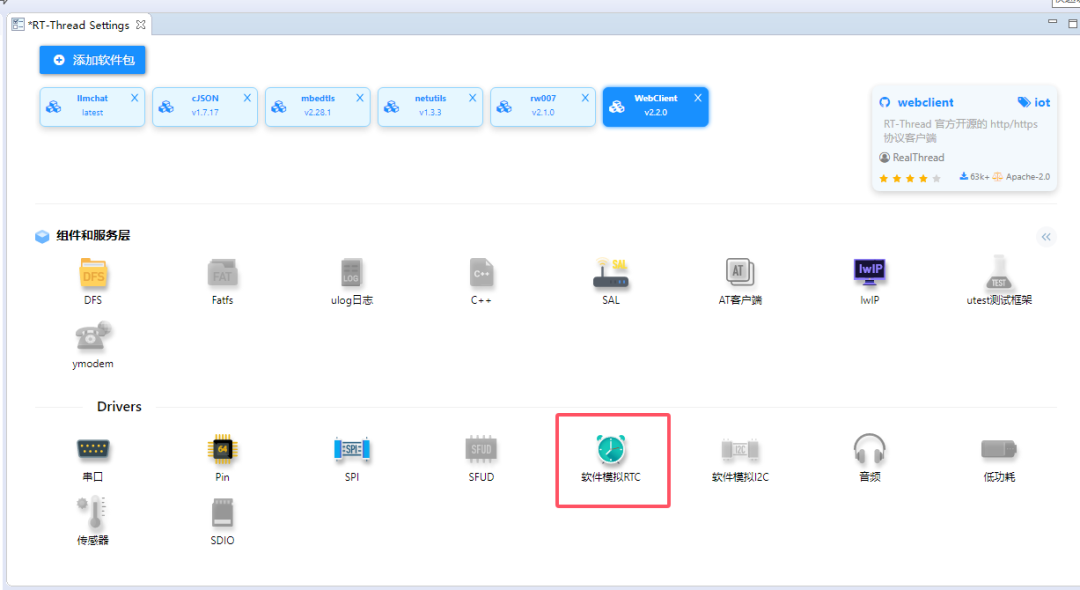

7. 使能軟件RTC功能

8. 更新軟件包配置:

在RT-Thread Settings界面下Ctrl+S保存軟件包配置,隨后編譯代碼,燒錄即可。

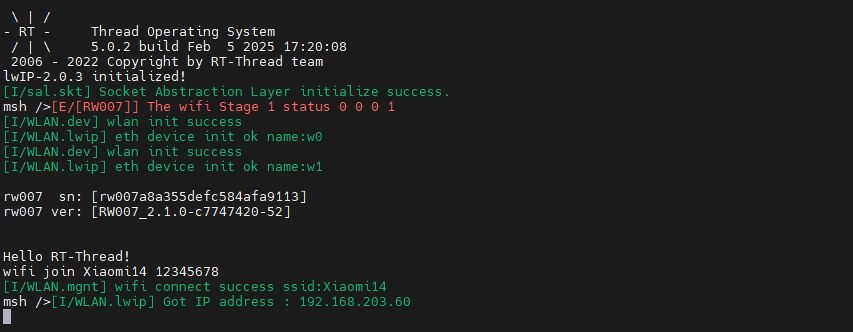

9. 開發板手動連接Wifi:

打開串口終端工具,輸入wifi join [wifi名稱] [wifi密碼]

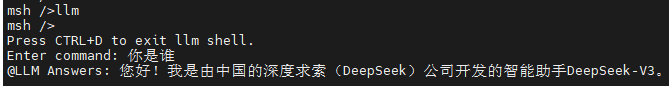

10. 輸入llm即可進入聊天終端,CTRL+D可以退出聊天窗口返回MSH終端:

開源倉庫地址,歡迎體驗~

https://github.com/Rbb666/llm_chat

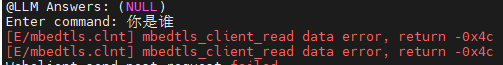

注意:由于當前Deepseek服務器資源緊張,可能會出現連接失敗,導致如下報錯:

可嘗試切換豆包或阿里通義千問大語言模型進行體驗。

-

單片機

+關注

關注

6067文章

44997瀏覽量

650734 -

語言模型

+關注

關注

0文章

561瀏覽量

10801 -

DeepSeek

+關注

關注

2文章

798瀏覽量

1772

發布評論請先 登錄

RT-Thread上CAN實踐

RT-Thread NUC97x 移植 LVGL

如何將RT-Thread移植到NXP MCUXPressoIDE上

如何在rt-thread studio上開發STM32H747IIT6?

RT-Thread上的CAN總線介紹以及驅動編寫

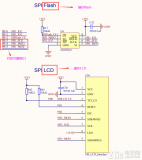

RT-Thread上SPI的細節內容

RT-Thread AI kit開源:輕松實現一鍵部署AI模型至 RT-Thread

【嵌入式AI入門日記】將 AI 模型移植到 RT-Thread 上(1)

RT-Thread全球技術大會:RT-Thread上的單元測試框架與運行測試用例

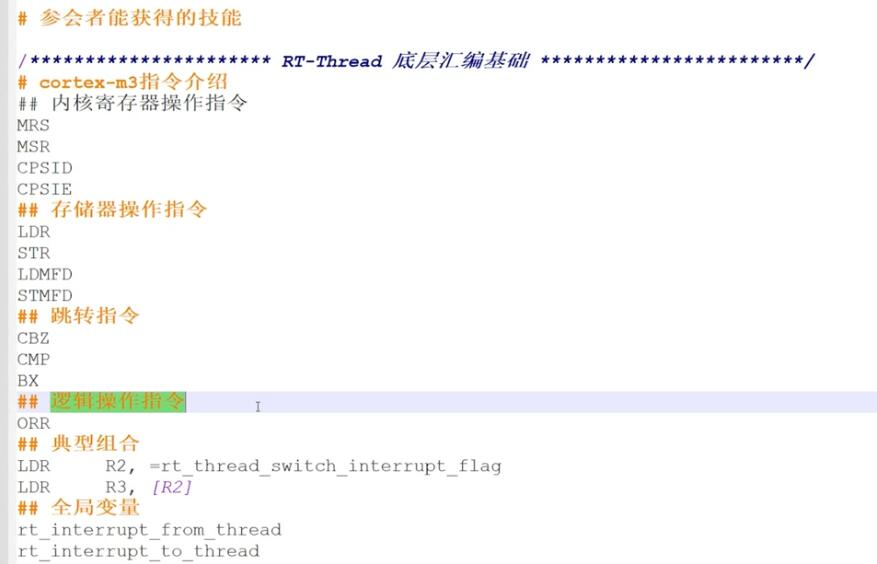

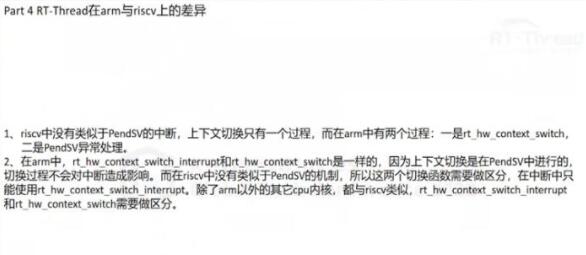

RT-Thread全球技術大會:RT-Thread底層匯編及在arm與riscv上的差異

Deepseek上單片機?RT-Thread上跑通大語言模型

Deepseek上單片機?RT-Thread上跑通大語言模型

評論