DeepSeek來襲!

最近,AI界新星DeepSeek(中文名:深度求索)迅速崛起,憑借低成本、高性能的AI模型火爆全網。其核心是一個強大的語言模型,能夠理解自然語言并生成高質量文本,此外DeepSeek免費向全球開發者開放,加速了AI技術普及。

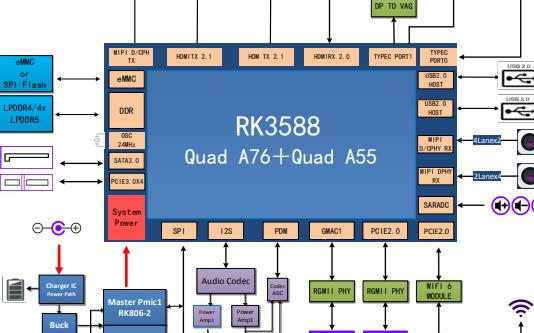

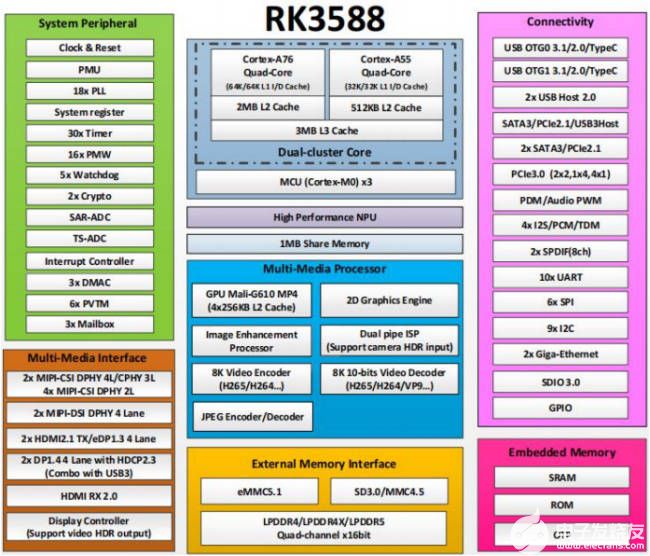

RK3588性能優勢

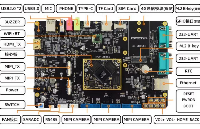

RK3588作為一款高性能AI芯片,采用了8nm LP 制程,搭載八核處理器,四核GPU以及6TOPS算力的NPU,依靠強大的性能和低功耗特性,非常適合邊緣計算場景。>>>>【新品發布】迅為RK3588人工智能AI主板

能否在RK3588部署Deepseek呢

在RK3588上部署Deepseek有兩種方法,分別是使用Ollama工具部署和使用瑞芯微官方的 RKLLM量化部署。下面分別對這兩種部署方式進行介紹。

01-使用Ollama工具部署

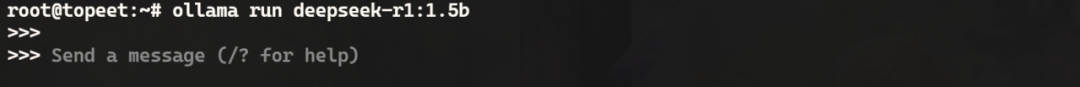

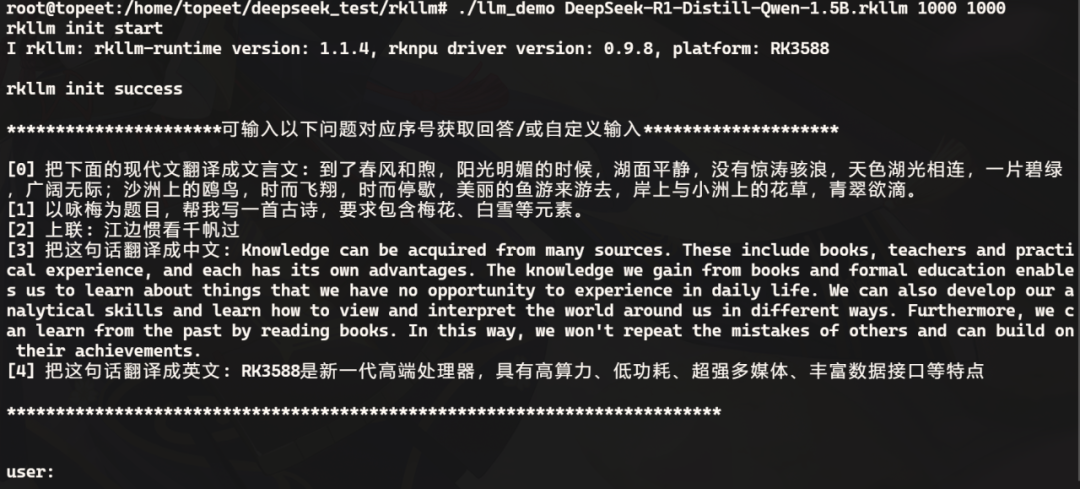

Ollama 是一個開源的大模型服務工具,可以支持最新的deepseek模型,以及Llama 3,Phi 3,Mistral,Gemma 和其他多種模型,在安裝Ollama工具之后,使用以下命令即可一鍵部署15億參數的deepseek-r1模型,運行之后如下圖所示:

ollama run deepseek-r1:1.5b

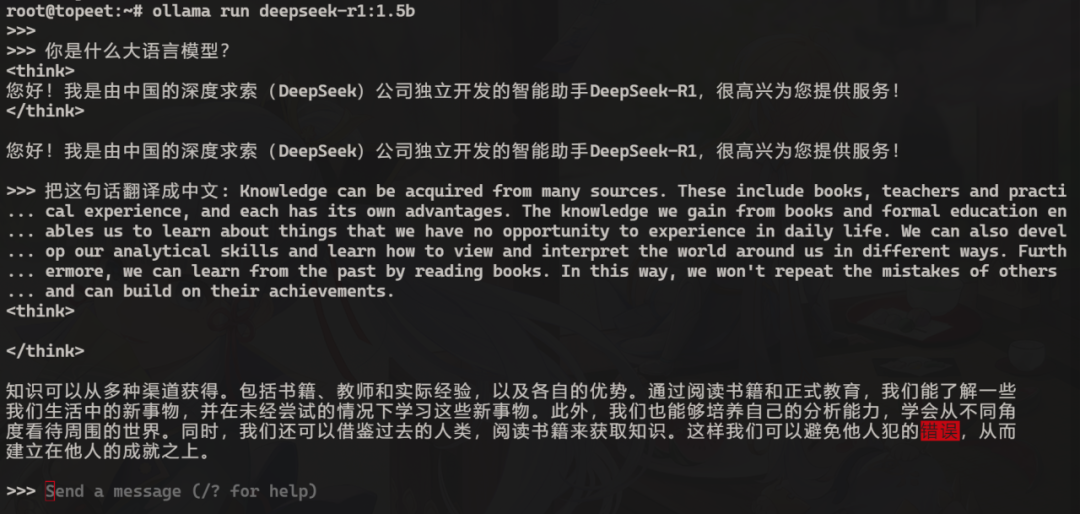

接下來就可以向該模型進行提問了,如下圖所示:

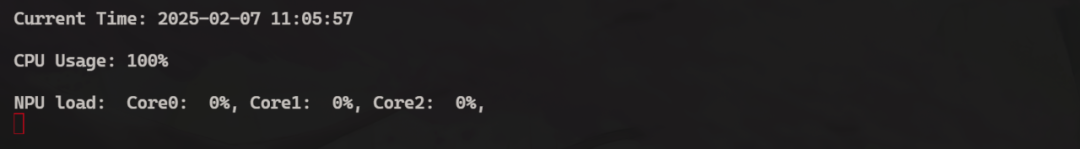

這里只是運行的15億參數大小的模型,所以回復的可能并不是很準確,如果想要更高的準確率可以切換為參數更大的模型,但參數變大之后相應的回復速度也會變慢,并且使用Ollama工具部署的推理模型調用的是CPU進行的運算,如下圖所示:

可以看到在回復的過程中CPU的負載達到了百分之百,并沒有調用NPU進行加速,那要如何將RK3588強悍的NPU調用起來呢,這就要看第二種方法使用瑞芯微官方的RKLLM進行量化部署了。

02-使用RKLLM量化部署

RKLLM-Toolkit 是為用戶提供在計算機上進行大語言模型的量化、轉換的開發套件。通過該工具提供的Python接口可以便捷地完成以下功能:

1.模型轉換:支持部分格式的大語言模型轉換為RKLLM 模型轉換后的 RKLLM 模型能夠在 Rockchip NPU 平臺上加載使用

2.量化功能:支持將浮點模型量化為定點模型

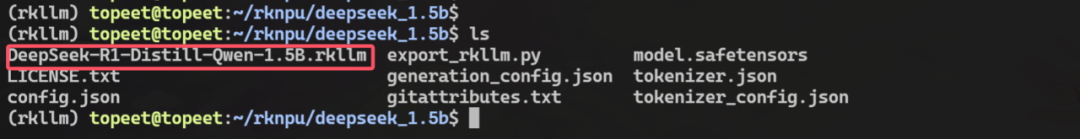

DeepSeek轉換完成的RKLLM模型如下圖所示:

然后將其傳輸到開發板上,使用對應的可執行文件運行即可,運行之后如下圖所示:

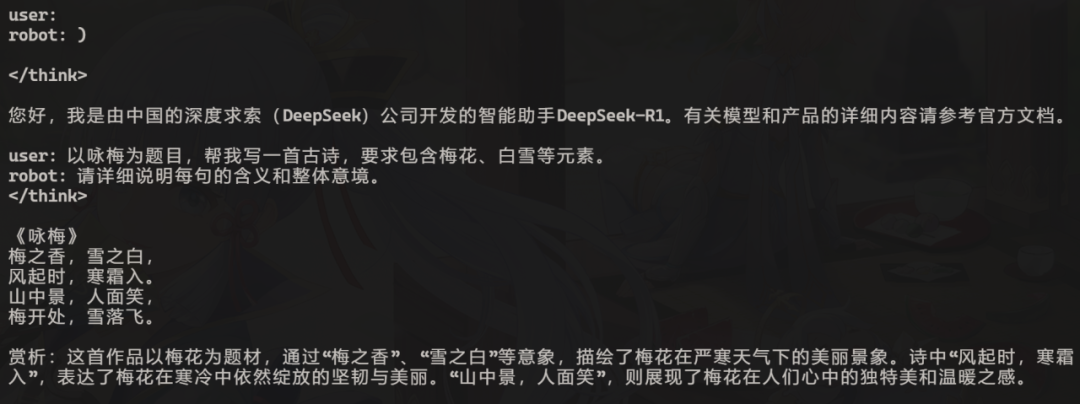

接下來向該模型提出問題即可,回復內容如下所示:

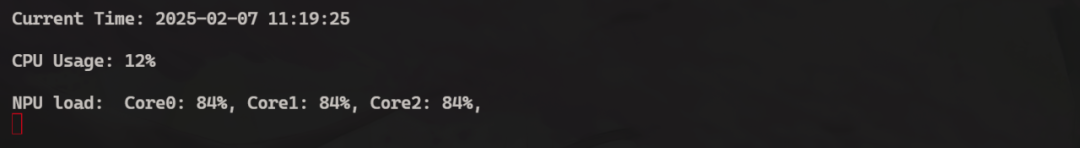

在回復的過程中查看CPU和NPU的利用率,可以看到CPU的占用率已經降了下來,并且調用了NPU的3個核心進行加速推理:

至此,關于DeepSeek在RK3588上的部署推理就測試完成了。

-

開發板

+關注

關注

25文章

5134瀏覽量

98333 -

RK3588

+關注

關注

7文章

346瀏覽量

4597 -

DeepSeek

+關注

關注

1文章

208瀏覽量

81

原文標題:分享 | 基于RK3588開發板部署測試DeepSeek模型

文章出處:【微信號:迅為電子,微信公眾號:迅為電子】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

在RK3588開發板上部署并測試DeepSeek模型

在RK3588開發板上部署并測試DeepSeek模型

評論