隨著深度學習技術的快速發展,大模型(如GPT、BERT等)在自然語言處理、計算機視覺等領域取得了顯著成果。然而,大模型的參數量和計算量極其龐大,傳統的硬件架構或者單臺設備(如單個GPU)難以滿足其計算需求。大模型的特點如下:

1. DeepSeek-R1模型的參數量高達6710億,訓練過程需要數萬臺GPU協同工作。

2. 計算需求:大模型的前向傳播、反向傳播和梯度更新涉及大規模的矩陣運算,單設備無法在合理時間內完成。

3. 內存需求:大模型的參數和中間結果需要大量內存存儲,單設備的內存容量有限。

4. 數據需求:大模型的訓練需要海量數據,單設備難以高效處理。

為提高大模型的計算效率,必須充分利用矩陣和向量運算的內在并行性。大模型訓練的核心流程:前向傳播、反向傳播和梯度更新,均依賴大規模矩陣計算,這為分布式并行提供了天然優勢。目前,主要的并行計算策略包括:

a)數據并行(Data Parallelism):將訓練數據拆分成多個批次或子集,分配到多個設備上執行局部計算。各設備獨立計算梯度后,通過梯度同步或聚合機制實現全局參數更新。

b)模型并行(Model Parallelism):將模型按照參數或模塊劃分,分布到多臺設備上進行計算。當模型單個設備內存難以容納時,模型并行可以有效擴展計算規模。

c)流水線并行(Pipeline Parallelism):將模型按照層級或階段劃分成多個片段,各設備依次負責不同層的計算。數據在設備間依次傳遞,形成一條類似流水線的處理路徑,從而在不同處理階段實現并行性。

分布式計算通過多種并行策略的協同應用,不僅可以突破單設備算力和內存的限制,還能顯著加速大規模深度學習模型的訓練。

在大模型訓練和推理中,GPU雖然是核心計算單元,但其計算能力往往受到數據管理、通信和存儲等任務的限制。DPU(Data Processing Unit,數據處理單元)作為一種新型硬件加速器,正在成為大模型訓練和推理的重要助力。DPU的出現正是為了解決這些問題:

a)卸載GPU的計算負擔:GPU主要負責矩陣運算等核心計算任務,但數據加載、預處理、通信等任務會占用其資源。DPU可以接管這些任務,通過高速I/O接口直接從存儲設備讀取數據,減少CPU的介入。大模型訓練需要頻繁讀取和寫入大量數據(如模型參數、中間結果、數據集等),傳統的存儲系統可能成為瓶頸。DPU支持NVMe over Fabric/RDMA等高速存儲協議,能夠直接從遠程存儲設備讀取數據。讓GPU專注于計算,從而提高整體效率。

b)優化數據預處理與檢索:大模型在訓練階段需要大量的預處理(如圖像增強、文本分詞等),在推理階段也需要通過知識庫進行檢索增強,這些操作通過遠程訪問分布式文件系統來完成。在CPU處理模式下,遠端存儲訪問協議的處理成為瓶頸。我們通過DPU進行遠端存儲訪問協議的卸載,提高數據讀寫的效率,提供比CPU更高的吞吐量和更低的延遲。

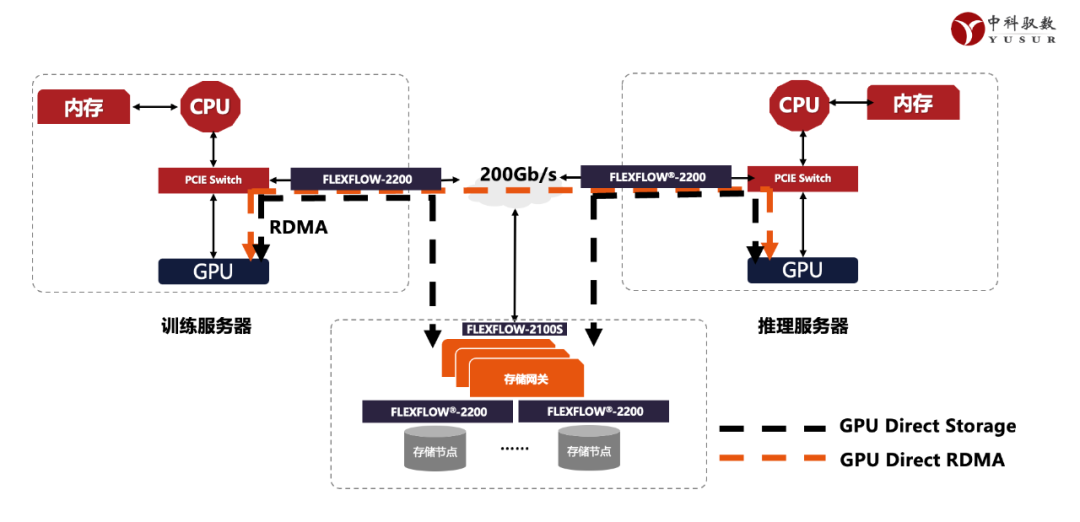

c)加速分布式訓練中的通信:分布式訓練中,GPU之間的通信(如梯度同步)會消耗大量時間。DPU可以優化通信任務,支持高效的All-Reduce操作,減少通信延遲。DPU內置專用的通信引擎,使能GPU Direct RDMA,減少CPU的干預,實現超高帶寬、低延遲的GPU間通信。

d)提高能效比:DPU專門針對數據管理和通信任務進行了優化,能夠以更低的功耗完成這些任務,從而降低整體能耗

中科馭數作為國內領軍的DPU芯片和產品供應商,憑借多年在DPU領域的積累,不斷推陳出新,基于公司全自研的國產芯片K2-Pro,推出應用于智算中心的系列產品和方案。

圖1 : 中科馭數K2-Pro

K2-Pro芯片的網絡處理能力,可以很好的支撐國產化推理集群的各種應用需求,在中科馭數自建的全國產化推理集群中,很好的承擔了高通量網絡傳輸,云化流表卸載與分布式資源快速加載的任務。

同時,在AI模型訓練方向,中科馭數完全自主研發的RDMA網卡助力數據中心高速網絡連接,確保大規模模型的數據傳輸效率,減少通信延遲,提升整體計算性能。RDMA性能達到200Gbps。釋放CPU算力,彌補國產CPU性能不足問題。提供微秒級時延和百G級帶寬以及千萬級別的IOPS存儲訪問能力,滿足模型計算對數據快速加載的性能要求。

近日,中科馭數基于全國產化CPU、GPU、DPU 三U一體設備本地化部署了DeepSeek模型,系統中通過國產CPU實現整體業務調度與主要服務進程運行,采用國產GPU完成模型推理運算,由中科馭數DPU進行設備裸金屬業務管理以及云化網絡/存儲能力卸載提速。該系統底層采用全國產化的3U一體服務器搭建,在兼顧安全性與低成本的同時,可以高效運行DeepSeek-V3與DeepSeek-R1等多個AI推理模型系統。中科馭數通過這種方式完成多個AI模型適配,打通全國產化三U一體算力底層支撐,能夠幫助AI應用在落地過程中實現更好的數據隱私性保護與抵御外部風險的能力,同時也積極推動產業鏈協同與資源優化整合。

圖2 :中科馭數智算中心解決方案

DPU通過卸載GPU的計算負擔、優化數據預處理、加速通信和存儲任務,正在成為大模型訓練和推理的重要助力。馭數的DPU產品憑借其高性能、低功耗和可擴展性,為大模型訓練和推理提供了強有力的支持。隨著深度學習技術的進一步發展,類似DeepSeek大模型的興起,以及由此帶來對智算資源的大幅優化,給國產GPU和CPU實現高效大模型訓練和推理的大規模部署帶來巨大可能和期盼。

同時,智算租賃因為DeepSeek模型對于部署資源的優化,讓最終從“看著挺美”變成“用著挺美”。很多用戶開始嘗試租賃智能算資源,這要求智算資源可以按需快速部署。中科馭數的DPU產品,通過流程簡化和存儲卸載,實現了裸金屬部署時間從傳統的30分鐘優化到3分鐘,大大便利了資源的反復利用,也極大地提升了客戶訂閱的體驗。

-

DPU

+關注

關注

0文章

393瀏覽量

24815 -

中科馭數

+關注

關注

0文章

133瀏覽量

4317 -

大模型

+關注

關注

2文章

3086瀏覽量

3971

原文標題:中科馭數DPU助力大模型訓練和推理

文章出處:【微信號:yusurtech,微信公眾號:馭數科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

中科馭數攜DPU全棧產品亮相福州數博會,賦能智算時代算力基建

中關村泛聯院一行來訪中科馭數

中科馭數受邀出席2025中關村論壇

中科馭數受邀參與華泰證券春季投資峰會 分享DPU在AI領域的應用

中科馭數K2-Pro芯片助力智算中心創新

中科馭數憑借在DPU芯片領域的積累被認定為北京市知識產權優勢單位

中科馭數DPU助力大模型訓練和推理

中科馭數DPU助力大模型訓練和推理

評論