隨著人工智能技術(shù)的迅猛發(fā)展,大規(guī)模語(yǔ)言模型(LLMs)在自然語(yǔ)言處理、內(nèi)容生成和智能對(duì)話等領(lǐng)域的應(yīng)用日益廣泛。國(guó)產(chǎn) AI 大模型 DeepSeek 憑借其強(qiáng)大的生成能力和廣泛的應(yīng)用場(chǎng)景,迅速成為業(yè)界焦點(diǎn)。

目前,我們已經(jīng)在英特爾 酷睿 處理器與英特爾銳炫 顯卡組成的硬件配置上,完成對(duì)大模型推理的驗(yàn)證,為 AI 模型的部署和推理提供了強(qiáng)有力的支持。

本文將帶您深入了解如何在英特爾平臺(tái)上高效部署 DeepSeek 模型,充分發(fā)揮其潛力,助力 AI 應(yīng)用的快速落地。

1硬件配置

GPU: 英特爾銳炫 B580 12G

2BIOS 配置

安裝英特爾銳炫顯卡后,必須在 BIOS 中啟用 PCIe 可重設(shè) BAR(Base Address Register)。

3操作系統(tǒng)和驅(qū)動(dòng)程序安裝

3.1Ubuntu* 24.10 操作系統(tǒng)安裝

以下是下載和安裝 Ubuntu 24.10 的步驟:

1)下載并安裝Ubuntu 24.10

wget https://releases.ubuntu.com/24.10/ubuntu-24.10-desktop-amd64.iso

2)關(guān)閉 Ubuntu 無(wú)人值守升級(jí),以避免未經(jīng)驗(yàn)證的內(nèi)核更新。

登錄 Ubuntu 后,設(shè)置屏幕永不鎖定并啟用自動(dòng)登錄。

Setting->Power->Power Saving->Screen Blank->Never

設(shè)置 -> 電源 -> 節(jié)能 -> 屏幕空白 -> 從不

System->Users->Automatic Login

系統(tǒng) -> 用戶 -> 自動(dòng)登錄

sudo systemctl disable --now unattended-upgrades

然后編輯/etc/apt/apt.conf.d/20auto-upgrades,將Unattended-Upgrade設(shè)置為 “0”。

3)檢查內(nèi)核版本是否為6.11.

$ uname -a Linux benchmark-Z590-VISION-D 6.11.0-8-generic #8-Ubuntu SMP PREEMPT_DYNAMIC Mon Sep 16 1320 UTC 2024 x86_64 x86_64 x86_64 GNU/Linux

4)重新啟動(dòng)設(shè)備,查看顯示是否正常工作。

3.2 英特爾客戶端 GPU

驅(qū)動(dòng)程序安裝(ARC B 系列)

參考:

https://dgpu-docs.intel.com/driver/client/overview.html#installing-client-gpus-on-ubuntu-desktop-24-10

3.2.1在 Ubuntu Desktop 24.10 上

安裝客戶端 GPU

使用以下命令安裝 intel-graphics PPA 和必要的計(jì)算與媒體包:

sudo apt-get update sudo apt-get install -y software-properties-common # Add the intel-graphics PPA for 24.10 sudo add-apt-repository -y ppa:kobuk-team/intel-graphics # Install the compute-related packages sudo apt-get install -y libze-intel-gpu1 libze1 intel-ocloc intel-opencl-icd clinfo intel-gsc hwinfo # Install the media-related packages sudo apt-get install -y intel-media-va-driver-non-free libmfx1 libmfx-gen1 libvpl2 libvpl-tools libva-glx2 va-driver-all vainfo

上述命令安裝了大多數(shù)用戶所需的所有基本包,旨在盡量減少不必要的包安裝。

請(qǐng)注意,不同版本的 intel-opencl-icd 可能會(huì)有不同的性能表現(xiàn)。

3.2.2 配置渲染組成員資格

要訪問(wèn) GPU 功能,當(dāng)前用戶必須能夠訪問(wèn)/dev/dri 中的 DRM 渲染節(jié)點(diǎn)。

如果當(dāng)前用戶不是 DRM 渲染節(jié)點(diǎn)(通常為 'render')組的成員,請(qǐng)將用戶添加到渲染節(jié)點(diǎn)組。

sudo gpasswd -a ${USER} render

這對(duì)更新后創(chuàng)建的 shell 就足夠了。要更改當(dāng)前 shell 的組 ID:

newgrp render

3.3 驗(yàn)證英特爾銳炫 B580 PCIe 配置空間

確保英特爾銳炫 B580 PCIe 配置空間具有 12GB 的 BAR2。以下是檢查 GPU PCIe 配置空間的指南:

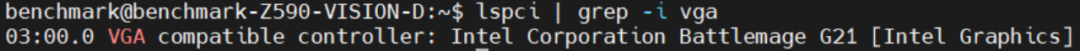

步驟 1:列出 VGA 設(shè)備的 PCIe 總線地址。

lspci | grep -i vga

您將在屏幕上看到這些消息:

步驟 2:檢查英特爾銳炫 B580 的 PCIe 功能。

sudo lspci -s 03:00 -vvv | grep BAR

您將看到英特爾銳炫 B580 的 PCIe 功能,并檢查 PCIe 配置空間。

4OpenVINO 和基準(zhǔn)測(cè)試工具安裝

OpenVINO 是一個(gè)開源工具包,用于優(yōu)化和部署從云到邊緣的深度學(xué)習(xí)模型。它加速了各種用例的深度學(xué)習(xí)推理,如生成式 AI、視頻、音頻和語(yǔ)言,支持來(lái)自流行框架(如 PyTorch、TensorFlow、ONNX 等)的模型。轉(zhuǎn)換和優(yōu)化模型,并部署在混合的英特爾 硬件和環(huán)境中,無(wú)論是在本地、設(shè)備上、瀏覽器中還是云端。

OpenVINO GenAI 是 OpenVINO 的一個(gè)變體,旨在簡(jiǎn)化生成式 AI 模型的推理運(yùn)行。它隱藏了生成過(guò)程的復(fù)雜性,并最大限度地減少了所需的代碼量。

使用以下命令快速安裝 OpenVINO 和工具。

git clone https://github.com/openvinotoolkit/openvino.genai.git cd ./tools/llm_bench python3 -m venv python-env source python-env/bin/activate pip install --upgrade pip pip install -r requirements.txt

更多詳情請(qǐng)參考o(jì)penvino.genai/tools/llm_bench at master · openvinotoolkit/openvino.genai · GitHub

https://github.com/openvinotoolkit/openvino.genai/tree/master/tools/llm_bench

5運(yùn)行 DeepSeek蒸餾模型的基準(zhǔn)測(cè)試

5.1 下載預(yù)訓(xùn)練的 LLM 模型

訪問(wèn):

https://huggingface.co或https://www.modelscope.cn

下載 deepseek 蒸餾模型,并將下載的模型保存在~/models 文件夾中。

5.2將模型轉(zhuǎn)換為 OpenVINO IR

運(yùn)行以下命令將 DeepSeek-R1-Distill-Qwen-7B 轉(zhuǎn)換為 IR 格式并將權(quán)重壓縮為 INT4。您的系統(tǒng)必須至少具有 64GB 內(nèi)存才能進(jìn)行轉(zhuǎn)換。

optimum-cli export openvino --framework pt -m ./DeepSeek-R1-Distill-Qwen-7B --weight-format int4 –sym --trust-remote-code --task text-generation-with-past ./DeepSeek-R1-Distill-Qwen-7B-IR

5.3 使用 OpenVINO 啟動(dòng) LLM 基準(zhǔn)測(cè)試

要在 B580 上啟動(dòng) LLM 模型 DeepSeek-R1-Distill-Qwen-7B 的基準(zhǔn)測(cè)試,請(qǐng)運(yùn)行以下命令:

python3 benchmark.py -m DeepSeek-R1-Distill-Qwen-7B-IR -n 1 -d GPU python benchmark.py -m DeepSeek-R1-Distill-Qwen-7B-IR -p "What is openvino?" -n 1 -d GPU

測(cè)試結(jié)果將顯示在屏幕上。請(qǐng)注意,結(jié)果可能因平臺(tái)和軟件版本而異。

通過(guò)本文的詳細(xì)步驟和配置指南,我們成功在英特爾平臺(tái)上驗(yàn)證了 DeepSeek 蒸餾模型的推理性能。從硬件配置、BIOS 設(shè)置、操作系統(tǒng)安裝到驅(qū)動(dòng)程序和 OpenVINO 工具的部署,每一步都確保了系統(tǒng)發(fā)揮更卓越的性能。

通過(guò)基準(zhǔn)測(cè)試,我們展示了 DeepSeek-R1-Distill-Qwen 系列模型在 INT4 精度下的高效推理能力,尤其是在首個(gè) token 和后續(xù) token 的延遲表現(xiàn)上,展現(xiàn)了英特爾銳炫 顯卡在處理大模型推理任務(wù)時(shí)的強(qiáng)大潛力。英特爾銳炫 B580能夠?yàn)锳I工作負(fù)載提供加速,其配備的英特爾Xe矩陣計(jì)算引擎(XMX),為新推出的XeSS 2提供強(qiáng)大支持。OpenVINO 工具套件可以縮短延遲,提高吞吐量,加速 AI 推理過(guò)程,同時(shí)保持精度,縮小模型占用空間,優(yōu)化硬件使用。

未來(lái),隨著硬件和軟件的進(jìn)一步優(yōu)化,我們期待在更多復(fù)雜場(chǎng)景中,特別是在生成式 AI 和大規(guī)模語(yǔ)言模型的應(yīng)用中,驗(yàn)證和英特爾銳炫 顯卡的性能,通過(guò)英特爾豐富的軟硬件產(chǎn)品協(xié)同,為 DeepSeek 及各種 AI 大模型的應(yīng)用提供更強(qiáng)大的算力,讓邊緣側(cè)部署 AI 的使用場(chǎng)景有更多可能。

-

英特爾

+關(guān)注

關(guān)注

61文章

10179瀏覽量

174124 -

顯卡

+關(guān)注

關(guān)注

16文章

2503瀏覽量

69265 -

人工智能

+關(guān)注

關(guān)注

1804文章

48829瀏覽量

247292 -

DeepSeek

+關(guān)注

關(guān)注

1文章

784瀏覽量

1465

原文標(biāo)題:DeepSeek 模型在英特爾銳炫? 顯卡上的高效推理實(shí)踐

文章出處:【微信號(hào):英特爾物聯(lián)網(wǎng),微信公眾號(hào):英特爾物聯(lián)網(wǎng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

MWC上海2018:英特爾助力合作伙伴加速5G部署

英特爾CPU部署Qwen 1.8B模型的過(guò)程

添越智創(chuàng)基于 RK3588 開發(fā)板部署測(cè)試 DeepSeek 模型全攻略

英特爾多款平板電腦CPU將于明年推出

OpenCL平臺(tái)和英特爾Stratix 10 FPGA的結(jié)合使用

為什么選擇加入英特爾?

介紹英特爾?分布式OpenVINO?工具包

英特爾Context Sensing SDK跨平臺(tái)上下文感知體驗(yàn)

由Gayathri Murali設(shè)計(jì)英特爾平臺(tái)上的Android

如何在英特爾? 平臺(tái)上實(shí)現(xiàn)高效的大語(yǔ)言模型訓(xùn)練后量化

IBM Cloud將部署英特爾Gaudi 3 AI芯片

英特爾酷睿Ultra處理器支持DeepSeek運(yùn)行

探索座艙“未至之境”:英特爾支持DeepSeek車內(nèi)本地運(yùn)行

如何在英特爾平臺(tái)上高效部署DeepSeek模型

如何在英特爾平臺(tái)上高效部署DeepSeek模型

評(píng)論