來源:OpenVINO 中文社區(qū)

作者:

武卓英特爾 OpenVINO 布道師

生成式AI(GenAI)在模型質(zhì)量與應(yīng)用范圍上持續(xù)爆發(fā)式增長,DeepSeek 等頂尖模型已引發(fā)行業(yè)熱議,這種勢(shì)頭預(yù)計(jì)將在 2025年延續(xù)。本次更新聚焦性能提升、更多生成式AI 模型的支持,并針對(duì)英特爾神經(jīng)處理單元(NPU)推出關(guān)鍵優(yōu)化。讓我們來一探究竟吧!

新增圖像生成場景與模型支持

OpenVINO 2025.0 版本正式支持FLUX.1 圖像生成模型(含Dev與Schnell變體),可在英特爾 CPU/GPU 上通過 GenAI 流水線運(yùn)行。開發(fā)者現(xiàn)可通過 Optimum-Intel 導(dǎo)出 Flux 模型,并結(jié)合 Text2ImagePipeline 生成圖像。針對(duì) Flux 模型對(duì)精度變化非常敏感的特點(diǎn),我們進(jìn)行了深度優(yōu)化,確保圖像生成性能與準(zhǔn)確度兼得。

LoRA適配器:模型定制利器

自前期版本起,OpenVINO 已支持基于 Safetensor 文件的LoRA 低秩適配技術(shù),無需重新編譯即可動(dòng)態(tài)切換 LoRA 適配器,從而快速方便的生成不同定制化風(fēng)格的圖像。本次更新進(jìn)一步擴(kuò)展至 Flux 模型家族,開發(fā)者可直接從 Hugging Face Hub 下載適配器,通過 GenAI 的 Text2ImagePipeline 快速實(shí)現(xiàn)風(fēng)格定制。

示例:

LoRA 增強(qiáng)的 FLUX.1-Dev 圖像生成效果

展示了 INT8 量化版 FLUX.1-dev 模型在應(yīng)用 Yarn 風(fēng)格 LoRA 前后的對(duì)比(提示詞:"albert einstein, yarn art style",初始種子=420,迭代次數(shù)=20):

新場景支持:Image2Image 與 Inpainting

新增Image2Image與Inpainting流水線(預(yù)覽版),解鎖更可控的創(chuàng)作方式:

Image2Image:以圖像+文本為輸入生成新圖像,提升結(jié)果可控性;

Inpainting:通過掩碼圖像替換輸入圖像的指定區(qū)域,支持局部內(nèi)容再生。

兩種流水線均兼容 LoRA 適配器,滿足定制化需求。

文本生成場景優(yōu)化

本次新版本在 LLMPipeline API 中引入了對(duì)提示詞查找解碼的預(yù)覽支持,這是對(duì)推測解碼的簡化,它在輸入提示詞本身中用直接查找機(jī)制取代了傳統(tǒng)的草稿模型。這有助于在具有高相似性的請(qǐng)求的情況下顯著減少生成延遲。例如,通過對(duì)一組文檔的問答可以觀察到性能優(yōu)勢(shì),因?yàn)榇鸢笇⒏鶕?jù)作為提示詞本身一部分的文檔來生成。

如我們的示例所示,只需對(duì) LLMPipeline 中的代碼進(jìn)行很小的修改,即可啟用此功能。總結(jié)來說,您需要將提示查找作為流水線中的一個(gè)參數(shù)啟用,并修改生成配置以添加兩個(gè)重要參數(shù):在提示詞中查找多少 token 數(shù)以及匹配后取多少 token 數(shù)。

生成過程中的內(nèi)存使用是運(yùn)行應(yīng)用的一個(gè)重要考慮因素,因?yàn)?LLM 權(quán)重非常占用內(nèi)存。KV Cache 代表了額外的內(nèi)存消耗,并且可能會(huì)增長得相當(dāng)大。我們引入了 KV Cache 的壓縮作為一種減少內(nèi)存消耗的技術(shù),在這個(gè)版本中,我們默認(rèn)在 CPU 上啟用它。為了確保壓縮的準(zhǔn)確性,我們引入了非對(duì)稱 INT8 壓縮,被證明是總體來說最準(zhǔn)確的壓縮方式。如果需要,INT4 壓縮也可作為進(jìn)一步減少內(nèi)存消耗的選項(xiàng)。在未來的版本中,我們計(jì)劃啟用更多的壓縮技術(shù),請(qǐng)持續(xù)關(guān)注。

另外,我們一直在努力支持和驗(yàn)證最新的模型,包括 Mistral-7B-Instruct-v0.2、Qwen2.5,當(dāng)然我們也支持基于 LLama 和 Qwen 架構(gòu)的 DeepSeek 蒸餾模型。您可以探索我們的新的使用 DeepSeek-R1 蒸餾模型進(jìn)行 LLM 推理的 Notebook 代碼示例,并查看下面與英特爾 酷睿 Ultra 200V GPU 上的 DeepSeek-R1-Llama-8b 模型的對(duì)話:

https://github.com/openvinotoolkit/openvino_notebooks/tree/latest/notebooks/deepseek-r1

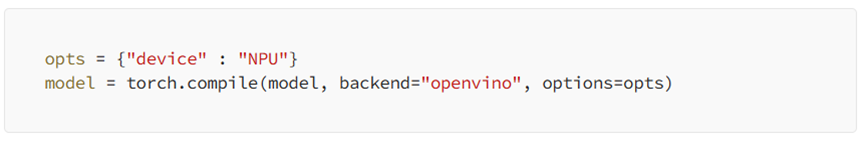

通過 torch.compile

支持英特爾 NPU

2025.0 版本首次實(shí)現(xiàn) NPU 加速支持,開發(fā)者可通過 PyTorch 的 torch.compile 接口調(diào)用英特爾 NPU 算力。OpenVINO 作為 torch.compile 生態(tài)系統(tǒng)中的編譯器已經(jīng)面世一段時(shí)間了。它已經(jīng)在 CPU 和 GPU 上得到支持,并且在性能方面非常接近原生 OpenVINO 推理。在 2025.0 版本中,我們將推出對(duì) Intel NPU 作為推理設(shè)備的預(yù)覽支持。這包括對(duì) TorchVision、Timm 和 TorchBench 存儲(chǔ)庫中的300多個(gè)模型的支持。

啟用方式非常簡單,只需要增加如下兩行代碼:

結(jié)果因模型而異,因此建議您嘗試使用自己的模型以查看性能的提升情況。同時(shí)我們建議在英特爾 酷睿 Ultra Series 2 及更高版本的平臺(tái)上使用此功能。

總結(jié)

隨著我們迎來激動(dòng)人心的新一年,生成式AI的潛力繼續(xù)重塑我們的創(chuàng)造、工作和創(chuàng)新方式。

借助 OpenVINO 2025.0,我們提供了更多的模型覆蓋、更快的推理性能和擴(kuò)展的英特爾 NPU 支持。這只是一個(gè)開始——今年我們?nèi)暧?jì)劃發(fā)布更多版本,請(qǐng)繼續(xù)關(guān)注即將到來的更新!

-

英特爾

+關(guān)注

關(guān)注

61文章

10183瀏覽量

174145 -

gpu

+關(guān)注

關(guān)注

28文章

4921瀏覽量

130808 -

模型

+關(guān)注

關(guān)注

1文章

3500瀏覽量

50122 -

OpenVINO

+關(guān)注

關(guān)注

0文章

114瀏覽量

429

原文標(biāo)題:開發(fā)者實(shí)戰(zhàn)|OpenVINO? 2025.0正式發(fā)布!DeepSeek支持、FLUX.1圖像生成、英特爾? NPU加速全面升級(jí)

文章出處:【微信號(hào):英特爾物聯(lián)網(wǎng),微信公眾號(hào):英特爾物聯(lián)網(wǎng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

世紀(jì)大并購!傳高通有意整體收購英特爾,英特爾最新回應(yīng)

直擊Computex2025:英特爾重磅發(fā)布新一代GPU,圖形和AI性能躍升3.4倍

英特爾發(fā)布全新GPU,AI和工作站迎來新選擇

在Windows中安裝OpenVINO?后,無法找到OpenCL編譯器二進(jìn)制文件是怎么回事?

為什么無法檢測到OpenVINO?工具套件中的英特爾?集成圖形處理單元?

請(qǐng)問OpenVINO?工具套件英特爾?Distribution是否與Windows? 10物聯(lián)網(wǎng)企業(yè)版兼容?

安裝OpenVINO?適用于Raspberry Pi64位操作系統(tǒng)的工具套件2022.3.1,配置英特爾?NCS2時(shí)出錯(cuò)怎么解決?

將英特爾?獨(dú)立顯卡與OpenVINO?工具套件結(jié)合使用時(shí),無法運(yùn)行推理怎么解決?

為什么Caffe模型可以直接與OpenVINO?工具套件推斷引擎API一起使用,而無法轉(zhuǎn)換為中間表示 (IR)?

英特爾的開發(fā)板評(píng)測

英特爾推出全新英特爾銳炫B系列顯卡

英特爾OpenVINO 2025.0正式發(fā)布

英特爾OpenVINO 2025.0正式發(fā)布

評(píng)論