BEVFusion 技術詳解總結

原始論文:*附件:bevfusion.pdf

介紹(Introduction)

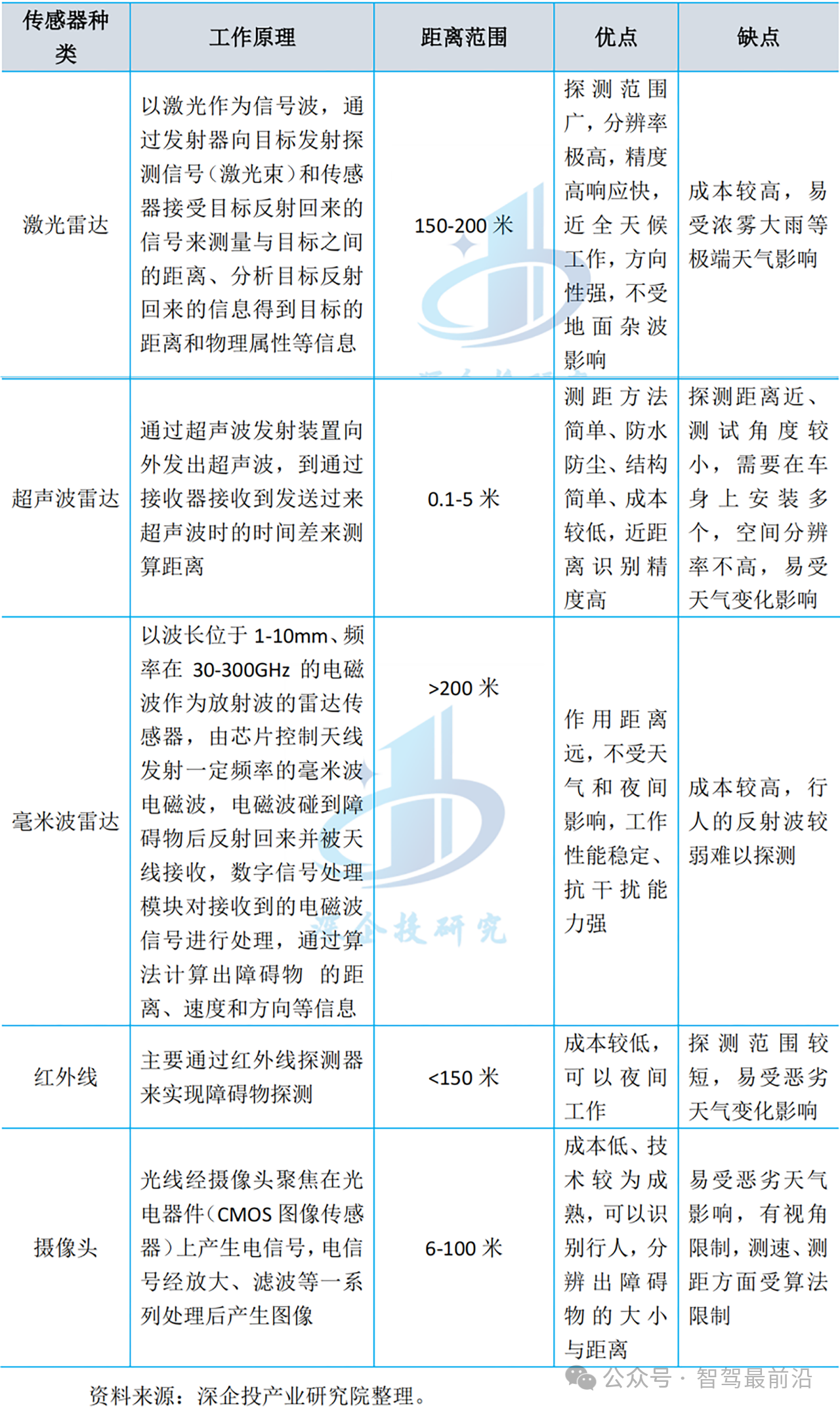

背景:自動駕駛系統(tǒng)配備了多種傳感器,提供互補的信號。但是不同傳感器的數據表現形式不同。

自動駕駛系統(tǒng)配備了多樣的傳感器。 例如,Waymo的自動駕駛車輛有29個攝像頭、6個雷達和5個激光雷達。 **不同的傳感器提供互補的信號:**例如,攝像機捕捉豐富的語義信息,激光雷達提供精確的空間信息,而雷達提供即時的速度估計。 因此,多傳感器融合對于準確可靠的感知具有重要意義。**來自不同傳感器的數據以根本不同的方式表示:**例如,攝像機在透視圖中捕獲數據,激光雷達在3D視圖中捕獲數據。

1. 核心目標與創(chuàng)新?

- 目標? 解決多模態(tài)傳感器(攝像頭、激光雷達等)在3D感知任務中的異構數據融合難題,實現高效、通用的多任務學習(如3D檢測、BEV分割)

- 核心創(chuàng)新?

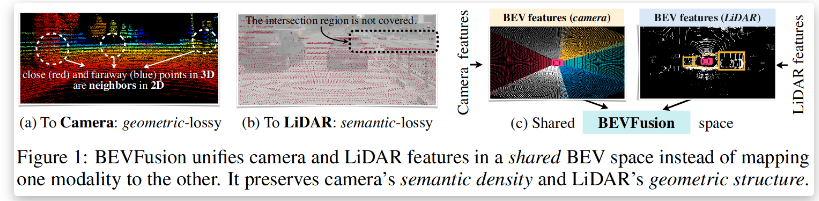

- ?統(tǒng)一BEV表示 將多模態(tài)特征映射到共享的鳥瞰圖(BEV)空間,保留幾何結構(激光雷達優(yōu)勢)和語義密度(攝像頭優(yōu)勢)

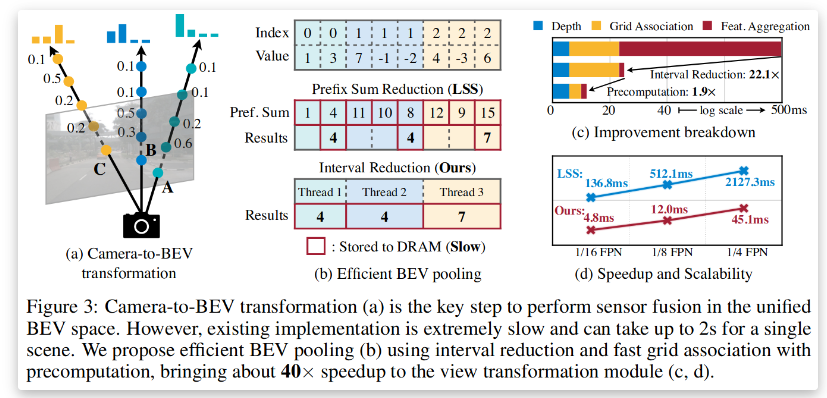

- ?優(yōu)化BEV池化 通過預計算和間隔縮減技術,將BEV池化速度提升40%以上

- ?全卷積融合 解決激光雷達與攝像頭BEV特征的空間錯位問題,提升融合魯棒性

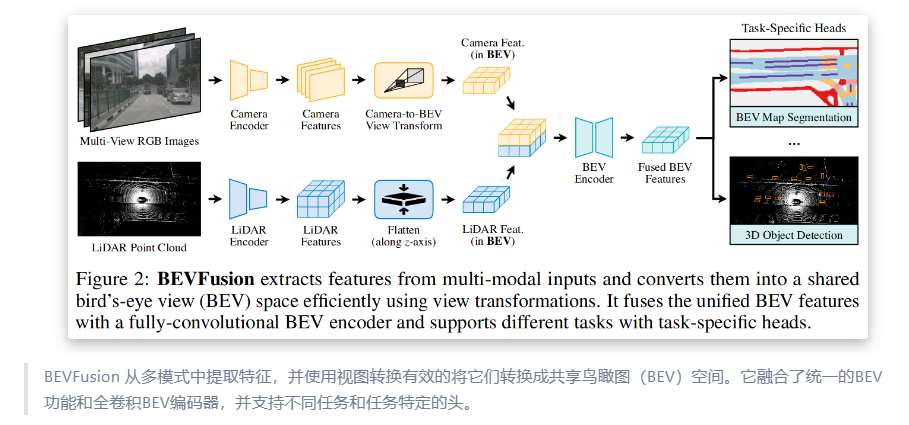

2. 技術框架與關鍵模塊?

?2.1 多模態(tài)特征提取

- ?傳感器輸入

- ?攝像頭 多視角圖像(透視視圖)

- ?激光雷達 點云數據(3D視圖)

- ?模態(tài)專用編碼器

- ?攝像頭 2D卷積神經網絡(如ResNet)提取圖像特征

- ?激光雷達 3D稀疏卷積網絡(如VoxelNet)提取點云特征

?2.2 統(tǒng)一BEV表示構建

- ?攝像頭到BEV的轉換

- ?深度分布預測 顯式預測每個像素的離散深度分布(避免幾何失真)

- ?特征投影 沿相機射線將像素特征分散到離散3D點,通過BEV池化聚合特征(見圖1)

- ?優(yōu)化加速 預計算相機內外參矩陣,減少實時計算開銷

- ?激光雷達到BEV的轉換 直接通過體素化將點云映射到BEV網格

?2.3 全卷積特征融合

- ?融合策略

- ?通道級聯(lián) 將攝像頭和激光雷達的BEV特征拼接,輸入全卷積網絡(FCN)

- ?空間對齊補償 通過可變形卷積或注意力機制緩解特征錯位問題

?2.4 多任務頭設計

- ?3D物體檢測 基于融合后的BEV特征,采用Anchor-free或CenterPoint范式預測邊界框

- ?BEV地圖分割 全卷積解碼器輸出語義分割結果(如車道線、可行駛區(qū)域)

?3. 性能優(yōu)勢與實驗驗證

? 3.1 基準測試結果(NuScenes數據集)

| ?任務 | ?模型類型 | ?性能指標 | ?BEVFusion優(yōu)勢 |

|---|---|---|---|

| 3D物體檢測 | 純攝像頭模型 | mAP: 35.1% | ?mAP: 68.5%(+33.4%) |

| 3D物體檢測 | 純激光雷達模型 | mAP: 65.2% | ?mAP: 68.5%(+3.3%) |

| BEV地圖分割 | 純攝像頭模型 | mIoU: 44.7% | ?mIoU: 50.7%(+6.0%) |

| BEV地圖分割 | 純激光雷達模型 | mIoU: 37.1% | ?mIoU: 50.7%(+13.6%) |

?3.2 效率對比

- ?計算成本 BEVFusion的計算量僅為同類多模態(tài)模型的50%(1.9倍低于純激光雷達模型)

- ?推理速度 優(yōu)化后的BEV池化使端到端延遲降低40%

?4. 與傳統(tǒng)方法的對比分析

?4.1 早期融合 vs. 晚期融合

| ?方法 | ?優(yōu)勢 | ?劣勢 |

|---|---|---|

| 早期融合(特征級) | 保留原始數據信息 | 異構特征難以對齊(如幾何失真) |

| 晚期融合(決策級) | 模態(tài)獨立性高 | 語義信息丟失,任務性能受限 |

| ?BEVFusion | ?統(tǒng)一BEV空間平衡幾何與語義 | 需優(yōu)化特征對齊與計算效率 |

?4.2 其他多模態(tài)模型對比

- ?PointPainting 將攝像頭語義注入點云,但依賴激光雷達主導,無法充分發(fā)揮攝像頭優(yōu)勢

- ?TransFusion 基于Transformer的融合,計算復雜度高,實時性差

?5. 局限性與未來方向

- ?局限性

- ?動態(tài)場景適應性 BEV靜態(tài)假設可能影響運動物體感知

- ?傳感器依賴性 仍需激光雷達提供幾何先驗

- ?未來方向

- ?純視覺BEV泛化 探索無激光雷達的BEV感知(如4D標注數據增強)

- ?時序融合 引入多幀BEV特征提升動態(tài)場景理解

?總結

BEVFusion通過統(tǒng)一的BEV表示空間和高效融合機制,解決了多模態(tài)傳感器在幾何與語義任務中的權衡問題,成為自動駕駛多任務感知的標桿框架其設計范式為后續(xù)研究提供了重要啟發(fā) ?**“統(tǒng)一表示+輕量優(yōu)化”是多模態(tài)融合的核心方向**

項目鏈接

- 官方網頁:https://hanlab.mit.edu/projects/bevfusion

- 原始論文:https://arxiv.org/abs/2205.13542

- 項目地址:https://github.com/mit-han-lab/bevfusion

參考資料

-

自動駕駛

+關注

關注

790文章

14321瀏覽量

170696

發(fā)布評論請先 登錄

康謀分享 | 基于多傳感器數據的自動駕駛仿真確定性驗證

自動駕駛汽車是如何準確定位的?

AI將如何改變自動駕駛?

技術分享 |多模態(tài)自動駕駛混合渲染HRMAD:將NeRF和3DGS進行感知驗證和端到端AD測試

一文聊聊自動駕駛測試技術的挑戰(zhàn)與創(chuàng)新

BEVFusion —面向自動駕駛的多任務多傳感器高效融合框架技術詳解

BEVFusion —面向自動駕駛的多任務多傳感器高效融合框架技術詳解

評論