SPACEMIT:進迭時空是一家計算芯片企業,專注于研發下一代 RISC-V架構的高性能CPU并提供軟硬一體優化的計算解決方案。秉承進取不息、迭代不止的企業精神,公司致力于構建“云—邊—端”架構原生一體的下一個計算時代。

愛芯通元:以算子為原子指令集的AI計算處理器。高效支持混合精度算法設計和Transformer,為大模型(DeepSeek、Qwen、MiniCPM……)在“云—邊—端”的AI應用提供強力基礎。

TLDR

| 模型名稱 | SPACEMIT M1 | SPACEMIT M1 + M.2卡 |

| DeepSeek-R1-1.5B | 5.5 tokens/s |

17.0 tokens/s (還有優化空間) |

| DeepSeek-R1-7B | 1.3 tokens/s |

4.0 tokens/s (還有優化空間) |

背景

最近,路邊社消息說又要大力推廣RISC-V產業生態了。還好提前布局,借助于AXCL項目優秀的可移植性,已經完成了國內能順利買到的基于RISC-V指令集的應用處理器開發板,同時完成內置愛芯通元NPU的M.2算力卡適配,讓DeepSeek蒸餾模型在市面上已有的RISC-V開發板上運行更加流暢,給RISC-V生態提供了一種高性價比的AI算力拓展解決方案。

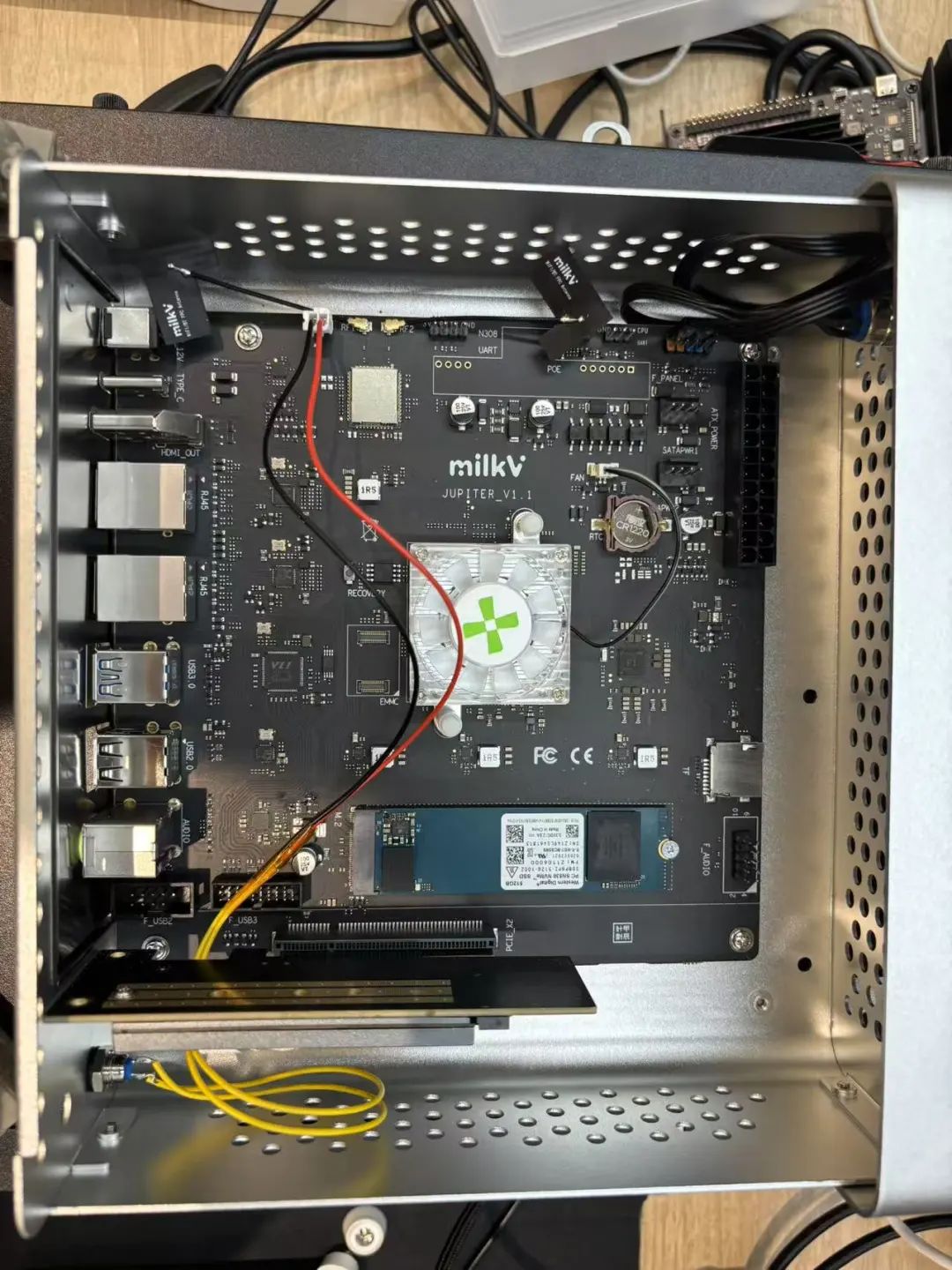

本文簡單介紹下SPACEMIT M1社區開發板加裝M.2算力卡運行DeepSeek-R1-7B模型的安裝細節和注意事項,降低大家踩坑概率。

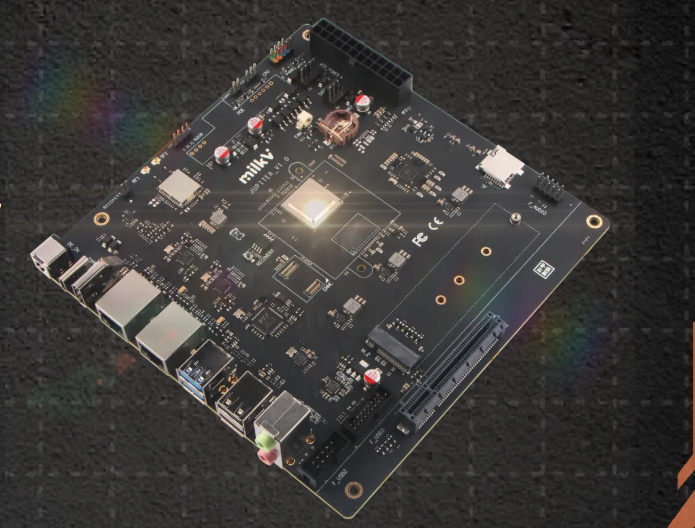

RISC-V PC for Everyone。Milk-V Jupiter由Spacemit K1/M1 SoC提供動力,是世界上第一款同時支持RVA22和RVV1.0的Mini ITX設備。本設備集成標準PCIe連接器,支持常見PCIe器件,如顯卡、PCIe轉SATA適配器、網卡等。它具有雙千兆以太網接口,板載Wi-Fi 6/BT 5.2,并支持NVMe SSD,使其成為入門級RISC-V桌面的理想選擇。

芯繭加速卡

芯繭人工智能算力卡是深圳市云集互聯生態科技有限公司推出的基于AXCL軟件架構的M.2 2280計算卡。

規格參數

| 項目 | 描述 |

| 內存 | 4GiB or 8GiB,64bit LPDDR4x |

| 智能 |

18TOPs@Int8,72TOPs@Int4; 支持CNN、Transformer模型部署; 支持LLM、VLM部署 |

| 視頻解碼 |

H.264/H.265,32路 1080@30fps解碼 |

| 視頻編碼 |

H.264/H.265,16路 1080@30fps編碼 |

| Host適配 | 支持Intel、AMD、NXP、Xilinx、Raspberry Pi、Rockchip、SPACEMIT、StarFive、SG2042等 |

| Host系統 |

Linux:Ubuntu、Debian、CentOS、OpenKylin等; Windows(適配中) |

| 外形尺寸 |

M.2 2280,M Key M.2 2242(開發中) |

| 工作電壓 | 3.3V |

| 系統功耗 | <8w |

硬件安裝

軟件安裝

適用于SPACEMIT M1的axcl deb包獲取鏈接

https://huggingface.co/AXERA-TECH/AXCL/blob/main/axcl_host_riscv_spacemit_V2.23.0_20250212162521.deb

詳細安裝流程可參考:AXCL安裝 - AXCL V1.0文檔

https://axcl-docs.readthedocs.io/zh-cn/latest/doc_guide_setup.html

踩坑記錄

在Milk-V Jupiter開發板上預裝的Bianbu OS中,如果要使用python環境或者安裝pip package,需要啟用python虛擬環境進行隔離。很遺憾大家最熟悉的miniconda貌似沒有RISC-V版本,建議采用python venv創建python虛擬環境。

當前DEMO依賴Transformer庫,pip安裝時請選用SPACEMIT提供的pip源。

pip install transformers --index-url https://git.spacemit.com/api/v4/projects/33/packages/pypi/simple

測試

基本功能

DeepSeek

直接嘗試DeepSeek-R1 7B模型,可以從AXERA-TECH/DeepSeek-R1-Distill-Qwen-7B-GPTQ-Int4獲取。

(https://huggingface.co/AXERA-TECH/DeepSeek-R1-Distill-Qwen-7B-GPTQ-Int4)

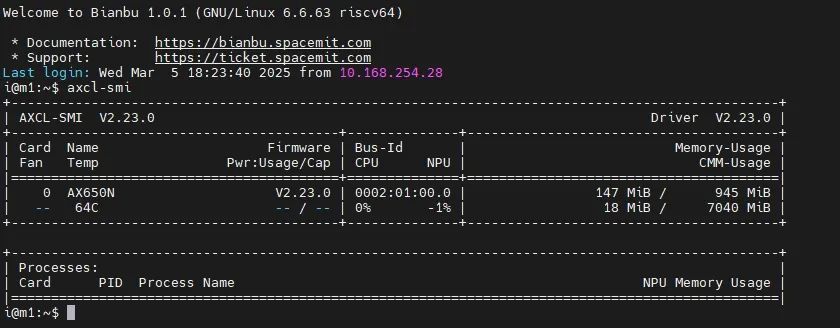

安裝完成后,可以使用類似nvidia-smi的設備管理工具axcl-smi。

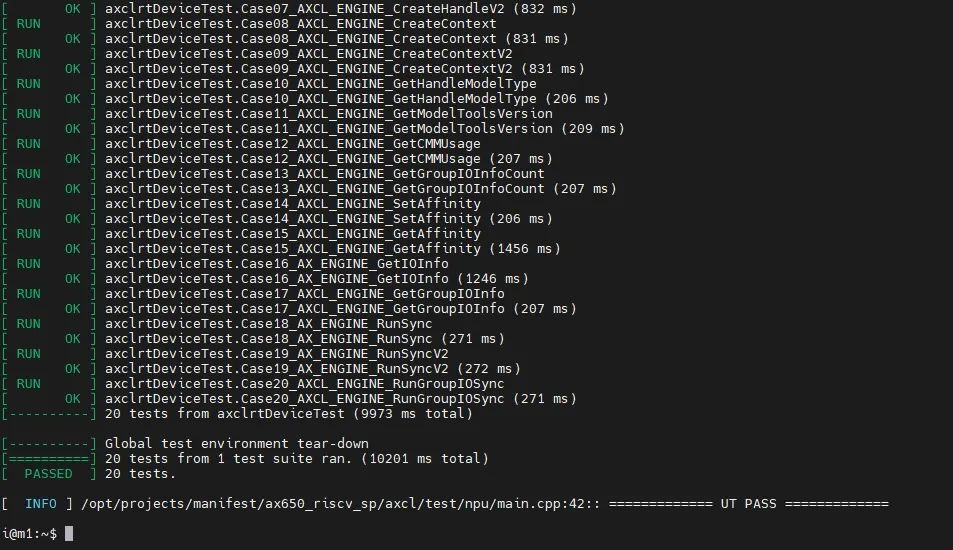

使用axcl_ut_npu完成NPU功能自測。

Tokenizer解析器

DEMO中的Tokenizer解析器采用本地模塊與HTTP Server兩種方案,其中本地方案又嘗試了sentencepiece、tiktoken兩種方案。但是我們在實際調試過程中發現sentencepiece對于不同LLM模型的special tokens支持不友好,需要用戶自行處理special tokens的拆分,容易導致板端token id與Transformers庫中的AutoTokenizer獲得的token id存在差異,最終影響LLM的輸出結果正確性。因此我們建議前期調試的時候使用Tokenizer HTTP Server的方式直接調用Transformers庫中的AutoTokenizer模塊進行測試。

Tokenizer HTTP Server的特點:

保證token id正確

方便添加chat template

支持本地、遠端部署

支持多用戶接入

以huggingface中提供的基于DeepSeek-R1-Distill-Qwen-7B的相關文件為例:

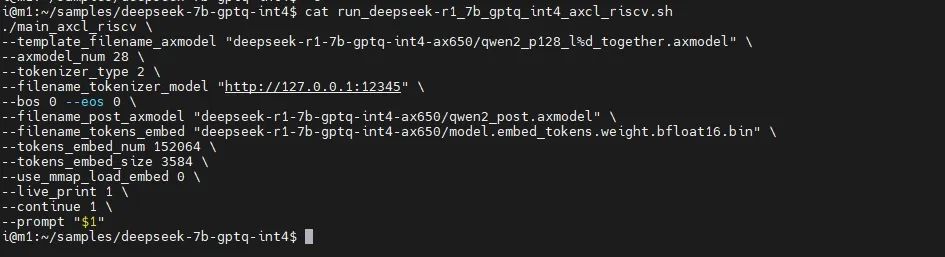

i@m1:~/samples/deepseek-7b-gptq-int4$ tree . ├── deepseek-r1-7b-gptq-int4-ax650 │ ├── model.embed_tokens.weight.bfloat16.bin │ ├── qwen2_p128_l0_together.axmodel ...... │ ├── qwen2_p128_l9_together.axmodel │ └── qwen2_post.axmodel ├── deepseek-r1_tokenizer │ ├── tokenizer_config.json │ └── tokenizer.json ├── deepseek-r1_tokenizer.py ├── main_axcl_riscv ├── main_prefill ├── post_config.json └── run_deepseek-r1_7b_gptq_int4_axcl_riscv.sh

deepseek-r1_tokenizer:是tokenizer相關文件,從DeepSeek/DeepSeek-R1-Distill-Qwen-7B中提取

deepseek-r1_tokenizer.py:是用python實現的Tokenizer HTTP Server

運行說明如下:

python deepseek-r1_tokenizer --host xxx.xxx.xxx.xxx --port 12345,其中--host xxx.xxx.xxx.xxx設置tokenizer解析服務器的IP地址,確保開發板能正常訪問該地址。可以在具備python環境的開發板本地運行;

修改run_deepseek-r1_7b_gptq_int4_axcl_riscv.sh中--filename_tokenizer_model的IP信息和步驟1中的一致;

運行run_deepseek-r1_7b_gptq_int4_axcl_riscv.sh即可。

運行視頻

結束語

當前,AI芯片行業競爭已從單純算力比拼轉向場景化適配能力。愛芯元智以“普惠AI造就美好生活”為使命,通過愛芯通元NPU與RISC-V產業鏈深度協同,成為驅動行業從“云端集中”邁向“邊緣智能”的關鍵力量。

因此從今年開始,愛芯通元NPU IP正式啟動商業授權服務,歡迎RISC-V產業鏈中感興趣的朋友來咨詢。

-

處理器

+關注

關注

68文章

19658瀏覽量

232463 -

RISC-V

+關注

關注

46文章

2442瀏覽量

47836 -

NPU

+關注

關注

2文章

308瀏覽量

19289 -

愛芯元智

+關注

關注

1文章

90瀏覽量

4999

原文標題:愛芯分享 | 愛芯通元NPU賦能產業鏈-SPACEMIT

文章出處:【微信號:愛芯元智AXERA,微信公眾號:愛芯元智AXERA】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

【愛芯派 Pro 開發板試用體驗】篇一:開箱篇

愛芯元智CEO仇肖莘出席CISES:AI賦能傳統技術,加速智能化轉型

“愛芯科技”正式更名“愛芯元智” 比亞迪半導體推出四合一鎖控MCU

TI芯科技 賦能中國新基建 | 西電東輸大動脈暢通的背后——TI芯科技賦能中國新基建之特高壓

TI芯科技 賦能中國新基建 | 從制造大國到制造強國的必由之路——TI芯科技賦能中國新基建之工業互聯網

愛芯通元NPU賦能SPACEMIT

愛芯通元NPU賦能SPACEMIT

評論