?項目主頁:

https://linxuewu.github.io/BIP3D-page/

?論文地址:

https://arxiv.org/abs/2411.14869

概述

在具身智能系統中,3D感知算法是一個關鍵組件,它在端側幫助可以幫助智能體理解環境信息,在云端可以用來輔助生成3D場景和3D標簽,具備重要的研究價值。現有主流算法主要依賴于點云作為輸入 (point-centric) ,盡管點云提供了精確的幾何信息,但由于其存在稀疏、噪聲、數據量較少等問題,仍然限制了感知算法的性能。

在本研究中,我們提出了一種新穎的以圖像為中心 (image-centric) 的3D感知模型——BIP3D,該模型利用具有顯式3D位置編碼的表達性圖像特征,以克服point-centric的方法的局限性。具體而言,我們利用預訓練的2D視覺基礎模型來增強語義理解,并引入了一個空間增強模塊來提升空間理解能力。這些模塊共同使BIP3D能夠實現多視角、多模態特征融合以及端到端的3D感知。BIP3D在多個開源數據集上獲得了卓越的性能,大幅領先現有算法。

BIP3D架構:基于Vision Foundation Model的多模態感知模型

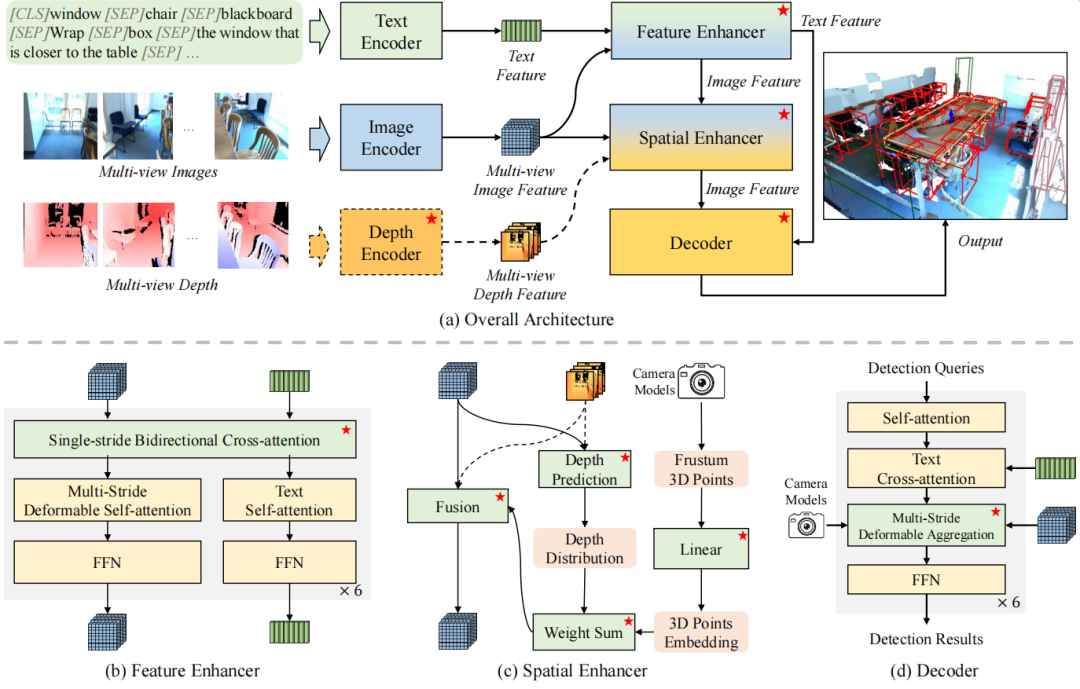

圖1 BIP3D模型架構圖

模型結構上,BIP3D主要包括6個模塊(圖1 (a) 所示):

1)text encoder:用于編碼文本特征,當采用decoder-only VLM作為基座時,則用text tokenizer代替;

2)image encoder:用于編碼多視角圖像,輸出多視角多尺度圖像特征;

3)depth encoder:用于編碼多視角深度圖像,輸出深度特征圖,和圖像特征保持pixel對齊,BIP3D支持純RGB輸入,因此depth encoder為可插拔模塊;

4)feature enhancer:用于融合圖像特征和文本特征;

5)spatial enhancer:利用相機模型對圖像特征加上3D位置編碼,同時融合深度特征;

6)decoder:基于spatial enhancer輸出的3D特征和文本特征,結合任務目標進行解碼;本文主要研究3D感知任務,因此采用了基于deformable aggregation的多視角特征融合算子來實現3D detection和grounding任務。

BIP3D的結構設計使其可以無縫銜接現有vision foundation model,本文采用Grounding-DINO作為基座來初始化BIP3D,以此獲得更好的泛化性、更快的收斂速度以及更高的感知精度。除了Grounding-DINO以外,也可以采用VLM類模型(如Qwen-VL)作為基座。

Spatial Enhancer:相機建模、3D編碼與深度特征融合

連接2D圖像和3D空間最重要的一步就是相機建模,我們首先利用圖像特征進行深度分布估計,得到一系列帶深度的視點及其概率,將這些視點通過相機模型投影到統一的3D空間,并對投影后的3D坐標進行高維映射,拿到3D point embedding,并將這些3D point embedding聯合所預測的概率分布進行加權求和,作為最終的3D position embedding。當模型接收深度圖作為輸入之一時,我們還會再深度估計時引入深度特征,以獲得更精確的深度分布,并在最終輸出的時候將深度特征和圖像特征進行融合,作為decoder的輸入。

我們的3D位置編碼可以提供很好的幾何信息,其特征空間的余弦距離和3D空間的歐氏距離具有顯著的正相關性,如下圖所示。

3D Perception Decoder:多視圖融合和文本特征融合

我們采用query-based detector的結構,如圖1 (d) 所示。首先生成一系列視角相關的bbox3d queries,并使用Deformable Aggregation算子實現任意視角數據的特征融合;為了實現open-set detection和grounding,還加入了text cross-attention。該decoder輸出9 DoF的3d bounding bbox及其高維特征,高維特征和文本特征的余弦距離用來表示置信度。考慮到9 DoF存在方向和尺寸歧義性,我們采用Wasserstein distance作為bbox3d的回歸損失函數。其次我們還加入了文本特征和query之間的對比損失,采用余弦距離和focal loss。具體實現見論文和代碼。

實驗結果

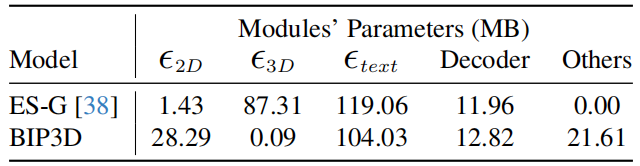

表1對比于BIP3D和point-centric方法的參數量分布情況,可以看出point-centric方法的主要參數量集中在3D encoder,而BIP3D集中在2D encoder,這是point-centric和image-centric的主要區別之一。

表1參數量分布對比

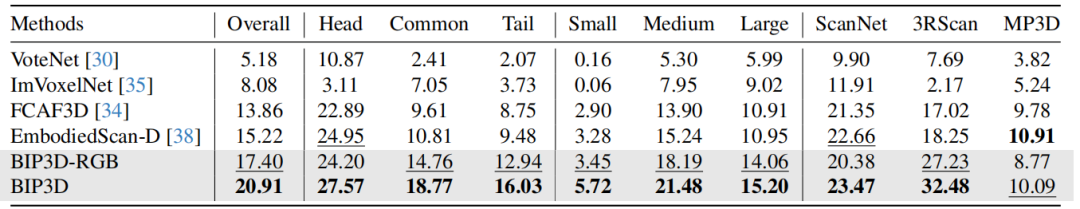

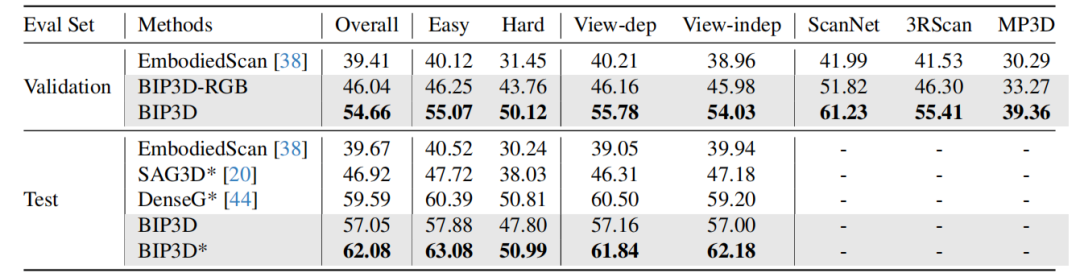

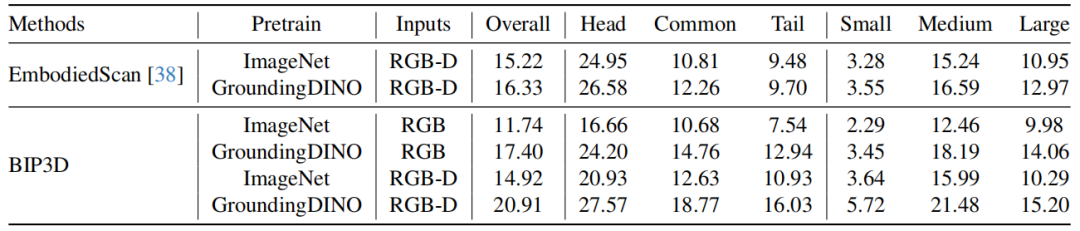

BIP3D在3D檢測和3D grounding上的性能顯著超越了現有方法,各項指標上都超過了EmbodiedScan的baseline。并且,當僅輸入圖像時,在沒有深度圖加持的情況下,BIP3D依然能獲得不錯的感知能力。

表2 3D檢測結果對比

表3 3D Grounding結果對比

我們還證明了,BIP3D這種image-centric的網絡架構可以很好的發揮出vision foundation model的作用,如表4所示。

表4 VFM的作用

更多的實驗結果可見huggingface主頁和論文。

總結與展望

在本研究中,我們提出了一種以圖像為中心的3D感知模型——BIP3D。該模型克服了點云數據的局限性,并充分利用了2D基礎模型的能力,從而在3D感知性能上實現了顯著提升。BIP3D支持多視角圖像、深度圖和文本作為輸入,使其能夠執行3D目標檢測和3D視覺定位任務。我們在EmbodiedScan基準測試中展示了BIP3D的優越性。然而,BIP3D仍有廣闊的探索空間,以下是未來工作的幾個方向:(1) 進一步優化網絡架構和訓練方案,以實現更卓越的感知性能。(2) 將BIP3D應用于動態場景,實現聯合檢測與跟蹤。(3) 引入更多感知任務,如實例分割、占據空間估計和抓取姿態估計。(4) 在BIP3D網絡框架下,改進decoder以支持更高級的任務,如action和3d reasoning。

-

3D

+關注

關注

9文章

2956瀏覽量

110454 -

相機

+關注

關注

4文章

1455瀏覽量

54582 -

感知模型

+關注

關注

0文章

3瀏覽量

5749 -

具身智能

+關注

關注

0文章

131瀏覽量

431

原文標題:CVPR 2025|BIP3D: 連接圖像和3D空間,提升具身智能的空間感知能力

文章出處:【微信號:horizonrobotics,微信公眾號:地平線HorizonRobotics】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

一種以圖像為中心的3D感知模型BIP3D

一種以圖像為中心的3D感知模型BIP3D

評論