日前,OpenAI發布三款語音模型,首次提出"開發者可控制語音情緒"的概念,引發行業對語音交互未來形態的討論。然而,國內外測評顯示,其生成的中文語音仍顯生硬,與國內技術存在明顯差距。這背后揭示了一個更深層的命題:情緒化語音的核心不在于文本轉譯技術,而在于聲學底層能力的突破。

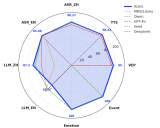

我們通過與GPT-4O-Mini-TTS對比測試發現,聲智開發的語音Agent在中文語境中的情緒表達十分突出,并能根據文字在一定程度上自主判斷情緒模式,而GPT-4O-Mini-TTS僅能機械切換預設的"溫柔"模式。這種差異源于聲學技術對聲音物理本質的解構能力——從聲音分類、聲紋識別再到噪聲抑制,每一個技術細節都在重塑人機交互的深度。

聲學:讓機器學會"用聲音擁抱人類"

在智能音箱時代,聲智科技已攻克遠場喚醒、噪聲抑制、回聲消除三大技術難關,讓機器首次在復雜聲場中準確捕捉人類指令。進入語音Agent時代,我們正在構建更底層的聲學能力框架,在情緒識別與對話上將表現更為出色。

這些技術突破使聲智語音Agent在居家場景能模擬母親哄睡時的氣聲發音,在人類低沉的聲音中尋找需要情緒按摩的入口,讓機器真正理解"聲音"的物理本質,而不僅是"語音"的文字含義。

當OpenAI與Meta爭相布局語音入口時,聲智科技已站在更高維度思考人機交互的本質。我們相信,真正的突破不會來自對情緒標簽的簡單調用,而必須回歸聲學本源。

聲智科技將發布全球首個原生自由交互Voice Agent,它不僅能聽懂你的言語,更能從聲音的震顫中感知你的疲憊,從環境的回聲里讀懂你的孤獨。這或許就是聲學技術帶給人類最溫暖的禮物:讓冷硬的機器,終于學會用"聲音"給予我們一個無形的擁抱。

從Voice Agent到Omni Agent

——聲智定義交互新范式

從上文的分析可以看出,將“情緒”引入語音交互的必要性不辨自明,但需要跳出“語音”(即voice-powered Agent)本身,在聲學領域,探尋聲音分類、聲紋識別、情緒識別的更大可能性。

1、對聲學和硬件入口的探索

未來的語音Agent將不僅依賴語音,還需要通過分析聲音的頻譜、音調變化、反射回聲、環境噪聲等因素,獲取更多的情境信息。這些聲音背后的數據將為AI的決策提供更加準確的反饋,幫助AI實現情感表達的精準控制。

2、情感與環境的增強感知

未來對話式交互的入口并非“voice”,而是“sound”,在人類的語音語言外,原始的聲音環境能傳達更多輔助AI進行判斷和反饋的內容,而對此類聲音信息的收集、分析、處理能力也將成為AI具備像人一樣傳遞情緒并進行自然對話的基礎。AI可以根據用戶的情緒波動靈活調整對話內容與語氣,使對話更具連貫性和自然感。例如,在家庭場景中AI語氣更溫暖,在工作場景中則顯得更冷靜。

3、從Voice Agent到 Omni Agent

未來的語音Agent不止于“聲音”,而應關注跨越多種感官反饋,如視覺、觸覺甚至氣味。AI可以通過手勢、眼動等方式與用戶互動,實現全感官的綜合體驗。這將大大提升語音交互的沉浸感,使AI不僅能“聽懂”語言,還能通過視覺和觸覺反饋提供更加豐富的互動。

4、AI與人類共情的未來展望

AI情感化交互的最終目標是實現“共情”,讓AI不僅能理解用戶的指令,還能理解用戶的情感狀態,給予關懷的回應。通過這種方式,AI將真正成為用戶的“情感伙伴”,提高長時間交互的質量和親密感。

作為全球使用人數最多的語言,中文的聲調變化、語氣助詞、方言體系蘊含著獨特的情感表達邏輯:北京話兒化音中的親昵感、江浙方言句尾上揚表達的委婉拒絕、粵語九聲六調承載的文化語境……這種深度本土化能力,結合我們在智能硬件領域積累的設備適配經驗,正推動聲智語音Agent在多個場景實現規模化落地。

聲學革命正在進行,你準備好迎接真正的共情時代了嗎?

-

人機交互

+關注

關注

12文章

1240瀏覽量

56272 -

Agent

+關注

關注

0文章

128瀏覽量

27654 -

聲智科技

+關注

關注

0文章

51瀏覽量

1695

原文標題:聲智科技定義下一代人機交互標準,人機交互即將開啟“共情模式”

文章出處:【微信號:聲智科技,微信公眾號:聲智科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

STC8H 單片機 + RA8889/RA6809:重新定義嵌入式觸控交互_高流暢、低延遲、零基礎的人機界面(一)

聲智科技全球首發新一代人機交互框架

具身智能工業機器人人機交互設計:重新定義人機協作新體驗

愛普生XV7021BB陀螺儀傳感器在人機交互中的應用

TCL攜手INDEMIND重新定義家庭AI交互邊界

Imagination與瑞薩攜手,重新定義GPU在下一代汽車中的角色

工業人機交互邁入韌性升級時代!益邏科技發布64系列觸控顯示器

啟英泰倫新推出多意圖自然說,重塑離線人機交互新標準!

新的人機交互入口?大模型加持、AI眼鏡賽道開啟百鏡大戰

聲智科技重新定義下一代人機交互標準

聲智科技重新定義下一代人機交互標準

評論