近日,阿里云正式發布Qwen3系列的8款開源混合推理模型。摩爾線程團隊在模型發布當天,率先完成了Qwen3全系列模型在全功能GPU上的高效支持。這一成果充分展現了MUSA架構及全功能GPU在生態兼容性和快速支持能力方面的卓越表現。MUSA架構憑借其強大的易用性,不僅顯著降低了開發者在適配遷移過程中的工作量,更大幅提升了開發效率,為創新成果的快速落地提供了堅實助力。

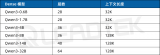

Qwen3作為國內首個“混合推理模型”,創造性將“快思考”與“慢思考”集成進同一個模型,在推理、指令遵循、智能體功能和多語言支持方面取得了突破性的進步。此次開源的兩款MoE模型是Qwen3-235B-A22B和Qwen3-30B-A3B;同時還包括六個Dense模型:Qwen3-32B、Qwen3-14B、Qwen3-8B、Qwen3-4B、Qwen3-1.7B和Qwen3-0.6B。

從官方發布的benchmark測試結果來看:Qwen3-235B-A22B在代碼、數學、通用能力等基準測試中,成績顯著高于OpenAI-o1及Deepseek-R1版本。Qwen3-32B在各項測試中成績同樣優于OpenAI-o3-mini。

快速支持

開放體驗Qwen3創新成果

摩爾線程現已將Qwen3系列模型的支持成果在“夸娥工場”開放上線。“夸娥工場”是摩爾線程傾力打造的模型展示與體驗中心,旨在為用戶提供基于夸娥(KUAE)智算集群支持的模型能力體驗。用戶可通過訪問夸娥工場,親身體驗Qwen3強大的推理模型性能與創新技術。

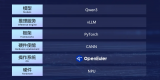

目前,主流推理引擎均可基于摩爾線程MUSA平臺運行Qwen3系列模型。MUSA平臺憑借其卓越性能,能夠作為vLLM、Ollama、GPU Stack等各類主流開源推理引擎的后端,為Qwen3系列模型的高效運行提供強大動力。

例如,QWen3-235B-A22B(Qwen3系列最大參數量模型),基于vLLM-MUSA引擎在摩爾線程全功能GPU上穩定運行。

同時,GPU Stack引擎與llama.cpp/ollama引擎也在摩爾線程圖形顯卡MTT S80上高效運行,充分展現了MUSA平臺的廣泛兼容性與卓越性能。

共建開源生態

持續推動國產GPU發展

摩爾線程積極響應開源社區的號召,旨在賦能更多開發者基于國產全功能GPU進行AI應用創新。此前,在通義千問QwQ-32B發布當日,摩爾線程就成功實現了Day-0支持,這一成果充分驗證了先進MUSA架構和全功能GPU的技術成熟度與可靠性。

我們誠摯歡迎廣大開發者與用戶前往“夸娥工場”進行體驗,與此同時,開發者也可訪問摩爾線程GitHub社區與開發者社區了解更多:

摩爾線程始終致力于推動開源生態的發展,通過技術開放與生態共建,加速國產全功能GPU在AI計算領域的規模化應用,為更多用戶提供更智能、高效的解決方案。

關于摩爾線程

摩爾線程成立于2020年10月,以全功能GPU為核心,致力于向全球提供加速計算的基礎設施和一站式解決方案,為各行各業的數智化轉型提供強大的AI計算支持。

我們的目標是成為具備國際競爭力的GPU領軍企業,為融合人工智能和數字孿生的數智世界打造先進的加速計算平臺。我們的愿景是為美好世界加速。

-

gpu

+關注

關注

28文章

4948瀏覽量

131259 -

模型

+關注

關注

1文章

3521瀏覽量

50437 -

摩爾線程

+關注

關注

2文章

235瀏覽量

5371

原文標題:Day-0支持|摩爾線程GPU率先支持Qwen3全系列模型

文章出處:【微信號:moorethreads,微信公眾號:摩爾線程】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

廣和通加速通義千問Qwen3在端側全面落地

壁仞科技完成Qwen3旗艦模型適配

Arm CPU適配通義千問Qwen3系列模型

Intel OpenVINO? Day0 實現阿里通義 Qwen3 快速部署

NVIDIA RTX 5880 Ada與Qwen3系列模型實測報告

MediaTek天璣9400率先完成阿里Qwen3模型部署

后摩智能NPU適配通義千問Qwen3系列模型

中科曙光DeepAI深算智能引擎全面支持Qwen3

幾B都有!BM1684X一鍵適配全系列Qwen3

壁仞科技完成阿里巴巴通義千問Qwen3全系列模型支持

摩爾線程GPU成功適配Deepseek-V3-0324大模型

摩爾線程GPU率先支持Qwen3全系列模型

摩爾線程GPU率先支持Qwen3全系列模型

評論