深度卷積神經(jīng)網(wǎng)絡(luò)是這一波 AI 浪潮背后的大功臣。雖然很多人可能都已經(jīng)聽(tīng)說(shuō)過(guò)這個(gè)名詞,但是對(duì)于這個(gè)領(lǐng)域的相關(guān)從業(yè)者或者科研學(xué)者來(lái)說(shuō),淺顯的了解并不足夠。近日,約克大學(xué)電氣工程與計(jì)算機(jī)科學(xué)系的 Isma Hadji 和 Richard P. Wildes 發(fā)表了一篇《我們?cè)撊绾卫斫饩矸e神經(jīng)網(wǎng)絡(luò)?》的論文:

第一章回顧了理解卷積神經(jīng)網(wǎng)絡(luò)的動(dòng)機(jī);

第二章闡述了幾種多層神經(jīng)網(wǎng)絡(luò),并介紹當(dāng)前計(jì)算機(jī)視覺(jué)領(lǐng)域應(yīng)用中最成功的卷積結(jié)構(gòu);

第三章具體介紹了標(biāo)準(zhǔn)卷積神經(jīng)網(wǎng)絡(luò)中的各構(gòu)成組件,并從生物學(xué)和理論兩個(gè)角度分析不同組件的設(shè)計(jì)方案;

第四章討論了當(dāng)前卷積神經(jīng)網(wǎng)絡(luò)設(shè)計(jì)的趨勢(shì)及可視化理解卷積神經(jīng)網(wǎng)絡(luò)的相關(guān)研究工作,還重點(diǎn)闡述了當(dāng)前結(jié)構(gòu)仍存在的一些關(guān)鍵問(wèn)題。

通過(guò)這篇文章,我們希望幫助大家加深對(duì)卷積神經(jīng)網(wǎng)絡(luò)的理解,并對(duì)這個(gè)重要概念有一個(gè)全面的認(rèn)知。

第一章

引言

▌本文動(dòng)機(jī)

過(guò)去幾年,計(jì)算機(jī)視覺(jué)研究主要集中在卷積神經(jīng)網(wǎng)絡(luò)上(通常簡(jiǎn)稱為 ConvNet 或 CNN),在大量諸如分類和回歸任務(wù)上已經(jīng)實(shí)現(xiàn)了目前為止最佳的表現(xiàn)。盡管這些方法的歷史可以追溯到多年前,但相對(duì)而言,對(duì)這些方法的理論理解及對(duì)結(jié)果的解釋還比較淺薄。

實(shí)際上,計(jì)算機(jī)視覺(jué)領(lǐng)域的很多成果都把 CNN 當(dāng)作了一種黑箱,這種方式雖然有效的,但對(duì)結(jié)果的解釋卻是模糊不清的,這也無(wú)法滿足科學(xué)研究的需求。尤其是當(dāng)這兩個(gè)問(wèn)題是互補(bǔ)關(guān)系時(shí):

(1)學(xué)習(xí)的方面(比如卷積核),它到底學(xué)習(xí)到的是什么?

(2)模型結(jié)構(gòu)設(shè)計(jì)方面(比如卷積層數(shù)量、卷積核數(shù)量、池化策略、非線性函數(shù)的選擇),為什么某些組合會(huì)優(yōu)于其他組合呢?求解這些問(wèn)題的答案,不僅有利于我們更好地理解卷積神經(jīng)網(wǎng)絡(luò),而且還能進(jìn)一步提升它的工程實(shí)用性。

此外,當(dāng)前 CNN 的實(shí)現(xiàn)方法都需要大量訓(xùn)練數(shù)據(jù),而且模型的設(shè)計(jì)方案對(duì)最終的結(jié)果有很大的影響。而更深層的理論理解應(yīng)該減輕模型對(duì)數(shù)據(jù)的依賴性。盡管大量的研究已經(jīng)集中在卷積神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)方式,但目前為止,這些研究結(jié)果很大程度上還只局限在對(duì)卷積操作內(nèi)部處理的可視化上,目的是為了理解卷積神經(jīng)網(wǎng)絡(luò)中不同層的變化情況。

▌本文目標(biāo)

針對(duì)以上問(wèn)題,本文將綜述幾種當(dāng)前最優(yōu)秀的多層卷積結(jié)構(gòu)模型。更重要的是,本文還將通過(guò)不同方法來(lái)總結(jié)標(biāo)準(zhǔn)卷積神經(jīng)網(wǎng)絡(luò)的各種組件,并介紹它們所基于的生物學(xué)或合理的理論基礎(chǔ)。此外,本文還將介紹如何通過(guò)可視化方法及實(shí)例研究來(lái)嘗試?yán)斫饩矸e神經(jīng)網(wǎng)絡(luò)內(nèi)部的變化情況。我們的最終目標(biāo)是向讀者詳細(xì)展示卷積神經(jīng)網(wǎng)絡(luò)中所涉及到的每一個(gè)卷積層操作,著重強(qiáng)調(diào)當(dāng)前最先進(jìn)的卷積神經(jīng)網(wǎng)絡(luò)模型并說(shuō)明未來(lái)仍需解決的問(wèn)題。

第二章

▌多層網(wǎng)絡(luò)結(jié)構(gòu)

近年來(lái),在深度學(xué)習(xí)或深層神經(jīng)網(wǎng)絡(luò)取得成功前,計(jì)算機(jī)視覺(jué)識(shí)別系統(tǒng)最先進(jìn)的方法主要由兩個(gè)步驟組成,這兩個(gè)步驟各自分離但又互補(bǔ):首先,我們需要通過(guò)人工設(shè)計(jì)操作(如卷積、局部或全局編碼方法)將輸入數(shù)據(jù)轉(zhuǎn)換成合適的形式。這種輸入的變換形式,通常是為了得到輸入數(shù)據(jù)的一種緊湊或抽象的表征,同時(shí)還要根據(jù)當(dāng)前任務(wù)的需要手動(dòng)設(shè)計(jì)一些不變量。通過(guò)這種轉(zhuǎn)換,我們能夠?qū)⑤斎霐?shù)據(jù)表征成一種更容易分離或識(shí)別的形式,這有助于后續(xù)的識(shí)別分類。其次,轉(zhuǎn)換后的數(shù)據(jù)通常作為分類器(如支持向量機(jī))訓(xùn)練的輸入信號(hào)。通常而言,任何分類器的表現(xiàn)都會(huì)受到變換后的數(shù)據(jù)質(zhì)量及所使用的變換方法的影響。

多層神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)的出現(xiàn)為解決這一問(wèn)題帶來(lái)了新的方式,這種多層結(jié)構(gòu)不僅能夠訓(xùn)練目標(biāo)分類器,還能從輸入數(shù)據(jù)中直接學(xué)習(xí)所需的變換操作。這種學(xué)習(xí)方式通常稱為表征學(xué)習(xí),當(dāng)將其應(yīng)用在深度或多層神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)中時(shí),我們稱之為深度學(xué)習(xí)。

多層神經(jīng)網(wǎng)絡(luò)定義為是一種從輸入數(shù)據(jù)的層次抽象表征中提取有用信息的計(jì)算模型。一般而言,設(shè)計(jì)多層網(wǎng)絡(luò)結(jié)構(gòu)的目標(biāo)是為了在高層凸顯輸入數(shù)據(jù)的重要信息,同時(shí)能讓那些不太不重要的信息變化更具魯棒性。

近年來(lái),研究者已經(jīng)提出了很多不同類型的多層架構(gòu),而大多數(shù)的多層神經(jīng)網(wǎng)絡(luò)都是以堆疊的方式,將一些線性和非線性函數(shù)模塊組合形成多層結(jié)構(gòu)。本章將會(huì)覆蓋計(jì)算機(jī)視覺(jué)應(yīng)用中最先進(jìn)的多層神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)。其中,人工神經(jīng)網(wǎng)絡(luò)是我們需要的關(guān)注重點(diǎn),因?yàn)檫@種網(wǎng)絡(luò)結(jié)構(gòu)的表現(xiàn)非常突出。為了方便起見(jiàn),在下文我們會(huì)直接將這類網(wǎng)絡(luò)稱為神經(jīng)網(wǎng)絡(luò)。

神經(jīng)網(wǎng)絡(luò)

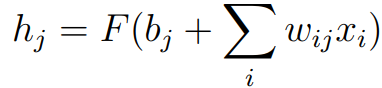

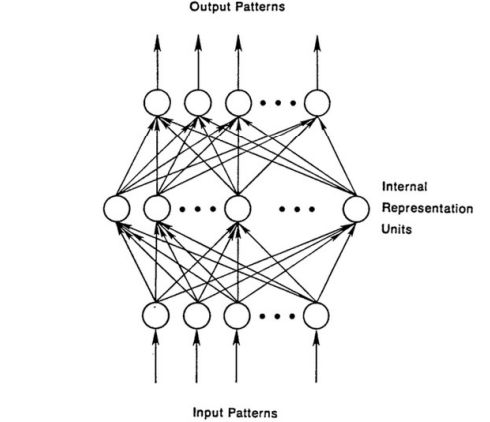

標(biāo)準(zhǔn)的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)通常由輸入層 x,輸出層 y 和多個(gè)隱藏層 h 堆疊而成,其中每個(gè)層還由多個(gè)單元組成,如下圖所示。通常,每個(gè)隱藏單元 hj 接受上一層所有單元的輸入,并將其加權(quán)組合,其非線性組合的數(shù)學(xué)形式如下:

wij 是權(quán)重值,用于控制輸入單位和隱藏單位之間連接的強(qiáng)度,bj 是隱藏單位的偏置,F(xiàn) 是非線性函數(shù),如 Sigmoid 函數(shù)。

深度神經(jīng)網(wǎng)絡(luò)可以被視為是 Rosenblatt 感知器及多層感知器的實(shí)例。 盡管神經(jīng)網(wǎng)絡(luò)模型已經(jīng)存在多年(即自 1960 年代以來(lái)),但它們并未被廣泛使用。造成這種的原因有很多,最主要的原因是感知器無(wú)法模擬像 XOR 這樣的簡(jiǎn)單操作而被外界否定,這也進(jìn)一步阻礙了研究人員對(duì)感知器的研究。

直到最近,一些研究人員將簡(jiǎn)單感知器擴(kuò)展到多層神經(jīng)網(wǎng)絡(luò)模型。 此外,缺乏適當(dāng)?shù)挠?xùn)練算法也會(huì)延緩感知度的訓(xùn)練進(jìn)度,而反向傳播算法的提出也使得神經(jīng)網(wǎng)絡(luò)模型得以普及。更重要的是,多層神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)依賴于大量的參數(shù),這就意味著我們需要大量的訓(xùn)練數(shù)據(jù)和計(jì)算資源來(lái)支持模型訓(xùn)練及學(xué)習(xí)參數(shù)過(guò)程。

標(biāo)準(zhǔn)神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)示意圖

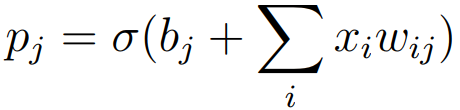

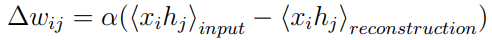

受限波爾茨曼機(jī)(RBM)的提出是深層神經(jīng)網(wǎng)絡(luò)領(lǐng)域的一大重要貢獻(xiàn)。受限玻耳茲曼機(jī)可以看作是兩層的神經(jīng)網(wǎng)絡(luò),只允許網(wǎng)絡(luò)以前饋連接的方式堆疊。而神經(jīng)網(wǎng)絡(luò)可以看作是使用受限波爾茨曼機(jī)進(jìn)行分層無(wú)監(jiān)督預(yù)訓(xùn)練的一種模型,在圖像識(shí)別任務(wù)中,這種無(wú)監(jiān)督學(xué)習(xí)方法主要包括三個(gè)步驟:首先,對(duì)于圖像中的每個(gè)像素,對(duì) xi 及初始化的 wij、偏置 bj、隱藏層狀態(tài) hj,其概率可以被定義為:

其中,σ(y)= 1 /(1 + exp(-y))。

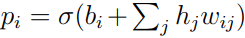

其次,如上式所示,一旦所有的隱藏狀態(tài)都被隨機(jī)設(shè)定,我們可以根據(jù)概率  將每個(gè)像素設(shè)定為 1,并以此重建圖像。

將每個(gè)像素設(shè)定為 1,并以此重建圖像。

然后,隱藏單元將通過(guò)重建的權(quán)重和偏差來(lái)更新校正單位的誤差:

其中,α 是學(xué)習(xí)率,(xihj)表示隱藏單元 hj 中像素 xi 出現(xiàn)的次數(shù)。整個(gè)訓(xùn)練過(guò)程將重復(fù) N 次或直到誤差下降到預(yù)設(shè)的閾值 τ。訓(xùn)練完一層后,使用它的輸出作為下一層的輸入,然后接著重復(fù)上述過(guò)程訓(xùn)練下一層。通常,網(wǎng)絡(luò)中的所有層經(jīng)過(guò)預(yù)訓(xùn)練后,它們還將通過(guò)梯度下降的方式,反向傳播誤差來(lái)進(jìn)一步微調(diào)標(biāo)記數(shù)據(jù)。使用這種分層無(wú)監(jiān)督預(yù)訓(xùn)練的方式可以不需大量標(biāo)記數(shù)據(jù)的情況下,訓(xùn)練深層神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)。因?yàn)槔檬芟薏柎穆鼨C(jī)進(jìn)行無(wú)監(jiān)督預(yù)訓(xùn)練,能夠?yàn)槟P蛥?shù)的初始化提供了一種有效途徑。受限波爾茨曼機(jī)的第一個(gè)成功應(yīng)用案例是用于人臉識(shí)別的降維,它們被當(dāng)作是一種自編碼器。

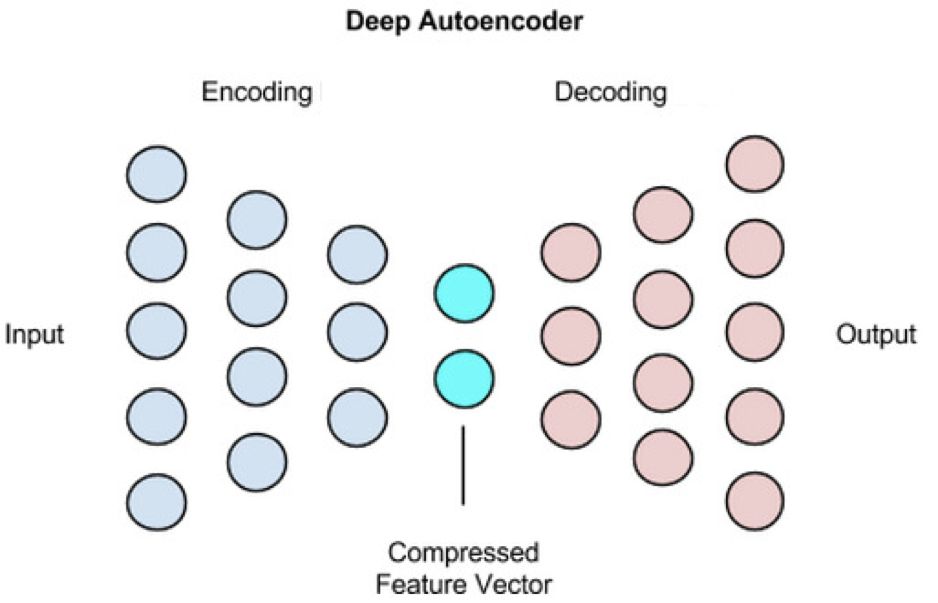

自動(dòng)編碼器主要是通過(guò)引入不同的正則化方法來(lái)防止模型學(xué)習(xí)一些無(wú)關(guān)緊要的數(shù)據(jù)特征。目前一些比較優(yōu)秀的編碼器包括稀疏自編碼器、去噪自編碼器(DAE)和壓縮自編碼器(CAE)等。稀疏自編碼器允許中間編碼表示的大小(即由輸入生成編碼器)大于輸入的大小,同時(shí)通過(guò)稀疏表示來(lái)正則化負(fù)相的輸出。相反,去噪自編碼器改變了編碼重建本身的目標(biāo),試圖重建一個(gè)干凈、不帶噪聲的輸入版本,得到一個(gè)更加強(qiáng)大的表示。類似地,壓縮自編碼器是通過(guò)懲罰噪聲中最敏感的單位來(lái)實(shí)現(xiàn)類似去噪自編碼器的過(guò)程。

標(biāo)準(zhǔn)的自編碼器結(jié)構(gòu)

循環(huán)神經(jīng)網(wǎng)絡(luò)

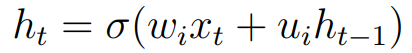

循環(huán)神經(jīng)網(wǎng)絡(luò)是處理序列數(shù)據(jù)相關(guān)任務(wù)最成功的多層神經(jīng)網(wǎng)絡(luò)模型(RNN)。 RNN,其結(jié)構(gòu)示意圖如下圖所示,它可以看作是神經(jīng)網(wǎng)絡(luò)的一種特殊類型,隱藏單元的輸入由當(dāng)前時(shí)間步所觀察到的數(shù)據(jù)中獲取輸入以及它在前一個(gè)時(shí)間步的狀態(tài)組合而成。 循環(huán)神經(jīng)網(wǎng)絡(luò)的輸出定義如下:

其中 σ 表示一些非線性函數(shù),wi 和ui 是網(wǎng)絡(luò)參數(shù),用于控制當(dāng)前和過(guò)去信息的相對(duì)重要性。

標(biāo)準(zhǔn)的循環(huán)神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)示意圖

每個(gè)循環(huán)單元的輸入將由當(dāng)前時(shí)刻的輸入 xt 及上一時(shí)刻 ht-1 組成,新的輸出表示可通過(guò)上式計(jì)算得到,并傳遞給循環(huán)神經(jīng)網(wǎng)絡(luò)中的其他層。

雖然循環(huán)神經(jīng)網(wǎng)絡(luò)是一類強(qiáng)大的多層神經(jīng)網(wǎng)絡(luò)模型,但其的主要問(wèn)題是模型對(duì)時(shí)間的長(zhǎng)期依賴性,由于梯度爆炸或梯度消失,這種限制將導(dǎo)致模型訓(xùn)練過(guò)程在網(wǎng)絡(luò)回傳過(guò)程中誤差的不平穩(wěn)變化。為了糾正這個(gè)困難,引入了長(zhǎng)短期記憶網(wǎng)絡(luò)(LSTM)。

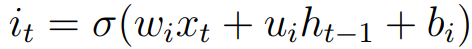

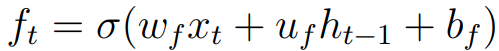

長(zhǎng)短期記憶網(wǎng)絡(luò)(LSTM)的結(jié)構(gòu)示意圖下圖所示,擁有存儲(chǔ)單元或記憶單元,隨著時(shí)間的推移存儲(chǔ)記憶信息。LSTM 的存儲(chǔ)單元是通過(guò)門控機(jī)制從中讀取信息或?qū)懭胄畔ⅰ?值得注意的是,LSTM 還包含遺忘門,即網(wǎng)絡(luò)能夠刪除一些不必要的信息。總的來(lái)說(shuō), LSTM 的結(jié)構(gòu)主要包含有:三個(gè)控制不同的門(輸入門、遺忘門及輸出門),以及存儲(chǔ)單元狀態(tài)。 輸入門由當(dāng)前輸入 xt 和前一個(gè)狀態(tài) ht-1 控制,它的定義如下:

其中,wi,ui,bi 表示權(quán)重和偏差項(xiàng),用于控制與輸入門相關(guān)的權(quán)重,σ 通常是一個(gè) Sigmoid 函數(shù)。類似地,遺忘門定義如下:

相應(yīng)地,權(quán)重和偏差項(xiàng)由 wf,uf,bf 控制。 可以說(shuō),LSTM 最重要的一點(diǎn)是它可以應(yīng)對(duì)梯度消失或梯度爆炸時(shí)網(wǎng)絡(luò)中誤差傳播不平穩(wěn)的挑戰(zhàn)。這種能力的實(shí)現(xiàn)是通過(guò)遺忘門和輸入門的狀態(tài)進(jìn)行加法結(jié)合來(lái)確定存儲(chǔ)單元的狀態(tài)。

標(biāo)準(zhǔn)的長(zhǎng)短期記憶網(wǎng)絡(luò)結(jié)構(gòu)示意圖

每個(gè)循環(huán)單元的輸入將由當(dāng)前時(shí)刻的輸入 xt 及上一時(shí)刻 ht-1 組成,網(wǎng)絡(luò)的返回值將饋送到下一時(shí)刻 ht。LSTM 最終的輸出由輸入門 it,遺忘門 ft 及輸出門 ot 和記憶單元狀態(tài) ct 共同決定。

卷積神經(jīng)網(wǎng)絡(luò)

卷積網(wǎng)絡(luò)(ConvNets)是一種特殊的神經(jīng)網(wǎng)絡(luò)類型,其特別適合計(jì)算機(jī)視覺(jué)應(yīng)用,因?yàn)樗鼈儗?duì)于局部操作有很強(qiáng)的抽象表征能力。推動(dòng)卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)在計(jì)算機(jī)視覺(jué)中成功應(yīng)用的兩個(gè)關(guān)鍵性的因素:

第一,卷積神經(jīng)網(wǎng)絡(luò)能夠利用圖像的 2D 結(jié)構(gòu)和圖像相鄰像素之間的高度相關(guān)性,從而避免在所有像素單元之間使用一對(duì)一連接(即如同大多數(shù)全連接的神經(jīng)網(wǎng)絡(luò)),這有利于使用分組的局部連接。此外,卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)依賴于特征共享原則,正如下圖所示,每個(gè)通道的輸出(或輸出的特征映射)都是通過(guò)所有位置的相同濾波器的卷積生成。相比于標(biāo)準(zhǔn)的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),卷積神經(jīng)網(wǎng)絡(luò)的這個(gè)重要特性依賴于很少的模型參數(shù)。

標(biāo)準(zhǔn)的卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)示意圖

第二,卷積神經(jīng)網(wǎng)絡(luò)還引入一個(gè)池化步驟,在一定程度上保證了圖像的平移不變性,這使得模型不受位置變化的影響。還值得注意的是,池化操作使得網(wǎng)絡(luò)擁有更大的感受野,從而能夠接受更大的輸入。感受野的增大,將允許網(wǎng)絡(luò)在更深層學(xué)習(xí)到更加抽象的特征表征。例如,對(duì)于目標(biāo)識(shí)別任務(wù),卷積網(wǎng)絡(luò)中的淺層將學(xué)習(xí)到圖像的一些邊、角特征,而在更深層能夠?qū)W習(xí)到整個(gè)目標(biāo)的特征。

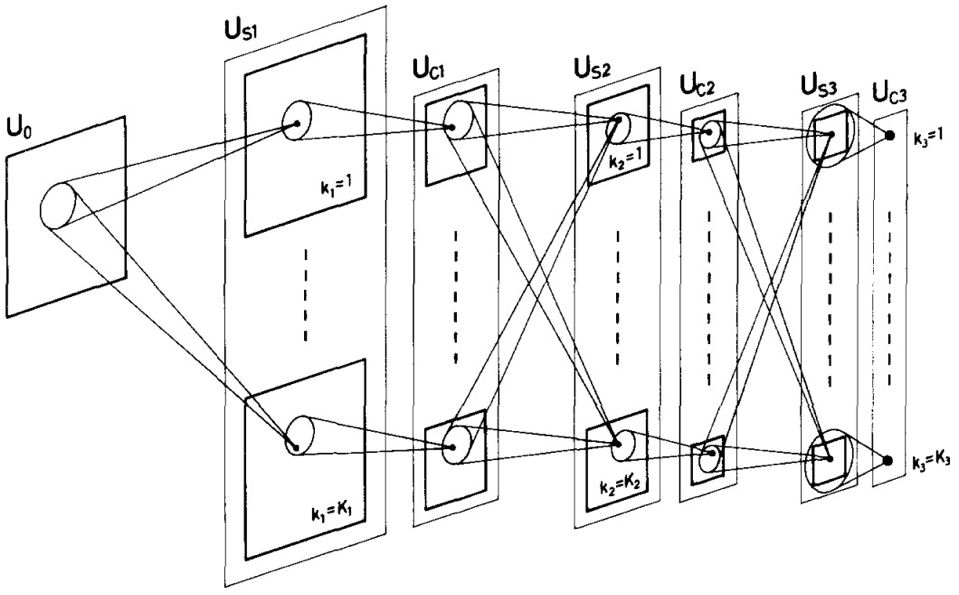

卷積神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)最早是受生物視覺(jué)機(jī)制啟發(fā)而設(shè)計(jì)的,正如 Hube 在其開(kāi)創(chuàng)性的研究中所描述的人類視覺(jué)皮層的工作原理。隨后,F(xiàn)ukushima 提出的神經(jīng)感知器(Neocognitron)是卷積神經(jīng)網(wǎng)絡(luò)的前身,它依賴局部連接的方式,由 K 層神經(jīng)網(wǎng)絡(luò)層級(jí)聯(lián)而成,每層神經(jīng)網(wǎng)絡(luò)由 S-cell 單元,U sl 及復(fù)雜的單元相間分布而成,這種交替分布的形式是模仿生物簡(jiǎn)單細(xì)胞中的處理機(jī)制而設(shè)計(jì)的,其結(jié)構(gòu)示意圖如下圖所示。

神經(jīng)感知器結(jié)構(gòu)示意圖

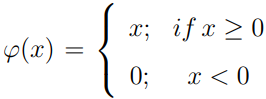

此外,在卷積操作后都會(huì)跟隨一個(gè)非線性變化單元,常見(jiàn)的非線性函數(shù)是修正線形單元 ReLu,其數(shù)學(xué)表達(dá)式如下:

在非線性變換后,通常會(huì)引入池化單元。平均池化操作是常用的池化操作之一,通過(guò)平均化感受野中的像素值,來(lái)綜合考慮周圍像素的特征。而最大池化則是用來(lái)提取相鄰像素間最重要的特征信息,避免模型學(xué)習(xí)到一些無(wú)關(guān)緊要的特征。經(jīng)典的卷積網(wǎng)絡(luò)由四個(gè)基本處理層組成: 卷積層、非線性變換層、歸一化層及池化層。

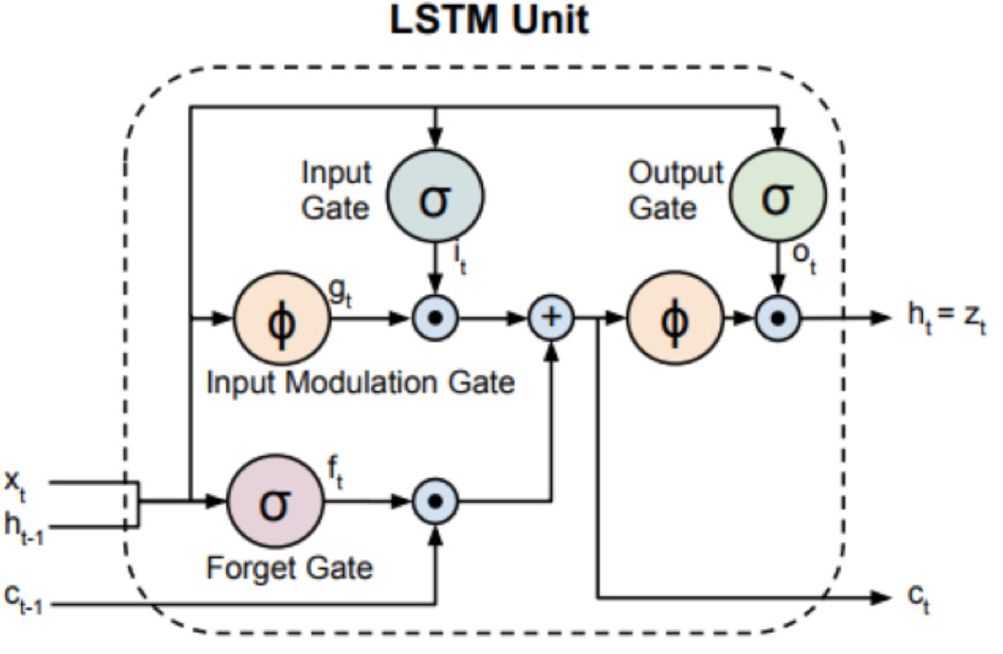

近年來(lái),在計(jì)算機(jī)視覺(jué)領(lǐng)域中所應(yīng)用的卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),大多是基于 Lecun 在 1998 年提出的用于手寫(xiě)字母識(shí)別的 LeNet 卷積模型結(jié)構(gòu)。LeNet 的一個(gè)關(guān)鍵是加入反向傳播過(guò)程來(lái)更有效地學(xué)習(xí)卷積參數(shù)。與全連接神經(jīng)網(wǎng)絡(luò)相比,雖然卷積神經(jīng)網(wǎng)絡(luò)有其獨(dú)特的優(yōu)勢(shì),但其對(duì)于標(biāo)簽數(shù)據(jù)的嚴(yán)重依賴性,也是其未被廣泛使用的主要原因之一。直到 2012 年,隨著大型 ImageNet 數(shù)據(jù)集的發(fā)布及計(jì)算能力的提高,人們重新恢復(fù)對(duì)卷積神經(jīng)網(wǎng)絡(luò)的研究興趣。

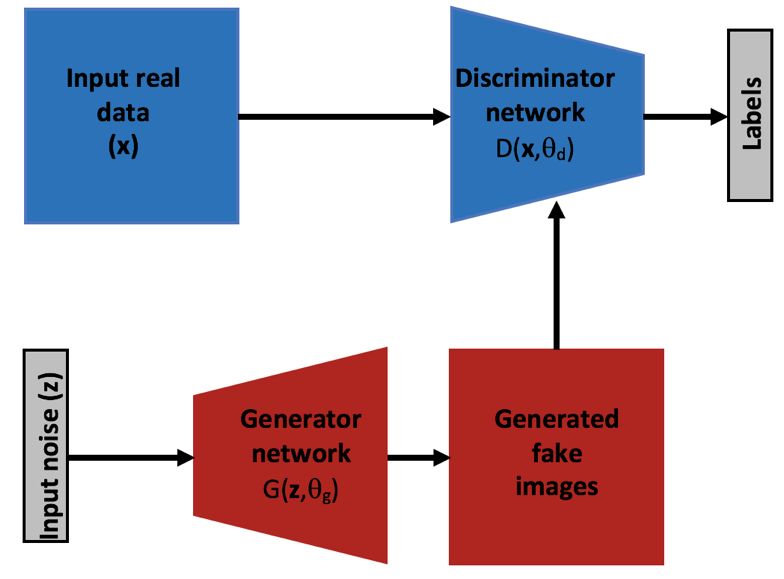

生成對(duì)抗網(wǎng)絡(luò)

生成對(duì)抗網(wǎng)絡(luò)是 2014 年首次引入的一種新型多層神經(jīng)網(wǎng)絡(luò)模型,這種模型結(jié)構(gòu)充分體現(xiàn)了多層網(wǎng)絡(luò)架構(gòu)的強(qiáng)大性。雖然生成對(duì)抗網(wǎng)絡(luò)并沒(méi)有多種不同的網(wǎng)絡(luò)構(gòu)建模塊,但這種網(wǎng)絡(luò)結(jié)構(gòu)具有一些特殊性,最關(guān)鍵的是引入了無(wú)監(jiān)督學(xué)習(xí)方式,使得模型的訓(xùn)練學(xué)習(xí)不再依賴大量的標(biāo)記數(shù)據(jù)。

一個(gè)標(biāo)準(zhǔn)的生成對(duì)抗模型主要由兩部分子網(wǎng)絡(luò)組成:生成網(wǎng)絡(luò) G 和判別網(wǎng)絡(luò) D,如下圖所示,兩個(gè)子網(wǎng)絡(luò)都是預(yù)先定義好的多層網(wǎng)絡(luò)結(jié)構(gòu)(最初提出的模型中二者都是多層全連接網(wǎng)絡(luò))。經(jīng)過(guò)交替對(duì)抗訓(xùn)練,判別網(wǎng)絡(luò)的目標(biāo)是鑒別生成網(wǎng)絡(luò)的生成數(shù)據(jù)標(biāo)簽與真實(shí)數(shù)據(jù)標(biāo)簽之間的真?zhèn)危删W(wǎng)絡(luò)的目標(biāo)是生成更加優(yōu)化的數(shù)據(jù),以 “欺騙”判別網(wǎng)絡(luò),訓(xùn)練的最終結(jié)果是使得生成的數(shù)據(jù)達(dá)到以假亂真的目的。

通用的生成對(duì)抗網(wǎng)絡(luò)結(jié)構(gòu)示意圖

生成對(duì)抗網(wǎng)絡(luò)自提出以來(lái),因其強(qiáng)大的多層網(wǎng)絡(luò)結(jié)構(gòu)及獨(dú)特的無(wú)監(jiān)督學(xué)習(xí)方式,得到了廣泛的關(guān)注和研究。GAN 的成功應(yīng)用包括:文本到圖像合成(其中網(wǎng)絡(luò)的輸入是要呈現(xiàn)圖像的文字描述);超分辨率圖像的生成,即用較低分辨率的輸入生成逼真的高分辨率圖像;圖像修復(fù),即用 GAN 來(lái)生成來(lái)自輸入圖像中的缺失信息;紋理合成,即從輸入噪聲中生成逼真的紋理特征。

多層網(wǎng)絡(luò)的訓(xùn)練

如前所述,當(dāng)前各種多層神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)所取得的成功,在很大程度上取決于網(wǎng)絡(luò)訓(xùn)練學(xué)習(xí)過(guò)程的進(jìn)步。通常,神經(jīng)網(wǎng)絡(luò)的訓(xùn)練首先需要進(jìn)行多層無(wú)監(jiān)督預(yù)訓(xùn)練,隨后,將預(yù)訓(xùn)練好的模型進(jìn)行有監(jiān)督訓(xùn)練,訓(xùn)練過(guò)程都是基于梯度下降的反向傳播原則,通過(guò)反向傳播網(wǎng)絡(luò)誤差,來(lái)更正修正模型的參數(shù)值,從而優(yōu)化網(wǎng)絡(luò)結(jié)構(gòu)及輸出結(jié)果。

遷移學(xué)習(xí)

多層神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)的一大益處是在跨數(shù)據(jù)集甚至跨不同任務(wù)中,模型所學(xué)得的特征具有通用的適用性。在多層網(wǎng)絡(luò)結(jié)構(gòu)中,隨著層次的增加,所學(xué)得的特征表征通常也是從簡(jiǎn)單到復(fù)雜、從局部到全局發(fā)展。因此,在低層次提取的特征往往適用于多種不同任務(wù),這使得多層結(jié)構(gòu)更容易進(jìn)行遷移學(xué)習(xí)。

▌空間卷積神經(jīng)網(wǎng)絡(luò)

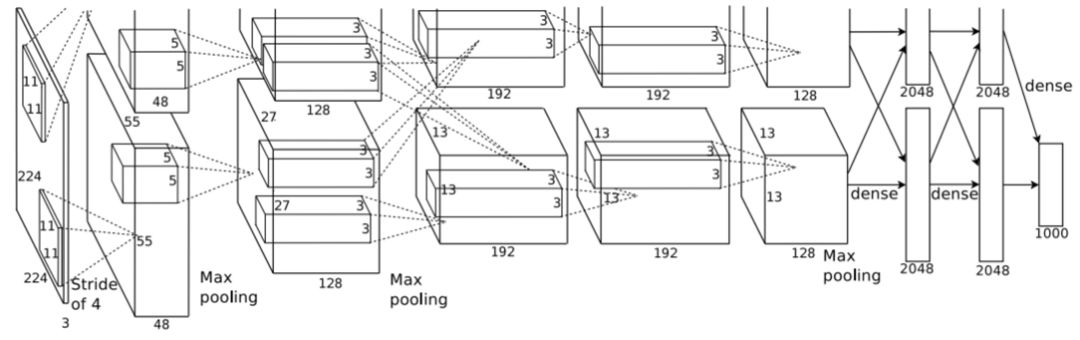

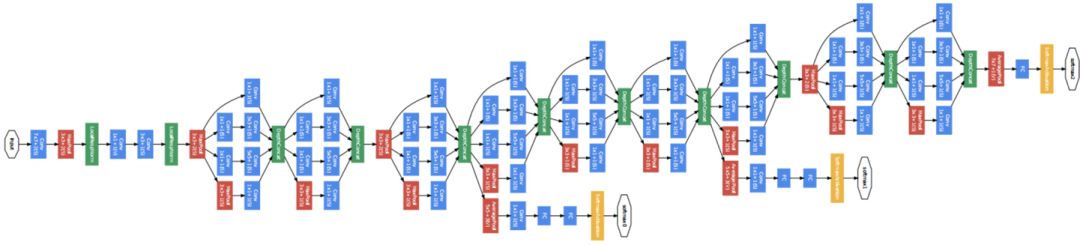

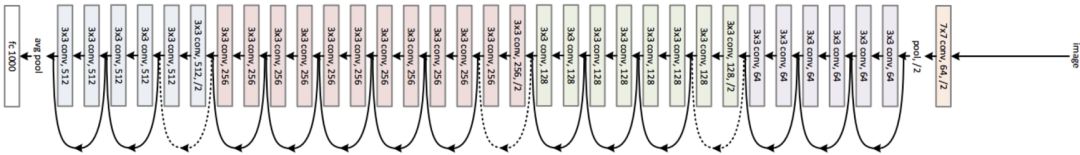

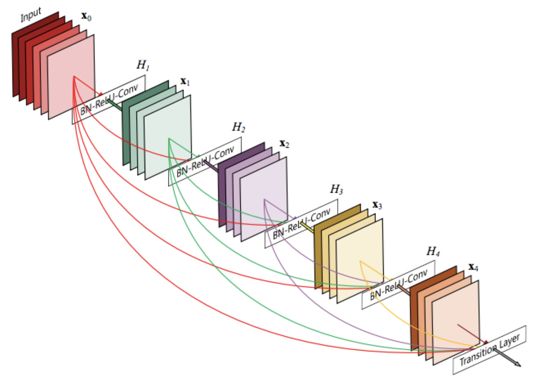

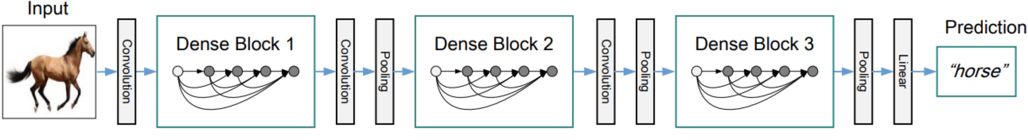

理論上,卷積神經(jīng)網(wǎng)絡(luò)可以應(yīng)用于任意維度的數(shù)據(jù),特別適用于二維的圖像數(shù)據(jù),因此卷積結(jié)構(gòu)在計(jì)算機(jī)視覺(jué)領(lǐng)域受到了相當(dāng)關(guān)注。隨著可用的大規(guī)模數(shù)據(jù)集和強(qiáng)大的計(jì)算機(jī)能力的發(fā)展,卷積神經(jīng)網(wǎng)絡(luò)在計(jì)算機(jī)視覺(jué)領(lǐng)域的應(yīng)用也日益增長(zhǎng)。本節(jié)我們將介紹幾種最突出的卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),包括 AlexNet,VGGNet,GoogleNet,ResNet,DenseNet 等,其結(jié)構(gòu)示意圖依次如下,這些體系結(jié)構(gòu)都是基于原始的 LeNet 發(fā)展起來(lái)的。

AlexNet 模型結(jié)構(gòu)示意圖。值得注意的是,這種結(jié)構(gòu)由兩個(gè)分支網(wǎng)絡(luò)構(gòu)成,分別在兩個(gè)不同的 GPU 上并行訓(xùn)練。

GoogleNet 模型結(jié)構(gòu)示意圖。該模型由多個(gè) Inception 模塊構(gòu)成。

ResNet 模型結(jié)構(gòu)示意圖。該模型由多個(gè)殘差模塊構(gòu)成。

DenseNet 模型結(jié)構(gòu)示意圖。該模型由多個(gè)密集模塊堆疊而成。

卷積神經(jīng)網(wǎng)絡(luò)的不變形

使用卷積神經(jīng)網(wǎng)絡(luò)的一大挑戰(zhàn)是需要非常大的數(shù)據(jù)集來(lái)訓(xùn)練并學(xué)習(xí)模型的所有基本參數(shù)。但即便是當(dāng)前大規(guī)模的數(shù)據(jù)集,如 ImageNet 擁有超過(guò)一百萬(wàn)張圖像數(shù)據(jù)的數(shù)據(jù)集,仍然無(wú)法滿足深層卷積結(jié)構(gòu)訓(xùn)練的需要。通常,在模型訓(xùn)練前,我們會(huì)通過(guò)數(shù)據(jù)增強(qiáng)操作來(lái)處理數(shù)據(jù)集:即通過(guò)隨機(jī)翻轉(zhuǎn)、旋轉(zhuǎn)等操作來(lái)改變圖像,從而增加數(shù)據(jù)樣本的數(shù)量。

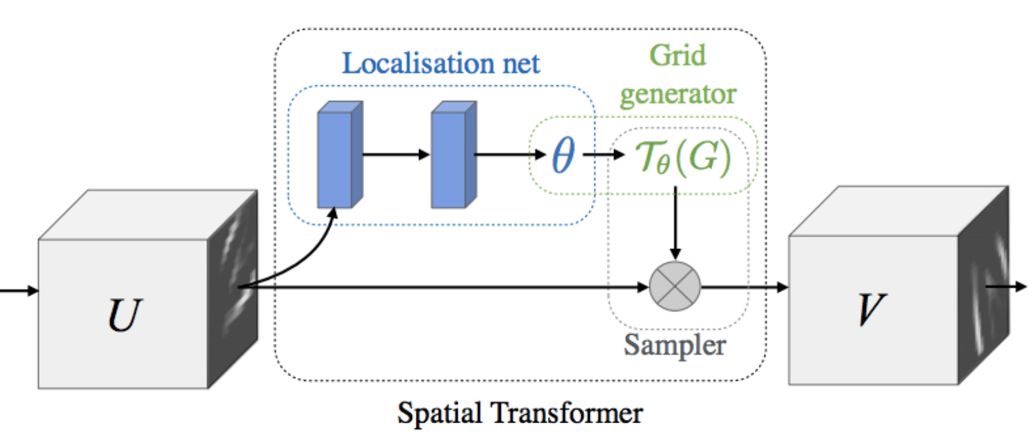

這些數(shù)據(jù)增強(qiáng)操作的主要優(yōu)點(diǎn)是使得網(wǎng)絡(luò)對(duì)于各種圖像轉(zhuǎn)換更加魯棒,這項(xiàng)技術(shù)也是 AlexNet 取得成功的主要原因之一。因此,除了上述改變網(wǎng)絡(luò)架構(gòu)以簡(jiǎn)化訓(xùn)練的方法之外,其他的研究工作旨在引入新穎的模塊結(jié)構(gòu)來(lái)更好的訓(xùn)練模型。處理不變性最大化的一種優(yōu)秀結(jié)構(gòu)是空間變換網(wǎng)絡(luò)(STN)。具體的說(shuō),這種網(wǎng)絡(luò)結(jié)構(gòu)使用了一個(gè)新穎的學(xué)習(xí)模塊,增加了模型對(duì)不重要空間變換的不變性,例如, 在物體識(shí)別過(guò)程中那些由不同視點(diǎn)引起的變換。該模型結(jié)構(gòu)由三個(gè)子模塊組成:一個(gè)定位模塊,一個(gè)網(wǎng)格生成模塊和一個(gè)采樣模塊,如下圖所示。

空間變換網(wǎng)絡(luò)結(jié)構(gòu)示意圖

卷積神經(jīng)網(wǎng)絡(luò)中的目標(biāo)定位問(wèn)題

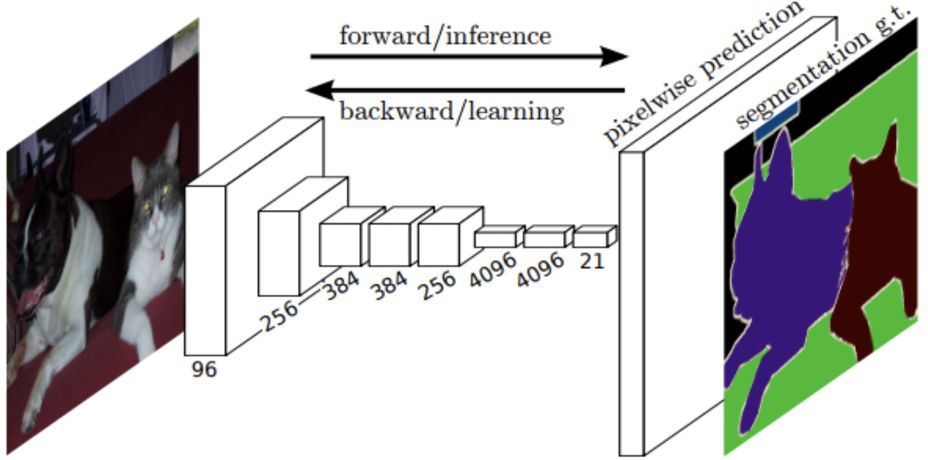

除了簡(jiǎn)單的目標(biāo)識(shí)別分類任務(wù),近年來(lái)卷積結(jié)構(gòu)在目標(biāo)精準(zhǔn)定位的任務(wù)中同樣表現(xiàn)出色,如目標(biāo)檢測(cè)、語(yǔ)義分割任務(wù)等。全卷積網(wǎng)絡(luò)(FCN)是其中最成功的卷積結(jié)構(gòu)之一,主要用于圖像語(yǔ)義分割。顧名思義,F(xiàn)CN 并未使用全連接層,而是將它們轉(zhuǎn)換為卷積層,其感受野范圍覆蓋整個(gè)卷積層的底層特征圖。更重要的是,網(wǎng)絡(luò)通過(guò)學(xué)習(xí)一個(gè)上采樣或者去卷積濾波器,可以恢復(fù)最后一層圖像的全分辨率,其結(jié)構(gòu)示意圖如下圖所示。

全卷積網(wǎng)絡(luò)結(jié)構(gòu)示意圖。經(jīng)過(guò)上采樣操作,在模型最后一層得到全分辨率的特征圖,適用 softmax 將每個(gè)像素分類,并生成最終的分割結(jié)果。

在 FCN 中,語(yǔ)義分割問(wèn)題被轉(zhuǎn)化成一個(gè)密集的逐像素分類問(wèn)題,通過(guò)投射來(lái)實(shí)現(xiàn)。換句話說(shuō),每個(gè)像素都與 softmax 層關(guān)聯(lián),通過(guò)像素逐類分組來(lái)實(shí)現(xiàn)圖像的語(yǔ)義分割。更值得注意的是,在這項(xiàng)工作中對(duì)較低結(jié)構(gòu)層的特征適用上采樣操作,起著至關(guān)重要作用。由于較低層特征更傾向于捕捉更精細(xì)化的細(xì)節(jié),因此上采樣操作允許模型進(jìn)行更精確的分割。此外,反卷積濾波器的一種替代方案是使用擴(kuò)張卷積,即上采樣稀疏濾波器,這有助于在保持參數(shù)數(shù)量的同時(shí),模型能夠?qū)W習(xí)到更高分辨率的特征圖。

R-CNN 是最早用于目標(biāo)檢測(cè)任務(wù)的卷積結(jié)構(gòu),這是一種帶區(qū)域建議的卷積神經(jīng)網(wǎng)絡(luò)(RPN),在最初的目標(biāo)檢測(cè)任務(wù)中取得了最先進(jìn)的檢測(cè)結(jié)果,特別是使用區(qū)域建議的選擇性搜索算法來(lái)檢測(cè)可能包含目標(biāo)的潛在區(qū)域,并將這些建議區(qū)域做一些變換以便匹配卷積結(jié)構(gòu)的輸入大小,經(jīng)卷積神經(jīng)網(wǎng)絡(luò)中特征提取后,最終送入 SVM 中進(jìn)行分類,并通過(guò)非極大值抑制后處理步驟中優(yōu)化模型的表現(xiàn)。

隨后,F(xiàn)ast R-CNN,Faster R-CNN,Mask R-CNN 等目標(biāo)檢測(cè)模型的提出都是基于最初的 R-CNN 結(jié)構(gòu)。可以說(shuō),卷積神經(jīng)網(wǎng)絡(luò)在目標(biāo)檢測(cè)方面的應(yīng)用是圍繞 R-CNN 結(jié)構(gòu)展開(kāi)。

▌時(shí)域卷積神經(jīng)網(wǎng)絡(luò)

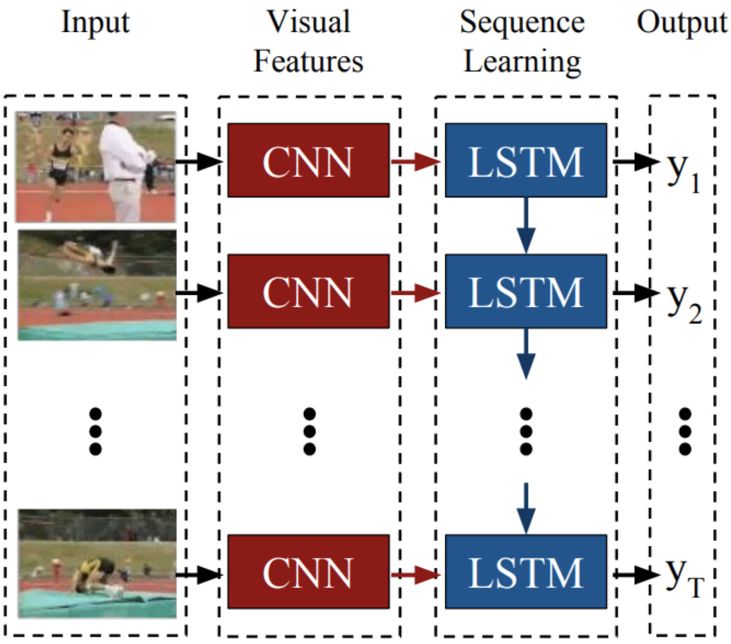

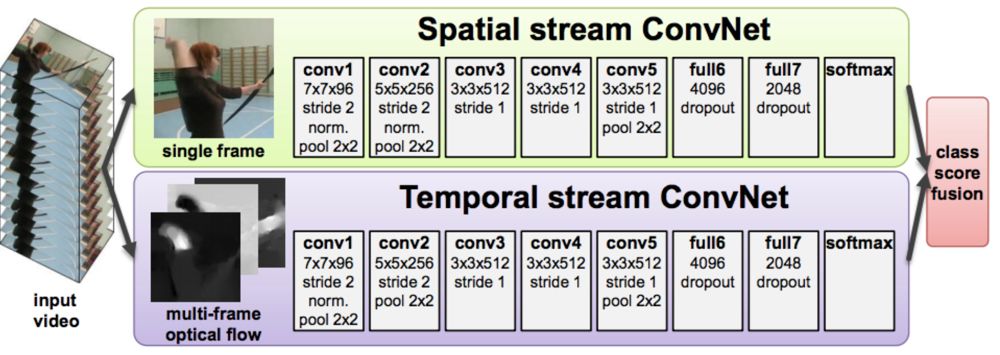

如上所述,卷積神經(jīng)網(wǎng)絡(luò)在計(jì)算機(jī)視覺(jué)二維空間的應(yīng)用中所取得的顯著性能,引發(fā)了人們對(duì) 3D 時(shí)空應(yīng)用的研究。許多文獻(xiàn)中提出的時(shí)域卷積結(jié)構(gòu)通常只是試圖從空間域(x,y)擴(kuò)展到時(shí)間域(x,y,t)的二維卷積結(jié)構(gòu)。而時(shí)域神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)有三種不同的形式:基于 LSTM 的時(shí)域卷積網(wǎng)絡(luò)、3D 卷積神經(jīng)網(wǎng)絡(luò)和雙流卷積神經(jīng)網(wǎng)絡(luò),其模型結(jié)構(gòu)示意圖如下圖。

基于 LSTM 的時(shí)域卷積神經(jīng)網(wǎng)絡(luò)。該模型中,由視頻流的每幀數(shù)據(jù)構(gòu)成模型的輸入。

雙流卷積神經(jīng)網(wǎng)絡(luò)。該模型以 RGB 光流數(shù)據(jù)作為輸入。

▌總結(jié)

相比于手動(dòng)設(shè)計(jì)的特征或淺層的特征表示,多層卷積結(jié)構(gòu)是當(dāng)前計(jì)算機(jī)視覺(jué)領(lǐng)域最先進(jìn)、最具吸引力的結(jié)構(gòu)之一。總體而言,大多數(shù)模型結(jié)構(gòu)都是基于四個(gè)共同的構(gòu)件塊,即卷積、非線性單元、歸一化和池化操作。雖然這些優(yōu)秀的卷積模型在大多數(shù)計(jì)算機(jī)視覺(jué)任務(wù)中取得了最優(yōu)性能,但它們共同的缺點(diǎn)仍然是對(duì)卷積內(nèi)部操作、特征表征的理解相當(dāng)有限,依賴于大規(guī)模的數(shù)據(jù)集和模型訓(xùn)練過(guò)程,缺乏精確的性能界限和超參數(shù)選擇的清晰度。這些超參數(shù)包括濾波器的大小、非線性函數(shù)、池化操作參數(shù)以及模型層數(shù)的選擇。接下來(lái)我們將進(jìn)一步討論卷積神經(jīng)網(wǎng)絡(luò)設(shè)計(jì)過(guò)程中這些超參數(shù)的選擇。

第三章

理解卷積神經(jīng)網(wǎng)絡(luò)的構(gòu)建模塊

考慮到卷積神經(jīng)網(wǎng)絡(luò)領(lǐng)域還存在大量未解決的問(wèn)題,在本章我們將探討一些典型案例中卷積網(wǎng)絡(luò)的每一層處理操作的作用及意義,尤其我們將從理論和生物學(xué)角度給出合理解釋。

▌卷積層

卷積神經(jīng)網(wǎng)絡(luò)的核心層是卷積層,這是模型最重要的一步。總的來(lái)說(shuō),卷積是一種線性的、具有平移不變性的運(yùn)算,它是通過(guò)局部加權(quán)輸入信號(hào)來(lái)實(shí)現(xiàn)的。權(quán)重集合是根據(jù)點(diǎn)擴(kuò)散函數(shù)(point spread function)來(lái)確定的,不同的權(quán)重函數(shù)能夠反映出輸入信號(hào)的不同性質(zhì)。

在頻率域中,與點(diǎn)擴(kuò)散函數(shù)相關(guān)聯(lián)的是調(diào)制函數(shù),這表明了輸入的頻率組分可以通過(guò)縮放和相移來(lái)進(jìn)行調(diào)制。因此,選擇合適的卷積核,將有助于模型獲取輸入信號(hào)中最顯著、最重要的特征信息。

▌非線性單元

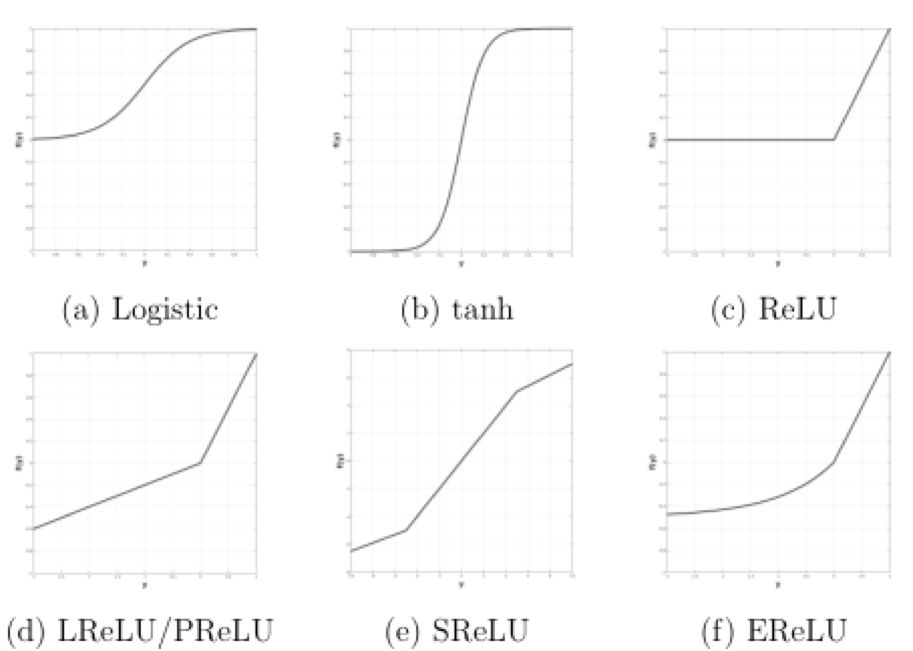

多層神經(jīng)網(wǎng)絡(luò)通常是高度的非線性模型,而修正單元(rectification)通常將引入一個(gè)非線性函數(shù)(也被稱為激活函數(shù)),即將非線性函數(shù)應(yīng)用到卷積層輸出中。引入修正單元的目的,一方面是為了最好的、最合適的模型解釋;另一方面是為了讓模型能更快和更好地學(xué)習(xí)。常用的非線性函數(shù)主要包括 Logistic 函數(shù)、tanh 函數(shù)、Sigmoid 函數(shù)、ReLU 及其變體 LReLU,SReLU,EReLU 等,其函數(shù)圖像如下圖所示。

多層網(wǎng)絡(luò)結(jié)構(gòu)中的非線性激活函數(shù)

▌歸一化

如上所述,由于這些多層網(wǎng)絡(luò)中存在級(jí)聯(lián)的非線性運(yùn)算,因此多層神經(jīng)網(wǎng)絡(luò)都是高度的非線性模型。除了上面討論的修正非線性單元外,歸一化(normalization)同樣是卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)中重要的非線性處理模塊。最廣泛使用的歸一化形式即所謂的局部響應(yīng)歸一化操作(LRN,Local Response Normalization)。此外,還有諸如批歸一化(batch normalization),分裂歸一化(divisive normalization)等。

▌池化操作

幾乎所有的卷積神經(jīng)網(wǎng)絡(luò),都包含池化操作。池化操作是為了提取特征在不同位置和規(guī)模上的變化,同時(shí)聚合不同特征映射的響應(yīng)。正如卷積結(jié)構(gòu)中前三個(gè)組份,池化操作也是受到生物學(xué)啟發(fā)和理論支持而提出的。 平均池化和最大池化是兩個(gè)最廣泛使用的池化操作,其池化效果依次如下圖所示。

經(jīng)平均池化操作后Gabor特征的變化情況

經(jīng)最大池化操作后Gabor特征的變化情況

第四章

當(dāng)前研究狀態(tài)

對(duì)卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)中各組作用的闡述凸顯了卷積模塊的重要性,這個(gè)模塊主要用于捕獲最抽象的特征信息。相對(duì)而言,我們對(duì)卷積模塊操作的理解卻很模糊,對(duì)其中繁瑣的計(jì)算過(guò)程的理解并不透徹。本章我們將嘗試?yán)斫饩矸e網(wǎng)絡(luò)中不同層所學(xué)習(xí)的內(nèi)容及不同的可視化方法。同時(shí),我們還將重點(diǎn)展望這些方面仍待解決的問(wèn)題。

▌當(dāng)前趨勢(shì)

盡管各種優(yōu)秀的卷積模型在多種計(jì)算機(jī)視覺(jué)應(yīng)用中取得了最優(yōu)表現(xiàn),但在理解這些模型結(jié)構(gòu)的工作方式及探索這些結(jié)構(gòu)的有效性方面的研究進(jìn)展仍相當(dāng)緩慢。如今,這個(gè)問(wèn)題已經(jīng)引起了眾多研究者的興趣,為此很多研究提出用于理解卷積結(jié)構(gòu)的方法。

總的來(lái)說(shuō),這些方法可以分成三個(gè)方向:對(duì)所學(xué)習(xí)到的過(guò)濾器和提取的特征圖進(jìn)行可視化分析、受生物視覺(jué)皮層理解方法所啟發(fā)的消融學(xué)習(xí)(ablation study)、以及通過(guò)引入主成分分析法設(shè)計(jì)并分析網(wǎng)絡(luò)最小化學(xué)習(xí)過(guò)程,我們將簡(jiǎn)要概述這三種方法。

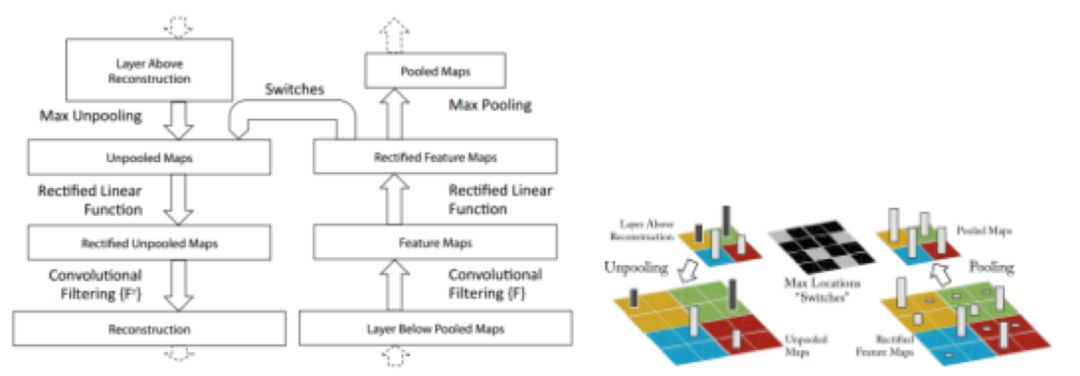

卷積的可視化分析

卷積可視化的第一種方法是以數(shù)據(jù)集為中心的方法,因?yàn)榫矸e操作依靠從數(shù)據(jù)集輸入來(lái)探測(cè)網(wǎng)絡(luò)在網(wǎng)絡(luò)中找到最大響應(yīng)單元。這種方法的第一個(gè)應(yīng)用是反卷積(DeConvNet)。其中可視化是分兩步實(shí)現(xiàn):首先,一個(gè)卷積結(jié)構(gòu)接收來(lái)自數(shù)據(jù)集 a 的幾個(gè)圖像并記錄數(shù)據(jù)集中輸入的特征映射最大響應(yīng);其次,這些特征地圖使用反卷積結(jié)構(gòu),通過(guò)反轉(zhuǎn)卷積操作模塊,將卷積操作中學(xué)習(xí)到的濾波器特征進(jìn)行轉(zhuǎn)置來(lái)執(zhí)行“解卷積”操作,從而實(shí)現(xiàn)卷積的可視化分析。反卷積操作的示意圖如下圖所示:

反卷積構(gòu)建模塊

卷積可視化的第二種方法稱為以網(wǎng)絡(luò)為中心的方法,因?yàn)樗鼉H使用網(wǎng)絡(luò)參數(shù)而不需要任何用于可視化的數(shù)據(jù)。這種方法首次應(yīng)用于深層置信網(wǎng)絡(luò)的可視化分析中,后來(lái)才應(yīng)用于卷積網(wǎng)絡(luò)結(jié)構(gòu)中。具體地說(shuō),這種卷積可視化是通過(guò)合成圖像來(lái)實(shí)現(xiàn)的,該圖像將最大化某些神經(jīng)元(或過(guò)濾器)的響應(yīng)。

卷積的消融學(xué)習(xí)

另一種流行的可視化方法是使用所謂的網(wǎng)絡(luò)消融研究。實(shí)際上,許多著名的卷積結(jié)構(gòu)都包括模型消融研究實(shí)驗(yàn)部分,其目的是隔離卷積結(jié)構(gòu)的不同部分組成網(wǎng)絡(luò),來(lái)查看刪除或添加某些模塊如何模擬整體的性能。消融研究能夠指導(dǎo)研究者設(shè)計(jì)出性能更優(yōu)的網(wǎng)絡(luò)結(jié)構(gòu)。

卷積結(jié)構(gòu)的控制設(shè)計(jì)

理解卷積結(jié)構(gòu)的另一種方法是在網(wǎng)絡(luò)設(shè)計(jì)時(shí)添加先驗(yàn)知識(shí),從而最大限度地減少所需學(xué)習(xí)的模型參數(shù)。例如,一些方法是減少每層卷積層所需學(xué)習(xí)的過(guò)濾器數(shù)量,并用轉(zhuǎn)換后的版本在每一層中學(xué)習(xí)的濾波器來(lái)模擬旋轉(zhuǎn)不變性。 其他方法依賴于用基礎(chǔ)集合代替過(guò)濾器的學(xué)習(xí)過(guò)程,而不是學(xué)習(xí)過(guò)濾器參數(shù),它們的目標(biāo)是學(xué)習(xí)如何組合基礎(chǔ)集合,以便在每一層形成有效的過(guò)濾器。此外,還有一些方法,是通過(guò)完全手工設(shè)計(jì)卷積網(wǎng)絡(luò),并針對(duì)特定的任務(wù)在網(wǎng)絡(luò)設(shè)計(jì)階段加入特定的先驗(yàn)知識(shí),如此設(shè)計(jì)出可解釋的網(wǎng)絡(luò)。

▌待解決問(wèn)題

通過(guò)上述內(nèi)容,我們總結(jié)了卷積模型一些關(guān)鍵技術(shù)以及如何更好地理解卷積結(jié)構(gòu)的方法。下面,我們將進(jìn)一步討論在卷積模型領(lǐng)域仍待解決的一些問(wèn)題。

基于卷積可視化的研究方法仍待解決的幾個(gè)關(guān)鍵問(wèn)題:

首先,開(kāi)發(fā)更加客觀的可視化評(píng)價(jià)方法是非常重要的,可以通過(guò)引入評(píng)價(jià)指標(biāo)來(lái)評(píng)估所生成的可視化圖像質(zhì)量或含義來(lái)實(shí)現(xiàn)。

此外,盡管看起來(lái)以網(wǎng)絡(luò)為中心的卷積可視化方法更有前景(因?yàn)樗鼈冊(cè)谏煽梢暬Y(jié)果過(guò)程中不依賴模型結(jié)構(gòu)自身),但也缺乏一套標(biāo)準(zhǔn)化的評(píng)估流程。一種可能的解決方案是使用一個(gè)評(píng)估基準(zhǔn)來(lái)評(píng)價(jià)同樣條件下生成的網(wǎng)絡(luò)可視化結(jié)果。這樣的標(biāo)準(zhǔn)化方法反過(guò)來(lái)也能實(shí)現(xiàn)基于指標(biāo)的評(píng)估方法,而不是當(dāng)前的解釋性分析。

另一個(gè)可視化分析的發(fā)展方向是同時(shí)可視化網(wǎng)絡(luò)的多個(gè)單元,以更好地理解模型中特征表征的分布情況,甚至還能遵循一種控制方法。

基于 ablation study 的研究方法仍待解決的幾個(gè)關(guān)鍵問(wèn)題:

使用共同的、系統(tǒng)性組織的數(shù)據(jù)集。我們不僅要解決計(jì)算機(jī)視覺(jué)領(lǐng)域常見(jiàn)的不同挑戰(zhàn)(比如視角和光照變化),還必須要應(yīng)對(duì)復(fù)雜度更大的類別問(wèn)題(如圖像紋理、部件和目標(biāo)復(fù)雜度等)。近年來(lái),已經(jīng)出現(xiàn)了一些這樣的數(shù)據(jù)集。在這樣的數(shù)據(jù)集上,使用 ablation study,輔以混淆矩陣分析,可以確定卷積結(jié)構(gòu)中出錯(cuò)的模塊,以便實(shí)現(xiàn)更好的理解卷積。

此外,分析多個(gè)協(xié)同的 ablation 對(duì)模型表現(xiàn)的影響方式,是一個(gè)很受關(guān)注的研究方向。這樣的研究也能有助于我們理解獨(dú)立單元的工作方式。

相比于完全基于學(xué)習(xí)的方法,還有一些受控方法能讓我們對(duì)這些結(jié)構(gòu)的運(yùn)算和表征有更深入的理解,因而具有很大的研究前景。這些有趣的研究方向包括:

逐層固定網(wǎng)絡(luò)參數(shù)及分析對(duì)網(wǎng)絡(luò)行為的影響。例如,基于當(dāng)前特定任務(wù)的先驗(yàn)知識(shí),一次固定一層的卷積核參數(shù),以分析每一卷積層中卷積核的適用性。這個(gè)逐層漸進(jìn)式的學(xué)習(xí)方式有助于揭示卷積學(xué)習(xí)的作用,還可用作最小化訓(xùn)練時(shí)間的初始化方法。

類似地,可以通過(guò)分析輸入的特征來(lái)研究網(wǎng)絡(luò)結(jié)構(gòu)的設(shè)計(jì)(如層的數(shù)量或每層中過(guò)濾器數(shù)量的選擇方案),這種方法有助于設(shè)計(jì)出最適合模型結(jié)構(gòu)。

最后,將受控方法應(yīng)用于網(wǎng)絡(luò)的同時(shí),可以對(duì)卷積神經(jīng)網(wǎng)絡(luò)的其它方面的作用進(jìn)行系統(tǒng)性的研究。通常,我們重點(diǎn)關(guān)注的是模型所學(xué)習(xí)的參數(shù),所以對(duì)這方面得到的關(guān)注較少。例如,我們可以在固定大多數(shù)參數(shù)的情況下,研究各種池化策略和殘差連接的作用。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4811瀏覽量

103025 -

AI

+關(guān)注

關(guān)注

88文章

34578瀏覽量

276126 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5557瀏覽量

122576

原文標(biāo)題:深度概覽卷積神經(jīng)網(wǎng)絡(luò)全景圖,沒(méi)有比這更全的了

文章出處:【微信號(hào):AI_Thinker,微信公眾號(hào):人工智能頭條】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

我們?cè)撊绾卫斫饩矸e神經(jīng)網(wǎng)絡(luò)?

我們?cè)撊绾卫斫饩矸e神經(jīng)網(wǎng)絡(luò)?

評(píng)論