編者按:說到GAN在人臉上的應用,就不得不提起去年高麗大學、Clova AI Research、新澤西大學和香港科技大學共同發表的一項成果:一個可以在多域圖像間實現圖對圖轉換的統一生成對抗網絡——StarGAN。它不僅能調整圖像中的發色、肌理、膚色、性別,還能合成各種生動有趣的表情。而就在上周,美國的一群研究人員基于解剖學上的肌肉運動方式,提出了一種轉換表情的新方法。

近年來,生成對抗網絡(GAN)已經在面部表情合成任務中取得了令人印象深刻的結果,這為包括電影工業、攝影、時尚和電子商務在內的商業領域打開了一扇新大門:如果GAN真的能實現表情的自然轉換,企業、制片方不僅能進一步壓縮成本,還能加快產品的產出效率。

在這個背景下,去年提出的StarGAN無疑是目前最成功的架構,它只用一對生成器和判別器就能實現多個域之間的映射,且能對各個域的圖像進行有效訓練。雖然論文較以往成果有巨大進步,也顯示出了通用性,但它只是把以前的2個域擴展到現在的k個域,模型轉換效果還是受數據集注釋局限。

為了解決這個問題,近日,西班牙IRI和美國俄亥俄州立大學的研究人員提出了一種基于動作單元(AU)的新型GAN,它在連續流形中描述了解剖學意義上的人類面部表情。經過無監督訓練后,只需控制每個AU的激活程度,并選取其中幾個進行組合,模型就能實現生動形象的表情轉換。

模型架構和方法

首先,我們來看這個GAN的具體構造。

對于任意表情,模型把輸入的RGB圖像定義為Iyr∈RH×W×3。通過把復雜表情解構成一個個動作單元(AU),我們可以用一組N個AU yr= (y1, . . . , yN)T對每個表情編碼,其中yn已經經過歸一化處理,取值在0到1之間。有了這種連續表征,我們就可以在不同表征之間進行自然插值,從而渲染各種逼真、平滑的面部表情。

簡而言之,我們的目標是學習一個映射M,它能把輸入圖像Iyr轉換成基于目標AU yg的輸出圖像Iyg。

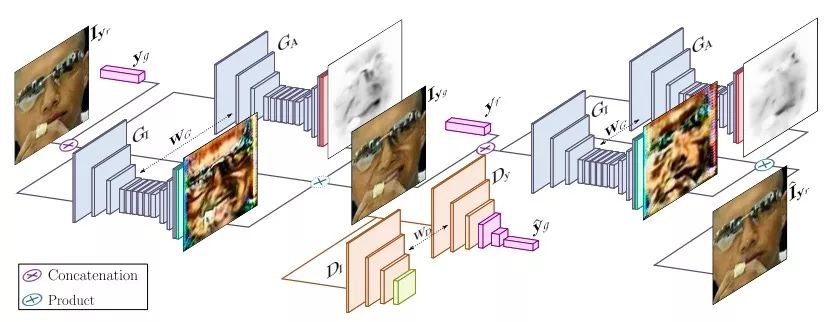

上圖是GANimation的整體架構,可以發現,它主要由兩部分組成:一個生成器G,一個判別器D。其中生成器負責回歸注意力(GI)和生成色彩掩模(GA),判別器負責鑒別生成圖像逼真與否(DI),并檢查表情是否連貫(y?g)。

既然重點是AU,那么模型的一個關鍵自然是專注于圖像中那些負責合成新表情的區域,換言之,我們需要弱化頭發、眼鏡、帽子或珠寶等其他元素對模型的干擾。為了實現這一點,如上圖所示,研究人員在生成器中引入注意力機制,把輸入圖像分成注意力掩模A和RGB掩模C,完成表情轉換后再合并渲染。

什么是AU

關于什么是AU,文中并沒有仔細說明,所以這里我們來看它重點引用的另一篇論文。

這篇名為Compound facial expressions of emotion的論文來自俄亥俄州立大學哥倫布分校,它和GANimation有一個共同的作者:Aleix M. Martinez。根據他們的研究,人類的不同面部表情可能存在一定相關性,比如當一個人感到驚喜時,他的面部肌肉群運動其實結合了愉悅、驚訝兩種基礎情緒的肌肉運動方式。

基于這個發現,他們提出了一種名為復合情感類別的重要表達式。通過采集230名人類受試者的面部表情樣本圖像,并進行觀察實驗,最終他們定義了21種不同表情類別,其中的差異可以被計算機用來區分不同人類情感。

數據庫中的22種常見表情

用線條進行肌肉運動分析

六種復合面部表情的AU組成

很可惜,仔細瀏覽了論文好幾次,我還是沒能從中找出AU對照表。下表是目前已知的幾項內容:

不過不知道也沒關系,這個GAN已經公開了自己的pytorch實現:github.com/albertpumarola/GANimation。如果有讀者希望獲得完整表格,建議直接聯系作者,或者依照俄亥俄州立大學論文中的方法自己總結,里面詳盡列出了數據來源、具體方法和操作細節。

實驗

最后是實驗對比,我們先來看看GANimation和DIAT、CycleGAN、IcGAN、StarGAN這些模型的性能區別。

如下圖所示,前三種模型都出現了不同程度的扭曲和畸變,表現較差;而StarGAN雖然保留了更多人臉細節,生成表情也更自然,但犧牲了清晰度,輸出圖像比較模糊。相比之下,GANimation雖然在臉型上出現了一點小瑕疵,但它的綜合表現是最好的。

下圖是GANimation的一些成功和失敗的例子。其中前兩個例子(頂行)對應于類似人的雕塑和非現實主義風格繪畫。在這兩種情況下,生成器都能保持原始圖像的藝術效果,并且忽略諸如眼鏡遮擋之類的偽像。

第三行的示例顯示了模型對于面部非均勻紋理的穩健性。可以看到,把微笑轉換成不滿后,女郎鼻翼兩側出現了下陷的法令紋,但模型并沒有試圖通過添加/去除頭發來使紋理均勻化。

底部是一些失敗案例。研究人員歸納了失敗原因,認為這些很可能都是因為訓練數據不足引起的。如紅臉男子圖所示,當模型輸入極端表情時,RGB掩模沒有及時調整權重,導致嘴部出現透明化。此外,如果輸入圖像的主體不是人類,那模型的表現也會很差。

小結

傳統的方法,比如Face2Face,需要極度依賴3D面部重建模型,適用面非常小,也難以擴展到任意身份。相反地,這篇論文以解剖學意義上的肌肉運動為條件,在處理極端輸入時更穩健,效果更好。總而言之,這是篇不錯的論文,而且提出了全然不同的轉換方法,它的思路值得學習借鑒。

-

GaN

+關注

關注

19文章

2186瀏覽量

76334 -

生成器

+關注

關注

7文章

322瀏覽量

21747

原文標題:GANimation:基于解剖結構的面部表情轉換(附GitHub地址)

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

一種無刷直流電機霍耳信號與定子繞組關系自學習方法

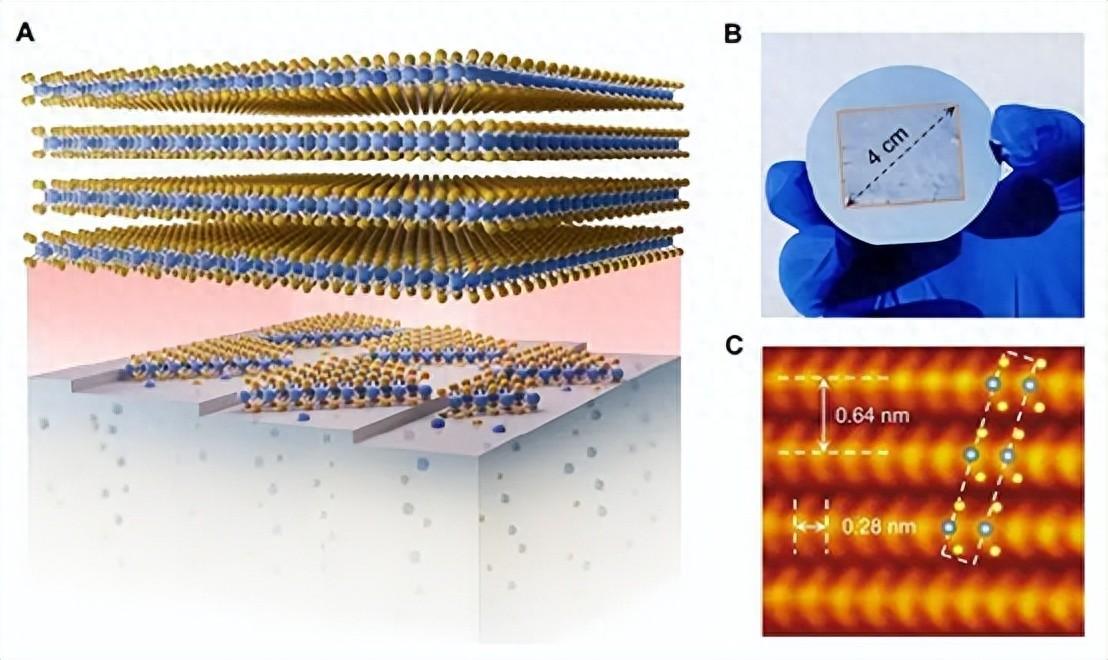

石墨烯制備的新方法

大華股份榮獲中國創新方法大賽一等獎

一種實現亞毫秒定時分辨率的RTOS新方法

基于遺傳算法的QD-SOA設計新方法

一種降低VIO/VSLAM系統漂移的新方法

大華股份榮獲2024年中國創新方法大賽一等獎

利用全息技術在硅晶圓內部制造納米結構的新方法

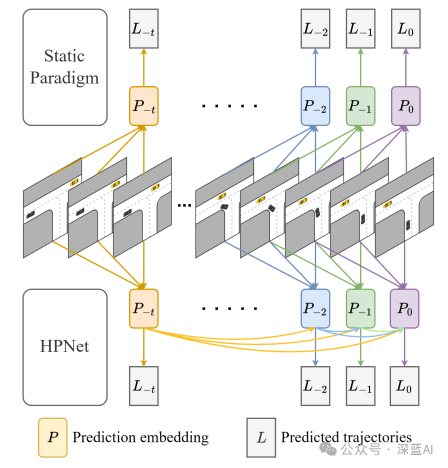

一種創新的動態軌跡預測方法

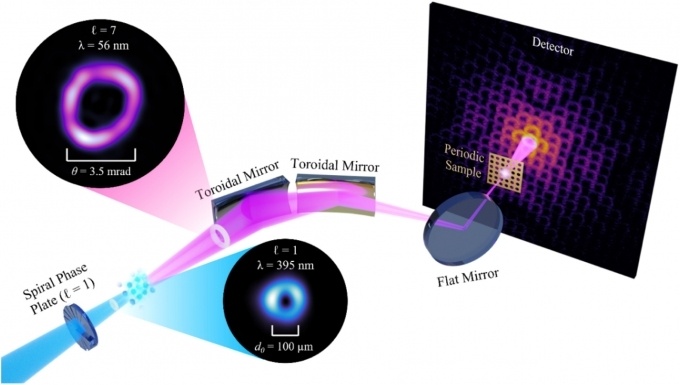

上海光機所提出強激光產生高能量子渦旋態電子新方法

一種無透鏡成像的新方法

從“蓋房子”到“頂竹筍”:我國科學家首創晶體制備新方法

基于解剖學上的肌肉運動方式,提出了一種轉換表情的新方法

基于解剖學上的肌肉運動方式,提出了一種轉換表情的新方法

評論