NIH臨床中心最新公布了一個迄今規模最大的多類別、病灶級別標注臨床醫療CT圖像開放數據集DeepLesion,研究人員在此基礎上訓練深度神經網絡,創建了一個具有統一框架的大規模通用病灶檢測器,能夠更準確、更自動地衡量患者體內所有病灶的大小,實現全身范圍的癌癥初步評估。

4427名獨立的匿名患者

10594次CT掃描(平均每位患者有3次隨訪)

32735個帶標記的病灶實例

一共928020張CT橫切圖像(512×512分辨率)

這就是美國國家衛生研究院(NIH)臨床中心最新公開發布的大型CT圖像數據集DeepLesion,也是迄今全球規模最大的多類別、病灶級別標注的開放獲取臨床醫療圖像數據集。

“我們希望這項工作能更好地幫助放射科醫生進行診斷,解決真正有意義的臨床問題。”DeepLesion項目技術負責人、現在已經離開NIH、出任平安科技美國東部研究院院長的呂樂博士在接受新智元采訪時說:“這件工作首先離不開我們在NIH的臨床醫生合作者羅納德·撒莫斯(Ronald M. Summers),他是醫生里面對技術理解特別深刻的,為獲取這個臨床的大規模醫療數據集提供了極大的幫助和指導。”

“基于DeepLesion數據集,我們開發了一種通用的病變檢測器,第一次為幫助放射科醫生找到患者身上所有類型的病灶提供了技術可能。”DeepLesion項目的主要完成人,NIH臨床中心的博士后研究員閆軻介紹說。

目前,大多數公開可用的醫學圖像數據集,都只含有圖像級別的分類標簽,而有病灶級別標注的數據集,數量往往不足1000,而且大都針對單一類型的病灶,因此訓練出的模型只能檢測一種病灶。而實際病灶的種類非常之多,這種方式就顯得有些低效。

2017年,同樣由呂樂和羅納德·撒莫斯博士率領的另一個NIH臨床中心研究團隊,發布了一個含有超過10萬匿名胸部X光片的標注圖像數據集,大幅推進了相關醫療AI研發,為醫生提供了更好的臨床診斷決策輔助。

這一次,呂樂、羅納德·撒莫斯和他們在NIH的同事,朝著一個更加宏大的目標進發——構建一個囊括各種不同病灶的標注數據集,并在此基礎上設計一個能夠檢測多種病灶的深度學習模型,從而更準確、自動地衡量患者體內所有病灶的大小,實現全身范圍的癌癥評估。

基于DeepLesion構建的通用病灶檢測流程圖。來源:[1]

醫生手工標注CT圖像,不適合用于訓練AI

“美國的臨床醫療數據庫里,積累了醫生在臨床實踐中留下的成千上萬個病人的標注數據,”呂樂博士說:“但是,這些標注往往不完整,是醫生為了輔助他們自己的工作進行的,不適合用于訓練AI系統。”

而為了訓練AI系統,請醫生專門對大量的醫療圖像進行標注又是不現實的,因為這需要耗費大量的人力和時間成本。因此,這件事情只有靠計算機設計深度學習算法來完成。

而要設計深度學習算法,關鍵就是帶有準確標記的醫療圖像大數據。去除隱私后的公共醫療大數據本就不多,而且不同于其他類型的數據標注,醫療圖像標注需要豐富的臨床經驗,即使是資深醫生,有時候也會在某個標注上產生意見分歧。

其結果就是,真正可用的標注醫療圖像數據集稀缺,盡管各種醫院診所里積累了大量的醫療圖像數據。

要設計深度學習算法解決臨床問題,“需要對技術和臨床實踐兩方面都擁有深刻的理解,”呂樂博士說:“AI 不是把放射科里面的東西再重新做一遍。哪些需求是臨床上迫切需要的,哪些需求是當前技術能夠滿足的,將放射科學、計算機科學和人工智能結合在一起時,有很多需要深度考量和仔細權衡的東西,蠻干是不行的。”

為了構建DeepLesion數據集,研究人員傾注了一年多的時間,期間在國際醫學圖像計算與計算機輔助干預大會(MICCAI)、北美放射學年會(RSNA)等醫學和放射影像國際頂會以及CVPR上,先后發表了12篇研究論文。

他們將工作成果匯聚為《DeepLesion: automated mining of large-scale lesion annotations anduniversal lesion detection with deep learning》,刊發在《Journalof Medical Imaging》。

現在,任何人都能訪問并使用NIH的DeepLesion數據集(鏈接見文末),醫生能夠更好地進行自動臨床病灶測量或者檢索相似病例,AI研究人員則能進一步完善和推動AI診療技術和產品的研發。

接下來,NIH臨床中心希望通過收集更多數據,不斷完善DeepLesion,提高其檢測的準確性。研究人員還考慮將現在僅含CT圖像的DeepLesion進一步擴展,比如納入MRI圖像,并與其他醫院的數據相結合,構建更加豐富的臨床醫療圖像庫。

DeepLesion:迄今最大的多類別、病灶級標注臨床醫療圖像開源數據集

在NIH臨床中心,每當有患者做完CT掃描后,相應的掃描圖像都會被送至放射科醫生處,然后醫生會對圖像進行解讀。

接著,放射科醫生會使用一種類似電子書簽的工具,測量并標記CT掃描中具有臨床意義的發現。與普通的實體書簽類似,放射科醫生會保存書簽的位置,并將重要發現加上標記,以便以后能再次查閱。

這些書簽的內容和形式很復雜,包括箭頭、線條、長短徑和文字說明等,用于標記病灶的確切位置和大小,以便專家識別病情發展或發現新的疾病。

在計算機視覺領域,為了收集圖像標簽,研究者會采用眾包或搜索引擎抓取,但這并不適用于醫學圖像,因為醫學圖像的標注需要大量的醫學知識和臨床經驗。

在開發DeepLesion數據集時,研究人員決定使用NIH臨床PACS數據庫中的“RECIST diameters”(Response Evaluation Criteria In Solid Tumors)長短徑標注,這種標注是醫生用來測量病灶大小的,被測量的一般都是醫生認為比較重要的病灶,能夠提供最精確的信息,從而確保數據的有效性。此外,這種類型的標注也是NIH數據庫中所有標注類型中占比最高的一種。

藍線代表醫生在日常工作中對病灶進行的長短徑標注。來源: [1]

決定了要使用的標注類型后,DeepLesion項目的命名人、NIH臨床中心的王潚崧博士與NIH PACS技術管理人員協商,確定了下載方案。隨后團隊編寫程序,把含有長短徑標注的圖像、圖像屬性和標注從原始數據中提取出來,再按照病人編號、CT掃描編號(study index)、序列號(series number)和橫斷層編號(slice number)等進行整理。

在實際場景中,每個病人會進行多次CT掃描(每次掃描的時間點不同),每次掃描會生成多個序列(每個序列的造影劑增強、掃描重建參數等不同),而每個序列都是由幾十到上百個橫斷層圖像組成的3D影像。

數據清理和脫敏是一項浩大的工程。由于下載的電子書簽中含有個別錯誤,研究人員設計了一些規則,清除掉這些錯誤,噪聲、slice interval 信息的計算等,也都進行了手工糾正。

十字交叉的紅線代表醫生日常標注的長短徑標注,綠框代表根據長短徑計算出的邊界框,黃點代表邊界框的中心,兩條相互垂直的藍線表示病灶的 x 軸和 y 軸,z 軸根據SSBR[3]算出。來源:[3]

對于圖像里可能含有的隱私信息,他們先用算法檢測圖像里的文字,然后人力檢查了圖像里是否有特別的首飾或者明顯的人臉,最后手工抹除相關部分。

“CT圖像的動態范圍較大,因此我們采用16比特無損壓縮png格式來保存所有圖像。這些圖像的使用方法可以參考數據集的FAQ文件,也可以參考論文[5]的源代碼。”

“在開始這個項目之前,沒想到構建數據庫有這么復雜,”DeepLesion論文的第一作者、NIH臨床中心的博士后研究員閆軻告訴新智元:“不過想到能給其他研究者帶來好處,我們就有了持續前行的動力。”

構建通用疾病檢測模型,推進精準個性化醫療

最終整理好的DeepLesion數據集,含有32735個帶標記的病灶實例,包括來自全身各個部位的關鍵影像學發現,比如肺結節、肝腫瘤、淋巴結腫大等。

DeepLesion數據集中一個子集(15%)的可視化結果,包含骨骼、肝臟、肺部、腹部、軟組織等全身各個部位的數據。散點圖是按照病灶在身體中的相對位置繪制的,可以看做一個人體的正面照。來源:[1]

在實驗過程中,研究人員意識到,雖然不同病灶的外觀差異較大,但目前的深度學習算法完全有能力同時檢測出各種病灶,從而提供了一個很有希望的新方向——創建一個具有統一框架的大規模通用病灶檢測器。

這個通用檢測器可以作為一種初步的檢測工具來使用,如有需要再將其檢測結果發送給在某些特定類型的病灶上訓練過的其他專用檢測模型。

閆軻說:“我們的數據集里包含了各種病灶,訓練得到的是一個通用的檢測器,雖然在特定種類的病灶上精度可能比不過專用的檢測器,但優點在于覆蓋了各種病灶,可以用來對病人的掃描影像進行一次性的初篩,降低漏檢。”

黃色和橙色框是ground-truth,綠色框是算法正確檢測到的病灶,紅色框是誤檢。算法可以較好地檢測出各種病灶,但仍有一些漏檢和誤檢。來源:論文[5]

通用病灶檢測的難度遠高于特定病灶檢測,DeepLesion中包含肺、肝、腎、淋巴、胰腺、骨骼、軟組織等各種病灶,病灶類內差異大,類間差異小(肺、肝的病灶相對容易檢測一些,而一些腹腔中的病灶與周圍正常組織差異較小)。繼續收集數據,可以進一步提高準確率。另外,算法的改進空間也還有很大。

為了改進病灶檢測的精度,NIH研究人員在MICCAI 2018上發表論文《3D Context Enhanced Region-based Convolutional Neural Network for End-to-End Lesion Detection》[5],提出了一種利用3D信息的檢測算法,將病灶識別準確率提高到了84.37%(4 false positives per image)。算法代碼見[5]。

大規模的臨床醫療數據庫,是AI在臨床真正落地的唯一路徑

除了自動檢測病灶,DeepLesion還可以用于一些其他問題,比如對數據集中每個病灶進行測量。“病灶的測量是放射科醫生的主要任務之一,”閆軻表示:“DeepLesion可以用于設計訓練一個自動測量病灶的算法,減輕醫生的負擔,同時降低不同醫生帶來的個體差異。”

此外,這個數據集還可以用于進行病灶的分割、分類研究。NIH臨床中心的蔡進錚博士和唐有寶博士利用DeepLesion,提出了弱監督病灶分割算法,相關論文《AccurateWeakly-Supervised Deep Lesion Segmentation using Large-Scale Clinical Annotations: Slice-Propagated 3D Mask Generation from 2D RECIST》發表在了今年的醫學影像頂會MICCAI 2018。蔡進錚和唐有寶的工作還把所有的二維直徑測量,用弱標注的深度學習算法,變成了高質量的腫瘤三維體積測量。

基于DeepLesion,提出的弱監督病灶分割算法得到北美放射科醫生廣泛好評。來源:Twitter

這項工作在北美放射科專科醫生領域里引發了強烈反響,并收到了非常高的正面評價!主要原因是目前為止基于放射科醫生人工標注的、在腫瘤圖像最大橫截面上的二維直徑測量,也即前文提到的RECIST,是記算并比較腫瘤大小的現行臨床標準。在實際工作中會造成很大的不決定性。基于絕對三維體積的腫瘤大小測量是公認的黃金標準,但因為制作費事費時,在臨床中并沒有被廣泛應用。

這項工作基于DeepLesion數據庫,提出了基于弱監督的深度學習腫瘤圖像分割算法,從臨床大數據中的直接利用原有的RECIST標注,無需任何額外的人工標注,即可學習和恢復三維的腫瘤分割和體積測量,并取得了好的定量和定性結果。擴展的期刊版本正在準備投稿《Radiology》。

“醫療AI技術的發展就是要讓醫生用起來有價值,真心愛用,”呂樂博士說:“Augmented intelligence for adding clinical value!”

把所有的二維直徑測量變成高質量的腫瘤三維體積測量

DeepLesion里大部分病人都有多次CT掃描的數據,而每次掃描又有多個不同病灶的標注,這為研究不同病灶之間的關系,以及同一病灶隨時間的變化提供了可能。

“總之,這是一個給人很大想象和發揮空間的數據集。”閆軻說。

大規模的臨床數據庫是AI在臨床真正落地的唯一路徑;但標注幾乎永遠不可能是完美的,這就對新的更魯棒的深度學習算法提出了更多以及更高的要求。

DeepLesion的獲取方式也決定了它存在著一定的局限性。例如,醫生在工作中通常只會標注有代表性的病灶,因此,數據集中存在著一些沒有標出來的病灶。“我們也鼓勵有余力的醫生能夠在DeepLesion上繼續補全病灶標注,以造福廣大研究者。”

-

神經網絡

+關注

關注

42文章

4811瀏覽量

103019 -

數據集

+關注

關注

4文章

1223瀏覽量

25317 -

深度學習

+關注

關注

73文章

5557瀏覽量

122576

原文標題:NIH開源迄今最大臨床醫療圖像數據集,用深度學習構建通用疾病檢測模型!

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

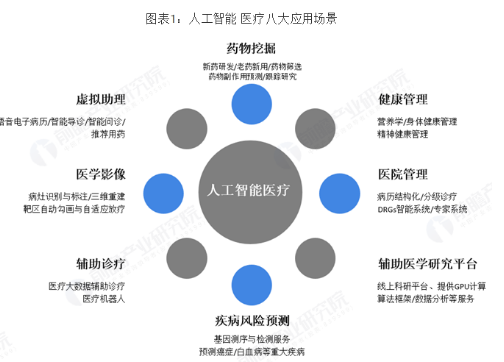

智能醫療市場發展的規模及趨勢

計算機視覺/深度學習領域常用數據集匯總

清洗誤標注的開發集和測試集樣本

一個benchmark實現大規模數據集上的OOD檢測

基于卷積神經網絡的圖像標注模型

多顯著對象圖像標注方法

基于形式概念分析的圖像場景語義標注模型

基于隱馬爾科夫模型和卷積神經網絡的圖像標注方法

醫學影像是AI醫療最熱門應用場景之一 病灶區識別與標注領域企業最多

全球規模最大的多類別、病灶級別標注的開放獲取臨床醫療圖像數據集

全球規模最大的多類別、病灶級別標注的開放獲取臨床醫療圖像數據集

評論