摘 要

第五代移動通信(5G)技術將為移動互聯網的快速發展提供無所不在的基礎性業務能力,在滿足未來10年移動互聯網流量增加1000倍發展需求的同時,為全行業、全生態提供萬物互聯的基礎網絡技術。相對已有的移動通信技術,5G技術適用面更為廣泛,系統設計也更為復雜。重新復興的人工智能(AI)技術為5G系統的設計與優化提供了一種超越傳統理念與性能的可能性。《中國科學:信息科學》最新錄用了尤肖虎教授等撰寫的評述“基于AI的5G技術——研究方向與范例”。該評述在概述5G移動通信關鍵技術的基礎上,梳理了AI技術在5G系統設計與優化方面富有發展前景的若干發展方向,并給出了有關5G網絡優化、資源最優分配、5G物理層統一加速運算以及端到端物理層聯合優化等若干典型范例。

01引言

5G是面向2020年之后發展需求的新一代移動通信系統,其主要目標可概括為“增強寬帶、萬物互聯”。5G 應用被劃分為3個典型的場景:增強型的移動寬帶(eMBB)、海量連接的機器通信(mMTC),以及高可靠、低時延的物聯網應用(URLLC),并規定了多個維度的關鍵技術指標需求,包括:峰值速率、頻譜效率、時間延遲、網絡可靠性、連接密度及用戶體驗速率等。大規模天線陣列、密集網絡、新型波形復用與信道編譯碼(如極化碼),以及毫米波接入將成為5G無線網絡的核心關鍵技術。

5G另一項富有前景的關鍵技術是網絡虛擬化與切片技術,其基本思想是將5G網絡構建在云計算平臺上,通過計算資源的隔離、動態調配與遷移,實現網絡資源的靈活調配,以適應未來5G極為豐富的應用場景。

5G技術標準正處于不斷完善與成熟的過程中。國際標準化組織3GPP于2017年12月公布了第1個5G技術標準,支持非獨立組網(NSA)與eMBB功能。2018年6月14日,3GPP批準了5G獨立組網(SA)技術標準,5G自此進入了產業全面沖刺的新階段。在4G技術基礎上,5G新無線接口(5G NR):

對已有的多輸入多輸出(MIMO)技術進行了增強,引入了大規模天線陣列技術;

對OFDM時隙結構和時頻資源塊(RB)劃分方案進行了補充,提出了更為靈活的空中接口技術;

預計下一個5G標準版本將引入非正交多用戶接入(NOMA)技術,以支撐廣域覆蓋的中低速率物聯網應用;

沿用了前期的分布式無線網絡構架,將無線網絡功能單元劃分為分布式單元(DU)和中心單元(CU),并引入了基于云計算的網絡虛擬化與切片技術。

5G 技術應用范圍的擴展使得其系統設計和優化更為復雜。傳統移動通信系統的優化目標主要體現在,對系統傳輸速率和移動性能力的支持方面。5G NR 將其應用特性的支持能力進一步擴展至:時間延遲、網絡可靠性、連接密度,以及用戶體驗速率等多個關鍵性能指標(KPI)方面。5G N系統設計需要在這些KPI之間進行折中與優化。而且靈活空中接口、網絡虛擬化與切片技術的引入,極大地增加了系統設計的復雜性,并為5G網絡運維和優化帶來了極大的挑戰。可喜的是,人工智能(AI)技術為5G系統的設計與優化提供了一種超越傳統理念與性能的可能性,已成為業界重點關注的研究方向。3GPP、ITU等組織均提出了5G與AI相結合的研究項目。

AI技術誕生于20世紀中葉,幾經沉浮,近年來借助于現代計算和數據存儲技術的迅猛發展而再次復興。AI技術涵蓋遺傳算法和人工神經網絡兩大類,其本身是一種普適性的機器學習技術。凡是給定場景涉及到了數據的統計、推斷、擬合、優化及聚類,AI均能找到其典型應用。根據訓練數據的標簽(label)或對應關系是否已知來區分,AI學習算法可以粗略地分為監督學習和非監督學習兩類。而增強學習算法既不是一般意義上的非監督學習算法,也不是監督學習算法,因此又自成一類。以上三類學習算法的特點和典型范例包括:

監督學習

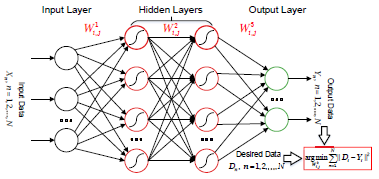

在監督學習中,每個訓練數據組(data pair)都是由一個輸入對象和一個期望的輸出值組成的,其目標是習得輸入和輸出數據的一種的函數關系,并依據該函數關系推斷其他輸入數據可能的輸出值。監督學習的一種典型范例即為圖1所示的深度神經網絡(DNN)的訓練。該訓練方法通過一組先驗的數據對(data pairs)對多層人工神經網絡節點間的加權系數進行離線訓練。當訓練收斂后,該分層人工神經網絡可以實現對新的數據的辨識與推斷。

圖 1

非監督學習

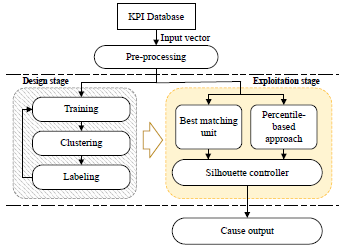

非監督學習的訓練數據是無標簽的數據。通過非監督學習,我們試圖找到這些數據中隱藏的結構。自組織映射(SOM)網絡的訓練就用到了非監督學習方法。在SOM中,如圖2,任意維度的無標簽訓練數據被輸入一個人工神經網絡,轉換為低維度(通常為二維)的離散映射(map),并通過非監督學習算法對權重向量有選擇性地微調,以拓撲有序的方式自適應地執行這種變換。

圖 2

增強學習

增強學習的典型例子是:可在線處理的增強學習方法(見圖3)。它基于智能實體(Agent)與環境(Environment)之間的動態交互。當智能實體感知到環境信息后,依據自己采取動作(Action)所可能帶來的獎賞(Reward)或懲罰(Penalty),確定下一步動作,并進一步觀察環境的反應,循環往復,直至收斂至某一穩態目標。

圖 3

兩種常見的學習方法如下:

反向傳播學習算法

反向傳播(BP)學習算法是分層人工神經網絡中最為經典的訓練算法,是最速下降優化算法的一種具體形式。其目標是通過迭代,調整節點間的加權系數,使得分層人工神經網絡的輸出逐步接近已知的輸出。有關BP算法的動態參數優化及加速實現形式,可參見作者早期的有關論文[You 1992; You 1995]。有關分層人工神經網絡拓撲結構的選擇,以及如何避免陷入局部最優,可參見作者早期的論文[You 1997]。而今,B學習算法被廣泛用于訓練深度神經網絡(DNN),并取得了良好的效果。擁有兩層或更多隱藏層(hidden layer)的神經網絡均可被稱為DNN。卷積神經網絡(CNN)是一類常見的前饋DNN,其隱藏層包含:卷積層、池化層、全連接層及歸一化層。 CNN也可以使用反向傳播算法進行訓練,并能在圖像和語音識別等方面給出比其他DNN更好的結果。

Q學習算法

Q學習算法又稱為Bellman算法,是增強學習最為經典的算法。其基本思路是:選擇某一函數(Q 函數),作為衡量一個智能實體執行某種動作的代價(獎勵或懲罰)函數;該智能實體根據所處的環境,對所有可能的動作進行Q函數評估,并從中選擇出獎勵成份最大的動作,并加以行動。Bellman給出了Q函數常見的迭代更新形式,從而使該智能實體的動作、環境的變化和Q函數的調整能以在線的方式實現。Q 算法的迭代收斂性證明可參見論文[Watkins 1992]。

傳統數據科學的AI機器學習算法(例如線性模型(linearmodels)、決策樹(descision tree)、k均值聚類(k-means clustering)等)日臻成熟并已經部分投入商用。而近年來,深度學習方法(例如DNN、CNN、增強學習等)迅速發展,并在認知技術等領域取得了重大突破,受到了前所未有的關注。與此同時,元學習(meta-learning)等深度學習算法的新分支也在不斷開拓中,提出了“學會學習”等嶄新的概念。例如,Finn等[Finn 2017]提出的未知模型元學習法(model-agnostic meta-learning,MAML)不會對模型的形式做任何假設,也沒有為元學習引入額外的參數,極易應用于許多領域,包括分類、回歸和增強學習等。近期AI技術的發展在文獻[Wu 2018; Zhou 2018; Zhong 2017]中有詳細的總結。

這些新技術使深度學習方法適用于更廣泛、更復雜的場景,也為AI在通信等領域中的應用制造了新的機遇。

02AI應用于5G系統的發展方向

作為普適性的機器學習技術,AI 可以廣泛地應用于5G 系統設計和優化的各個環節,大體上涉及三類技術問題: 組合優化問題、檢測問題及估計問題。

組合優化問題

5G NR的資源分配問題是一個典型的組合優化問題。它需要從資源池中窮舉出一組最優的資源配置方式,并據此將資源分配給網絡覆蓋范圍內的多個用戶,最大化資源利用效率。

檢測問題

再如,5G通信最優接收機的設計就是一個典型的檢測問題,其目標是對接收信號進行辨識,確定對應的發射信號,并使檢測錯誤概率最低。

估計問題

5G通信的信道參數的準確估計是實現系統相干接收的必要條件。它需要根據5G 系統所發送的導頻信號(事先確知),估計出無線信號傳播從發射端到接收端所歷經的信道畸變。

AI技術在5G系統中的應用已有大量的文獻可供參考,但并非所有的研究均有潛在的發展生命力。

首先,移動通信系統本身經過長期的發展,已經擁有了較為完備的經典設計和處理方法。大量實踐已經證明,這些經典方法在工程上極為有效,且易于實現。

其次,移動通信系統通常存在性能界(如香農容量限),現有的方法經過精心設計已經可以充分逼近上述性能界。例如,文獻[Gao 2009]中給出了逼近MIMO容量界的一種設計方法,其只需對功率最優注水分配問題進行簡單的迭代,便可使MIMO的性能充分逼近香農容量界。這意味著,即使采用先進的AI學習技術,也無法超越這些經典算法。

第三,AI學習本身也有明顯的局限性,無論是BP算法還是Q算法均存在訓練的收斂時間問題。能否滿足移動通信系統實時處理的需求,需要進行較為充分的評估。最后,與經典的方法相比,AI學習算法的計算復雜度通常較高,如果不能帶來性能上的明顯提升,其本身顯然不具備足夠的競爭力。

這里,并非否定AI技術在5G系統設計與優化中的潛在價值。相反,5G系統中存在大量傳統方法難以建模、求解、或高效實現的問題,為AI技術在5G中的有效應用提供了可能。同時,一些新的AI算法正在不斷發展中,為AI在5G中的應用提供了新的機遇。因此,有必要對AI技術在5G系統設計與優化中的典型問題進行梳理,從而確定其在5G系統中更有潛在應用價值的研究方向。

為此,本文將AI 在5G中的應用問題劃分為以下四種類型:無法建模問題、難以求解問題、統一模式高效實現問題、及最優檢測與估計問題。我們將看到: 對于前兩類問題,由于缺乏有效的傳統解決方案,AI技術通常更具應用潛力。而對于后兩類問題,AI技術相對于傳統的解決方案是否在性能或實現上具備更強的競爭力,則視其具體解決方案而定。四類問題具體分析如下:

無法建模問題

移動通信系統的網絡優化涵蓋一類難以統一建模的技術問題,如覆蓋問題、干擾問題、鄰區選擇、及越區切換問題等,其運維通常更多地依賴于工程人員的實踐經驗。相比之下,5G系統涉及的應用場景更為綜合、KPI種類更多,特別是5G NR中基于大規模天線陣列的密集波束應用,需要引入更高維度的優化參數,對網絡運維帶來了更為艱巨的挑戰。5GNR另一個難以建模的問題是KPI優化。如前所述,5G NR的KPI涉及峰值速率、頻譜效率、時間延遲、網絡可靠性、連接密度及用戶體驗速率等多個維度,這些指標往往是相互依賴或相互矛盾的,因而難以建立全局性的優化模型。

難以求解問題

5GNR涉及一系列資源分配問題,包括: 小區間時頻資源塊分配、正交導頻資源分配、波束分配、大規模MIMO多用戶聚類及無線網絡虛擬化資源池調配等。這些問題的模型優化目標是使得整個無線網絡的吞吐率最大化,并滿足一定程度的用戶服務比例公平性。其最優解求解問題通常屬于NP-hard類型的組合優化,對應的計算復雜度隨系統規模的增加而指數增長。傳統的解決方法一般將此類問題進行靜態分割,從而以較低的計算量獲取次優的解決方案。AI技術則為此類問題的解決提供了可能的技術途徑。

統一模式高效實現問題

5GNR涉及一些基本功能模塊的級聯組合。以5G NR的物理層為例,涉及大規模MIMO多用戶空時處理、NOMA信號檢測及LDPC碼和Polar碼信道編譯碼等功能模塊。上述每個功能模塊算法各不相同,但理論上均可以單獨采用AI學習技術逐一加以解決。這啟發我們,可用統一的、基于AI技術的軟硬件方案解決5G NR物理層所有的關鍵功能模塊,從而簡化系統的設計流程、加速工程實現的進程、提高物理層實現的可配置性,并最終降低系統實現成本、提高實現效率。

最優檢測與估計問題

將AI應用于5G系統的直觀的想法是,用人工神經網絡來取代傳統發射機和接收機的基本功能模塊。如前所述,基于人工神經網絡訓練的方法,其無線傳輸性能最多也只能接近香農容量界;但相對于經典的優化設計方法,其計算量可能更為龐大,且訓練所需的收斂時間也會限制其實際應用。另一個更值得探討的研究方向是,使用AI技術進行跨層聯合優化,包括:物理層與媒體控制層的聯合優化、信源與信道的聯合優化及算法設計與硬件實現的聯合優化等,這些均是傳統方法所難以解決的。

03AI應用于5G系統的典型范例

本節將具體介紹AI應用于5G系統的四個典型范例: 網絡自組織與自優化、時頻資源最優分配、5G通用加速器、及5G物理層端到端優化。

3.1網絡自組織與自優化

自組織網絡(SON)已被3GPP列為LTE網絡優化關鍵技術。相比于傳統無線通信,5G應用場景更為復雜,網絡優化與管理更為艱難,因此對SON的技術需求將更為強烈。SON包括了網絡自配置、自優化、及自愈合三項功能,旨在淡化傳統人工干預,實現網絡規劃、網絡配置、及網絡優化的高度自動化,以節省運營成本,降低人為故障。文獻[Wang 2015; Klaine 2017; Perez-Romero 2016]對AI技術在SON中的應用進行了總結,涉及基站自主參數配置、動態規劃、遷移學習,網絡故障的自動檢測與定位,及網絡參數的自動優化等,所采用的AI方法包括人工神經網絡學習、蟻群優化、及遺傳算法等。

下面以文獻[Gomez-Andrades 2016]提出的自動故障分析為例,介紹AI技術在SON中的具體應用。為了實現LTE網絡自動故障診斷,AI技術需要克服兩大問題:

現有大量數據的KPI種類多,又缺乏已知的故障標簽,難以進行簡單的歸類診斷;

鑒于人工診斷的成本較高和能力有限,需要盡量減少人工參與。

因此,研究者結合監督和無監督兩種學習方法,提出了基于AI的故障診斷系統。診斷分為以下幾步:

步驟 1

利用圖2所示的無監督的自組織映射(SOM)算法實現對無標簽高維度數據的初步分類。多種類的KPI指標帶來了高維的歷史數據。SOM作為人工神經網絡,通過訓練能將任意維的輸入數據在輸出層映射成二維神經元網絡。神經元的拓撲結構即代表了原數據的分布情況: 越相近的神經元,其映射的原數據越接近。 這樣就實現了高維數據的低維表示和初步聚類。

步驟 2

完成SOM訓練之后,我們再對SOM建立的神經元進行一次無監督的聚類。因為神經元之間的歐氏距離即表示其映射數據之間的差異,所以基于歐式距離的沃德(Ward)聚類算法即可實現對神經元的聚類。

步驟 3

經過以上兩個步驟,數據已經被分為幾個大類。此時,再引入專家對分好類的數據進行故障分析,有監督地貼上故障標簽。

以上三個步驟完成了故障診斷系統的設計,建立了一套自動的診斷流程,如圖4所示。此后產生的新數據在輸入該系統之后,將先由SOM定位到最接近的神經元,再由該神經元的類別標簽判斷其是否故障以及原因。在診斷一定數量的新數據之后,以上三個步驟可以再次被執行用以驗證和更新系統。文獻[Gomez-Andrades 2016]的仿真結果表明,即便在主要使用無監督學習進行構建、并且人工參與量極低的情況下,上述自動故障診斷系統仍能達到非常高的診斷準確率。

圖 4

3.2時頻資源最優分配

相比于4G LTE-A,5G NR將面臨更為復雜的OFDM時頻資源塊(RB)分配問題,以適應5G三種典型的應用場景。圖5給出了一個典型的多小區、多用戶下行鏈路RB分配示意圖。其中,同一小區內不同用戶的RB分配是正交的,系統整體干擾主要取決于相鄰小區用戶RB的分配方案。假設每個用戶的信息容量可在信干比(SIR)測量值的基礎上得出,則系統RB最優分配的目標是使所有用戶的信息容量之和最大化。這是一個典型的NP-hard組合優化問題,所需的計算量與覆蓋范圍內移動用戶數的階乘成正比。

圖 5

以基于Q學習算法的應用為例。假設某一智能實體負責上述移動用戶的RB分配,則該智能實體的動作可以遵循以下原則對用戶RB進行更新:

在同一小區內,選擇SIR較好的空閑RB分配給用戶;

不斷更新本小區SIR最差用戶的RB,以尋求更好的系統性能;

對于同一RB,把本小區SIR最差的用戶與鄰小區SIR最好的用戶進行配對或分簇,如圖3所示。

前兩個原則易于理解,而第三個原則旨在避免位置相近、且處于小區邊緣的用戶被分配相同的RB。此時,相鄰基站無論如何調整發射功率,這些用戶均無法同時獲得正常工作所需的SIR。

智能實體在動作集合確定后,以所有用戶的信息容量之和最大化為準則,選擇當前最優的動作對RB進行調整,并按照Bellman公式對Q函數進行實時更新。如此迭代操作,直至Q函數趨于穩定。

上述迭代過程還應與用戶的功率最優分配相結合。文獻[Wang 2017]基于博弈論框架,給出了多小區用戶采用相同RB時的最優功率分配方法。如果系統需要進一步考慮用戶QoS的比例公平性,可引入拉格朗日乘子法,構造相應的動作評估準則和Q函數。文獻[Bogale 2018; Li 2017]對AI在5G資源分配中的一些應用進行了總結和展望。而cite{35。3}也初步提出了增強學習方法在5G新框架中的網絡切片技術方面的新應用。

3.35G通用加速器

相比于4G,5G的基帶處理需要考慮更多的模塊,例如:大規模MIMO檢測、NOMA檢測及Polar碼譯碼等,這會使硬件面積增加,實現架構不規律。可以注意到,盡管5G基帶模塊眾多,但所有功能均可以用基于因子圖的置信傳播算法實現。針對特定的基帶功能,置信傳播算法只需確定變量符號集、變量間關系等參數,而保持其余的部分不變。因此可以用一個基于置信傳播的、參數可配置的通用加速器實現整個基帶功能。

盡管基于置信傳播的算法可以實現5G通用加速器,但受其性能限制,置信傳播算法在一些場景下仍然無法滿足要求。為此我們嘗試在置信傳播通用加速器的基礎上,實現基于AI的5G通用加速器。我們可以通過以下兩種方式,將一個置信傳播算法改進為一個性能更好的AI算法。

方法一

將置信傳播算法改為深度神經網絡(DNN)算法。方法如下:

將置信傳播算法的因子圖復制多次,并按照原有的方式連接為一個深度神經網絡,復制次數等于置信傳播算法的迭代次數。

對DNN進行訓練。Xu等[Xu 2017]提出的基于DNN的polar碼譯碼器,Tan等[Tan 2018]提出的基于DNN的MIMO檢測器等是方法一在基帶模塊上實現的范例。

方法二

將置信傳播算法改為卷積神經網絡(CNN)算法。方法如下:

將置信傳播算法的因子圖節點排列在圖片上,其中每個像素代表一個節點。像素相鄰意味著其對應的節點在因子圖中相連。

用連接得到的圖像對CNN進行訓練。Liang等[Liang 2018]提出的BP-CNN信道譯碼器應用了方法二。

AI技術中的神經網絡算法具有高度的自適應性與可靠性。通過將基帶算法轉化為神經網絡能夠處理的問題,我們受益于以下兩方面:

系統性能的提升;

硬件架構的統一。

觀察神經網絡的算法,我們發現CNN核心操作是卷積運算,而DNN核心操作為二維矩陣乘法運算。二維脈動陣列可以同時完成上述兩種運算。因此利用同一脈動陣列,只需對輸入數據進行合理調度,即可同時實現CNN與DNN的功能,從而實現基于AI的5G通用加速器。文獻[Xu 2018a]綜合研究了神經網絡的高效量化策略以及硬件實現。一種二維脈動陣列架構如圖6所示,可以看出其高度的規整性和可擴展性。

圖 6

文獻[Xu 2018b]指出,在由信道編碼、信道、信道均衡器及譯碼器組成的系統中(如圖7),接收機的均衡器與譯碼器分別可用CNN和DNN實現。對應的AI加速器有兩種實現方案。

圖 7

硬件消耗優先的設計

我們可將整個接收機折疊為一個通用處理器。通用處理器首先工作于均衡器模式(CNN),輸入為來自信道的信息,輸出被保存下來;然后工作于譯碼器模式(DNN),將剛保存的結果作為輸入,輸出最后的譯碼結果。

吞吐速率優先的設計

接收機由兩個通用處理器組成流水線,兩個處理器分別工作在均衡器和譯碼器模式。

可以看出,相比于傳統實現,通用處理器可帶來更多硬件設計自由度,以更好的滿足不同系統要求。

3.45G物理層端到端優化

AI算法在物理層若干模塊上成功實現了功能優化,例如:Lv等[Lv 2004]提出的基于神經網絡的調制模式識別,Xu等[Xu 2017]提出的DNN極化碼譯碼器,及Liang等[Liang 2018]提出的基于DNN的MIMO檢測算法等。在兩個或多個物理層模塊的聯合優化問題中,AI算法也得到了成功的應用,例如Xu等[Xu 2018b]提出的基于神經網絡的信道均衡和信道譯碼的聯合優化。文獻[Wang 2017; O'Shea 2017]均對AI在物理層各模塊的應用進行了較全面的總結。但單個模塊的優化并無法保證整個物理層端到端通信的整體優化,而端到端通信的實現中,多個基于迭代算法的AI模塊的拼接反而會帶來更高的訓練和計算復雜度。因此,我們需要一種對物理層端到端的聯合優化方法。

文獻[O'Shea 2017a]提出將物理層通信看作一個端到端的信號重構問題,并應用自編碼器概念來表示物理層通信過程,進行端到端通信的聯合優化。自編碼器是一種無監督深度學習算法,屬于神經網絡,通過學習輸入信息的壓縮形式來進行壓縮信息的重構。在利用自編碼器構建的端到端通信模型中,編碼、調制、信道均衡等物理層模塊,被簡單表示為發射端,信道和接收端三個模塊:發射端和接收端都分別表示為全連接的DNN,其中發射端連接一個歸一化層來確保輸出值符合物理約束,接收端則連接一個softmax激活函數層,最后輸出一組概率向量來決定接收到的信息。兩者中間的AWGN信道則用神經網絡的一個噪聲層(noise layer)表示,從而將通信系統表示為結構如圖8所示的大型自編碼器。該自編碼器基于端到端的誤比特率(BER)或誤塊率(BLER)表現進行訓練,完成訓練的自編碼器即可基于接收信號對傳輸信號進行重構。

圖 8

自編碼器方法不基于任何經典的編碼、檢測方法,而是將整個端到端通信構筑為一個用于信息重構的DNN并進行聯合優化。在難以建立準確模型的復雜現實環境中,自編碼器方法不采用經典模型,而是利用大量數據的支撐和機器學習算法的強大功能來“學習”復雜的信道狀況,從而優化整個通信過程。同時,它也有效避免了多種模塊拼接而產生的多層網絡所帶來的高復雜度和大計算量。O'Shea 等[O'Shea 2017a]將自編碼器模型推廣到干擾信道的多用戶通信模型上,而[O'Shea 2017b]則將這種自編碼器優化方法推廣到MIMO上,通過增加信道矩陣相關模塊,形成了如圖9所示的MIMO自編碼器通信模型。文獻[O'Shea 2017b]的實驗結果均顯示自編碼器方法建立了一種可用于不同CSI信息,天線數等情況下的統一物理層框架,并且在更低的計算復雜度下可通過 "學習" 得到比經典方法更低的誤比特率。而上述端到端優化策略可以利用上文所述的 "基于AI的5G通用加速器" 加以高效實現。

圖 9

04結束語

5G突破了傳統移動通信系統的應用范疇,在大幅提升傳統移動互聯網服務能力的同時,將應用的觸角滲透至各行各業的物聯網應用,從而演變成為支撐全社會、全行業運行的基礎性互聯網絡。以統一的技術框架支撐極度差異化的繁雜應用,5G技術的發展正面臨著前所未有的挑戰。AI技術的新一輪復興及迅猛發展,為應對上述挑戰并超越傳統移動通信設計理念與性能提供了潛在的可能性。

AI技術在5G移動通信系統中應用,已有大量的研究文獻可供借鑒。本文并非試圖全面地總結該領域已有研究成果,而是希望厘清AI技術在5G系統中最有發展生命力的研究方向,并通過在這些方向上的進一步努力,使5G系統性能與實現的便利性可以顯著超越傳統移動通信系統。基于本文所給出的若干典型應用范例,我們有理由期待上述努力在不遠的未來取得顯著的成效。

-

神經網絡

+關注

關注

42文章

4811瀏覽量

103007 -

5G技術

+關注

關注

8文章

533瀏覽量

18904 -

ai技術

+關注

關注

1文章

1307瀏覽量

25049

原文標題:東南大學尤肖虎教授:基于AI的5G技術---研究方向與范例

文章出處:【微信號:mwrfnet,微信公眾號:微波射頻網】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

AI技術在5G系統設計與優化方面富有發展前景的若干發展方向

AI技術在5G系統設計與優化方面富有發展前景的若干發展方向

評論