強(qiáng)化學(xué)習(xí)是一種非常重要 AI 技術(shù),它能使用獎(jiǎng)勵(lì)(或懲罰)來(lái)驅(qū)動(dòng)智能體(agents)朝著特定目標(biāo)前進(jìn),比如它訓(xùn)練的 AI 系統(tǒng) AlphaGo 擊敗了頂尖圍棋選手,它也是 DeepMind 的深度 Q 網(wǎng)絡(luò)(DQN)的核心部分,它可以在多個(gè) workers 之間分步學(xué)習(xí),例如,在 Atari 2600 游戲中實(shí)現(xiàn)“超人”性能。

麻煩的是,強(qiáng)化學(xué)習(xí)框架需要花費(fèi)大量時(shí)間來(lái)掌握一個(gè)目標(biāo),而且框架往往是不靈活和不總是穩(wěn)定的。

但不用擔(dān)心,Google 近日發(fā)布了一個(gè)替代方案:基于 TensorFlow 的開(kāi)源強(qiáng)化學(xué)習(xí)框架 Dopamine(多巴胺)。

Google 的博文中提到,這個(gè)基于 Tensorflow 的強(qiáng)化學(xué)習(xí)框架,旨在為 RL 的研究人員提供靈活性,穩(wěn)定性和可重復(fù)性的研究。受到大腦中獎(jiǎng)勵(lì)動(dòng)機(jī)行為的主要成分的啟發(fā),以及反映神經(jīng)科學(xué)與強(qiáng)化學(xué)習(xí)研究之間強(qiáng)烈的歷史聯(lián)系,該平臺(tái)旨在實(shí)現(xiàn)可推動(dòng)激進(jìn)發(fā)現(xiàn)的思辨研究(speculative research)。此版本還包括一組闡明如何使用整個(gè)框架的 colabs。

除了強(qiáng)化學(xué)習(xí)框架的發(fā)布,谷歌還推出了一個(gè)網(wǎng)站(https://google.github.io/dopamine/baselines/plots.html),允許開(kāi)發(fā)人員快速可視化多個(gè)智能體的訓(xùn)練運(yùn)行情況。他們希望,這一框架的靈活性和易用性將使研究人員能積極嘗試新的想法,不管是漸進(jìn)式還是激進(jìn)式的想法。

引入靈活和可重復(fù)的強(qiáng)化學(xué)習(xí)研究的新框架

強(qiáng)化學(xué)習(xí)(RL)研究在過(guò)去幾年中取得了許多重大進(jìn)展。這些進(jìn)步使得智能體可以以超人類(lèi)級(jí)別的能力玩游戲。比如 Atari 游戲中 DeepMind 的 DQN ,AlphaGo ,AlphaGo Zero 以及 Open AI Five。

具體而言,在 DQN 中引入 replay memories 可以利用以前的智能體經(jīng)驗(yàn),大規(guī)模的分布式訓(xùn)練可以在多個(gè) workers 之間分配學(xué)習(xí)過(guò)程,分布式方法允許智能體模擬完整的分布過(guò)程,而不僅僅是模擬它們期望值,以學(xué)習(xí)更完整的圖景。這種類(lèi)型的進(jìn)展很重要,因?yàn)槌霈F(xiàn)這些進(jìn)步的算法還適用于其他領(lǐng)域,例如機(jī)器人技術(shù)。

通常,這種進(jìn)步都來(lái)自于快速迭代設(shè)計(jì)(通常沒(méi)有明確的方向),以及顛覆既定方法的結(jié)構(gòu)。然而,大多數(shù)現(xiàn)有的 RL 框架并沒(méi)有結(jié)合靈活性和穩(wěn)定性以及使研究人員能夠有效地迭代 RL 方法,并因此探索可能沒(méi)有直接明顯益處的新研究方向。此外,從現(xiàn)有框架再現(xiàn)結(jié)果通常太耗時(shí),這可能導(dǎo)致科學(xué)的再現(xiàn)性問(wèn)題。

今天,我們推出了一個(gè)新的基于 Tensorflow 的框架,旨在為 RL 的研究人員提供靈活性、穩(wěn)定性和可重復(fù)性。受到大腦中獎(jiǎng)勵(lì)動(dòng)機(jī)行為的主要成分的啟發(fā),以及反映神經(jīng)科學(xué)與強(qiáng)化學(xué)習(xí)研究之間強(qiáng)烈的歷史聯(lián)系,該平臺(tái)旨在實(shí)現(xiàn)可推動(dòng)激進(jìn)發(fā)現(xiàn)的思辨研究(speculative research)。此版本還包括一組闡明如何使用整個(gè)框架的 colabs。

易用性

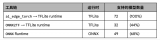

清晰和簡(jiǎn)潔是該框架設(shè)計(jì)中要考慮的兩個(gè)關(guān)鍵因素。我們提供更精簡(jiǎn)的代碼(大約 15 個(gè)Python 文件),并且有詳細(xì)記錄。這是通過(guò)專(zhuān)注于 Arcade 學(xué)習(xí)環(huán)境(一個(gè)成熟的,易于理解的基準(zhǔn))和四個(gè)基于 value 的智能體來(lái)實(shí)現(xiàn)的:DQN,C51,一個(gè)精心策劃的 Rainbow 智能體的簡(jiǎn)化版本,以及隱式分位數(shù)網(wǎng)絡(luò)(Implicit Quantile Network)智能體,這已在上個(gè)月的 ICML 大會(huì)上已經(jīng)發(fā)表。我們希望這種簡(jiǎn)潔性使研究人員能夠輕松了解智能體內(nèi)部的運(yùn)作狀況,并積極嘗試新的想法。

可重復(fù)性

我們對(duì)重復(fù)性在強(qiáng)化學(xué)習(xí)研究中的重要性特別敏感。為此,我們?yōu)榇a提供完整的測(cè)試覆蓋率,這些測(cè)試也可作為其他文檔形式。此外,我們的實(shí)驗(yàn)框架遵循 Machado 等人給出的關(guān)于使用 Arcade 學(xué)習(xí)環(huán)境標(biāo)準(zhǔn)化經(jīng)驗(yàn)評(píng)估的建議。

基準(zhǔn)測(cè)試

對(duì)于新的研究人員來(lái)說(shuō),能夠根據(jù)既定方法快速對(duì)其想法進(jìn)行基準(zhǔn)測(cè)試非常重要。因此,我們?yōu)?Arcade 學(xué)習(xí)環(huán)境支持的 60 個(gè)游戲提供四個(gè)智能體的完整培訓(xùn)數(shù)據(jù),可用作 Python pickle 文件(用于使用我們框架訓(xùn)練的智能體)和 JSON 數(shù)據(jù)文件(用于與受過(guò)其他框架訓(xùn)練的智能體進(jìn)行比較);我們還提供了一個(gè)網(wǎng)站,你可以在其中快速查看 60 個(gè)游戲中所有智能體的訓(xùn)練運(yùn)行情況。

下面展示我們?cè)?Seaquest 上的 4 個(gè)代理的訓(xùn)練情況,這是由 Arcade 學(xué)習(xí)環(huán)境支持的一種 Atari 2600 游戲。

在 Seaquest 上的 4 名智能體參加了訓(xùn)練。x 軸表示迭代,其中每次迭代是 100 萬(wàn)個(gè)游戲幀(4.5 小時(shí)的實(shí)時(shí)游戲);y 軸是每場(chǎng)比賽獲得的平均分?jǐn)?shù)。陰影區(qū)域顯示的是來(lái)自 5 次獨(dú)立運(yùn)行的置信區(qū)間。

我們還提供已經(jīng)訓(xùn)練好的深度網(wǎng)絡(luò),原始統(tǒng)計(jì)日志以及用 Tensorboard 繪圖的 Tensorflow 事件文件。這些都可以在網(wǎng)站的下載部分找到。

希望我們框架的靈活性和易用性將使研究人員敢于嘗試新的想法,包括漸進(jìn)式和激進(jìn)式的想法。我們已經(jīng)積極地將它用于我們的研究,并發(fā)現(xiàn)它能夠靈活且快速迭代許多想法。我們很高興可以為更大的社區(qū)做些貢獻(xiàn)。

-

Google

+關(guān)注

關(guān)注

5文章

1789瀏覽量

59030 -

AI

+關(guān)注

關(guān)注

88文章

35143瀏覽量

279824

原文標(biāo)題:Google發(fā)布“多巴胺”開(kāi)源強(qiáng)化學(xué)習(xí)框架,三大特性全滿足

文章出處:【微信號(hào):CAAI-1981,微信公眾號(hào):中國(guó)人工智能學(xué)會(huì)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

NVIDIA Isaac Lab可用環(huán)境與強(qiáng)化學(xué)習(xí)腳本使用指南

Google Fast Pair服務(wù)簡(jiǎn)介

18個(gè)常用的強(qiáng)化學(xué)習(xí)算法整理:從基礎(chǔ)方法到高級(jí)模型的理論技術(shù)與代碼實(shí)現(xiàn)

詳解RAD端到端強(qiáng)化學(xué)習(xí)后訓(xùn)練范式

基于LMP91000在電化學(xué)傳感器電極故障檢測(cè)中的應(yīng)用詳解

請(qǐng)問(wèn)什么是同步采樣ADC?要實(shí)現(xiàn)同步采樣要滿足什么條件?

HarmonyOS NEXT應(yīng)用元服務(wù)開(kāi)發(fā)Intents Kit(意圖框架服務(wù))綜述

螞蟻集團(tuán)收購(gòu)邊塞科技,吳翼出任強(qiáng)化學(xué)習(xí)實(shí)驗(yàn)室首席科學(xué)家

卷積神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)工具與框架

Google AI Edge Torch的特性詳解

Google強(qiáng)化學(xué)習(xí)框架,要滿足哪三大特性

Google強(qiáng)化學(xué)習(xí)框架,要滿足哪三大特性

評(píng)論