穿衣服是我們每天都會做的動作,對人類來說非常容易,比如在穿襯衫時,我們一手打開襯衫,另一只手會穿到袖子中,連同整個手臂穿入袖子,再換另一只手穿好另一邊的袖子。整個過程中,我們都會依靠觸覺,保證動作不會破壞衣服。但是目前還沒有能讓智能體自己穿衣的機器學習案例,想將人物和衣服之間這樣復雜的交互動作制作成動畫,依然是很大的挑戰。

最近,佐治亞理工學院的研究人員們提出了一種模型,可以讓強化學習智能體像人類一樣穿短袖、襯衫等衣服。以下是論智對原論文做的大致介紹:

為了用動畫模擬人們穿衣的動作,我們用到了物理模擬和機器學習,我們使用了一個物理引擎模擬人物和衣服的動作。為了生成任務動作,我們用強化學習訓練了一個神經網絡,執行人物控制衣服的策略。

由于每個人在穿衣服時的控制策略不同,每個策略的動作都是由任務和環境的狀態決定的。和其他運動或控制動作不同,穿衣服的動作并不遵循特定的運動軌跡,同時環境狀態也在高度變換,難以表示。所以我們用無模型的深度強化學習方法,用深度網絡自動探索穿衣控制策略。

深度強化學習最近受到很大關注,因為它可以大大減少降維需求,也無需選擇狀態空間和動作空間的特征。但是,直接在高維空間中學習、輸入狀態空間,對穿衣問題來說比較棘手,因為在這種場景下的計算成本非常大。所以,直接生成“穿衣策略”會嚴重影響獎勵函數、狀態和動作的設計,使得端到端學習方法變得不切實際。在這篇論文中,我們首次證明了,利用合適的輸入狀態空間和獎勵函數,是可以將模擬衣物嵌入到強化學習框架中的,從而學習一種穩定的穿衣控制策略的。

觸覺感知

雖然穿衣的過程類似“移動”和“抓取”任務,但是與常見的操控任務不同的是,穿衣過程是依靠觸覺判斷任務的進行的。智能體需要學習用觸覺完成兩個相反的任務:施加力量將身體套在衣服上,同時還要避免力量過大損壞衣服。

在這一過程中,我們提出了一種可以表示觸覺信息的方法,用來指引穿衣過程。輸入到控制策略中的一部分環境狀態是一張觸覺地圖(haptic map),它可以測量智能體和模擬衣物之間接觸部分的力度。我們在智能體身上安置了一系列觸覺感應器,然后收集身體和衣服之間的接觸力量。感應器分布如下所示:

分辨正反

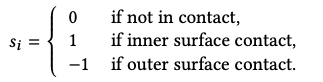

人們在穿衣時,會讓身體和衣服的內側接觸,也就是說人類能很容易地分辨衣服的正反面,這對不具備視覺感應器的機器人來說也是個難題。為此,我們對每個觸覺感應器提供了相應的策略,可以區分衣物的內側和外側。

如果感應器上的接觸力與該位置上面向外的頂點法線相反,那么就是-1,反之則為1.如果最后感應器收集的值為正數,那么我們就認為與感應器接觸的是衣服的內里,反之則是外側。

除此之外,訓練期間的獎勵函數會根據觸覺狀態和采取的動作提供學習信號。例如,如果模型檢測到衣服發生變形,就會用獎勵函數進行懲罰。

策略程序算法

另一個遇到的挑戰就是,智能體在穿衣服時需要做一系列動作,例如先抓起襯衫,將手對準袖口,再將手穿過去。想讓單一的控制策略學習每一個步驟,并且一氣呵成是不可能的,原因仍然與計算成本有關。于是,我們將一整套穿衣流程分解成不同的子任務,對每個任務學習控制策略。每個穿衣動作的子任務都被設計成部分可觀測的馬爾可夫決策過程(POMDP),每個POMDP的解決方法都是隨機控制策略:π:O × A →[0, 1]。一個馬爾可夫決策過程是(S, A, r, ρ, Psas’, γ)的組合,其中S表示狀態空間,A表示動作空間,r是獎勵函數,ρ表示初始狀態s0的分布,Psas’是過渡概率,γ是折扣因子。我們的目標是優化表示神經網絡的策略π,讓積累的獎勵達到最大。

為了保證任務效果不會因為策略的改變而改變,我們提出了一種策略程序(Policy sequencing)算法,它可以將一種子任務中的輸出狀態分布與下一個子任務的輸入分布按順序相匹配。

要為一個子任務生成成功策略需要數小時的模擬和優化。高計算成本也有好處,這樣一來,最終結果就不是單一的動畫,而是智能體的控制策略,可以處理多種情況,比如不同的衣服位置和人物動作,如果過程中有干擾,會利用控制策略進行修正。

結果

模擬小人穿t-shirt

模擬小人穿對開式衣服

模擬小人在輔助工具下穿衣

-

智能體

+關注

關注

1文章

307瀏覽量

11078 -

強化學習

+關注

關注

4文章

269瀏覽量

11602

原文標題:效果驚艷!強化學習讓智能體像人類一樣穿衣服

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

將深度學習和強化學習相結合的深度強化學習DRL

高明!OpenAI提出HER算法,人工智能可像人類一樣認識錯誤汲取教訓

機器能像嬰兒一樣通過眼睛學習世界?

人工智能和人類看到的東西一樣嗎

DeepMind發布強化學習庫RLax

語言模型做先驗,統一強化學習智能體,DeepMind選擇走這條通用AI之路

什么是強化學習

讓強化學習智能體像人類一樣穿短袖、襯衫等衣服

讓強化學習智能體像人類一樣穿短袖、襯衫等衣服

評論