吳恩達(dá)斯坦福大學(xué)CS230《深度學(xué)習(xí)》課程內(nèi)容歸納總結(jié)放出,全文干貨。對(duì)于不方便正式上課的同學(xué)們來說,相信這份核心內(nèi)容總結(jié)一定會(huì)對(duì)你有所幫助。

作為全球計(jì)算機(jī)四大名校之一,斯坦福大學(xué)的CS230《深度學(xué)習(xí)》課程一直受到全球計(jì)算機(jī)學(xué)子和從業(yè)人員的熱烈歡迎。

CS230授課人為全球著名計(jì)算機(jī)科學(xué)家吳恩達(dá)和他的助教Kian Katanforoosh。

日前,MIT的Afshine Amidi和斯坦福大學(xué)的Shervine Amidi在博客上整理了一份CS230課程知識(shí)點(diǎn)的歸納總結(jié),在Reddit上引發(fā)熱議。

評(píng)論網(wǎng)友紛紛表示喜大普奔,對(duì)于沒有條件上課或者沒趕上授課時(shí)間的人來說,看看這份總結(jié)貼也能獲益頗豐。

這份總結(jié)提要基本遵循CS230的授課思路和流程,分三大方面由淺入深地介紹了深度學(xué)習(xí)的基本概念、網(wǎng)絡(luò)模型、研究和實(shí)驗(yàn)操作方法等。三部分內(nèi)容分別為:卷積神經(jīng)網(wǎng)絡(luò)、遞歸神經(jīng)網(wǎng)絡(luò)、提示與技巧。

本文主要介紹這份總結(jié)的第一部分,即CNN部分的內(nèi)容,后兩部分RNN、竅門與技巧部分,讀者可自行參看Github上放出的資源:

卷積神經(jīng)網(wǎng)絡(luò)(CNN)

https://stanford.edu/~shervine/teaching/cs-230/cheatsheet-convolutional-neural-networks

遞歸神經(jīng)網(wǎng)絡(luò)(RNN)

https://stanford.edu/~shervine/teaching/cs-230/cheatsheet-recurrent-neural-networks

技巧與竅門

https://stanford.edu/~shervine/teaching/cs-230/cheatsheet-deep-learning-tips-and-tricks

囊括全部?jī)?nèi)容的“超級(jí)VIP”pdf下載

https://github.com/afshinea/stanford-cs-230-deep-learning/blob/master/super-cheatsheet-deep-learning.pdf

卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu):卷積層、池化層、全連接層

傳統(tǒng)的卷積神經(jīng)網(wǎng)絡(luò)由輸入圖像、卷積層、池化層和全連接層構(gòu)成。

卷積層(CONV):使用過濾器執(zhí)行卷積操作,掃描輸入大小。它的超參數(shù)包括濾波器的Size和Stride。結(jié)果輸出O稱為特征映射或激活映射。

池化層(POOL)是一種下采樣操作,通常在卷積層之下使用,該卷積層執(zhí)行一些空間不變性。其中最大池化和平均池化屬于特殊操作,分別采用最大值和平均值。

全連接層(FC)在平坦輸入上運(yùn)行,每個(gè)輸入都連接到所有神經(jīng)元。如果全連接層存在,通常位于網(wǎng)絡(luò)體系結(jié)構(gòu)的末尾,可用于優(yōu)化諸如分類評(píng)分等目標(biāo)。

過濾器超參數(shù)

過濾器維度:大小為F×F的過濾器應(yīng)用在Cchannel上維度為F×F×C。

Stride:對(duì)于卷積和池化操作而言,Stride表示每次操作后窗口移動(dòng)的像素?cái)?shù)量。

Zero-padding表示對(duì)輸入邊界的每一端加入P個(gè)零的過程。這個(gè)值可以通過下圖中所示的三個(gè)方式手動(dòng)指定,也可以自動(dòng)設(shè)置。

超參數(shù)的調(diào)整

卷積層中的超參數(shù)兼容性:記輸入量長(zhǎng)度為I,過濾器長(zhǎng)度為F,補(bǔ)零數(shù)量為P,Stride量為S,則該維度下特征映射的輸出大小O可用下式表示:

理解模型的復(fù)雜度:為了獲取模型復(fù)雜度,常常可以通過相應(yīng)架構(gòu)下的參數(shù)數(shù)量來達(dá)到這一目標(biāo)。在給定的卷積神經(jīng)網(wǎng)絡(luò)層中,該過程如下圖所示:

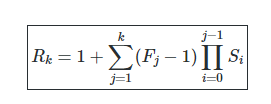

感受野:層K上的感受野區(qū)域記為Rk×Rk,即第K次激活映射可以“看見”的每個(gè)輸入像素。若層j上的過濾器大小為Fj,層i上的Stride值為Si,且S0=1,則層k上的感受野可以由下式計(jì)算出:

常用激活函數(shù)

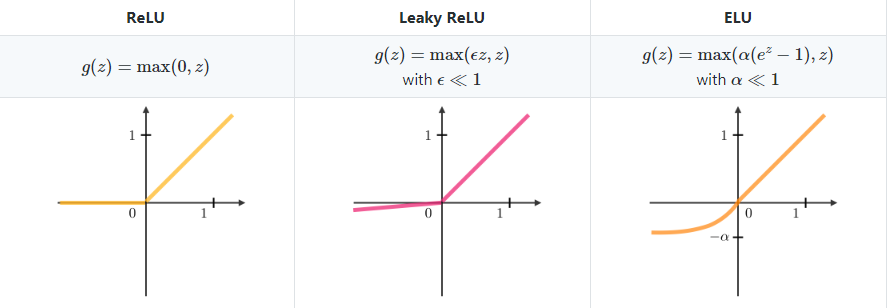

整流線性單元:整流線性單元層(ReLU)是激活函數(shù)g,作用于所有元素。它旨在為網(wǎng)絡(luò)引入非線性特征,其變量總結(jié)在下圖中:

Softmax:可以視作一個(gè)作用于網(wǎng)絡(luò)架構(gòu)末端通用邏輯函數(shù),輸入為分?jǐn)?shù)向量,輸出為概率向量。其定義如下:

物體檢測(cè)

模型的類型:

有三類主要的物體識(shí)別算法,其預(yù)測(cè)的性質(zhì)是不同的。如下表的描述:

三類物體識(shí)別算法

檢測(cè)(Detection):

在對(duì)象檢測(cè)的上下文中,根據(jù)我們是僅想要定位對(duì)象還是想要在圖像中檢測(cè)更復(fù)雜的形狀,可以使用不同的方法。下面總結(jié)了兩個(gè)主要的方法:

邊界框檢測(cè)和特征點(diǎn)檢測(cè)

Intersection over Union:

Intersection over Union(交并比),也稱為IoU,是一種量化預(yù)測(cè)邊界框 在實(shí)際邊界框

在實(shí)際邊界框 上的正確定位的函數(shù)。它的定義是:

上的正確定位的函數(shù)。它的定義是:

備注:IoU∈[0,1]。按照慣例,如果IoU(Bp,Ba)?0.5,預(yù)測(cè)邊界框Bp被認(rèn)為是合理的。

Anchor boxes:

Anchor boxing是一種用于預(yù)測(cè)重疊邊界框的技術(shù)。在實(shí)際應(yīng)用中,網(wǎng)絡(luò)可以同時(shí)預(yù)測(cè)多個(gè)box,其中每個(gè)box的預(yù)測(cè)被約束具有給定的一組幾何特性。例如,第一個(gè)預(yù)測(cè)可能是給定形狀的矩形框,而第二個(gè)預(yù)測(cè)可能是另一個(gè)形狀不同的矩形框。

Non-max suppression:

Non-max suppression技術(shù)旨在通過選擇最具代表性的對(duì)象來刪除同一對(duì)象的重疊邊界框。在刪除了概率預(yù)測(cè)低于0.6的所有框之后,在剩余框中重復(fù)以下步驟:

對(duì)于一個(gè)給定的類,

步驟1:選擇具有最大預(yù)測(cè)概率的框。

步驟2:刪除任何與前一個(gè)框的IoU?0.5的框。

YOLO - You Only Look Once,這是一種對(duì)象檢測(cè)算法,它執(zhí)行以下步驟:

步驟1:將輸入圖像分割成G×G的網(wǎng)格。

步驟2:對(duì)于每個(gè)網(wǎng)格單元,運(yùn)行一個(gè)CNN網(wǎng)絡(luò),預(yù)測(cè)下面公式中的y:

其中 是檢測(cè)對(duì)象的概率,

是檢測(cè)對(duì)象的概率, 是檢測(cè)到的邊界框的屬性,

是檢測(cè)到的邊界框的屬性, 是檢測(cè)到的p類的one-hot representation,k是anchor boxes的數(shù)量。

是檢測(cè)到的p類的one-hot representation,k是anchor boxes的數(shù)量。

步驟3:運(yùn)行 non-max suppression 算法,刪除任何可能的重復(fù)重疊邊界框。

R-CNN

Region with Convolutional Neural Networks (R-CNN) 是一種對(duì)象檢測(cè)算法,它首先對(duì)圖像進(jìn)行分割以找到潛在的相關(guān)邊界框,然后運(yùn)行檢測(cè)算法,在那些邊界框中找到最可能的對(duì)象。

備注:雖然原始算法計(jì)算成本高且速度慢,但新的架構(gòu)能讓算法運(yùn)行得更快,例如Fast R-CNN和Faster R-CNN。

面部驗(yàn)證和識(shí)別

模型類型:下面總結(jié)了兩種主要類型的模型:

One Shot Learning

One Shot Learning是一種面部驗(yàn)證算法,它使用有限的訓(xùn)練集來學(xué)習(xí)相似函數(shù),該函數(shù)量化兩個(gè)給定圖像的差異。應(yīng)用于兩個(gè)圖像的相似度函數(shù)通常被標(biāo)注為d(image 1,image 2).。

Siamese Network

Siamese Networks的目的是學(xué)習(xí)如何編碼圖像,然后量化不同的兩個(gè)圖像。對(duì)于給定的輸入圖像 ,編碼輸出通常記為

,編碼輸出通常記為

Triplet loss

Triplet loss ?是在圖像A(anchor),P(positive) 和N(negative)這三個(gè)圖像的嵌入表示上計(jì)算的損失函數(shù)。 anchor和positive示例屬于同一個(gè)類,negative示例屬于另一個(gè)類。通過調(diào)用 margin參數(shù),該損失定義如下:

margin參數(shù),該損失定義如下:

神經(jīng)風(fēng)格遷移

動(dòng)機(jī):

神經(jīng)風(fēng)格轉(zhuǎn)移(neural style transfer)的目標(biāo)是基于給定內(nèi)容C和給定風(fēng)格S,生成圖像G。

激活:

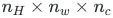

在給定層l中,激活被標(biāo)記為 ,并且具有維度

,并且具有維度

內(nèi)容成本函數(shù)(Content cost function)

內(nèi)容成本函數(shù) 用于確定生成的圖像G與原始內(nèi)容圖像C的不同之處。它的定義如下:

用于確定生成的圖像G與原始內(nèi)容圖像C的不同之處。它的定義如下:

風(fēng)格矩陣(Style matrix)

style matrix 是一個(gè)Gram矩陣,其中每個(gè)元素

是一個(gè)Gram矩陣,其中每個(gè)元素 量化了通道k和k'的相關(guān)性。它是根據(jù)激活

量化了通道k和k'的相關(guān)性。它是根據(jù)激活

風(fēng)格成本函數(shù)(Style cost function)

風(fēng)格成本函數(shù) 用于確定生成的圖像G與風(fēng)格S的不同之處。它的定義如下:

用于確定生成的圖像G與風(fēng)格S的不同之處。它的定義如下:

總成本函數(shù)(Overall cost function)

總成本函數(shù)的定義是內(nèi)容和風(fēng)格成本函數(shù)的組合,由參數(shù)α, β加權(quán),如下所示:

使用計(jì)算技巧的架構(gòu)

生成對(duì)抗網(wǎng)絡(luò)(Generative Adversarial Network)

生成對(duì)抗網(wǎng)絡(luò),也稱為GAN,由生成模型和判別模型組成,其中生成模型旨在生成最真實(shí)的輸出,這些輸出將被用于區(qū)分生成圖像和真實(shí)圖像。

ResNet(Residual Network)

殘差網(wǎng)絡(luò)架構(gòu)(也稱為ResNet),使用具有大量層的residual blocks來減少訓(xùn)練誤差。 residual blocks 具有以下特征:

Inception Network

該架構(gòu)使用 inception modules,目的是嘗試不同的卷積,以通過特征的多樣化來提高其性能。具體來說,它使用1×1卷積技巧來限制計(jì)算負(fù)擔(dān)。

-

濾波器

+關(guān)注

關(guān)注

161文章

7876瀏覽量

179071 -

網(wǎng)絡(luò)模型

+關(guān)注

關(guān)注

0文章

44瀏覽量

8506 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5518瀏覽量

121612

原文標(biāo)題:斯坦福CS230官方指南:CNN、RNN及使用技巧速查(打印收藏)

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

請(qǐng)發(fā)我一份CS1237-SO的STC51例程

C語言程序小知識(shí)點(diǎn)總結(jié)

計(jì)算機(jī)組成原理考研知識(shí)點(diǎn)歸納

高一數(shù)學(xué)知識(shí)點(diǎn)總結(jié)

高二數(shù)學(xué)知識(shí)點(diǎn)總結(jié)

Python的知識(shí)點(diǎn)總結(jié)詳細(xì)說明

嵌入式知識(shí)點(diǎn)總結(jié)

人教版八年級(jí)生物下冊(cè)知識(shí)點(diǎn)歸納總結(jié)

開關(guān)電源模塊知識(shí)點(diǎn)總結(jié)

數(shù)字信號(hào)處理知識(shí)點(diǎn)總結(jié)

數(shù)字電路知識(shí)點(diǎn)總結(jié)

電阻的相關(guān)知識(shí)點(diǎn)

機(jī)器視覺與視覺檢測(cè)知識(shí)點(diǎn)的歸納

一份CS230課程知識(shí)點(diǎn)的歸納總結(jié),在Reddit上引發(fā)熱議

一份CS230課程知識(shí)點(diǎn)的歸納總結(jié),在Reddit上引發(fā)熱議

評(píng)論