本文將討論:循環神經網絡(Recurrent Neural Networks ,以下簡稱RNN),它廣泛的用于自然語言處理中的語音識別,手寫書別以及機器翻譯等領域。

1. RNN概述

在前面講到的DNN和CNN中,訓練樣本的輸入和輸出是比較的確定的。但是有一類問題DNN和CNN不好解決,就是訓練樣本輸入是連續的序列,且序列的長短不一,比如基于時間的序列:一段段連續的語音,一段段連續的手寫文字。這些序列比較長,且長度不一,比較難直接的拆分成一個個獨立的樣本來通過DNN/CNN進行訓練。

而對于這類問題,RNN則比較的擅長。那么RNN是怎么做到的呢?RNN假設我們的樣本是基于序列的。比如是從序列索引 1 到序列索引 T 的。對于這其中的任意序列索引號 t,它對應的輸入是對應的樣本序列中的 。而模型在序列索引號 t 位置的隱藏狀態

。而模型在序列索引號 t 位置的隱藏狀態 ,則由

,則由

共同決定。在任意序列索引號 t,我們也有對應的模型預測輸出

共同決定。在任意序列索引號 t,我們也有對應的模型預測輸出 。通過預測輸出

。通過預測輸出 和訓練序列真實輸出

和訓練序列真實輸出 ,以及損失函數

,以及損失函數 ,我們就可以用DNN類似的方法來訓練模型,接著用來預測測試序列中的一些位置的輸出。

,我們就可以用DNN類似的方法來訓練模型,接著用來預測測試序列中的一些位置的輸出。

下面我們來看看RNN的模型。

2. RNN模型

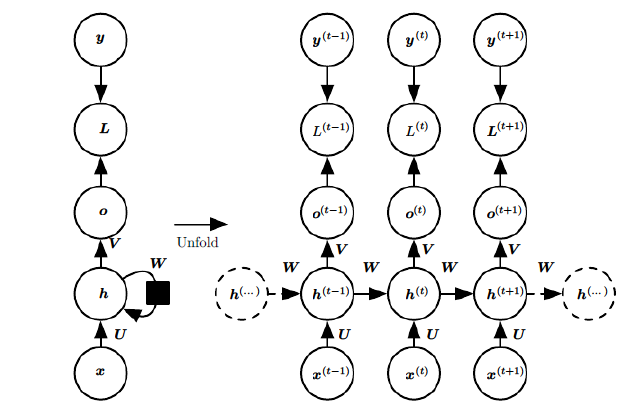

RNN模型有比較多的變種,這里介紹最主流的RNN模型結構如下:

上圖中左邊是RNN模型沒有按時間展開的圖,如果按時間序列展開,則是上圖中的右邊部分。我們重點觀察右邊部分的圖。

這幅圖描述了在序列索引號t附近RNN的模型。其中:

1)

和

和 代表在序列索引號 t?1 和 t+1 時訓練樣本的輸入。

代表在序列索引號 t?1 和 t+1 時訓練樣本的輸入。

2)

3)

4)

5) 代表在序列索引號 t 時訓練樣本序列的真實輸出。

代表在序列索引號 t 時訓練樣本序列的真實輸出。

6)U,W,V這三個矩陣是我們的模型的線性關系參數,它在整個RNN網絡中是共享的,這點和DNN很不相同。 也正因為是共享了,它體現了RNN的模型的“循環反饋”的思想。

3. RNN前向傳播算法

有了上面的模型,RNN的前向傳播算法就很容易得到了。

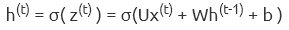

對于任意一個序列索引號t,我們隱藏狀態

其中 σ 為RNN的激活函數,一般為 tanh, b為線性關系的偏倚。

序列索引號 t 時模型的輸出

?+ c

?+ c

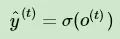

在最終在序列索引號 t 時我們的預測輸出為:

通常由于RNN是識別類的分類模型,所以上面這個激活函數一般是softmax。

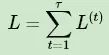

通過損失函數

4. RNN反向傳播算法推導

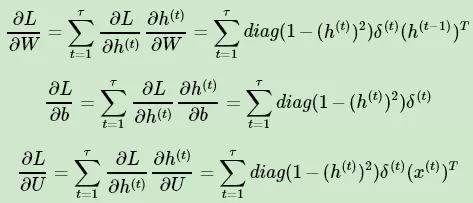

有了RNN前向傳播算法的基礎,就容易推導出RNN反向傳播算法的流程了。RNN反向傳播算法的思路和DNN是一樣的,即通過梯度下降法一輪輪的迭代,得到合適的RNN模型參數 U,W,V,b,c 。由于我們是基于時間反向傳播,所以RNN的反向傳播有時也叫做BPTT(back-propagation through time)。當然這里的BPTT和DNN也有很大的不同點,即這里所有的 U,W,V,b,c 在序列的各個位置是共享的,反向傳播時我們更新的是相同的參數。

為了簡化描述,這里的損失函數我們為交叉熵損失函數,輸出的激活函數為softmax函數,隱藏層的激活函數為tanh函數。

對于RNN,由于我們在序列的每個位置都有損失函數,因此最終的損失 L 為:

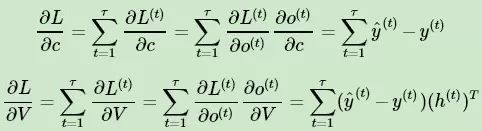

其中 V,c,的梯度計算是比較簡單的:

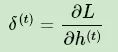

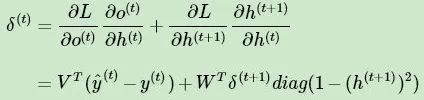

但是 W,U,b 的梯度計算就比較的復雜了。從RNN的模型可以看出,在反向傳播時,在在某一序列位置t的梯度損失由當前位置的輸出對應的梯度損失和序列索引位置 t+1 時的梯度損失兩部分共同決定。對于 W 在某一序列位置t的梯度損失需要反向傳播一步步的計算。我們定義序列索引 t 位置的隱藏狀態的梯度為:

這樣我們可以像DNN一樣從 遞推

遞推 ?。

?。

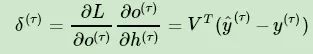

對于,由于它的后面沒有其他的序列索引了,因此有:

有了

除了梯度表達式不同,RNN的反向傳播算法和DNN區別不大,因此這里就不再重復總結了。

5. RNN小結

上面總結了通用的RNN模型和前向反向傳播算法。當然,有些RNN模型會有些不同,自然前向反向傳播的公式會有些不一樣,但是原理基本類似。

RNN雖然理論上可以很漂亮的解決序列數據的訓練,但是它也像DNN一樣有梯度消失時的問題,當序列很長的時候問題尤其嚴重。因此,上面的RNN模型一般不能直接用于應用領域。在語音識別,手寫書別以及機器翻譯等NLP領域實際應用比較廣泛的是基于RNN模型的一個特例LSTM,下一篇我們就來討論LSTM模型。

-

循環神經網絡

+關注

關注

0文章

38瀏覽量

3092

原文標題:循環神經網絡(RNN)模型與前向反向傳播算法

文章出處:【微信號:Imgtec,微信公眾號:Imagination Tech】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

循環神經網絡模型與前向反向傳播算法

循環神經網絡模型與前向反向傳播算法

評論