阿里近日正式開(kāi)源了輕量級(jí)深度學(xué)習(xí)端側(cè)推理引擎“MNN”。與 Tensorflow、Caffe2 等同時(shí)覆蓋訓(xùn)練和推理的通用框架相比,MNN 更注重在推理時(shí)的加速和優(yōu)化,在大規(guī)模機(jī)器學(xué)習(xí)應(yīng)用中具有優(yōu)勢(shì)。本文詳細(xì)闡述了MNN背后的技術(shù)框架和規(guī)劃。

近日,阿里正式開(kāi)源輕量級(jí)深度學(xué)習(xí)端側(cè)推理引擎“MNN”。

AI科學(xué)家賈揚(yáng)清如此評(píng)價(jià)道:

“與 Tensorflow、Caffe2 等同時(shí)覆蓋訓(xùn)練和推理的通用框架相比,MNN 更注重在推理時(shí)的加速和優(yōu)化,解決在模型部署的階段的效率問(wèn)題,從而在移動(dòng)端更高效地實(shí)現(xiàn)模型背后的業(yè)務(wù)。這和服務(wù)器端 TensorRT 等推理引擎的想法不謀而合。

在大規(guī)模機(jī)器學(xué)習(xí)應(yīng)用中,考慮到大規(guī)模的模型部署,機(jī)器學(xué)習(xí)的推理側(cè)計(jì)算量往往是訓(xùn)練側(cè)計(jì)算量的十倍以上,所以推理側(cè)的優(yōu)化尤其重要。”

MNN背后的技術(shù)框架如何設(shè)計(jì)?未來(lái)有哪些規(guī)劃?今天一起來(lái)深入了解。

開(kāi)源地址

https://github.com/alibaba/MNN

1、MNN 是什么?

MNN 是一個(gè)輕量級(jí)的深度學(xué)習(xí)端側(cè)推理引擎,核心解決深度神經(jīng)網(wǎng)絡(luò)模型在端側(cè)推理運(yùn)行問(wèn)題,涵蓋深度神經(jīng)網(wǎng)絡(luò)模型的優(yōu)化、轉(zhuǎn)換和推理。目前,MNN 已經(jīng)在手淘、手貓、優(yōu)酷、聚劃算、UC、飛豬、千牛等 20 多個(gè) App 中使用,覆蓋直播、短視頻、搜索推薦、商品圖像搜索、互動(dòng)營(yíng)銷(xiāo)、權(quán)益發(fā)放、安全風(fēng)控等場(chǎng)景,每天穩(wěn)定運(yùn)行上億次。此外,菜鳥(niǎo)自提柜等 IoT 設(shè)備中也有應(yīng)用。在2018 年雙十一購(gòu)物節(jié)中,MNN 在天貓晚會(huì)笑臉紅包、掃一掃明星猜拳大戰(zhàn)等場(chǎng)景中使用。

2、MNN 的優(yōu)勢(shì)

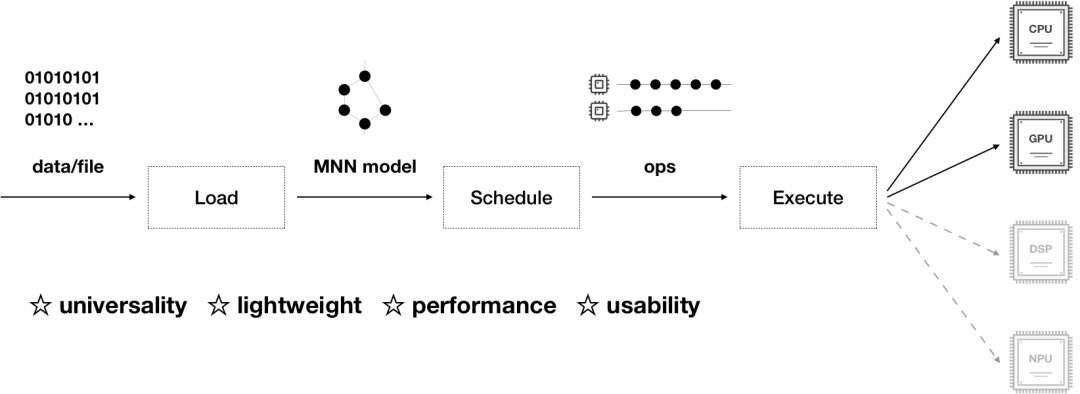

MNN 負(fù)責(zé)加載網(wǎng)絡(luò)模型,推理預(yù)測(cè)返回相關(guān)結(jié)果,整個(gè)推理過(guò)程可以分為模型的加載解析、計(jì)算圖的調(diào)度、在異構(gòu)后端上高效運(yùn)行。MNN 具有通用性、輕量性、高性能、易用性的特征:

通用性:

支持 Tensorflow、Caffe、ONNX 等主流模型格式,支持 CNN、RNN、GAN 等常用網(wǎng)絡(luò);

支持 86 個(gè) TensorflowOp、34 個(gè) CaffeOp ;各計(jì)算設(shè)備支持的 MNN Op 數(shù):CPU 71 個(gè),Metal 55 個(gè),OpenCL 40 個(gè),Vulkan 35 個(gè);

支持 iOS 8.0+、Android 4.3+ 和具有 POSIX 接口的嵌入式設(shè)備;

支持異構(gòu)設(shè)備混合計(jì)算,目前支持 CPU 和 GPU,可以動(dòng)態(tài)導(dǎo)入 GPU Op 插件,替代 CPU Op 的實(shí)現(xiàn);

輕量性:

針對(duì)端側(cè)設(shè)備特點(diǎn)深度定制和裁剪,無(wú)任何依賴(lài),可以方便地部署到移動(dòng)設(shè)備和各種嵌入式設(shè)備中;

iOS 平臺(tái)上,armv7+arm64 靜態(tài)庫(kù)大小 5MB 左右,鏈接生成可執(zhí)行文件增加大小 620KB 左右,metallib 文件 600KB 左右;

Android 平臺(tái)上,so 大小 400KB 左右,OpenCL 庫(kù) 400KB 左右,Vulkan 庫(kù) 400KB 左右;

高性能:

不依賴(lài)任何第三方計(jì)算庫(kù),依靠大量手寫(xiě)匯編實(shí)現(xiàn)核心運(yùn)算,充分發(fā)揮 ARM CPU 的算力;

iOS 設(shè)備上可以開(kāi)啟 GPU 加速(Metal),支持 iOS 8.0 以上版本,常用模型上快于蘋(píng)果原生的 CoreML;

Android 上提供了 OpenCL、Vulkan、OpenGL 三套方案,盡可能多地滿足設(shè)備需求,針對(duì)主流 GPU(Adreno 和 Mali)做了深度調(diào)優(yōu);

卷積、轉(zhuǎn)置卷積算法高效穩(wěn)定,對(duì)于任意形狀的卷積均能高效運(yùn)行,廣泛運(yùn)用了 Winograd 卷積算法,對(duì) 3x3 -> 7x7 之類(lèi)的對(duì)稱(chēng)卷積有高效的實(shí)現(xiàn);

針對(duì) ARM v8.2 的新架構(gòu)額外作了優(yōu)化,新設(shè)備可利用半精度計(jì)算的特性進(jìn)一步提速;

易用性:

完善的文檔和實(shí)例;

有高效的圖像處理模塊,覆蓋常見(jiàn)的形變、轉(zhuǎn)換等需求,一般情況下,無(wú)需額外引入 libyuv 或 opencv 庫(kù)處理圖像;

支持回調(diào)機(jī)制,方便提取數(shù)據(jù)或者控制運(yùn)行走向;

支持運(yùn)行網(wǎng)絡(luò)模型中的部分路徑,或者指定 CPU 和 GPU 間并行運(yùn)行;

3、MNN 核心介紹

3.1 模塊設(shè)計(jì)

如上圖所示,MNN 可以分為Converter和Interpreter兩部分。

Converter由Frontends和Graph Optimize構(gòu)成。前者負(fù)責(zé)支持不同的訓(xùn)練框架,MNN 當(dāng)前支持 Tensorflow (Lite)、Caffe 和 ONNX;后者通過(guò)算子融合、算子替代、布局調(diào)整等方式優(yōu)化圖。

Interpreter由Engine和Backends構(gòu)成。前者負(fù)責(zé)模型的加載、計(jì)算圖的調(diào)度;后者包含各計(jì)算設(shè)備下的內(nèi)存分配、Op 實(shí)現(xiàn)。在Engine和Backends中,MNN 應(yīng)用了多種優(yōu)化方案,包括在卷積和反卷積中應(yīng)用 Winograd 算法、在矩陣乘法中應(yīng)用 Strassen 算法、低精度計(jì)算、Neon 優(yōu)化、手寫(xiě)匯編、多線程優(yōu)化、內(nèi)存復(fù)用、異構(gòu)計(jì)算等。

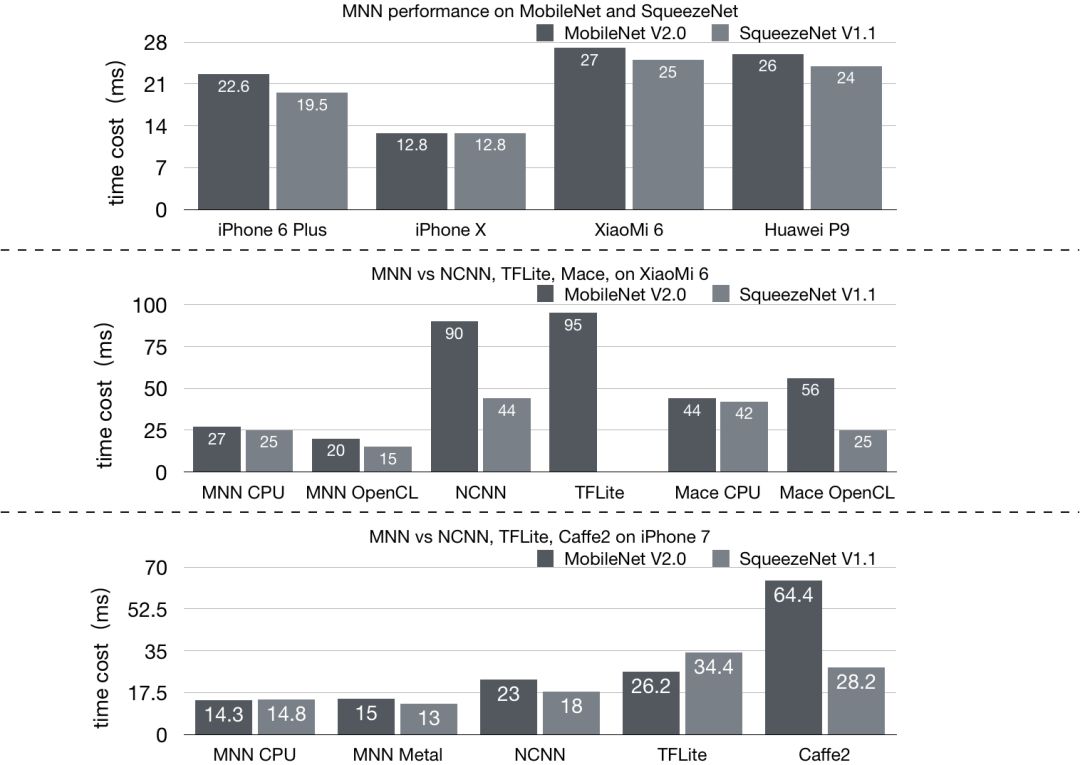

3.2 性能比較

采用業(yè)務(wù)常用的 MobileNet、SqueezeNet 和主流開(kāi)源框架進(jìn)行比較,結(jié)果如下圖:

MNN 相比于 NCNN、Mace、Tensorflow Lite、Caffe2 都有 20% 以上的優(yōu)勢(shì)。我們其實(shí)更加聚焦在內(nèi)部使用的業(yè)務(wù)模型優(yōu)化上,針對(duì)人臉檢測(cè)等模型進(jìn)行深入優(yōu)化,iPhone6 可以達(dá)到單幀檢測(cè) 5ms 左右。

注:Mace、Tensorflow Lite、Caffe2 均使用截止 2019 年 3 月 1 日 GitHub 代碼倉(cāng)庫(kù)的 master 分支;NCNN 由于編譯問(wèn)題采用20181228 Release 預(yù)編譯庫(kù)。

4、MNN 的開(kāi)源歷史

4.1 我們?yōu)槭裁匆龆藗?cè)推理

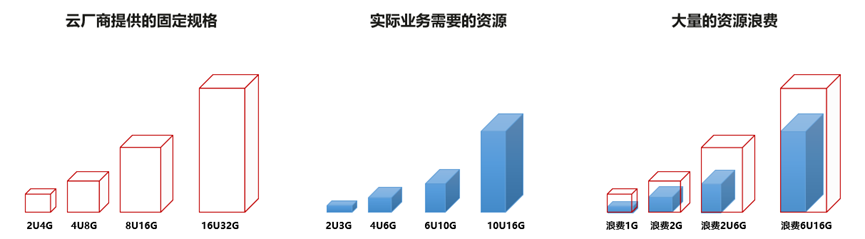

隨著手機(jī)算力的不斷提升,以及深度學(xué)習(xí)的快速發(fā)展,特別是小網(wǎng)絡(luò)模型不斷成熟,原本在云端執(zhí)行的推理預(yù)測(cè)就可以轉(zhuǎn)移到端上來(lái)做。端智能即在端側(cè)部署運(yùn)行 AI 算法,相比服務(wù)端智能,端智能具有低延時(shí)、兼顧數(shù)據(jù)隱私、節(jié)省云端資源等優(yōu)勢(shì)。目前端智能正逐漸變?yōu)橼厔?shì),從業(yè)界來(lái)看,它已經(jīng)在 AI 攝像、視覺(jué)特效等場(chǎng)景發(fā)揮了巨大價(jià)值。

手淘作為電商的超級(jí) App ,業(yè)務(wù)形態(tài)豐富,拍立淘、直播短視頻、互動(dòng)營(yíng)銷(xiāo)、試妝、個(gè)性化推薦搜索等業(yè)務(wù)場(chǎng)景都有端智能訴求,結(jié)合端智能能力,可以給用戶帶來(lái)新的交互體驗(yàn),助力業(yè)務(wù)創(chuàng)新突破。

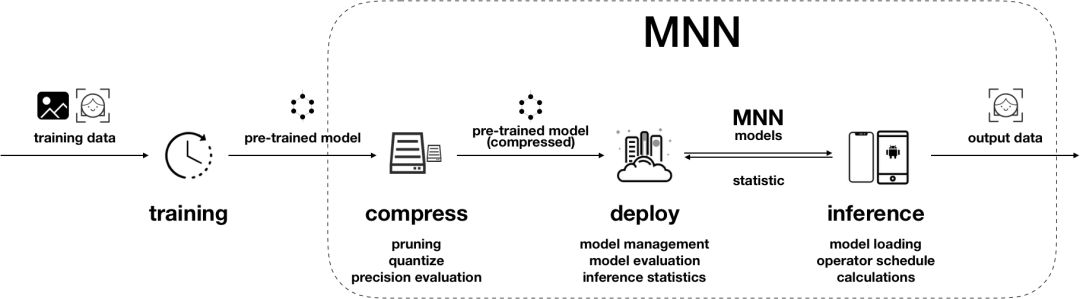

一般來(lái)說(shuō),端側(cè)深度學(xué)習(xí)的應(yīng)用可以分成如下幾個(gè)階段:

模型訓(xùn)練階段,主要解決模型訓(xùn)練,利用標(biāo)注數(shù)據(jù)訓(xùn)練出對(duì)應(yīng)的模型文件。面向端側(cè)設(shè)計(jì)模型時(shí),需要考慮模型大小和計(jì)算量;

模型壓縮階段,主要優(yōu)化模型大小,可以通過(guò)剪枝、量化等手段降低模型大小,以便在端上使用;

模型部署階段,主要實(shí)現(xiàn)模型部署,包括模型管理和部署、運(yùn)維監(jiān)控等;

端側(cè)推理階段,主要完成模型推理,即加載模型,完成推理相關(guān)的所有計(jì)算;

由上可知,端側(cè)推理引擎是端智能應(yīng)用的核心模塊,需要在有限算力、有限內(nèi)存等限制下,高效地利用資源,快速完成推理。可以說(shuō),端側(cè)推理引擎實(shí)現(xiàn)的優(yōu)劣,直接決定了算法模型能否在端側(cè)運(yùn)行,決定了業(yè)務(wù)能否上線。因此,我們需要一個(gè)端側(cè)推理引擎,一個(gè)優(yōu)秀的端側(cè)推理引擎。

4.2 我們?yōu)槭裁匆_(kāi)源 MNN

在 2017 年初,我們?cè)陂_(kāi)始引擎研發(fā)之前,重點(diǎn)調(diào)研了系統(tǒng)方案和開(kāi)源方案,從通用性、輕量性、高性能、安全性等方面深入分。CoreML 是 Apple 的系統(tǒng)框架,MLKit 和 NNAPI 是 Android 的系統(tǒng)框架,系統(tǒng)框架最大的優(yōu)勢(shì)是輕量性 —— 在包大小方面相對(duì)寬裕。而最大的劣勢(shì)是通用性,CoreML 需要 iOS 11+,MLKit 和 NNAPI 需要 Android 8.1+,可以覆蓋的機(jī)型非常有限,同時(shí)難以支持嵌入式設(shè)備的使用場(chǎng)景。此外,系統(tǒng)框架支持的網(wǎng)絡(luò)類(lèi)型、Op 類(lèi)型都較少,可拓展性又較差,還未能充分利用設(shè)備的算力,加之存在模型安全方面的問(wèn)題。綜上種種,系統(tǒng)框架不是一個(gè)很好的選擇。開(kāi)源方案中 Tensorflow Lite 宣而未發(fā),Caffe 較成熟但不是面向端側(cè)場(chǎng)景設(shè)計(jì)和開(kāi)發(fā)的,NCNN 則剛剛發(fā)布還不夠成熟。總的來(lái)說(shuō),我們找不到一套面向不同訓(xùn)練框架,不同部署環(huán)境,簡(jiǎn)單高效安全的端側(cè)推理引擎。

因此,我們希望提供面向不同業(yè)務(wù)算法場(chǎng)景,不同訓(xùn)練框架,不同部署環(huán)境的簡(jiǎn)單、高效、安全的端側(cè)推理引擎 MNN 。能夠抹平 Android 和 iOS 的差異,碎片設(shè)備之間的差異,不同訓(xùn)練框架的差異,實(shí)現(xiàn)快速的在端側(cè)部署運(yùn)行,并且能夠根據(jù)業(yè)務(wù)模型進(jìn)行 OP 靈活添加和 CPU/GPU 等異構(gòu)設(shè)備深入性能優(yōu)化。

隨著時(shí)間推移,NCNN、Tensorflow Lite、Mace、Anakin 等逐步升級(jí)和開(kāi)源,給與我們很好的輸入和借鑒。我們隨著業(yè)務(wù)需求也在不斷迭代和優(yōu)化,并且經(jīng)歷了雙十一考驗(yàn),已經(jīng)相對(duì)成熟和完善,所以開(kāi)源給社區(qū),希望給應(yīng)用和 IoT 開(kāi)發(fā)者貢獻(xiàn)我們的力量。

5、應(yīng)用場(chǎng)景

目前,MNN 已經(jīng)在手淘、貓客、優(yōu)酷、聚劃算、UC、飛豬、千牛等 20 + 集團(tuán) App 中集成,在拍立淘、直播短視頻、互動(dòng)營(yíng)銷(xiāo)、實(shí)人認(rèn)證、試妝、搜索推薦等場(chǎng)景使用,每天穩(wěn)定運(yùn)行上億次。2018 年雙十一購(gòu)物節(jié)中,MNN 也在貓晚笑臉紅包、掃一掃明星猜拳大戰(zhàn)等場(chǎng)景中使用。

拍立淘是在手淘里面的一個(gè)圖像搜索和識(shí)別產(chǎn)品,從 14 年首次上線經(jīng)過(guò)不斷迭代發(fā)展目前已經(jīng)成長(zhǎng)為 UV 超過(guò)千萬(wàn)的應(yīng)用。其中的技術(shù)也在不斷迭代更新,從最早的拍照上傳圖片云端識(shí)別,演進(jìn)到目前在端上做物體識(shí)別和摳圖再上傳云端識(shí)別,有效的提升了用戶體驗(yàn)同時(shí)節(jié)省了服務(wù)端計(jì)算成本。針對(duì)一些簡(jiǎn)單的物體分類(lèi)萬(wàn)物識(shí)別和 logo 識(shí)別,目前也已經(jīng)支持直接通過(guò)端上的模型進(jìn)行實(shí)時(shí)識(shí)別。

笑臉紅包是 18 年雙十一貓晚開(kāi)場(chǎng)的第一個(gè)節(jié)目,這個(gè)玩法是基于實(shí)時(shí)人臉檢測(cè)和表情識(shí)別能力做的,相比之前各種通過(guò)屏幕觸控的交互玩法,這個(gè)活動(dòng)通過(guò)攝像頭實(shí)時(shí)人臉檢測(cè)算法實(shí)現(xiàn)從傳統(tǒng)觸控交互玩法到自然交互玩法的跨越,給用戶帶來(lái)新的用戶體驗(yàn)。

集五福是 19 年春節(jié)的活動(dòng),也是手淘第一次通過(guò)掃年貨的方式加入到這個(gè)活動(dòng)中來(lái)。通過(guò)掃一掃商品識(shí)別能力,識(shí)別紅色年貨,除了福卡之外,還能得到羽絨被、五糧液、茅臺(tái)、帝王蟹等實(shí)物大獎(jiǎng)和貓超、天貓精靈等無(wú)門(mén)檻優(yōu)惠券,讓家里的年貨變成下金蛋的 “母雞”。

6、Roadmap

我們計(jì)劃每?jī)蓚€(gè)月 Release 一個(gè)穩(wěn)定版本。當(dāng)前規(guī)劃如下:

模型優(yōu)化方面

完善 Converter 圖優(yōu)化

完善對(duì)量化的支持,增加對(duì)稀疏的支持

調(diào)度優(yōu)化方面

增加模型 flops 統(tǒng)計(jì)

針對(duì)設(shè)備硬件特性動(dòng)態(tài)調(diào)度運(yùn)行策略

計(jì)算優(yōu)化

現(xiàn)有 Backend 持續(xù)優(yōu)化(CPU/OpenGL/OpenCL/Vulkan/Metal)

優(yōu)化 Arm v8.2 Backend,支持量化模型

使用 NNAPI,增加 NPU Backend

應(yīng)用快速矩陣乘法、Winograd 算法優(yōu)化性能

其他

文檔和示例

完善 test、benchmark 相關(guān)工具

支持更多 Op

-

開(kāi)源

+關(guān)注

關(guān)注

3文章

3659瀏覽量

43731 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5558瀏覽量

122700 -

阿里

+關(guān)注

關(guān)注

6文章

454瀏覽量

33288

原文標(biāo)題:賈揚(yáng)清推薦:阿里開(kāi)源輕量級(jí)深度學(xué)習(xí)框架 MNN,側(cè)重推理加速和優(yōu)化

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

大模型推理顯存和計(jì)算量估計(jì)方法研究

首創(chuàng)開(kāi)源架構(gòu),天璣AI開(kāi)發(fā)套件讓端側(cè)AI模型接入得心應(yīng)手

從零復(fù)現(xiàn),全面開(kāi)源:360 Light-R1-14B/7B帶來(lái)端側(cè)AI平權(quán)時(shí)刻

Arm與阿里巴巴合作加速端側(cè)多模態(tài)AI體驗(yàn)

廣和通Fibocom AI Stack:加速端側(cè)AI部署新紀(jì)元

廣和通發(fā)布Fibocom AI Stack,助力客戶快速實(shí)現(xiàn)跨平臺(tái)跨系統(tǒng)的端側(cè)AI部署

華為Flexus云服務(wù)器搭建SamWaf開(kāi)源輕量級(jí)網(wǎng)站防火墻

阿里云發(fā)布開(kāi)源多模態(tài)推理模型QVQ-72B-Preview

阿里云開(kāi)源推理大模型QwQ

國(guó)產(chǎn)芯上運(yùn)行TinyMaxi輕量級(jí)的神經(jīng)網(wǎng)絡(luò)推理庫(kù)-米爾基于芯馳D9國(guó)產(chǎn)商顯板

國(guó)產(chǎn)芯上運(yùn)行TinyMaxi輕量級(jí)的神經(jīng)網(wǎng)絡(luò)推理庫(kù)-米爾基于芯馳D9國(guó)產(chǎn)商顯板

深度學(xué)習(xí)編譯器和推理引擎的區(qū)別

鴻蒙語(yǔ)言基礎(chǔ)類(lèi)庫(kù):ohos.data.storage 輕量級(jí)存儲(chǔ)

國(guó)產(chǎn)芯上運(yùn)行TinyMaxi輕量級(jí)的神經(jīng)網(wǎng)絡(luò)推理庫(kù)-米爾基于芯馳D9國(guó)產(chǎn)商顯板

阿里正式開(kāi)源輕量級(jí)深度學(xué)習(xí)端側(cè)推理引擎“MNN”

阿里正式開(kāi)源輕量級(jí)深度學(xué)習(xí)端側(cè)推理引擎“MNN”

評(píng)論