對于視覺識別中的區域層次和像素層次問題,分類網絡(如ResNet、VGGNet等)學到的表征分辨率比較低,在此基礎上恢復的高分辨率表征空間區分度仍然不夠強,使其在對空間精度敏感的任務上很難取得準確的預測結果。為此,微軟亞洲研究院視覺計算組提出高分辨率深度神經網絡(HRNet),對網絡結構做了基礎性的改變,由傳統的串行連接高低分辨率卷積,改成并行連接高低分辨率卷積,通過全程保持高分辨率和對高低分辨率表征的多次信息交換來學到豐富的高分辨率表征,在多個數據集的人體姿態估計任務中取得了最佳的性能。

前言

視覺識別主要包括三大類問題:圖像層次(圖像分類),區域層次(目標檢測)和像素層次(比如圖像分割、人體姿態估計和人臉對齊等)。最近幾年,用于圖像分類的卷積神經網絡成為解決視覺識別問題的標準結構,比如圖1所示的LeNet-5。這類網絡的特點是學到的表征在空間分辨率上逐漸變小。我們認為分類網絡并不適合區域層次和像素層次的問題,因為學到的表征本質上具有低分辨率的特點,在分辨率上的巨大損失使得其在對空間精度敏感的任務上很難取得準確的預測結果。

圖1. 典型的卷積神經網絡:LeNet-5。其它典型的卷積神經網絡,如AlexNet、VGGNet、GoogleNet、ResNet、DenseNet等,表征的空間分辨率均從大逐漸變小。

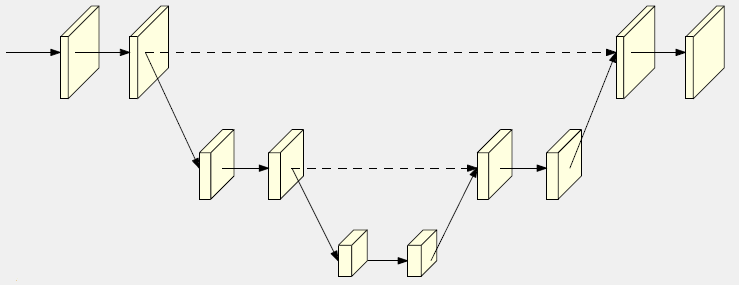

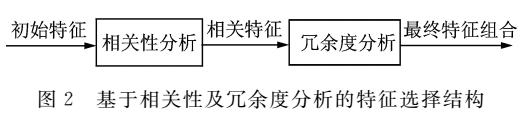

為了彌補空間精度的損失,研究者們在分類卷積神經網絡結構的基礎上,通過引入上采樣操作和/或組合空洞卷積減少降采樣次數來提升表征的分辨率,典型的結構包括Hourglass、U-Net等(如圖2)。

在這類網絡結構中,最終的高分辨表征主要來源于兩個部分:第一是原本的高分辨率表征,但是由于只經過了少量的卷積操作,其本身只能提供低層次的語義表達;第二是低分辨率表征通過上采樣得到的高分辨率表征,其本身雖然擁有很好的語義表達能力,但是上采樣本身并不能完整地彌補空間分辨率的損失。所以,最終輸出的高分辨率表征所具有的空間敏感度并不高,很大程度上受限于語義表達力強的表征所對應的分辨率。

圖2. 從低分辨率表征恢復高分辨率表征

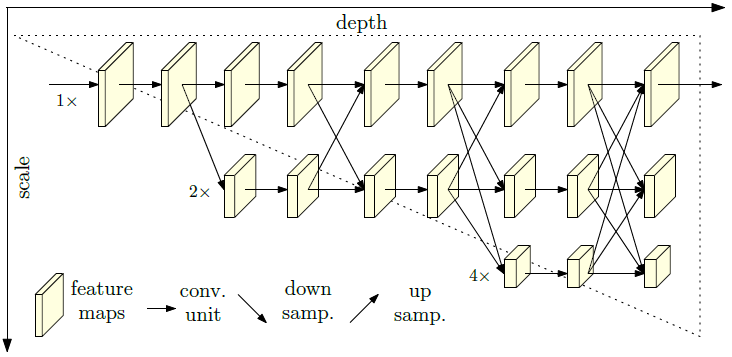

我們認為不應該局限于從分類卷積神經網絡生成的低分辨率表征來恢復高分辨率表征這一路線,而應該為高分辨率表征學習建立新的網絡結構。基于此,我們提出了高分辨率深度神經網絡(High-Resolution Network,HRNet),在網絡整個過程中始終保持高分辨率表征,同時多次在高低分辨率表征之間進行信息交換,從而學到足夠豐富的高分辨率表征。

實驗證明HRNet在人體姿態估計,以及圖像分割、人臉對齊和目標檢測等問題上取得了不錯的結果。我們相信HRNet將取代分類深度神經網絡成為計算機視覺識別等應用的新的標準結構。關于人體姿態估計的論文已發表在CVPR 2019 [1],相關代碼已在GitHub上開源[2, 3]。

GitHub鏈接:

https://github.com/HRNet

高分辨率網絡

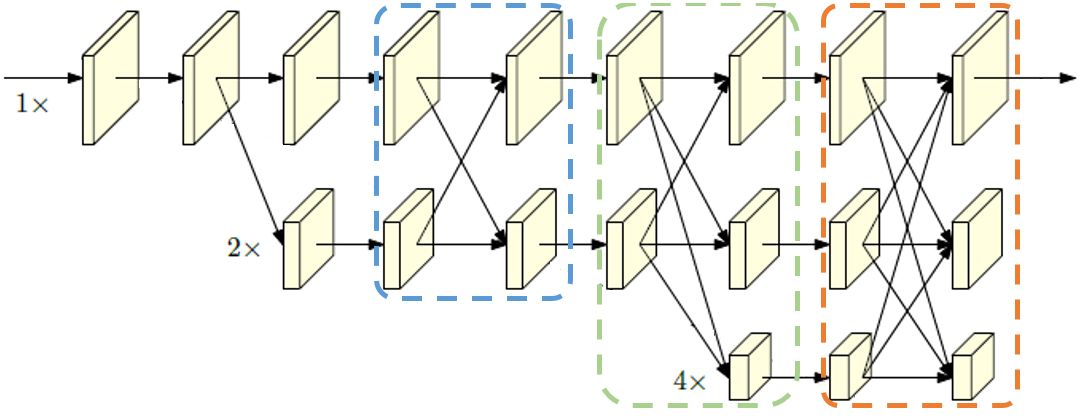

我們在HRNet的整個網絡中始終保持高分辨率表征,逐步引入低分辨率卷積,并且將不同分辨率的卷積并行連接。同時,我們通過不斷在多分辨率表征之間進行信息交換,來提升高分辨率和低分辨率表征的表達能力,讓多分辨率表征之間更好地相互促進,結構如圖3所示。HRNet與先前的分類卷積神經網絡有著基礎性的區別:先前的分類將分辨率從高到低的卷積串行連接,HRNet則是并行連接。

圖3. 高分辨率網絡 (High-Resolution Network,HRNet)

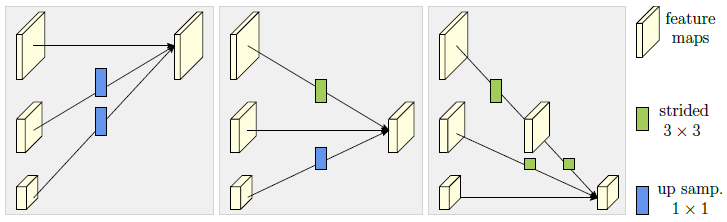

關于多分辨率表征信息交換,這里以三個分辨率輸入和三個分辨率輸出為例,如圖4所示。每一個分辨率的輸出表征都會融合三個分辨率輸入的表征,以保證信息的充分利用和交互。將高分辨率特征降到低分辨率特征時,我們采用stride為2的3x3卷積;低分辨率特征到高分辨率特征時,先利用1x1卷積進行通道數的匹配,再利用最近鄰插值的方式來提高分辨率。相同分辨率的表征則采用恒等映射的形式。

圖4. 多分辨率表征信息交換

實驗

HRNet保持高分辨率表征,利用重復的多分辨率表征信息交換增強其表達能力,使模型所學的表征在空間精度上有顯著的提升。實驗中,我們首先在MS COCO數據集中的關鍵點檢測任務上進行了消融實驗,驗證了表征分辨率的重要性和重復的多分辨率表征信息交換的有效性;然后在MS COCO、PoseTrack等標準數據集中與最先進的方法進行公平對比,都取得了更好的性能。

1. 表征分辨率對性能的影響

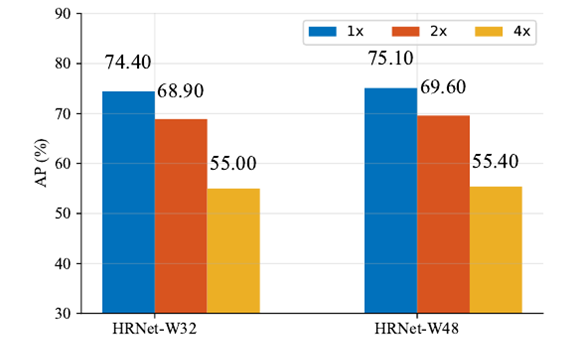

HRNet可輸出4種分辨率的表征(1x、2x、4x、以及8x),我們針對不同的網絡輸出分辨率在兩組模型上做了對比實驗,如圖5所示。

圖5. 網絡輸出分辨率對結果的影響,1x、2x和4x分辨率表征在人體姿態估計的性能。

從圖5中,我們可以清楚地看到,網絡輸出表征的分辨率降低會使得模型的性能有巨大的損失。分辨率在2x時,性能降低了接近6% AP,4x時降低了20% AP。這體現了表征分辨率對于空間精度的重要性。

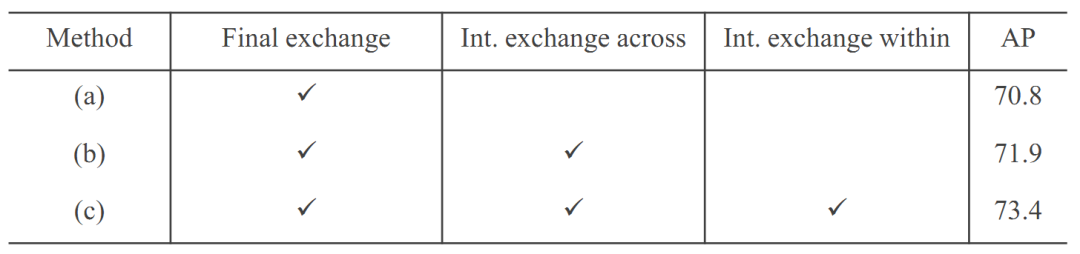

2. 多分辨率表征信息交換對性能的影響

圖6. 藍色框內為階段內的多分辨率表征信息交換(Int. exchange within),綠色框為階段間的多分辨率表征信息交換(Int. exchange across),紅色框為最終的多分辨率表征信息交換(Final exchange)。

表1. 多尺度特征融合對性能的影響,實驗中每個網絡是從隨機初始化開始訓練的。

我們考慮了三種信息交換(如圖6),結果如表1。可以看到,多分辨率表征信息交換可以將不同分辨率的表征信息進行充分的交換利用,對表征增強的作用十分明顯,可以到達2.6% AP的提升。

3. 在標準數據集上的性能

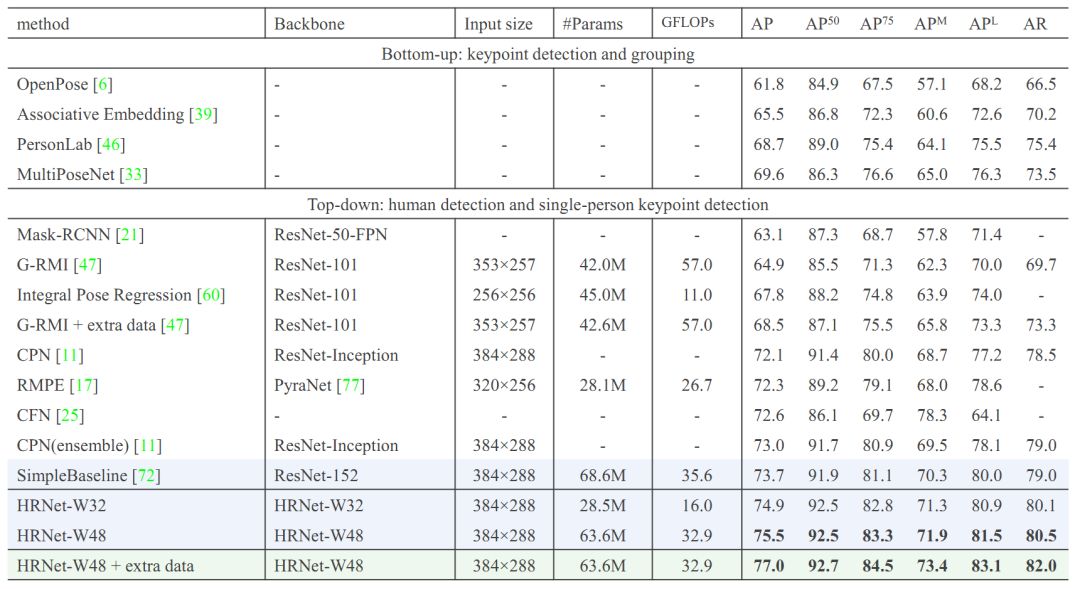

MS COCO數據集是關鍵點檢測的最權威的數據集之一,我們在該數據上對我們的方法進行驗證,結果如表2所示。

表2. COCO test-dev上與最先進方法的性能比較

我們可以看到,在相同的輸入圖像大小下,我們的小模型HRNet-W32在參數量和計算量都小于SimpleBaseline(ResNet-152)一半的情況下,取得了1.2% AP的提高,而大模型HRNet-W48取得了1.8% AP的提升,在引入額外數據的情況下,大模型展現了更強的表達能力,有更顯著的提升。

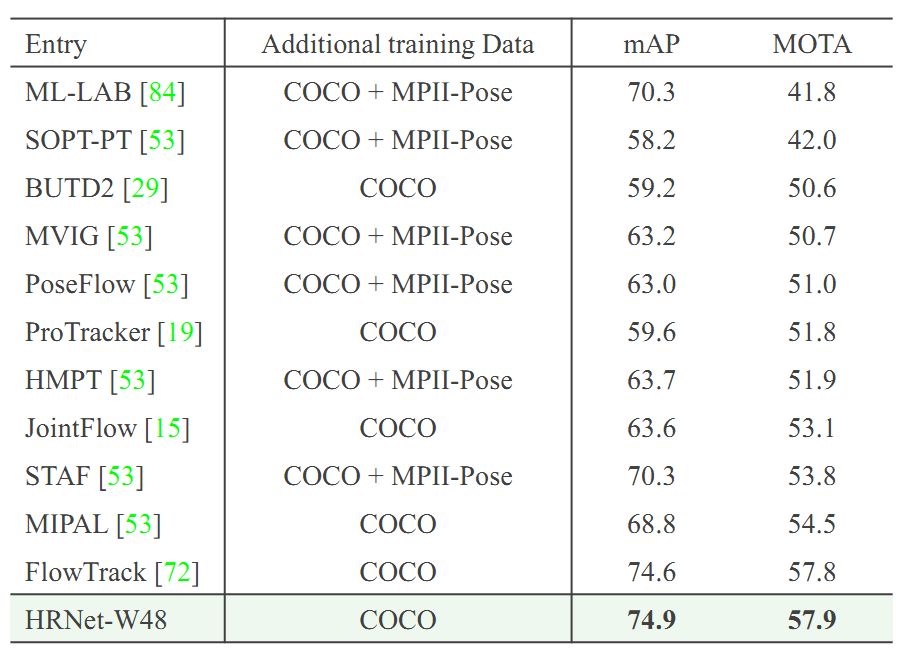

表3. 在Pose-Track數據集上與最先進方法的性能比較

在表3中,我們在Pose-Track數據集的兩個任務上進行了驗證:(1)多幀人體姿態估計,可以利用其他幀的信息估計某幀的姿態;(2)多幀人體姿態跟蹤,需要把不同幀間的同一個人的姿態關聯起來。前者性能用mAP來評價,后者性能用MOTA來評價。可以看到在兩個任務上,我們都取得了最好的性能。

結語

我們改變了現有的基于分類網絡的人體姿態估計的網絡結構,提出了高分辨率深度神經網絡(HRNet)。該網絡能夠成功學到足夠豐富的高分辨率表征的原因在于,整個過程保持高分辨率,以及多次對高低分辨率表征進行信息補足。HRNet在多個數據集的人體姿態估計任務中取得了當前最好的性能,也在圖像分割、人臉對齊和目標檢測等問題上取得了不錯的結果。我們相信HRNet將取代以分類網絡為基礎的網絡架構,成為計算機視覺識別等應用的新標準結構。

-

微軟

+關注

關注

4文章

6673瀏覽量

105372 -

神經網絡

+關注

關注

42文章

4807瀏覽量

102792 -

視覺識別

+關注

關注

3文章

102瀏覽量

16976

原文標題:告別低分辨率網絡,微軟提出高分辨率深度神經網絡HRNet | CVPR 2019

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

【AD新聞】中國深圳先進院在高分辨率超聲成像領域取得重要進展

從AlexNet到MobileNet,帶你入門深度神經網絡

增強高分辨率圖像捕獲的選擇

康耐視兩款高分辨率Checker視覺傳感器

如何在基于機器視覺的應用中通過單線傳輸高分辨率視頻數據

數據外補償的深度網絡超分辨率重建

高分辨率遙感圖像飛機目標檢測

微軟亞洲研究院視覺計算組提出高分辨率深度神經網絡

微軟亞洲研究院視覺計算組提出高分辨率深度神經網絡

評論