摸一摸就知道長什么樣、看一看就知道摸著是什么感覺,你以為我說的是人?不,是AI。MIT研究人員開發(fā)出一種具有預(yù)測性人工智能的機(jī)器人,它可以通過觸摸來學(xué)習(xí)“看”,通過“看”來學(xué)習(xí)感覺,李昀燭和朱俊彥這兩位大神參與了此項(xiàng)研究。

我們?nèi)祟惪梢酝ㄟ^簡單地觸摸來輕松地判斷物體的外形,這完全歸功于我們的觸覺,它使我們具備了這種能力。此外,我們當(dāng)然也可以通過觀察物體來確定它的感受。

但做同樣的事情對于機(jī)器來說可能是困難的,這也是一個(gè)巨大的挑戰(zhàn)。即使是被編程有感官的機(jī)器人也無法做到這一點(diǎn),它們不能把這些觸覺信號互換使用。

現(xiàn)在,麻省理工學(xué)院計(jì)算機(jī)科學(xué)與人工智能實(shí)驗(yàn)室(CSAIL)的研究人員已經(jīng)開發(fā)出一種具有預(yù)測性人工智能(AI)的機(jī)器人,它可以通過觸摸來學(xué)習(xí)“看”,通過“看”來學(xué)習(xí)感覺。

強(qiáng)強(qiáng)聯(lián)合,必出精品

在細(xì)講這篇論文之前,先來給大家隆重介紹一下這個(gè)研究團(tuán)隊(duì)——均來自MIT CSAIL,一作是MIT CSAIL博士、曾經(jīng)的北大學(xué)神李昀燭,二作是即將在CMU擔(dān)任助理教授、曾經(jīng)的清華學(xué)神朱俊彥。

李昀燭

李昀燭是CSAIL的二年級博士生,他的研究領(lǐng)域是計(jì)算機(jī)視覺、機(jī)器學(xué)習(xí)和機(jī)器人技術(shù),尤其是基于深度學(xué)習(xí)的機(jī)器人動(dòng)力學(xué)建模和多模態(tài)感知。他本科畢業(yè)于北京大學(xué),本科期間參加北京大學(xué)和斯坦福大學(xué)的多個(gè)實(shí)驗(yàn)室研究,并以第一作者身份發(fā)表多篇計(jì)算機(jī)視覺和機(jī)器學(xué)習(xí)頂級會(huì)議論文。

朱俊彥

朱俊彥目前是CSAIL的一名博士后研究員,他將于2020年秋季回到CMU擔(dān)任助理教授。朱俊彥主要從事計(jì)算機(jī)視覺、計(jì)算機(jī)圖形和機(jī)器學(xué)習(xí)的研究。他畢業(yè)于加州大學(xué)伯克利分校,2012 年獲得清華大學(xué)計(jì)算機(jī)科學(xué)系的工學(xué)學(xué)士學(xué)位,在 CMU 和 UC Berkeley 經(jīng)過 5 年學(xué)習(xí)后,于 2017 年獲得 UC Berkeley 電氣工程與計(jì)算機(jī)科學(xué)系的博士學(xué)位。(參見:【AI新星耀名校】陳天奇、朱俊彥、金馳加盟CMU、普林斯頓)

李昀燭和朱俊彥曾經(jīng)合作多次,最近最近爆火的MIT十美元“滅霸”手套也是二人合作完成的。這次又強(qiáng)強(qiáng)聯(lián)合,會(huì)出怎樣的精品呢?接下來看看這項(xiàng)新研究。

這項(xiàng)研究做了什么?

研究團(tuán)隊(duì)使用KUKA機(jī)器人手臂并添加了一個(gè)名為GelSight的特殊觸覺傳感器,該傳感器之前由Edward Adelson領(lǐng)導(dǎo)的另一個(gè)麻省理工學(xué)院小組設(shè)計(jì)。

圖1.數(shù)據(jù)采集裝置:(a)他們使用一個(gè)裝備了GelSight傳感器的機(jī)器人手臂來收集觸覺數(shù)據(jù),并使用網(wǎng)絡(luò)攝像頭來捕捉對象交互場景的視頻。(b)凝膠接觸物體的圖示。交叉模式預(yù)測:在收集到的視覺觸覺對的基礎(chǔ)上,他們?yōu)閹讉€(gè)任務(wù)訓(xùn)練了交叉模式預(yù)測網(wǎng)絡(luò):(c)通過視覺學(xué)習(xí)感知(視覺→觸摸):從相應(yīng)的視覺輸入和參考圖像預(yù)測觸摸信號;(d)通過觸摸來學(xué)習(xí)看(觸摸→視覺):通過觸摸預(yù)測視覺。預(yù)測的觸摸位置和ground truth位置(用(d)中的黃色箭頭標(biāo)記)具有相似的感覺。

GelSight是一塊透明的合成橡膠板,其一面涂有油漆,含有微小的金屬斑點(diǎn)。在另一側(cè),安裝攝像頭。該團(tuán)隊(duì)使用網(wǎng)絡(luò)攝像頭記錄了近12000個(gè)被觸摸的200件物品的視頻,包括工具、家用產(chǎn)品、織物等。

圖2.物品集。這里他們展示了訓(xùn)練和測試中使用的物品集,包含了食品、工具、廚房用品、織物和文具等各種各樣的物品。

然后,研究人員將這些視頻分解為靜態(tài)幀并編制了“VisGel”,這是一個(gè)包含超過300萬個(gè)視覺/觸覺配對圖像的數(shù)據(jù)集。這些參考圖像隨后幫助機(jī)器人對物品和環(huán)境的細(xì)節(jié)進(jìn)行編碼。

“通過觀察場景,我們的模型可以想象觸摸平坦表面或鋒利邊緣的感覺,” 李昀燭說:“僅通過觸摸,我們的模型可以單純從觸覺中預(yù)測與環(huán)境的相互作用。將這兩種感官結(jié)合在一起,可以增強(qiáng)機(jī)器人的能力并減少我們在涉及操縱和抓取物體的任務(wù)時(shí)可能需要的數(shù)據(jù)。”

視覺和觸覺演示

視覺到觸覺(綠色:Ground Truth;紅色:預(yù)測)

觸覺到視覺(綠色:Ground Truth;紅色:預(yù)測)

現(xiàn)在,機(jī)器人只能識別受控環(huán)境中的物體。然而,一些細(xì)節(jié),如物體的顏色和柔軟度,對于新的AI系統(tǒng)得出結(jié)論仍然是個(gè)挑戰(zhàn)。盡管如此,研究人員希望這種新方法能夠?yàn)橹圃飙h(huán)境中的“人-機(jī)器人”無縫結(jié)合鋪平道路,尤其是在缺乏視覺數(shù)據(jù)的任務(wù)中。

該團(tuán)隊(duì)新AI系統(tǒng)的下一步是通過收集更多非結(jié)構(gòu)化區(qū)域中的數(shù)據(jù)或使用MIT新設(shè)計(jì)的傳感器手套來構(gòu)建更大的數(shù)據(jù)集,以便機(jī)器人可以在更多樣化的環(huán)境中工作。

“這是第一種可以令人信服地在視覺和觸摸信號之間進(jìn)行轉(zhuǎn)換的方法,”加州大學(xué)伯克利分校的博士后Andrew Owens說:“像這樣的方法有可能對機(jī)器人技術(shù)非常有用,你需要回答諸如'這個(gè)物體是硬還是軟?'之類的問題,或者'如果我通過杯柄舉起這個(gè)杯子,我的握力有多好?'這是一個(gè)非常具有挑戰(zhàn)性的問題,因?yàn)樾盘柺侨绱瞬煌疫@個(gè)模型已經(jīng)證明了它的強(qiáng)大能力。”

該論文會(huì)在加利福尼亞州長灘舉行的CVPR上發(fā)表,接下來和大家分享一下這篇論文。

使用跨模態(tài)預(yù)測方法

研究人員提出了一種從觸覺預(yù)測視覺的跨模態(tài)預(yù)測方法,反之亦然。首先,他們將觸摸的規(guī)模和位置合并到他們的模型中。然后,使用數(shù)據(jù)再平衡機(jī)制來增加結(jié)果的多樣性。最后,通過從附近的輸入幀中提取時(shí)間信息,進(jìn)一步提高了結(jié)果的時(shí)間一致性和準(zhǔn)確性。

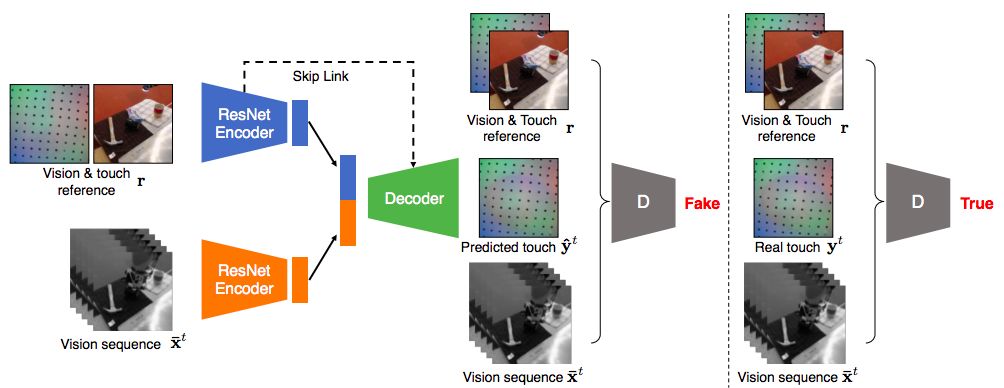

圖3.跨模態(tài)預(yù)測模型概述:視覺→觸摸模式。

圖3顯示了一個(gè)示例輸入輸出組合,其中網(wǎng)絡(luò)將一系列視覺圖像和相應(yīng)的參考作為輸入,并將觸覺預(yù)測合成為輸出。同樣的框架也可以應(yīng)用于觸摸→視覺。

實(shí)驗(yàn)介紹

研究人員使用VisGel數(shù)據(jù)集對視覺和觸覺之間的跨模態(tài)預(yù)測任務(wù)的方法進(jìn)行了評估。他們報(bào)告了評估預(yù)測不同方面的多個(gè)指標(biāo)。

對于視覺→觸覺預(yù)測,測量

(1)使用AMT的感知現(xiàn)實(shí)性:結(jié)果是否真實(shí),

(2)接觸時(shí)刻:模型能否預(yù)測GelSight傳感器是否與物體接觸,

(3)標(biāo)記物的變形:模型是否能夠跟蹤膜的變形。

對于觸摸→視覺方向,他們使用

(1)通過AMT的視覺真實(shí)性和

(2)觸摸感來評估他們的模型:預(yù)測的觸摸位置是否與ground truth位置具有相似的感覺。他們還將有關(guān)完整參考指標(biāo)的評估納入補(bǔ)充資料,并向所有基線提供參考圖像,因?yàn)樗鼈儗τ谔幚肀壤町愔陵P(guān)重要(圖4)。

圖4.使用參考圖像。使用/不使用參考圖像的方法的定性結(jié)果。他們用參考圖像訓(xùn)練的模型產(chǎn)生了更具視覺吸引力的圖像。

圖5.跨模態(tài)預(yù)測結(jié)果示例。(a)和(b)顯示了他們的模型和基線的視覺→觸摸預(yù)測的兩個(gè)例子。(c)和(d)顯示觸摸→視覺方向。 在這兩種情況下,他們的結(jié)果看起來既真實(shí)又在視覺上類似于ground truth 目標(biāo)圖像。在(c)和(d)中,他們的模型在沒有g(shù)round truth 位置標(biāo)注的情況下進(jìn)行訓(xùn)練,可以準(zhǔn)確地預(yù)測觸摸位置,與完全監(jiān)督的預(yù)測方法相當(dāng)。

圖6.Vision2Touch定量結(jié)果。上圖:檢測觸摸了物體表面的錯(cuò)誤。使用時(shí)間提示可以顯著提高性能或他們的模型。下圖:根據(jù)圖像還原觸覺點(diǎn)位置的失真錯(cuò)誤情況。他們的方法仍然有效。

圖7.Vision2Touch檢測接觸時(shí)刻。顯示了標(biāo)記隨時(shí)間的變形,由所有黑色標(biāo)記的平均移動(dòng)決定。較高的變形意味著物體與較大的力接觸。上圖:三種典型案例,其中(a)所有方法都可以推斷出接觸時(shí)刻,(b)沒有時(shí)間線索的方法無法捕捉接觸時(shí)刻,(c)沒有時(shí)間線索的方法會(huì)產(chǎn)生錯(cuò)位結(jié)果。下圖:我們展示了案例(c)中的幾個(gè)視覺和觸摸框架。 我們的模型具有時(shí)間線索可以更準(zhǔn)確地預(yù)測GelSight的變形。標(biāo)記的運(yùn)動(dòng)為紅色顯示以獲得更好的可視化效果。

表2.Vision2Touch AMT “真實(shí)vs虛假”測試。與pix2pix和基線相比,他們的方法可以合成更逼真的觸覺信號,既適用于已知物品,也適用于未知物品。

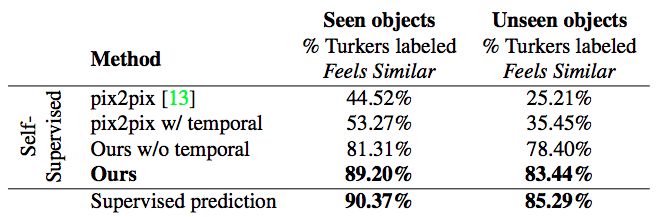

表3. Touch2Vision“感覺相似vs感覺不同”測試。他們的自我監(jiān)督方法明顯優(yōu)于基線。其精度可與用ground truth 標(biāo)注訓(xùn)練的完全監(jiān)督預(yù)測方法相媲美。

表4. Touch2Vision AMT“真實(shí)vs虛假”測試。 盡管pix2pix在看不見的對象中獲得了最高分,但由于mode collapse,它總是產(chǎn)生相同的圖像。

討論

在這項(xiàng)研究中,研究團(tuán)隊(duì)提出用條件對抗網(wǎng)絡(luò)在視覺和觸覺之間建立聯(lián)系。在與世界互動(dòng)時(shí),人類嚴(yán)重依賴于兩種感官模式。他們的模型可以為已知對象和未知對象提供有希望的跨模態(tài)預(yù)測結(jié)果。在未來,視覺-觸覺交叉模式連接可以幫助下游視覺和機(jī)器人應(yīng)用,例如在弱光環(huán)境中的物體識別和抓取,以及物理場景理解。

-

傳感器

+關(guān)注

關(guān)注

2554文章

51582瀏覽量

757832 -

機(jī)器人

+關(guān)注

關(guān)注

211文章

28809瀏覽量

209184 -

人工智能

+關(guān)注

關(guān)注

1799文章

47965瀏覽量

241311

原文標(biāo)題:觸感隔空看到,MIT“滅霸手套”作者李昀燭、朱俊彥又一重磅研究

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

MIT研究人員開發(fā)出一種具有預(yù)測性人工智能的機(jī)器人

MIT研究人員開發(fā)出一種具有預(yù)測性人工智能的機(jī)器人

評論