還記得權力的游戲第八季么? Jon Snow也加入了千萬罵編劇的粉絲的陣營,并且因此向粉絲道歉。

這個視頻當然是假的,他嘴巴的移動方式看起來就很奇怪。

這是一個DeepFake生成的視頻,一個用來娛樂或欺騙大眾人工智能產物。

之前文摘菌也報道過,這項技術的上線后就廣受詬病,后來又有一個小團隊開發出一款新的應用DeepNude,可以一鍵實現脫衣,之后也因為反響惡劣而被迫下架。

人們對于無法分辨真假的恐懼是合理的,畢竟這種技術的出現將會滋生出許多想象不到的新的犯罪手段的誕生。

最近,南加州大學信息科學研究所計算機的研究人員發表一篇論文,研究通過訓練AI尋找視頻畫面中的不一致性來檢測AI生成的假視頻,論文同時也被提交到CVPR 2019。

用AI對抗AI,來看看如何實現

對于偽造生成的假視頻,研究人員發現,用于生成虛假視頻的主流AI模型(以及其他方法,如2016年的Face2Face程序),都是通過逐幀修改視頻且并不注意時間的連貫性。這會使得生成視頻中的人物移動看起來非常笨拙,人們通常會注意到這類奇怪的動作。

為了實現找出奇怪動作這一過程的自動化,研究人員首先要訓練一個神經網絡—這種人工智能程序以個人的海量視頻為基礎,可以用來“學習”人類在說話時如何移動的重要特征。

然后,研究人員使用這些參數將偽造視頻的堆疊幀輸入AI模型,以檢測視頻隨時間的不一致性。根據該論文,這種方法可以判斷“AI偽造視頻”,準確率超過90%。

研究人員使用的模型是一個遞歸卷積模型(Recurrent convolutional model),這個深度學習模型能夠很好的提取到視頻中的信息。

整個過程分為兩步:

將視頻中的人臉進行裁剪對齊

對于獲取人臉區域,研究人員使用由FaceForensics++提供的模型。

論文鏈接:

https://arxiv.org/abs/1901.08971

研究人員嘗試了兩種人臉對齊技術的結合:

顯式使用面部坐標對齊,在參考坐標系中,人的面部是先天決定的,所有的面孔是使用同一個參考坐標系;

隱式排列對齊,使用STN。

在后一種情況下,網絡根據輸入圖像預測對齊參數,因此可能學會縮放人臉的特定部分,必要時可將訓練集中的預期損失最小化。

在這兩種情況下,核心思想都是我們希望循環卷積模型將人臉“tubelet”作為輸入,這是一個跨越視頻幀的時空緊密對齊的人臉序列。

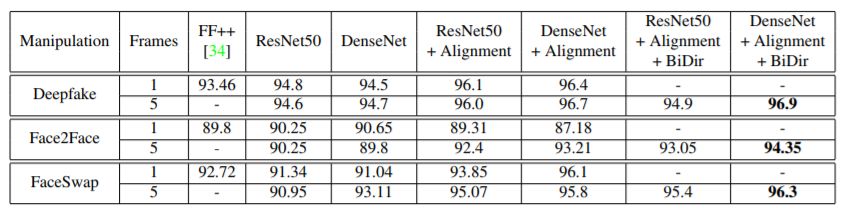

所有篡改類型的檢測精度。結果表明,采用線性和雙向遞歸網絡的DenseNet性能最好

基于視頻人臉篡改的檢測

對于人臉篡改的檢測,我們使用一個類似于用于視覺識別的Long-term循環卷積網絡。

論文鏈接:

https://arxiv.org/abs/1411.4389

其中輸入是來自查詢視頻的幀序列,這個模型背后是在利用跨幀的時間差異。由于篡改是在逐幀的基礎上進行的,研究人員認為圖像中會存在時間差異。因此,由對人臉的篡改引起的低層次的差別則有可能表現為跨幀不一致特性的時間差異。

骨干網絡(Backbone encoding network)

在實驗中,研究人員探索了ResNet和DenseNet兩種架構作為模型的CNN分量。

無論采用何種架構,首先對主干網絡進行FF++訓練分割,使交叉熵損失最小化,進行二值分類,形成特征,從合成人臉中識別真實人臉。然后用RNN對Backbone進行擴展,最后在多種策略下形成端到端訓練。

RNN的訓練策略

研究人員使用放置在骨干網絡不同位置的多個循環模型進行實驗:用它將骨干網絡連接在一起,用來進行特征學習,將特征傳遞給隨時間推移聚合輸入的RNN。

在這里研究人員也嘗試了兩種策略:一是在骨干網的最終特性基礎上,簡單地使用單一的遞歸網絡;二是嘗試在骨干網結構的不同層次上訓練多個遞歸神經網絡。

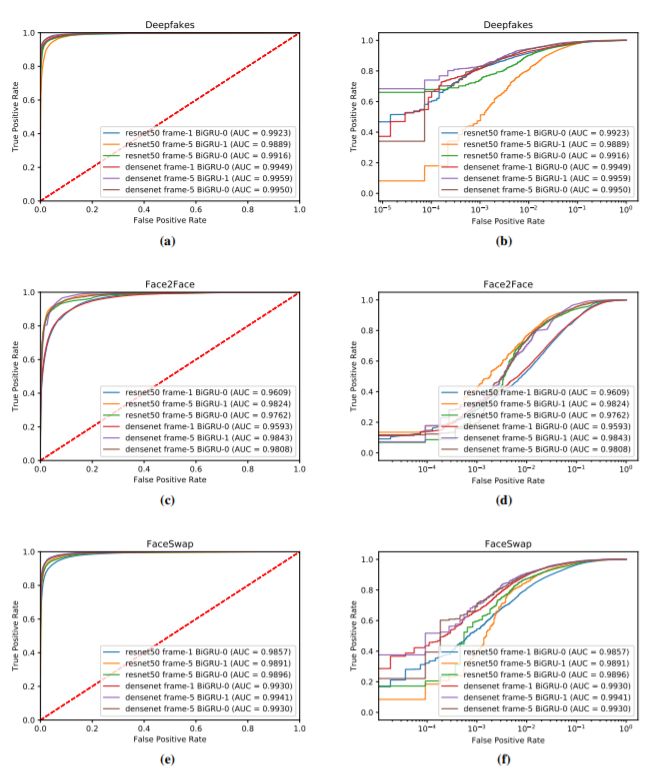

所有篡改類型的ROC曲線。每一行對應一個不同的篡改類型。左列為線性圖,右列為線性對數圖

希望能從源頭阻止deepfake假視頻

研究的共同作者Wael AbdAlmageed表示,這種模式可以被社交網站和視頻網站用于大規模識別deepfake假視頻,因為它不需要通過“學習”特定個體的關鍵特征來進行識別,而是通用的。

“我們的模型對于任何人來說都是通用的,因為我們不關注某個人的身份,而是關注面部運動的一致性,”AbdAlmageed說,“我們將發布自己的模型,所以社交網絡無需訓練新的模型。網站只需要在其平臺中加上該檢測軟件,以檢查上傳到平臺的視頻是否為deepfake生成的假視頻。”

機器學習的出現讓造假的成本逐漸變低,很多玩火不嫌事大的開發者還開發出許多不需要寫代碼直接可以造假的小軟件,盡管他們不一定是出于惡意,但是不排除軟件最后被用到“作惡”的地方。

雖然還有許多方法可以反“AI造假”(例如在拍攝圖片時生成"噪聲水印"),但利用AI來識別AI造假,并且將這項技術加載到視頻網站的審查過程中,那么從源頭大規模地阻止假視頻流向公眾,或許可以成為現實。

-

AI

+關注

關注

88文章

35008瀏覽量

278770 -

DeepFake

+關注

關注

0文章

15瀏覽量

6877

原文標題:解鈴還須系鈴人!南加大訓練AI檢測Deepfake“假視頻”,準確率超90%

文章出處:【微信號:BigDataDigest,微信公眾號:大數據文摘】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

【BPI-CanMV-K230D-Zero開發板體驗】視頻會議場景下的 AI 應用(電子云臺 EPTZ、人像居中 / 追蹤、畫中畫)

【BPI-CanMV-K230D-Zero開發板體驗】AI 算法模型(人臉檢測、軀干檢測、車牌識別)

【BPI-CanMV-K230D-Zero開發板體驗】03 攝像頭調用+AI人臉檢測

《DNESP32S3使用指南-IDF版_V1.6》第五十八章 人臉檢測實驗

《DNESP32S3使用指南-IDF版_V1.6》第五十七章 樂鑫AI庫簡介

Banana Pi 發布 BPI-AI2N & BPI-AI2N Carrier,助力 AI 計算與嵌入式開發

《AI Agent 應用與項目實戰》----- 學習如何開發視頻應用

可靈AI全球首發視頻模型定制功能,助力AI視頻創作

基于迅為RK3568/RK3588開發板的AI圖像識別方案

基于迅為RK3588開發板的AI圖像識別方案

用AI對抗AI——基于視頻人臉篡改的檢測

用AI對抗AI——基于視頻人臉篡改的檢測

評論