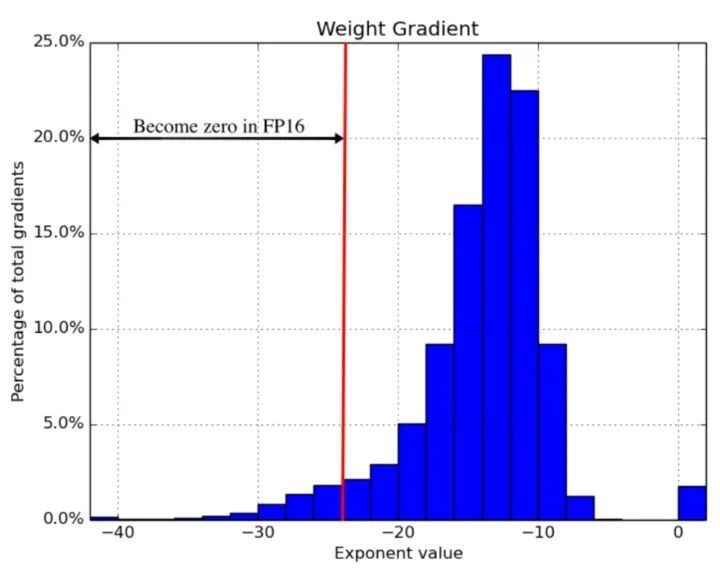

PyTorch 1.6 nightly增加了一個(gè)子模塊amp,支持自動(dòng)混合精度訓(xùn)練。值得期待。來看看性能如何,相比Nvidia Apex 有哪些優(yōu)勢(shì)?

A developer-friendly guide to mixed precision training with PyTorch

https://spell.run/blog/mixed-precision-training-with-pytorch-Xuk7YBEAACAASJam

即將在 PyTorch 1.6上發(fā)布的 torch.cuda.amp 混合精度訓(xùn)練模塊實(shí)現(xiàn)了它的承諾,只需增加幾行新代碼就可以提高大型模型訓(xùn)練50-60% 的速度。

-

模塊

+關(guān)注

關(guān)注

7文章

2784瀏覽量

49726 -

代碼

+關(guān)注

關(guān)注

30文章

4891瀏覽量

70306 -

pytorch

+關(guān)注

關(guān)注

2文章

809瀏覽量

13786

原文標(biāo)題:訓(xùn)練提速60%!只需5行代碼,PyTorch 1.6即將原生支持自動(dòng)混合精度訓(xùn)練

文章出處:【微信號(hào):cas-ciomp,微信公眾號(hào):中科院長春光機(jī)所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

摩爾線程發(fā)布Torch-MUSA v2.0.0版本 支持原生FP8和PyTorch 2.5.0

摩爾線程GPU原生FP8計(jì)算助力AI訓(xùn)練

使用OpenVINO? 2021.4將經(jīng)過訓(xùn)練的自定義PyTorch模型加載為IR格式時(shí)遇到錯(cuò)誤怎么解決?

大模型訓(xùn)練框架(五)之Accelerate

PyTorch GPU 加速訓(xùn)練模型方法

如何在 PyTorch 中訓(xùn)練模型

使用PyTorch在英特爾獨(dú)立顯卡上訓(xùn)練模型

基于Pytorch訓(xùn)練并部署ONNX模型在TDA4應(yīng)用筆記

PyTorch 1.6即將原生支持自動(dòng)混合精度訓(xùn)練

PyTorch 1.6即將原生支持自動(dòng)混合精度訓(xùn)練

評(píng)論